1、 文档目标

解决 22.11 版本后如何导出 Gerber 镜像层的问题

2、 问题场景

Gerber 导出旧版本,在 AD 22.11 之前的 Gerber 导出中是存在镜像层的选择。

图 1

软件更新至 AD22.11 及之后版本,在 Gerber 导出设置中无法选择层镜像进行导出。

图 2

3、软硬件环境

1)、软件版本:Altium Designer 22.11 以上支持

2)、电脑环境:Windows 11

3)、外设硬件:无

4、解决方法

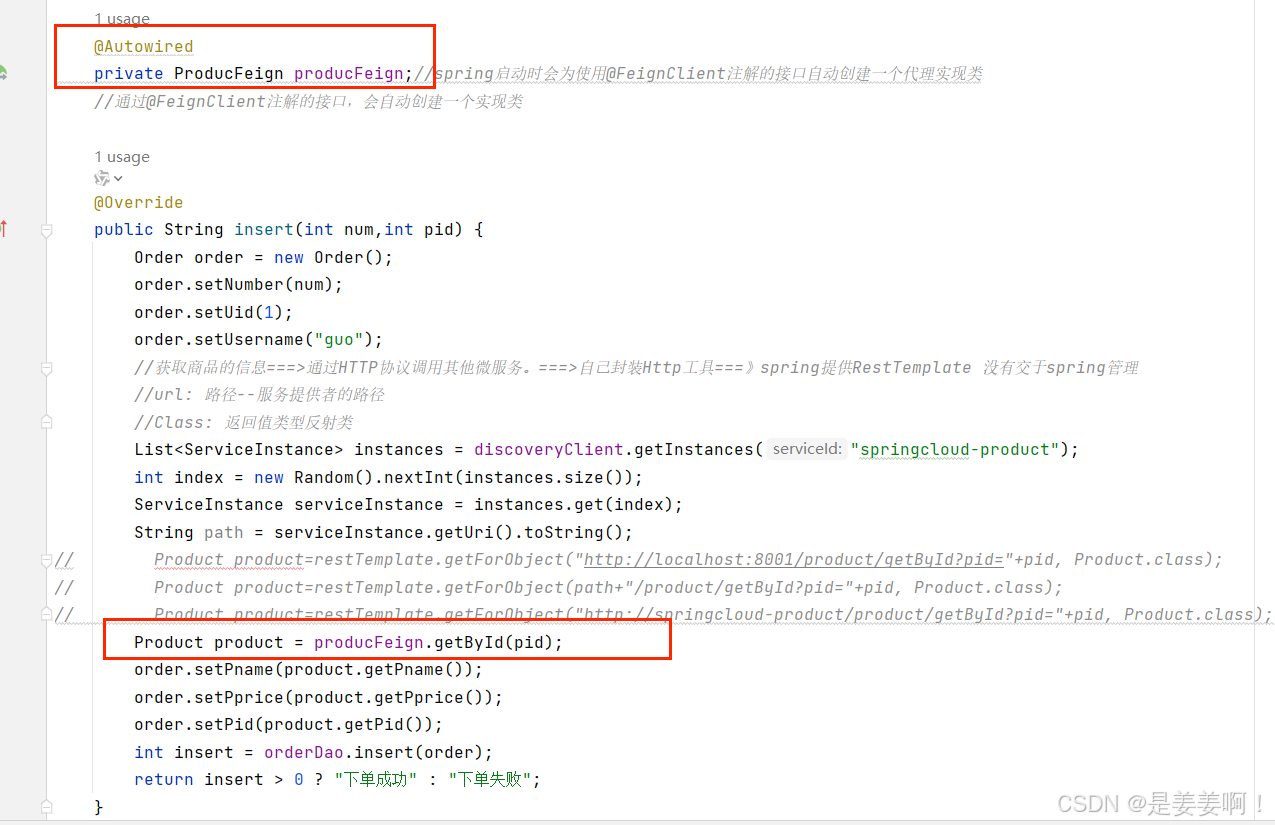

导出 Gerber 设置中层设置镜像的作用:

直接导出 Bottom 层的 Gerber 文件,是从 Top 层看到的透视视角,要给 Bottom 层做钢网,对焊盘涂锡,需要 Bottom 层的镜像文件。

打开【设置】→【Advanced】

图 3

找到【UI.Unification.GerberDiog.showmirrorColumn】,并勾选Value检查框,重启软件。

图 4

此时打开 Gerber 设置,就可以对需要镜像的层进行设置了。

图 5

————————————————————————

版权声明:本文为亿道电子技术有限公司原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

![[项目]基于FreeRTOS的STM32四轴飞行器: 四.LED控制](https://i-blog.csdnimg.cn/direct/7ed6b12289c042e0887cc369c36b9cb5.png)