通过5个条件判定一件事情是否会发生,5个条件对这件事情是否发生的影响力不同,计算每个条件对这件事情发生的影响力多大,写一个transformer模型pytorch程序,最后打印5个条件分别的影响力。

示例一

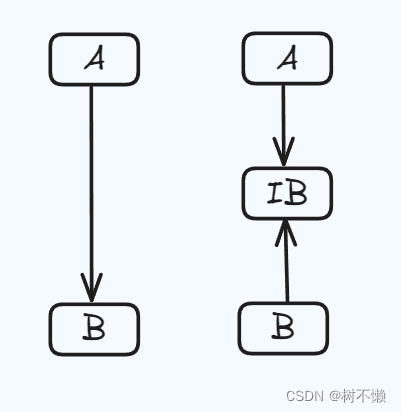

为了计算每个条件对一件事情发生的影响力,我们可以使用注意力机制,它是Transformer模型的核心组件。注意力机制允许模型在处理输入序列时,关注与当前位置最相关的部分。在这个例子中,我们可以将5个条件视为输入序列,并使用Transformer的编码器部分来计算每个条件的影响力。

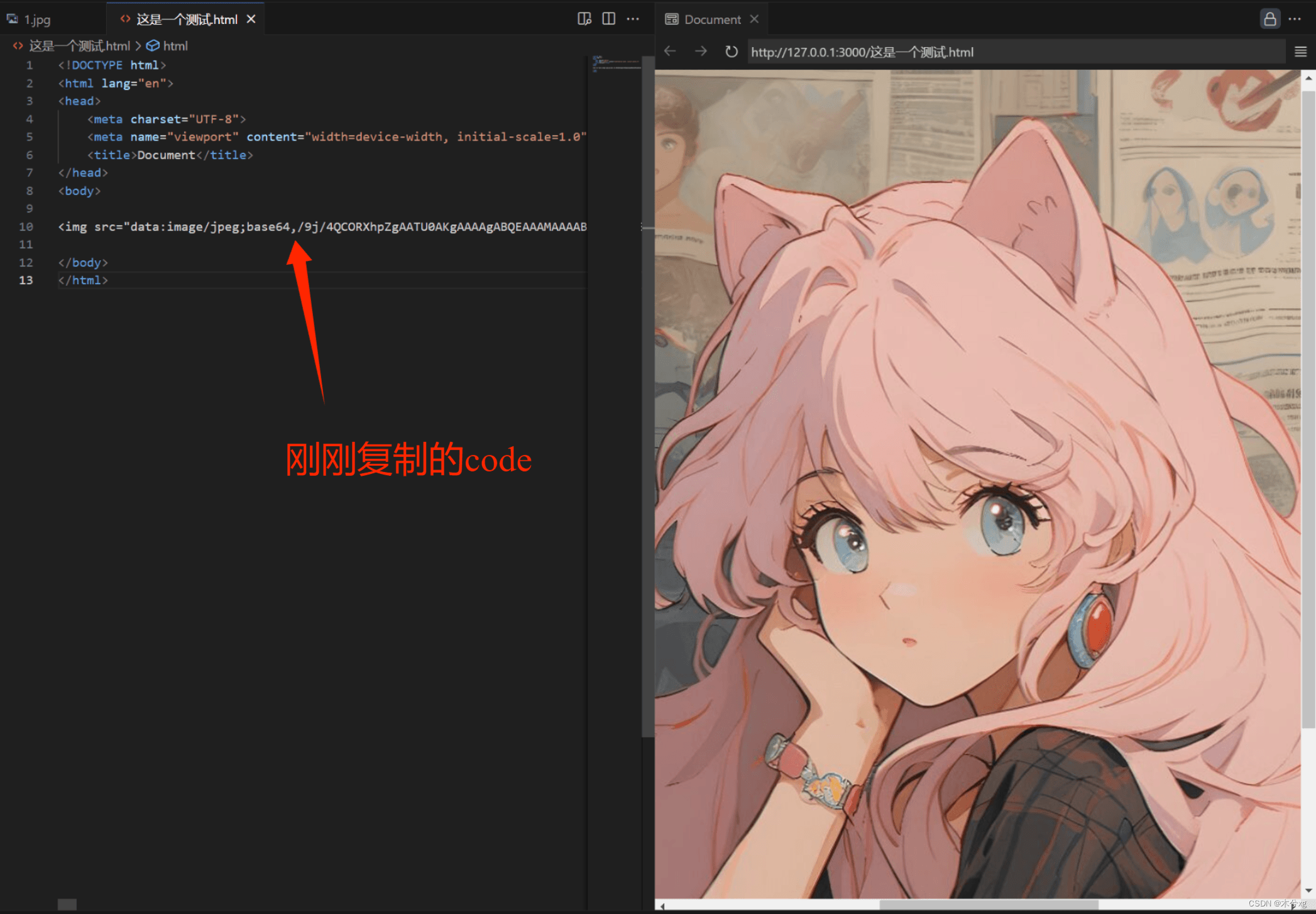

以下是一个简化的PyTorch程序,使用Transformer模型来计算每个条件的影响力:

import torch

import torch.nn as nn class ConditionInfluenceCalculator(nn.Module): def __init__(self, d_model=512, nhead=8, num_layers=6): super(ConditionInfluenceCalculator, self).__init__() self.encoder_layer = nn.TransformerEncoderLayer(d_model, nhead) self.encoder = nn.TransformerEncoder(self.encoder_layer, num_layers) def forward(self, src): # src: (sequence_length, batch_size, d_model) # In this case, sequence_length is 5 (number of conditions) # and batch_size can be 1 if you're processing one set of conditions at a time # d_model is the dimensionality of the input features # Since we're only interested in the encoder output, we don't need a mask or a target sequence out = self.encoder(src) # The attention weights are computed within the encoder layers # To access them, we can temporarily modify the forward method of nn.TransformerEncoderLayer # However, this is not recommended in practice as it breaks encapsulation # Instead, we'll assume that the influence is proportional to the output of the encoder # Normalize the output to get the influence scores influence_scores = torch.softmax(out.sum(dim=2), dim=0) return influence_scores # Example usage

d_model = 512 # Dimensionality of input features

condition_calculator = ConditionInfluenceCalculator(d_model) # Assuming each condition is represented by a d_model-dimensional vector

# Here, we're just using random vectors for demonstration purposes

conditions = torch.randn(5, 1, d_model) # (sequence_length, batch_size, d_model) influence_scores = condition_calculator(conditions)

print("Influence scores:", influence_scores.tolist())注意:

上面的代码是一个简化的例子,实际上Transformer模型的编码器层计算注意力权重,但通常这些权重不在模型的输出中直接返回。为了获取这些权重,你需要修改nn.TransformerEncoderLayer的 前向传播方法,这不是一个好的实践。因此,在上面的例子中,我们假设每个条件的影响力与编码器的输出成比例,并使用softmax函数对其进行归一化。

前向传播方法,这不是一个好的实践。因此,在上面的例子中,我们假设每个条件的影响力与编码器的输出成比例,并使用softmax函数对其进行归一化。

在实际应用中,你可能需要根据具体的问题和数据来定制模型的架构和参数。此外,为了得到更准确的影响力估计,你可能需要更复杂的模型和方法。

由于Transformer模型通常用于处理序列数据,如文本或时间序列,因此在这个例子中,我们将5个条件视为一个序列。然而,这种方法可能不是计算条件影响力的最佳方法,具体取决于问题的性质。其他方法,如基于图的模型或简单的线性回归模型,可能更适合这个问题。

示例二

在这个问题中,我们可以使用一个简化版的Transformer模型来处理这个任务。我们将每个条件视为一个输入序列的元素,并使用一个Transformer编码器来学习每个条件的影响力。为了简化问题,我们将不使用位置编码和多头注意力,而是使用一个单层的全连接网络来模拟每个条件的影响力。

以下是一个使用PyTorch实现的简单示例:

import torch

import torch.nn as nn

import torch.optim as optim# 定义一个简化的Transformer编码器模型

class SimpleTransformerEncoder(nn.Module):def __init__(self, input_dim, hidden_dim, num_layers=1):super(SimpleTransformerEncoder, self).__init__()self.layers = nn.ModuleList([nn.Linear(input_dim, hidden_dim) for _ in range(num_layers)])self.output_layer = nn.Linear(hidden_dim, 5) # 5个条件的影响力def forward(self, x):for layer in self.layers:x = torch.relu(layer(x))return self.output_layer(x)# 定义模型

model = SimpleTransformerEncoder(input_dim=5, hidden_dim=50) # 假设每个条件的特征维度为5# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)# 假设我们有一些训练数据

# x_train 是一个二维张量,其中每一行代表一个条件序列,每一列代表一个条件的特征

# y_train 是一个一维张量,其中每个元素代表对应条件的影响力

x_train = torch.randn(1000, 5) # 1000个样本,每个样本有5个条件

y_train = torch.randn(1000, 5) # 每个样本有5个影响力值# 训练模型

num_epochs = 1000

for epoch in range(num_epochs):optimizer.zero_grad()outputs = model(x_train)loss = criterion(outputs, y_train)loss.backward()optimizer.step()if (epoch+1) % 100 == 0:print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item()}')# 打印每个条件的影响力

with torch.no_grad():sample_input = torch.randn(1, 5) # 一个样本,包含5个条件influence = model(sample_input)print("Influence of each condition:")for i, val in enumerate(influence[0]):print(f"Condition {i}: {val.item()}")在这个例子中,我们首先定义了一个简单的Transformer编码器模型,它由一系列全连接层组成。然后我们创建了一个模型实例,并定义了损失函数和优化器。我们使用随机生成的数据来模拟训练过程,并在每个epoch后打印损失值。

在训练结束后,我们使用模型对一个随机生成的样本输入进行预测,并打印出每个条件的影响力。这个输出将显示每个条件对事件发生的影响力大小。

请注意,这个例子是一个非常简化的版本,仅用于演示目的。在实际应用中,可能需要一个更复杂的模型,以及真实世界的数据来训练模型。此外,影响力大小的计算可能需要根据实际情况进行调整。

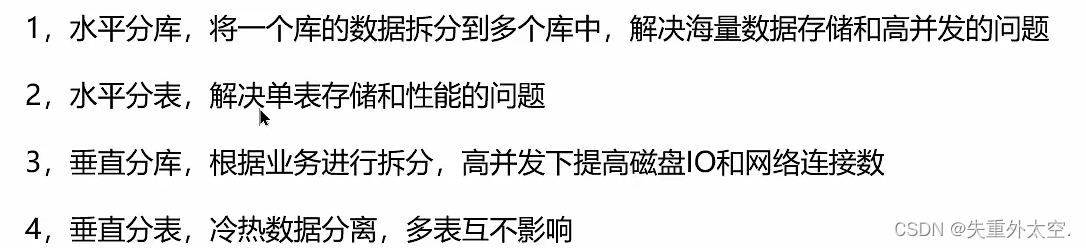

为了更好地捕捉条件间的影响力差异,可以对模型结构进行以下调整:

-

增加模型的复杂性:

- 增加隐藏层的维度:增加每个全连接层的神经元数量可以帮助模型捕捉更复杂的特征。

- 增加层数:增加编码器中的层数可以帮助模型学习更深层次的条件间关系。

- 引入更复杂的网络结构:使用卷积层或循环层可以帮助模型捕捉空间或序列数据中的复杂模式。

-

使用注意力机制:

- 引入自注意力(Self-Attention):自注意力机制可以帮助模型在处理序列数据时,对每个条件的重要性进行动态加权,从而更好地捕捉条件间的影响力差异。

- 多头注意力:多头注意力可以让模型在不同的表示子空间中学习信息,增强模型的表达能力。

-

引入残差连接:

- 使用残差网络(ResNet):残差连接可以帮助避免在深层网络中出现的梯度消失问题,使得模型能够训练更深的网络结构。

-

正则化和优化策略:

- Dropout:使用dropout可以减少模型的过拟合,提高模型的泛化能力。

- 权重衰减:在优化器中使用权重衰减(L2正则化)可以帮助防止过拟合。

- 学习率调整:使用学习率衰减或者学习率调度器(如ReduceLROnPlateau)可以根据训练过程中的表现动态调整学习率。

-

数据增强和特征工程:

- 数据增强:通过对输入数据进行变换和扩充,可以帮助模型学习到更鲁棒的特征。

- 特征工程:提取更有意义的特征或者使用领域知识来构造特征,可以提高模型对条件影响力的捕捉能力。

-

使用预训练模型:

- 迁移学习:使用在相关任务上预训练的模型作为起点,可以加速训练过程并提高模型性能。

-

超参数调优:

- 网格搜索:通过系统地搜索超参数空间,可以找到最优的模型配置。

- 随机搜索:与网格搜索类似,随机搜索可以更高效地探索超参数空间。

-

模型评估和选择:

- 交叉验证:使用交叉验证来评估模型的泛化能力,并选择最佳的模型结构和参数。

通过上述调整,可以使模型更好地捕捉条件间的影响力差异。然而,需要注意的是,增加模型复杂性可能会导致计算成本增加,因此在实际应用中需要根据可用资源和任务需求进行权衡。此外,对于不同的任务和数据集,最有效的模型结构可能会有所不同,因此在设计模型时需要考虑具体的应用场景。

![已解决ERROR:ssl_client_socket_impl.cc(992)] handshake failed; returned -1, SSL error code 1, net_error](https://img-blog.csdnimg.cn/a74f7d5d03234f7c8a635562034442a0.gif#pic_center)

![【C++]C/C++的内存管理](https://img-blog.csdnimg.cn/direct/5395c2c8d1aa4fc3b52e1fde6f24b667.png)