- ✍️ 作者:哈哥撩编程(视频号同名)

- 博客专家·全国博客之星第四名

- 超级个体·COC上海社区主理人

- 特约讲师·谷歌亚马逊演讲嘉宾

- 科技博主·极星会首批签约作者

- 🏆 推荐专栏:

- 🏅 程序员:职场关键角色通识宝典

- 🏅 程序员:职场效能必修宝典

- 🏅 程序员:文心一言指令词宝典

- 🏅 Python全栈白宝书

- 🏅 ChatGPT实践指南白宝书

- 🏅 产品思维训练白宝书

- 🏅 全域运营实战白宝书

- 🏅 大前端全栈架构白宝书

文章目录

- ⭐ 大语言模型的发展一览

- ✨ AI 1.0 VS AI 2.0

- ✨ 大模型发展 · 词向量

- ✨ 大模型发展 · 词嵌入

- ✨ 大模型发展 · 句向量与全文向量

- ✨ 大模型发展 · 理解上下文

- ✨ 大模型发展 · ChatGPT的出现

这一章节呢,我们主要学习的是AI大模型相关的一些背景和基础知识。大家可以看到这一章节的标题是 “多模型强应用:AI 2.0时代应用开发者的机会” ,标题名字倒是挺唬人的,相较于唬人的标题,大家肯定更关心的是接下来一段时间主要讲哪些内容呢?

首先,要请大家理解的是,由于内容篇幅大、涉及的知识面和方向也挺多的,所以接下来会进行章节内容的拆解。第一个就是带领大家了解一下大语言模型的快速发展,接着会为大家介绍一下国内主要的 LLM 的特点,以及AIGC整个产业的拆解,包括一下专业的常见名词,最后会和大家讲一下应用开发者在目前这样一个大背景下的机会,最后就是实战部分 Agent智能体 的项目,针对这个项目做需求分析和技术选型相关的工作,这是这一大章节的主要内容,先来看一下 大语言模型的发展一览 吧。

⭐ 大语言模型的发展一览

我们都知道,大语言模型(Large Language Model),简称是是 LLM 。为什么说是 AI 2.0时代 呢?这是因为在 LLM 出现之前,我们将之前的时间归结为 AI 1.0时代 。这个时候主要是各类的 NLP工程 都是一个特点,也就是通用性比较差。整个AI领域终极的形态,也是很多AI领域创业者都希望能够达到的一个形态,就是AGI,即所谓的通用智能。

✨ AI 1.0 VS AI 2.0

AI 1.0时代的特点就是单任务的智能AI,比如说27年前的IBM公司研制的人工智能系统 - 深蓝,它的特点就是只会下国际象棋,通过深度学习了很多国际象棋的套路后,战胜了国际象棋大师 加里·卡斯帕罗夫。这样的人工智能,你如果向它提问超过国家象棋之外的内容,它绝对是不知道的,这就是单任务智能AI的典型特点。

大语言模型的特点是什么?最显著的特点之一就是可以通过语言与我们进行交互,甚至可以通过自然语言的方式拓展到更多的场景,极大的可能会通过这种方式在未来发展出像AGI这样的通用型智能,也就是向我们一样的拥有智慧的智能体。

AI 1.0 这里就不做过多的介绍了,都是一些 NLP 相关的东西,直接从 AI 2.0 开始介绍 大语言模型的发展就好。

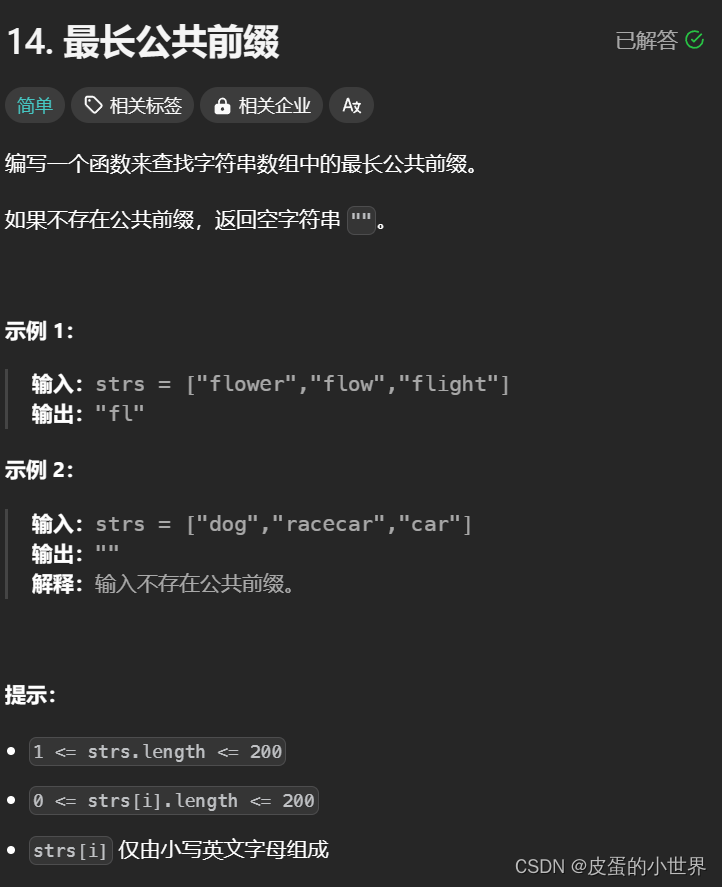

✨ 大模型发展 · 词向量

大语言模型从技术层面来分析的话,基本上也是一个从点到面的过程。最早出现的是名为 “词向量” 的技术,就是将自然语言的词语通过 向量 来表示,“向量” 是一个数学概念,就相当于是每一个词在 向量空间 里有一个唯一的坐标一样。就如同下图中的 “apple” 这个词在向量空间中表现出来的就是 [1 0 0 0 0] 这样的一个坐标,而 “elephant” 这个词的向量空间坐标就与 “apple” 有所区别,它的位置是 [0 0 0 0 1] 。这样的好处就在于,可以将我们现实生活中的自然语言通过数学语言的方式描述出来,通过精准的坐标可以找到位置。但是需要注意的是,词向量无法表达词语与词语之间的关联关系,另一个就是效率上也存在着一定的问题。

✨ 大模型发展 · 词嵌入

在 “词向量” 的基础之上,又出现了 “词嵌入技术” ,也就是 “embedding” ,在后续的实践项目中也会有使用到。词嵌入技术本质上其实还是词向量,其实就是对语言模型进行预训练,通过对现有的大量文章进行训练,让原本的词向量具备语言信息。

通过一些语言的训练方式,经过预训练之后的词向量,在向量空间上优惠诞生额外的信息,就会有效的提升模型的效果,而且可以在后续的其他任务空间做迁移,这就是大语言模型的预训练的初始原型。

在下图中,我们可以看到 embedding 中的 “dog” 和 “cat” ,通过坐标的方式做了标注,可以具备 低维向量 的表示,还可以具备语义相似、空间向量相近的特性。也就是说 “dog” 和 “cat” 通过大量的文章资料训练后,发现它们都可以归类到 “宠物”,那么这两个坐标点在向量空间中的坐标就是非常接近的,两者同属于宠物的 “向量域” ,而 “tree” 和 “flower” 就同属于是植物的 “向量域” 。

所以,我们就可以看到 “词向量” 实际上就是在 “低维向量” 中表示语义相似的向量空间、相近的一个特性。除此之外,词向量还可以进行迁移学习,将任务迁移到其他任务当中去。前文中介绍到的 IBM公司研制的人工智能系统 - 深蓝 ,就是一个活生生的例子,利用词向量的技术将学习国际象棋的技能进行迁移。

✨ 大模型发展 · 句向量与全文向量

在 “词嵌入” 之后呢,就出现了 “句向量” 和 “全文向量” ,就是根据前文信息去分析下文,或者是根据本文翻译成另一种语言,也就是说可以有效的处理时序性的序列数据。

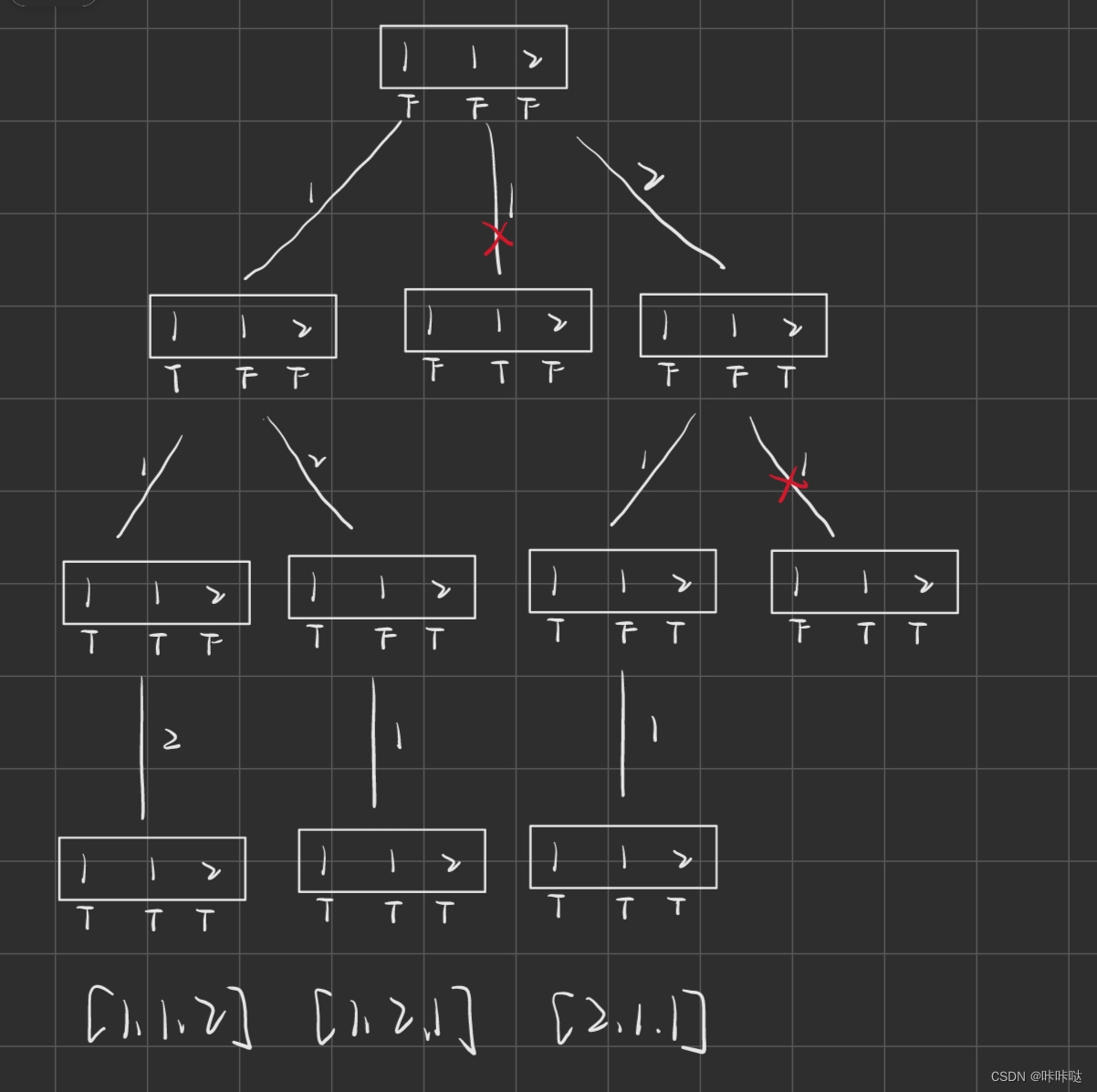

所以,我们就可以看到如下图中的例子,可以将 “what time is it ?” 这样的一个句子通过一层一层的神经网络按照 “waht”、“time”、“is”、“it” 、“?” 这样的顺序做上下文的理解。

除此之外,“句向量” 还可以做到 短时记忆 和 选择性 的遗忘,主要应用在 文本生成、语音识别 和 图像描述 等场景,这个时候其实已经可以做到常见的AI识别了。

✨ 大模型发展 · 理解上下文

再往后发展,也就到了 理解全文上下文 的阶段了,理解上下文这种模式的代表作就是 BERT大模型 。这个阶段其实已经可以完成类似完形填空这样的任务了,就是根据上下文的理解完成代词。比如说代表男性的 “他” ,代表女性的 “她” ,代表第三方非人的 “它” ,这个时候也就说所谓的 “真·预训练” 模型时代开启了。

这个时候的显著特点之一就是支持 “并行训练” ,和早期的 RNN、CNN 模型的只能通过一层一层的方式进行训练相比,也就是 RNN、CNN 在处理 “waht time is it ?” 这样的训练的时候,是一层一层处理完前一个任务之后,才会处理后一个任务。所以这种依托 “并行训练” 实现的大模型就替代了 RNN、CNN 这样的神经网络,功能上更加的强大,可以实现类似语义识别的能力了。

✨ 大模型发展 · ChatGPT的出现

2023年,OPenAI 的 ChatGPT 的出现,AI领域正式进入到超大模型和大模型统一的时代。这里的起始点,其实是从谷歌的 T5 模型开始的,ChatGPT中的 “T” 代表的就是谷歌的Transformer(转换器)。

ChatGPT 引入的是 Prompt 这样的范式进行模型的训练,也就是说将 提示词(Prompt) 告诉模型,将答案训练出来,不停的通过这样的模式来持续的训练模型。当我们通过 “提示词”、“Prompt” 的方式对 ChatGPT进行引导,从而得出对应的答案。

到了这个时候,以 ChatGPT 和 GPT4 为代表的大模型,效果非常的惊艳,最新的成果就是目前的大模型都开始支持了 多模态 。也就是说开启 文生图、生成文字、生成图片、甚至生成视频 的时代,通过基于 Prompt 为范式训练大模型的方式,将这个标准给公布了出来。

前文介绍的,整个的大模型的发展是一个由点到面过程。其实就是一开始的 词向量 的技术,发展到了 神经网络 ,再到单线、并行训练,最后一直到现在这样的大规模、超大规模的训练集,最终呈现出来的就是现在大家所熟知、能够看到的一个大模型发展的一个结果。