前言

Reor 是一款人工智能驱动的桌面笔记应用程序,它能自动链接相关笔记、回答笔记中的问题并提供语义搜索。所有内容都存储在本地,支持 Windows、Linux 和 MacOS。Reor 站在 Ollama、Transformers.js 和 LanceDB 等巨头的肩膀上,使 LLM 和嵌入模型都能在本地运行。此外,还支持连接 OpenAI 或与 OpenAI 兼容的 API(如 Oobabooga)。

基本原理

你写的每篇笔记都会被分块并嵌入到内部向量数据库

相关笔记会通过向量相似性(

vector similarity)自动连接起来由

LLM驱动的问答会对笔记语料库进行RAG(Retrieval Augmented Generation)检索增强生成分析所有内容都可以进行语义搜索

可以把 Reor 看作是一个有两个生成器的 RAG 应用程序:LLM 和我们人类。在问答的模式下,LLM会从语料库中获取上下文来帮助回答问题。同样,在编辑模式下,人类可以切换侧边栏,显示从语料库中检索的相关注释。通过将当前笔记中的观点与语料库中的相关观点进行交叉引用,这种扩充的思维方式非常强大。

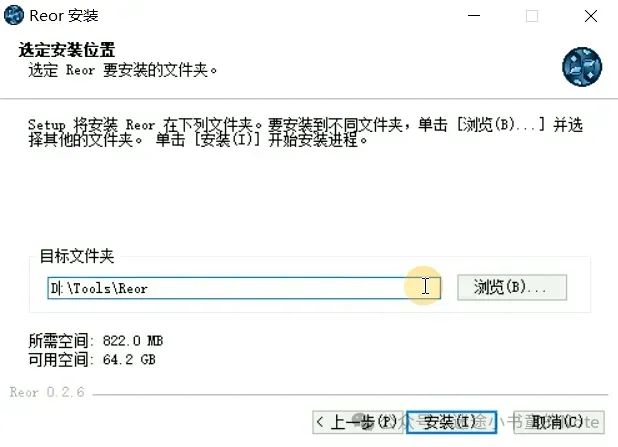

离线安装

来到官方版本发布页 https://github.com/reorproject/reor/releases/,目前最新版本是 v0.2.6,根据自己的平台选择安装包下载

绑定本地嵌入模型

要绑定本地嵌入模型(Embedding Model),需要使用 Git Large File Storage (LFS) 从 Hugging Face 下载。

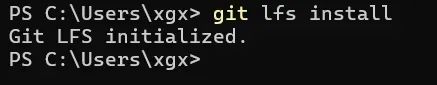

第一步安装git lfs,来到官方网站下载 https://git-lfs.com/

傻瓜式进行安装,安装完毕后,打开 powershell,输入 git lfs install 来验证一下是否安装成功

如果命令有如上的输出,说明安装好了。

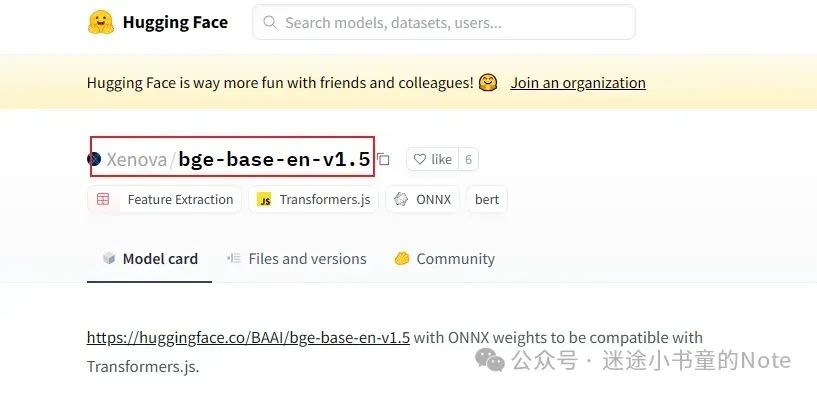

第二步,去下载模型,这里以 Xenova/bge-m3 模型为例,仓库地址 https://huggingface.co/Xenova/bge-base-en-v1.5

git clone https://huggingface.co/Xenova/bge-m3如果 git clone 连接不上服务器的话,可以通过下面这个方法

# 安装huggingface-cli命令行工具,包含在huggingface_hub库里,不仅可以下载模型、数据,还可以可以登录huggingface、上传模型、数据

pip install -U huggingface_hub# 下载模型,支持续传,保存在本地文件夹bge-base-en-v1.5,即最后一个参数

huggingface-cli download --resume-download Xenova/bge-base-en-v1.5 --local-dir bge-base-en-v1.5

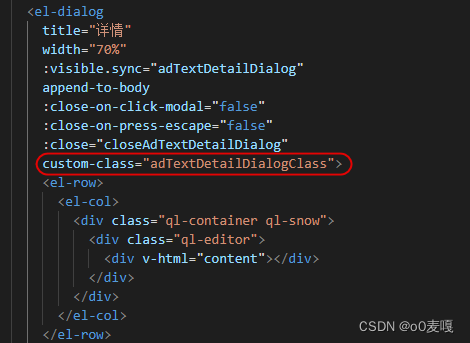

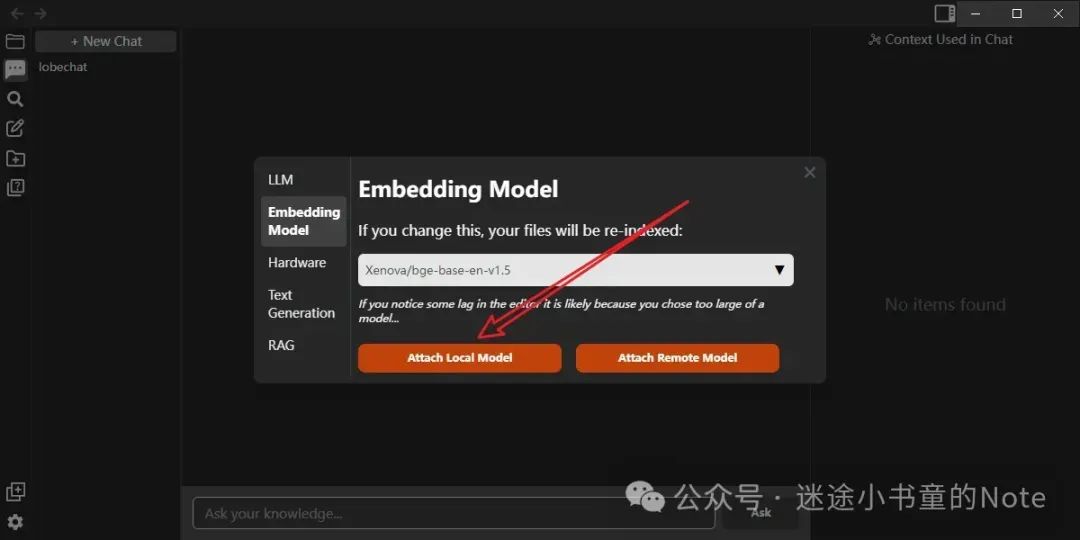

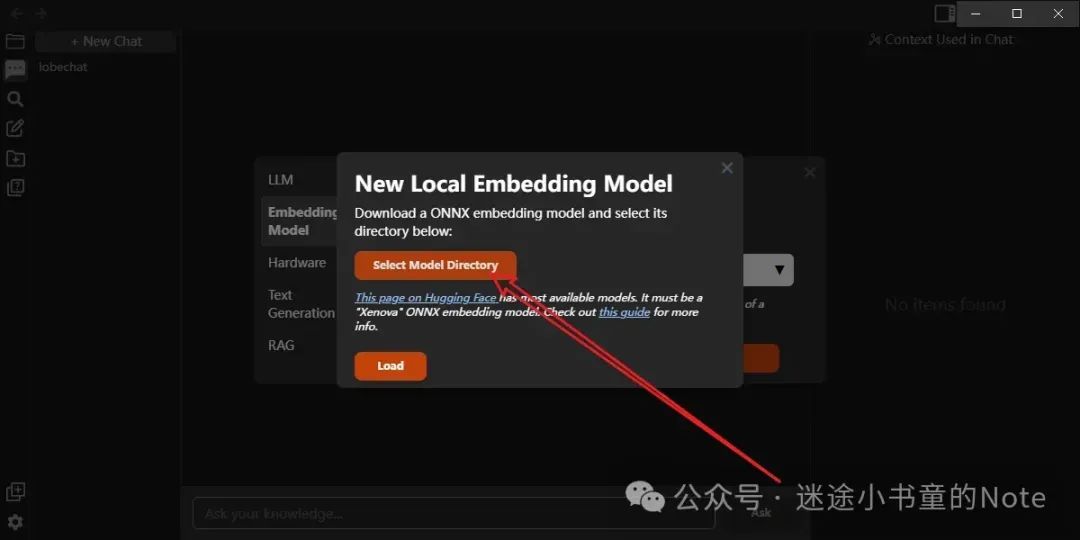

第三步进行绑定,来到 Settings --> Embedding Models --> Attach Local Model

选择刚刚下载好的模型文件夹

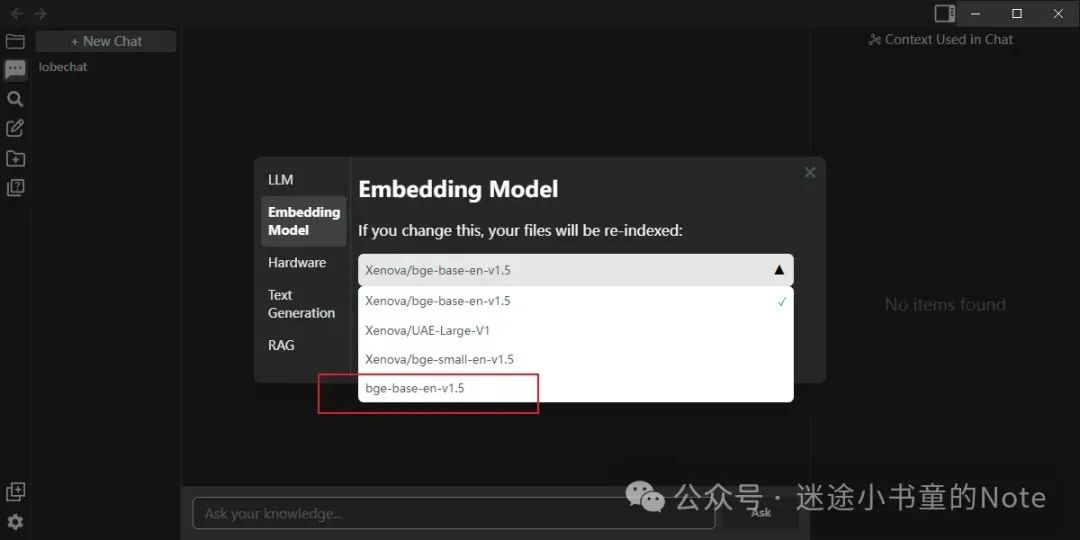

选择新的模型

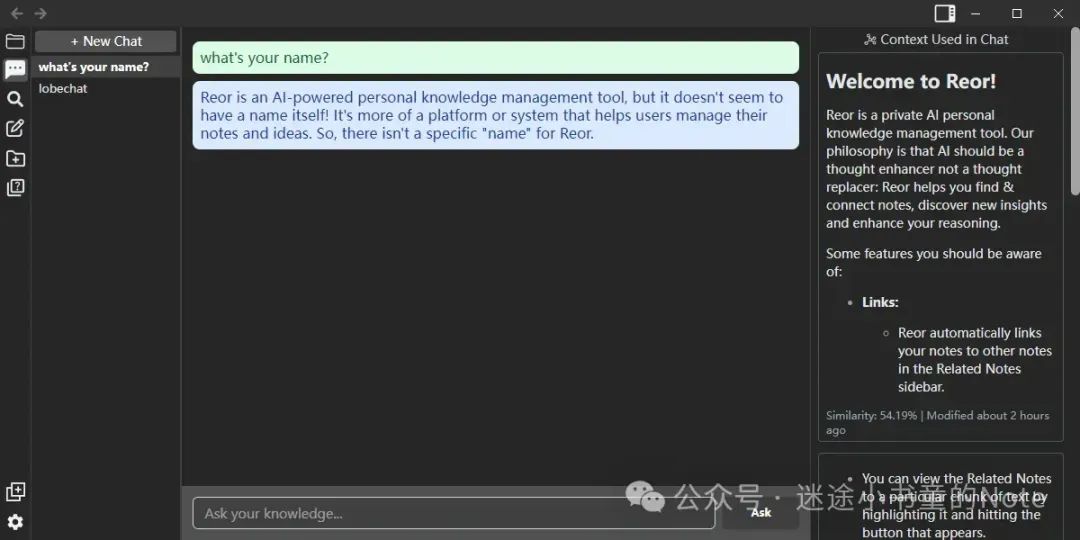

可以开始向它提问了

参考资料

https://github.com/reorproject/reor