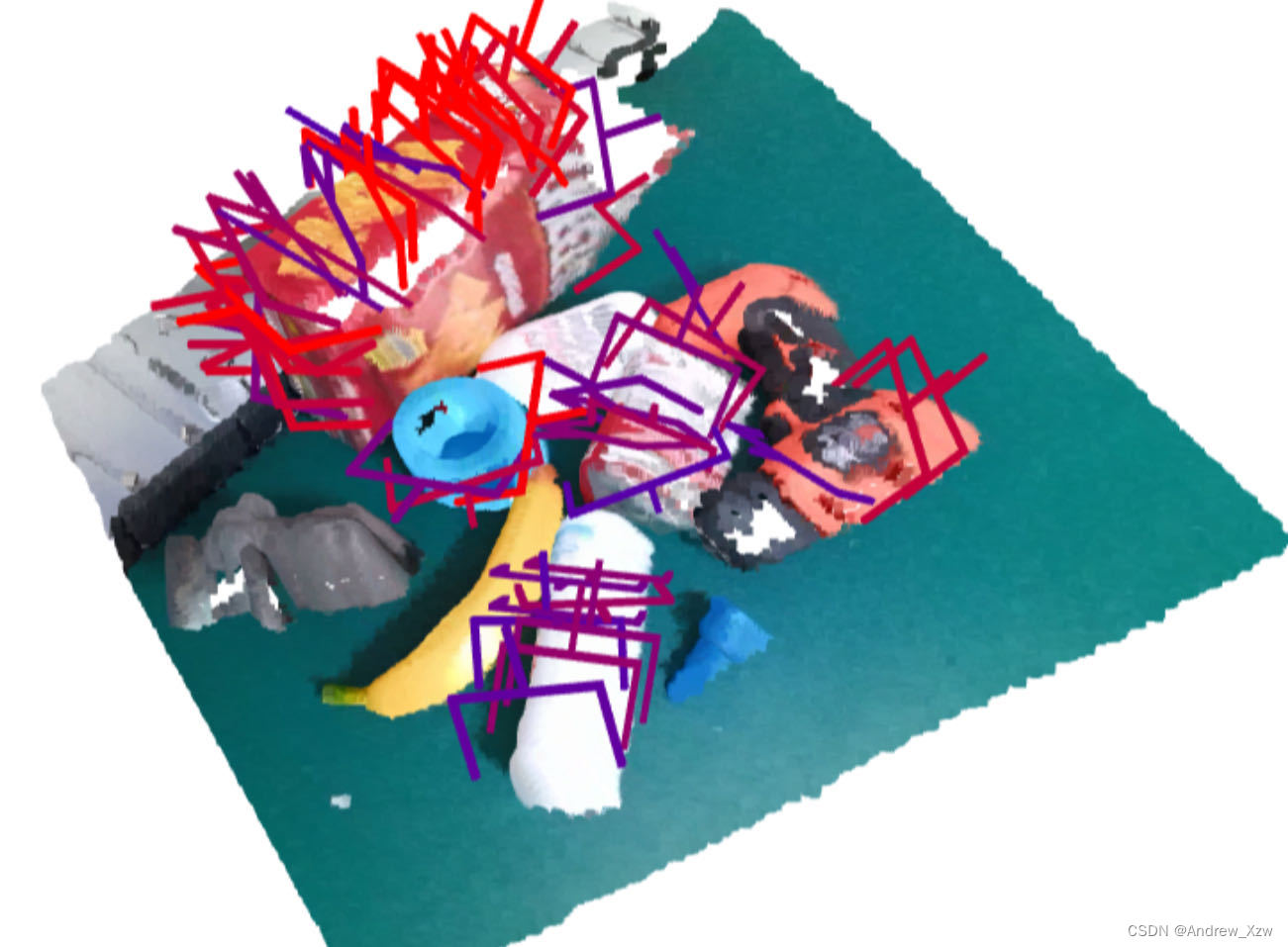

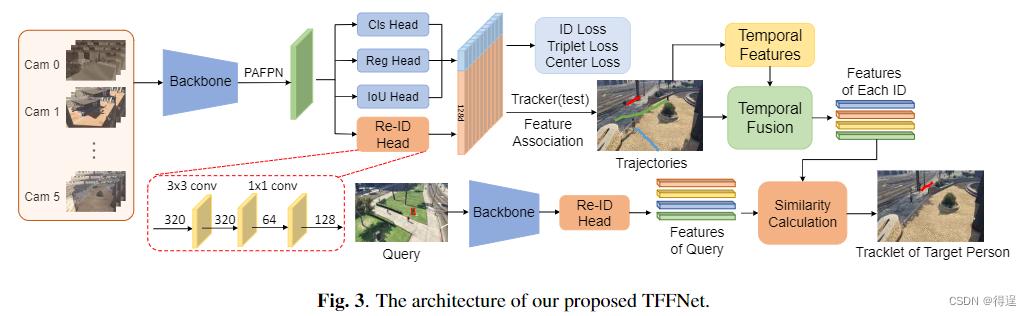

Q:关于 Yi-9B 通过 input/output cosine 来分析模型,可能文档里没有把前提说明白。该指标确实存在你们提到的不同模型大小不可比的问题。所以我们比较的是同一个模型在不同训练阶段,以及 layer 深度相同的dense models 之间的比较。除了发现yi-6B/34B 随着训练 tokens 的增加不同的 cosine 下降趋势外,我们也比较了32 层 layer的 7B open source models 的 cosine 排序,发现大体与模型对应的英文能力对应,我们认为 model cosine 在相同模型结构下,反映着对于 token embedding 的特征提取能力。

A:特征提取这个定义跟我们当时做long context调研的结论很一致的。的确是发现不同层在做不用的事情,跟当年cnn做人脸识别,不同层抽不同特征很接近。

Q:想问下目前高质量数据主要还是靠收集标注?还是主要靠自动生成?另外LR scheduler 这部分之前看了MiniCPM的博客感觉比较有意思,如果中间不用 stable,比如还是 cosine,但是 decay 的非常慢,会有差别吗?以及提到的 cosine decay 再把 lr 提上去,这个会不会容易崩掉?一般来说 lr decay 完成之后模型应该趋于稳定了。

A:1 高质量数据,花钱买