昆仑万维近期宣布开源了其2千亿参数规模的稀疏大模型Skywork-MoE。这个模型是基于他们之前开源的Skywork-13B模型中间checkpoint扩展而来的,并且宣称是首个完整应用MoE Upcycling技术的开源千亿MoE大模型。此外,它也是首个支持使用单台RTX 4090服务器(8张RTX 4090显卡)进行推理的开源千亿MoE大模型。

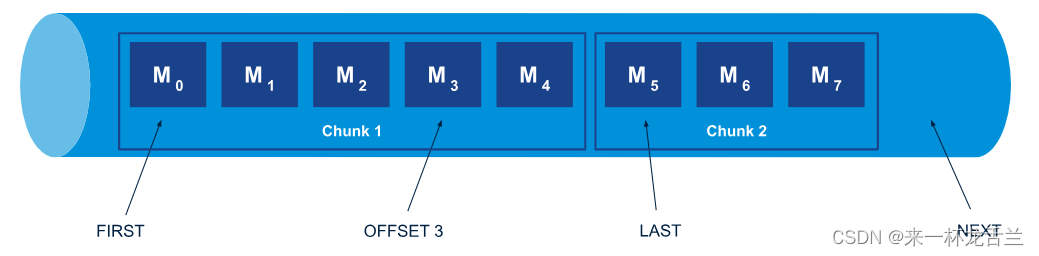

Skywork-MoE模型属于天工3.0研发模型系列中的中档大小模型(Skywork-MoE-Medium),其总参数量为146B,激活参数量为22B,共有16个Expert,每个Expert大小为13B,每次激活其中的2个Expert。天工3.0还训练了75B(Skywork-MoE-Small)和400B(Skywork-MoE-Large)两档MoE模型,但这些模型并不包含在此次开源中。

根据官方测试,在相同的激活参数量20B(推理计算量)下,Skywork-MoE的能力接近70B的Dense模型,这使得模型的推理成本有近3倍的下降。同时,Skywork-MoE的总参数大小比DeepSeekV2的总参数大小要小1/3,用更小的参数规模做到了相近的能力。

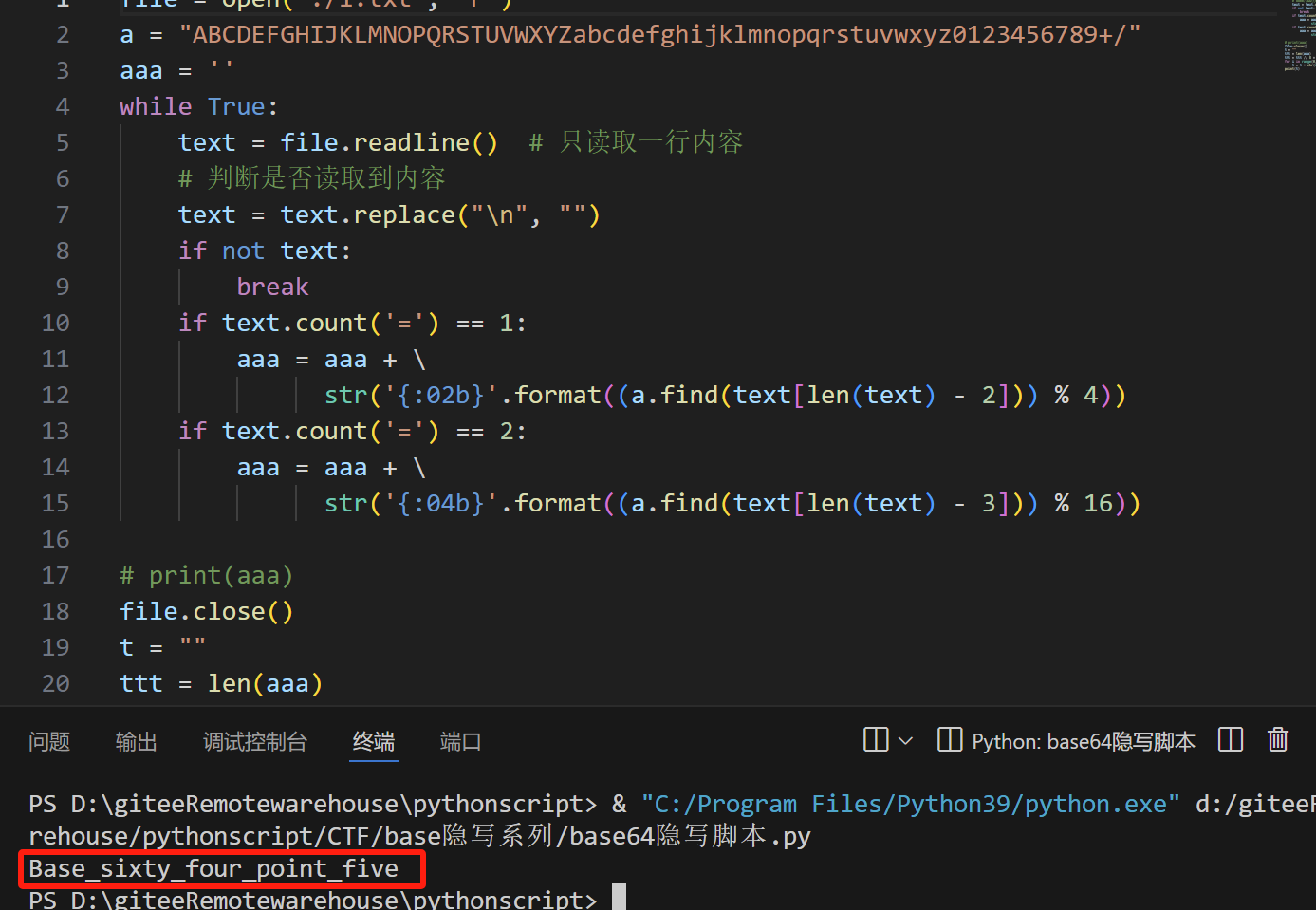

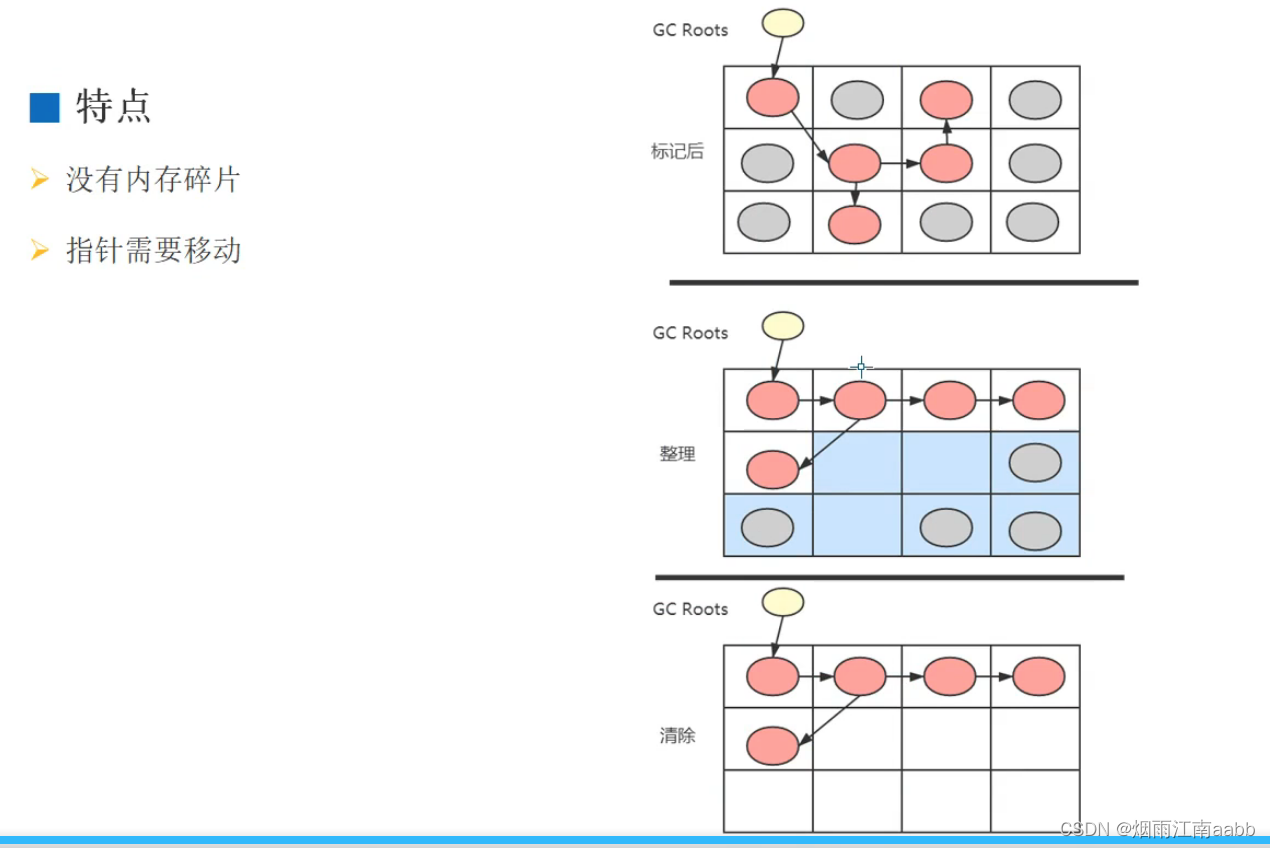

Skywork-MoE模型的MoE Upcycling技术通过将稠密模型(Dense Model)转换为混合专家模型(Mixture of Experts, MoE),显著提高了模型的推理效率。这种技术的优点包括降低训练成本、提高推理效率,以及强大的可扩展性。通过这种技术,大规模模型的部署和应用变得更加高效和可行。

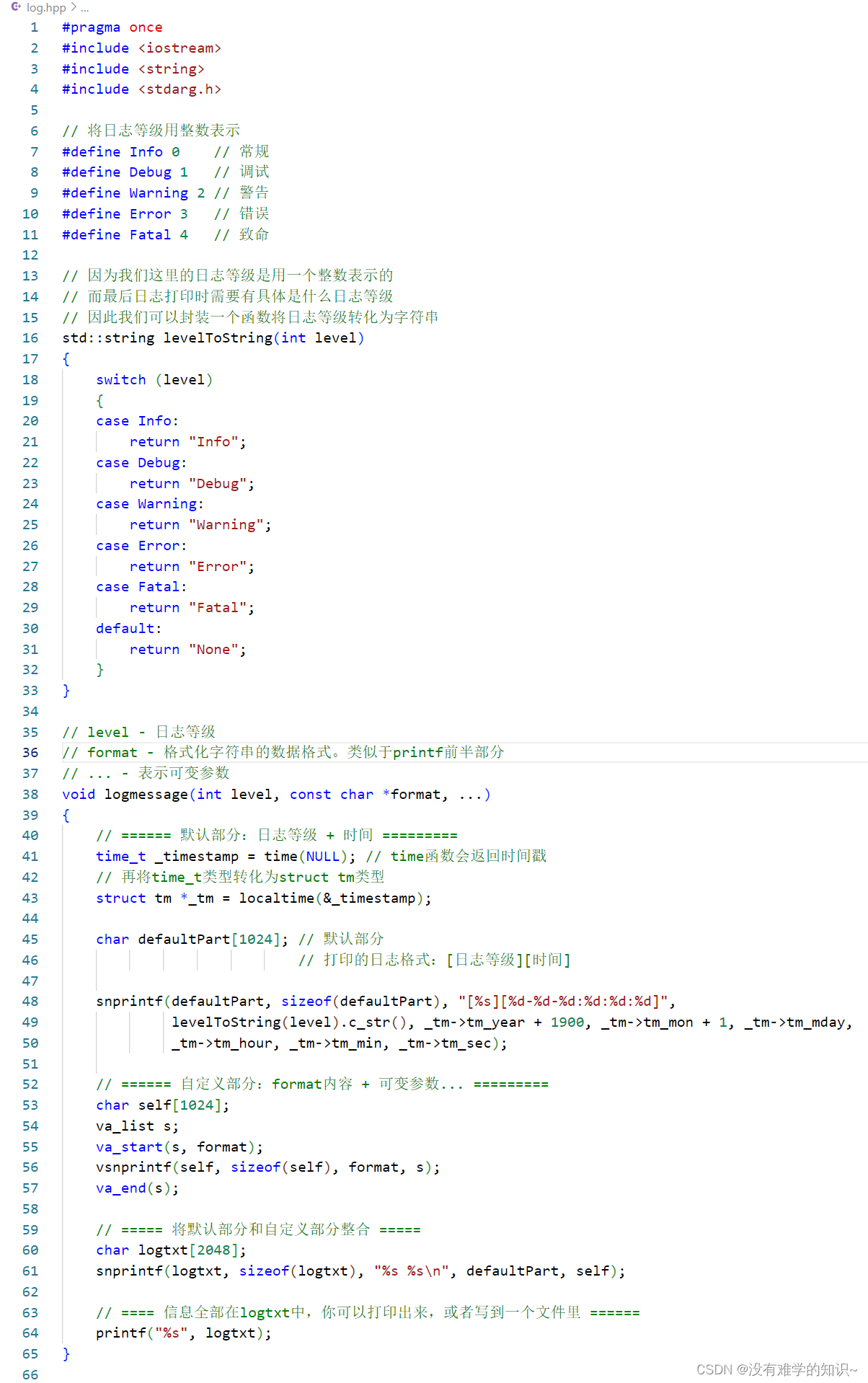

模型的源代码、技术报告和推理代码均已公开,可以通过以下链接访问:

- 模型开源仓库:Skywork-MoE on GitHub

- 模型技术报告:Skywork-MoE Tech Report

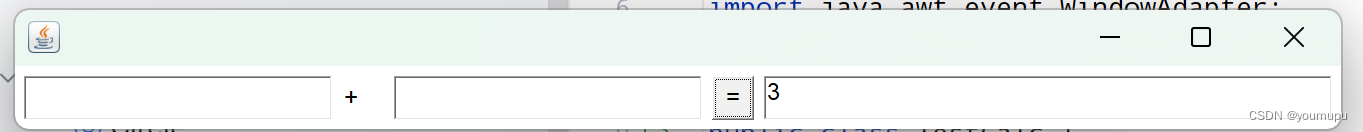

- 模型推理代码(支持8 x 4090服务器上8 bit量化加载推理):vllm on GitHub

以上信息来源于腾讯新闻、CSDN博客和SegmentFault。