重点:通过langchain 调用 定义的工具或api

1. 明确Agent的核心目标

-

应用场景:确定Agent的用途(如客服、个人助手、数据分析、自动化流程等)。

-

输入输出:定义输入形式(文本、语音、图像等)和 输出动作(生成文本、调用API、控制设备等)。

-

性能指标:设定评估标准(响应速度、准确性、任务完成率等)。

2. Agent的核心架构

典型的Agent架构包括以下模块:

(1) 感知模块(Perception)

-

功能:接收多模态输入(文本、语音、图像等),转化为大模型可处理的格式。

-

工具:

-

文本:直接输入大模型。

-

语音:ASR模型(如Whisper)。

-

图像:多模态大模型(如GPT-4V)或专用模型(CLIP)。

-

-

示例:用户语音输入 → Whisper转为文本 → 输入大模型。

(2) 处理核心(大模型)

-

功能:推理、决策、生成响应。

-

关键能力:

-

上下文理解:通过Prompt Engineering注入历史对话或知识。

-

任务分解:用Chain-of-Thought(思维链)或ReAct框架拆分复杂任务。

-

工具调用:通过函数调用(如OpenAI的

tools参数)触发外部API。

-

-

示例:用户问“北京天气如何?” → 模型生成函数调用

get_weather(location="北京")。

(3) 记忆模块(Memory)

-

短期记忆:保存对话上下文(如通过对话历史注入Prompt)。

-

长期记忆:用向量数据库(如Pinecone、FAISS)存储知识,支持检索增强生成(RAG)。

-

示例:用户问“上次提到的项目进展如何?” → 检索数据库获取历史记录。

(4) 决策与执行模块(Action)

-

工具库:定义可调用的API、函数或工具(如搜索引擎、计算器、邮件发送)。

-

执行逻辑:

-

大模型生成工具调用指令(如JSON格式)。

-

解析指令并执行(如调用天气API)。

-

将执行结果返回给大模型生成最终响应。

-

-

示例:模型生成

{"tool": "search", "query": "2024年奥运会举办地"}→ 调用搜索引擎 → 返回结果 → 模型总结答案。

(5) 反馈与优化

-

实时监控:记录Agent的决策过程和结果。

-

评估指标:人工反馈或自动评估(如任务成功率)。

-

迭代优化:通过微调模型、调整Prompt或工具库提升性能。

3. 关键技术实现

(1) Prompt Engineering

-

系统提示词(System Prompt):定义Agent的角色和能力。

"你是一个客服助手,负责回答用户问题。若需要查询订单,请调用 get_order_status API。"

-

思维链(Chain-of-Thought):引导模型分步思考。

-

ReAct框架:将任务拆解为

Thought → Action → Observation循环。

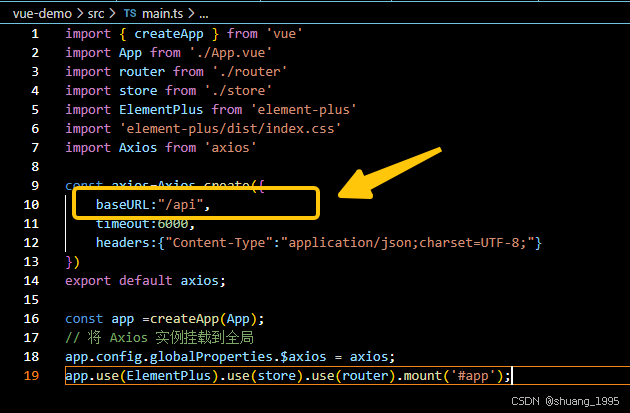

(2) 工具调用与函数嵌入

-

OpenAI Function Calling:让模型生成结构化工具调用请求。

-

LangChain Tools:通过 预定义工具链(如

SerpAPI、WolframAlpha)扩展能力。

(3) 检索增强生成(RAG)

-

将用户问题与向量数据库中的知识匹配,注入到Prompt中提升准确性。

(4) 多Agent协作

-

多个Agent分工协作(如一个负责规划任务,一个负责执行)。

4. 开发工具与框架

-

LangChain:快速集成大模型、记忆模块和工具库。

-

AutoGPT:自动化任务分解和执行的参考实现。

-

HuggingFace Agents:基于开源模型的Agent框架。

-

自定义开发:使用Python + FastAPI + 向量数据库(如Chroma)。

5. 示例:天气查询Agent

描述信息很重要,用于调用工具的基础。

# 伪代码示例(使用LangChain和OpenAI)

from langchain.agents import AgentExecutor, Tool

from langchain_openai import ChatOpenAI# 定义工具:查询天气的API

def get_weather(location: str) -> str:return f"{location}的天气是25℃,晴。"tools = [Tool(name="get_weather",func=get_weather,description="查询某地天气,输入参数是地点名称(如'北京')")

]# 初始化Agent

agent = AgentExecutor.from_agent_and_tools(agent=ChatOpenAI(model="gpt-4").bind(tools=tools),tools=tools

)# 用户输入

response = agent.invoke("北京今天天气如何?")

print(response["output"]) # 输出:北京的天气是25℃,晴。6. 挑战与解决方案

-

上下文长度限制:通过摘要或向量检索压缩关键信息。

-

延迟与成本:对小任务使用轻量级模型(如GPT-3.5 Turbo)。

-

安全性:添加内容过滤层,限制危险工具调用(如删除文件)。

7. 进阶方向

-

自主迭代:让Agent根据反馈自动优化策略(如强化学习)。

-

多模态交互:支持图像生成、语音合成等。

-

长期记忆:结合知识图谱和时序数据库。

![洛谷P1216 [IOI 1994] 数字三角形 Number Triangles(动态规划)](https://i-blog.csdnimg.cn/direct/98f83165b7814be5bc934fd0a0016549.png)