ControlNet 是一个通过添加额外条件来控制SD中图像生成的神经网络,可以使用 ControlNet 来做以下事情:

-

指定人体姿势。

-

从另一幅图像复制图片的构图。

-

生成参考图片类似的图像。

-

将涂鸦图片变成专业的图像。

ControlNet 是用于控制SD的神经网络模型。您可以将 ControlNet 与任SD模型一起使用。

SD模型最基本的形式是文本转图像。它使用文本提示词作为条件来引导图像生成,以便生成与文本提示词相匹配的图像。

ControlNet除了文本提示词外还增加了一个图像生成条件。在 ControlNet 中,额外的条件可以有多种形式。通过边缘检测和人体姿势检测控制图像生成。

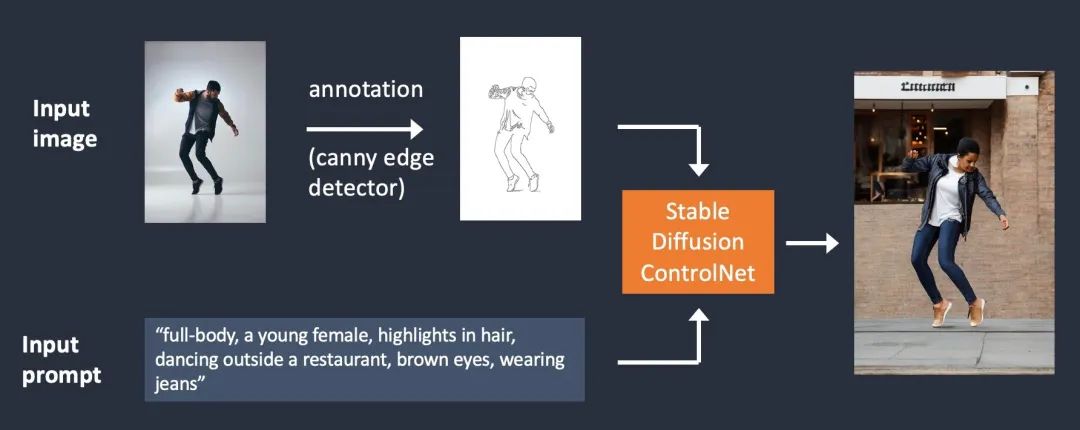

边缘检测

ControlNet 通过接收额外的输入图像,并使用 Canny 边缘检测器检测其轮廓。然后,将包含检测到的边缘的图像保存为控制图。它被输入到 ControlNet 模型中,作为对文本提示词的额外调节条件。

从输入图像中提取特定信息(在本例中为边缘)的过程称为注释或预处理(在 ControlNet 扩展中)。

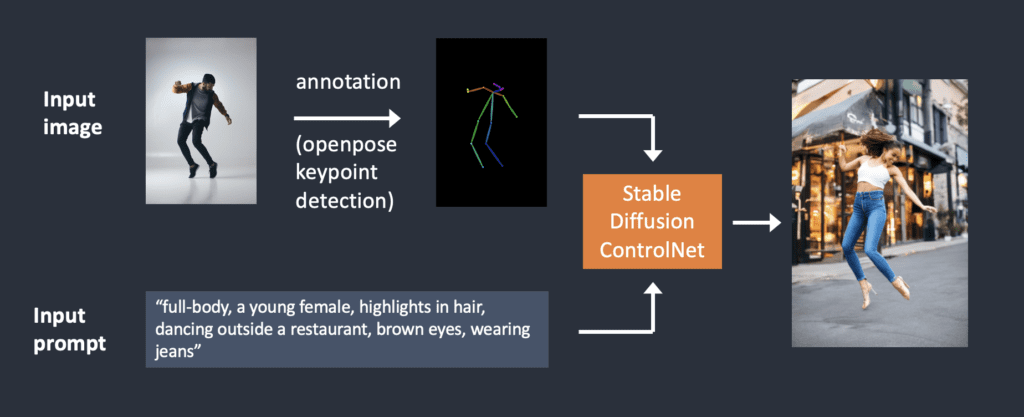

人体姿势检测

边缘检测并不是预处理图像的唯一方法。Openpose是一种快速人体关键点检测模型,可以提取人体姿势,例如手、腿和头部的位置。请参见下面的示例。

以下是使用 OpenPose 的 ControlNet 工作流程。使用 OpenPose 从输入图像中提取关键点,并将其保存为包含关键点位置的控制图。然后将其与文本提示词一起作为额外条件输入到 Stable Diffusion 。以下是根据这两个条件生成图像。

使用 Canny 边缘检测和 Openpose 有什么区别?

Canny 边缘检测器可以提取主体和背景的边缘。它倾向于更专注地翻译场景。你可以看到跳舞的男人变成了女人,但轮廓和发型都保留了下来。OpenPose仅检测人体姿势的关键点,例如头部,手臂等位置。图像生成更加自由,但遵循原始姿势。

上述示例生成了一名女性跳跃的姿势,但是左脚指向侧面,与原始图像和 Canny Edge 示例中的图像不同。原因是 OpenPose 的关键点检测未指定脚的方向。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

零基础AI绘画学习资源介绍

👉stable diffusion新手0基础入门PDF👈

(全套教程文末领取哈)

👉AI绘画必备工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉AI绘画基础+速成+进阶使用教程👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉12000+AI关键词大合集👈

这份完整版的AI绘画全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】