1. 通过 API 人工智能

也许我们以前从未想过,但我无法相信 AI 领域的先驱公司只是决定将他们的高级模型置于 API(“应用程序编程接口”)之后。这意味着最先进的 AI 技术受到其创造者的良好保护,世界其他地区只有在公司允许的情况下才能访问它们,并遵守其严格的使用规则。

是的,有开源替代品,但到目前为止,没有一个能与 OpenAI 的 GPT-3 或谷歌的 LaMDA 相提并论。

2. 基于Token的使用成本

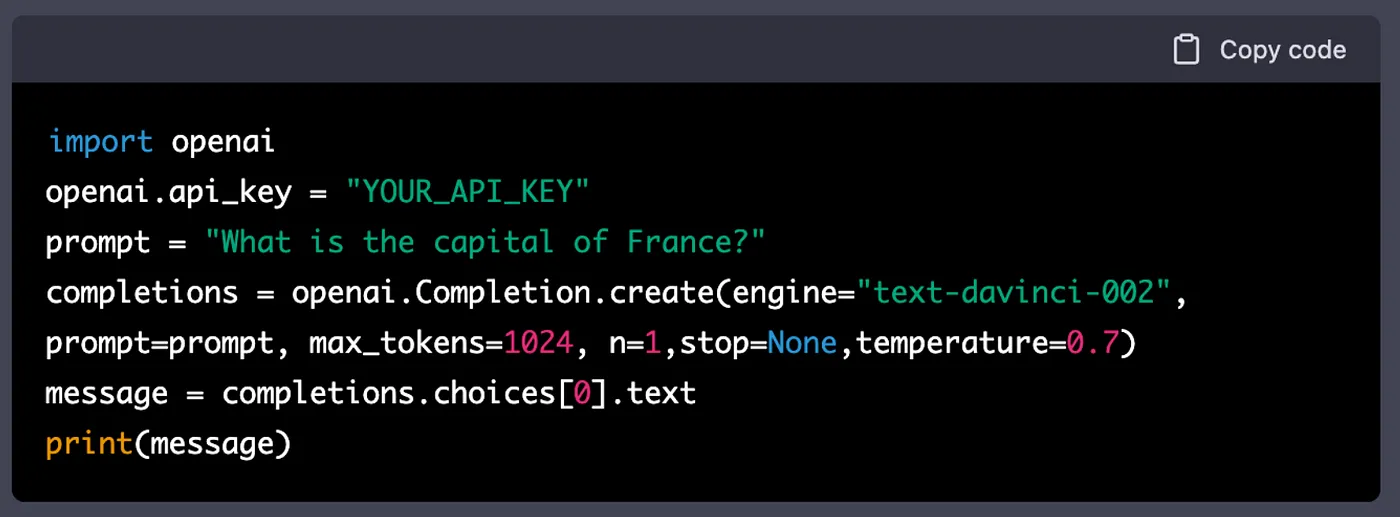

如果您查看 OpenAI 的 GPT-3 模型定价(此链接),您可能会有点困惑。OpenAI 使用“token”作为使用单位。Token大致意思是“几个字符”,所以比如“at”、“hello”等都是token。基于 OpenAI 的分词方法,1000 个分词差不多是 750 个单词。看成本,你可能会觉得好便宜;毕竟你必须为每 10,000 个Token支付 2 美分,这是你使用最先进的 davinci 模型(其他比这更便宜)的时候。但请记住:当您每天多次与 AI 交互时,这些小成本很容易累积。前一个月我因为试验 GPT-3 而被收取 80 美元,如果你是一家公司并且你的员工需要使用这个 AI,请准备好每月支付数千美元的费用。

3.有限的上下文窗口

GPT-3 和 ChatGPT 目前无法处理长输入。这意味着许多涉及总结/撰写长篇书籍的应用程序无法直接实现。GPT-3 只能处理超过 4000 个

![[Apple Push] 【苹果推】Appletexter](https://img-blog.csdnimg.cn/20210630012952297.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L1NlbmRlck4=,size_16,color_FFFFFF,t_70)

![[论文阅读] (15)英文SCI论文审稿意见及应对策略学习笔记总结(letpub爬虫)](https://img-blog.csdnimg.cn/bfbbb0e09e7143b6b67f29edc37a26cd.png?x-oss-process=image/watermark,type_d3F5LXplbmhlaQ,shadow_50,text_Q1NETiBARWFzdG1vdW50,size_14,color_FFFFFF,t_70,g_se,x_16#pic_center)