文章目录

- 前言

- 一、UC-gs:交叉视图不确定性的航拍街道重建(Drone-assisted Road Gaussian Splatting with Cross-view Uncertainty)(质量 )

- 细节

- 结果

- 二、实时高斯:通过光度SLAM加速3DGS(Towards Real-Time Gaussian Splatting: Accelerating 3DGS through Photometric SLAM)(加速 )

- 三、Splatt3R:两张图像的零样本高斯(Splatt3R: Zero-shot Gaussian Splatting from Uncalibrated Image Pairs)(稀疏重建 )

- 细节

- 效果

- 四、Spann3R:空间记忆提升三维重建(3D Reconstruction with Spatial Memory)(质量 )

- 细节

- 五、DoubleTake:几何引导深度估计 Geometry Guided Depth Estimation(ECCV 2024 质量 )

- 六、GenWarp: 语义保留的单张图像生成3D(GenWarp: Single Image to Novel Views with Semantic-Preserving Generative Warping)(稀疏重建 )

- 七、ReconX: 用视频扩散模型从稀疏视图重建任意场景(Reconstruct Any Scene from Sparse Views with Video Diffusion Model)(生成式 )

- 八、航空图像的大场景高斯重建(3D Gaussian Splatting for Large-scale 3D Surface Reconstruction from Aerial Images)(大场景 )

- 九、PRoGS: 渐进高斯渲染(PRoGS: Progressive Rendering of Gaussian Splats )(压缩 )

- 十、大场景的分层表示(A Hierarchical 3D Gaussian Representation for Real-Time Rendering of Very Large Datasets)( 大场景 )

- 总结

前言

提示:以下是本篇文章正文内容,下面案例可供参考

一、UC-gs:交叉视图不确定性的航拍街道重建(Drone-assisted Road Gaussian Splatting with Cross-view Uncertainty)(质量 )

来源:1清华大学人工智能产业研究院2安阳理工大学 3清华大学4北京理工大学

项目:https://sainingzhang.github.io/project/uc-gs/

解决问题:无人机的高海拔限制了它捕捉细粒度的道路细节的能力。全局鸟瞰图和局部街景在尺度和粒度上的不匹配使得MatrixCity [15]不适合无人机辅助的道路场景合成。空中和地面图像表现出较大的视图差异,很难直接训练3D-GS。

自动驾驶仿真场景:无人机视角的数据为地面车辆数据提供一个互补的视角,增强场景重建和渲染的完整性。 本文设计了一种不确定性感知训练方法,允许航空图像辅助合成地面图像学习效果较差的区域,而不是像以前的工作那样在3D-GS训练中对所有像素进行平均加权。通过排除空中透视中不相关的部分,如建筑的upper floor,它们与街景的关系较小,我们成功地减轻了街景上视角的移动和旋转的模糊性,提高了NVS的保真度 。

为了量化评估指标,提供合成数据集 :AirSim [29]控制无人机和车辆进行精确的轨迹生成,拟摄像机的视角,生成真实场景。通过 Unreal Engine 渲染相应的图像数据。地面视图利用车辆轨迹来生成前向图像。如图2,在1.5m和1.8m高度的地方采集前视图地面图像,在20m高度采集鸟瞰图图像,从前视图向下的60°角(基于测试)。1.6米和1.9米高度的附加试验数据评估透视影响。每个场景包括315张地面图像和351张航空图像的训练集,以及36张地面图像的测试集。

综合结果表明:(1)联合训练空中和地面图像有助于提高3D-GS在测试视图移动和旋转时的表示能力,但在held-out(保留)的道路视图测试中表现不佳。(2) 我们的方法减少了联合训练的弱点,并在数据集上进行的测试和涉及视图移动和旋转的场景上定量地优于其他基线。(3) 从质量上讲,我们的方法在道路场景细节的渲染方面有了很大的改进。

整体管道。首先采用基于ensemble的渲染不确定性,量化3D高斯在地面图像上的学习结果。接下来,将地面不确定性投影到空中,以构建交叉视图不确定性。随后,我们将交叉视图不确定性引入到3D高斯训练中,作为损失函数中航空图像每个像素的权重,以及3D-GS对地面图像的原始渲染损失。

细节

训练时,对空中和地面图像中的所有像素进行平均加权,会使空中图像具有与道路图像相同的合成优先级。与道路场景不重叠的区域和对道路场景合成贡献不大的区域不仅不能提高道路重建的有效性,也影响三维高斯收敛。

具体地说,训练一个由地面图像生成的运动结构(SfM)初始化的M个高斯溅射(GS)集合。通过将集合解释为均匀加权混合模型,成员的预测通过平均进行组合,预测不确定性表示为单个成员预测的方差。

一组GS中,场景中像素p的期望颜色,以及不确定性(即单个像素预测的方差)分别为:

通过渲染M个单独的RGB图像,并直接在像素空间中计算均值和方差,可以非常容易地计算 µ R G B µ_{RGB} µRGB 和 σ R G B 2 σ^2_{RGB} σRGB2 。两者都是RGB颜色通道上的3个矢量。通过以下方式将颜色通道的方差合并为一个不确定性值:

1.交叉视图不确定性投影。为了将不确定性图从地面视图投影到空中视图,我们测试了几种方法。基于神经场的方法,如NeRF和3D-GS,容易过拟合,因此用地面不确定性图训练的神经场无法在空中呈现高质量的不确定性。此外, 最近出现的端到端密集立体模型DUSt3R[39]将SoTA设置在许多3D任务上,可以用作空中和地面图像之间的2D-2D像素匹配器 。通过这种方式,通过地面和空中图像之间的匹配,将地面的不确定性图投影到空中,并通过多次匹配像素处的不确定性进行平均,构建出合理的交叉视图的不确定性图。可视化如图5所示。

2.不确定性敏感的训练。 U k ( x ) U_k(x) Uk(x)是第k幅航拍图像的像素x的不确定性值将其归一化到(0,1):

最后用uncertainty map来加权损失( λ S S I M λ_{SSIM} λSSIM = 0.2 λ v o l λ_{vol} λvol = 0.001):

L v o l L_{vol} Lvol是[Scaffold-gs]中使用的体积正则化,使得高斯球小,且重叠少。

结果

实验采用两个真实的城市场景:纽约市(NYC)和旧金山(SF),收集自Kyrylo Sibiriakov 和 Tav Shande。总结:不仅提高了从地面角度对GS的表示,而且 improves the quality of road scenes synthesis during the view shifting and rotation。

二、实时高斯:通过光度SLAM加速3DGS(Towards Real-Time Gaussian Splatting: Accelerating 3DGS through Photometric SLAM)(加速 )

来源:滑铁卢大学

论文:https://arxiv.org/pdf/2408.03825

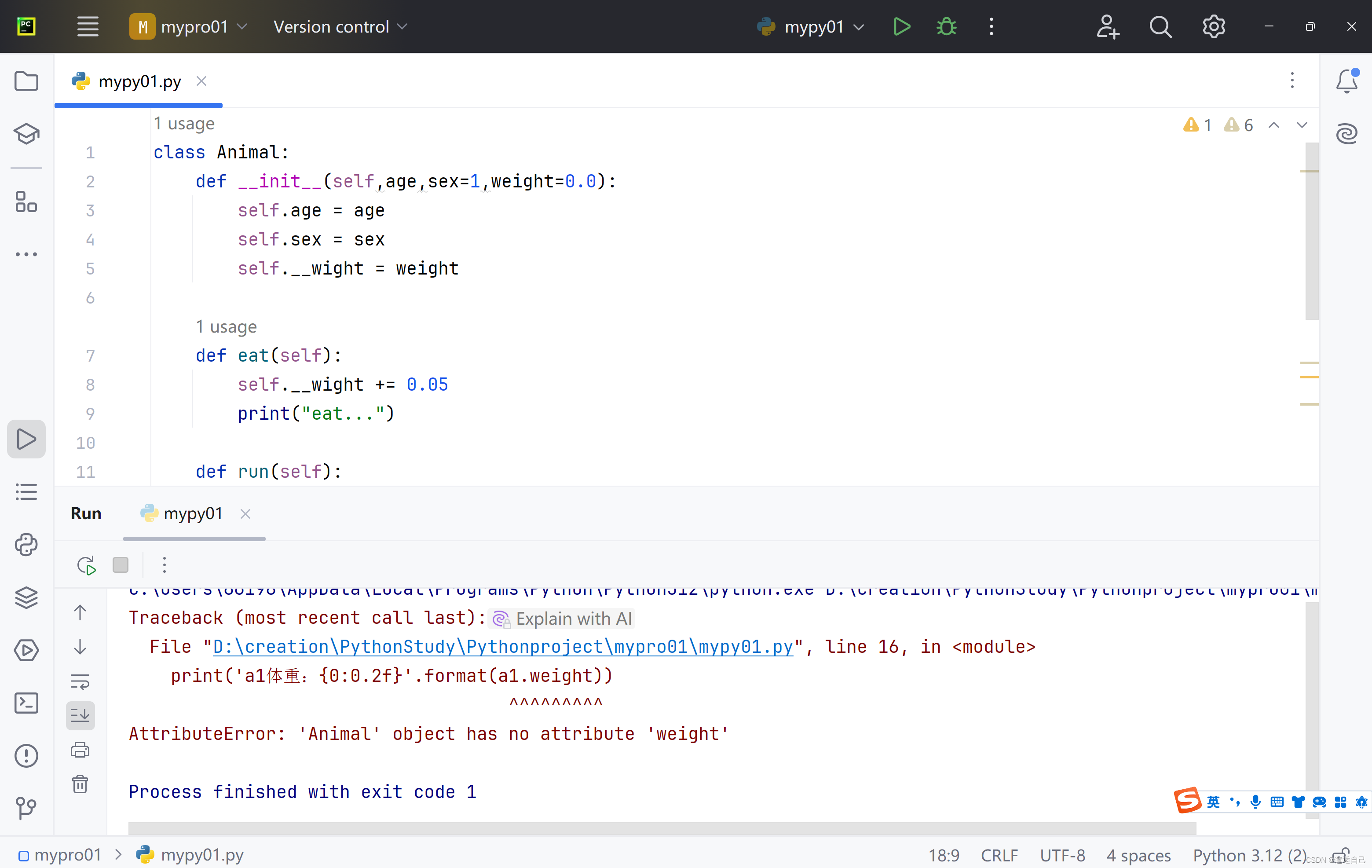

摘要。与传统的VSLAM相比,当前的3DGS集成降低了跟踪性能和运行速度。为了解决这些问题,我们建议将3DGS与单目光度SLAM系统直接稀疏测距相结合(integrating 3DGS with Direct Sparse Odometry, a monocular photometric SLAM system)。我们已经进行了初步实验,表明直接使用稀疏的里程计Odometry 点云输出,而不是标准的运动结构方法,可以显著缩短实现高质量渲染所需的训练时间。减少3DGS训练时间可以开发在移动硬件上实时运行的3DGS集成SLAM系统。

传统的VSLAM方法使用场景表示,如点云和占用网格,并不能完全捕捉场景。相比之下,3D高斯溅射(3DGS)[1]可以生成具有增强细节和真实性的场景。3DGS对VSLAM的首次应用,如SplaTAM [2],成功地使用实时单眼视频输入生成了3DGS场景。然而,与ORBSLAM3 [3]等传统VSLAM系统相比,它们的跟踪精度更低,运行速度更慢。这些挑战可能源于他们的跟踪方法的不同。传统的VSLAM通过跟踪连续图像上的特征点来计算姿态。相比之下,3DGS通过扩展3DGS优化到包括姿态,将3DGS纳入VSLAM

DUSt3R并不是产生高密度点云的唯一方法。我们的主要贡献是证明了单目光度或基于像素的VSLAM系统,如直接稀疏测量(Direct Sparse Odometry:DSO,类似于LOFTER,不使用特征点来做投影匹配)[7],可以产生高密度点云,加速3DGS训练。基于像素的SLAM系统跟踪高梯度像素而不是特征点,由于有更多的跟踪候选对象,因此会导致更密集的点云。我们进一步修改了DSO,以跟踪更多未用于姿态优化的像素,将点云密度增加到与DUSt3R相当的水平。我们做的实验表明,将修改后的DSO点云和姿态输入到3DGS中,而不是使用Colmap,可以显著提高训练时间,特别是在训练过程的早期。定性地说,3DGS的高质量渲染在一分钟内完成,如图1所示。此外,DSO以实时速度运行,这比典型的结构从运动系统更快。这一贡献对于使用3DGS的VSLAM系统尤其有利,其中速度是最重要的。

DSO和所做的修改的简化描述。DSO的工作原理是在连续的帧i和帧j中跟踪一组像素。它优化姿态p,使用下面的光度损失方程的每个像素:

其中I为像素强度,a和b是光度变量,s是曝光。这个函数在考虑照明变化时,找到最匹配帧 i i i 和帧 j j j 之间的像素变化.

通过跟踪高梯度像素,DSO可以为其地图创建密集的点云;然而,点选择是为跟踪性能而优化的,而不是最大化点密度。我们发现,在更密集的点云上,3DGS训练比通常为DSO的最佳跟踪设置生成的更快。为了在不影响跟踪的情况下提高3DGS的性能,我们修改了DSO,以包含不用于姿态跟踪的额外的点。

对DSO的像素选择器进行修改,在缺乏跟踪像素的区域寻找均匀分布的额外像素。因为这些额外的像素很难跟踪位置,所以它们只优化了位置,而不会影响整体的姿态跟踪。此外,图像中的一些区域缺乏梯度,使得跟踪成为不可能。为了确保3DGS的这些无梯度区域中存在点,我们实现了一个系统,在这些区域中放置一些点,并将它们的位置设置为附近跟踪点的平均值。

Replica上实验效果:

三、Splatt3R:两张图像的零样本高斯(Splatt3R: Zero-shot Gaussian Splatting from Uncalibrated Image Pairs)(稀疏重建 )

来源:1 Active Vision Lab, 2 Visual Geometry Group --University of Oxford

代码:https://splatt3r.active.vision/

Splatt3R,这是一种无姿态的前馈方法,用于野外3D重建和从立体对合成新的视图。给定未校准的自然图像,Splatt3R可以预测3D高斯splats,而不需要任何相机参数或深度信息。为了通用性,简单地在一个大规模的预训练“foundation”3D MASt3R模型中添加一个高斯解码器,将其扩展到处理3D结构和外观。具体来说,与仅重建3D点云的原始MASt3R不同,我们预测了为每个点构建高斯基元所需的额外高斯属性。因此,与其他新颖的视图合成方法不同,Splatt3R首先通过优化3D点云的几何损失来训练,然后是新视图的综合目标。通过这样做,我们避免了在从立体视图训练3D高斯时出现的局部最小值。我们还提出了一种新的损失mask策略,这对于外推视角至关重要。实验在ScanNet++数据集上训练Splatt3R,并对未校准的野生图像进行了出色的泛化。Splatt3R可以以512 x 512分辨率以4FPS重建场景,并且可以实时渲染生成的splat。

我们使用视觉变换器编码器同时对每个图像进行编码,然后将它们传递给Transformer解码器,该解码器在每个图像之间执行交叉注意。通常,MASt3R有两个预测头,一个用于预测像素对齐的3D点和置信度,另一个用于特征匹配。我们引入了第三个头来预测每个点的协方差(由旋转四元数和尺度参数化)、球谐函数、不透明度和平均偏移。这使我们能够为每个像素构建一个完整的高斯基元,然后我们可以对其进行渲染以进行新颖的视图合成。在训练过程中,我们只训练高斯预测头,依赖于预训练MASt3R模型来做其他参数。

为了优化我们的高斯参数预测,我们监督预测场景的新视图渲染。在训练过程中,每个样本由两个输入的“上下文”图像组成,我们使用它们来重建场景,以及一些带pose的“目标”图像,用于计算渲染损失。这些目标图像中的一些可能包含场景的区域,这些区域由于被遮挡或位于其平截头体之外而对两个上下文视图不可见。为了解决这个问题,我们只监督渲染中包含与上下文图像中的像素之一直接对应的像素的区域。这使我们能够从不一定是两个输入图像之间的插值的视角来监督我们的渲染。

细节

提出背景: 大多数现有的可推广的3D-GS方法的一个显著局限性是,它们只监督输入立体视图[7,10]之间的新视点,而不是学习推断到更远的视点。这些外推观点的挑战是,他们经常看到的点被输入相机视图模糊,或者完全在他们的截锥体之外。因此,监督这些点的新视图呈现损失是适得其反的,并可能对模型的性能造成破坏。通过只监督位于两个上下文图像之间的视图的新视图渲染丢失,现有的工作避免了试图重建场景中许多看不见的部分。然而,这意味着该模型没有经过训练来准确地为超出立体基线的视图生成新的视图渲染

为了解决这个问题,我们采用了一种基于 frustum culling(截锥体裁剪)和covisibility testing的损失mask策略,使用训练中已知的地面真实姿态和深度图进行计算。我们只将均方误差和LPIPS损失应用于渲染中可以可行地重建的部分,从而防止了从场景中不可见的部分更新到我们的模型。

MASt3R训练。给定真实pointmap X 1 X^1 X1和 X 2 X^2 X2,对于每个视图v∈{1,2}中的每个有效像素i,训练目标 L p t s L_{pts} Lpts定义为:

Pixel Splat[7]和MVSplat [10]都使用前馈的、交叉注意的网络架构来提取输入视图之间的信息。其次,MASt3R预测每个图像的像素对齐的3D点(和置信度),而可推广的3D-GS模型预测每个图像的像素对齐的三维高斯分布。

给定一组未校准的图像 I I I,MASt3R使用ViT对其编码,再传递给解码器,在每个图像之间执行交叉注意。MASt3R有两个预测头,一个预测每个像素的一个3D点(x)和置信度©,另一个用于特征匹配(这里没用到); 本文引入了第三个“高斯头”,预测了每个点的协方差(由旋转四元数 q ∈ R 4 q∈R^4 q∈R4和尺度 s ∈ R 3 s∈R^3 s∈R3参数化)、球面谐波( S ∈ R 3 × d S∈R^{3×d} S∈R3×d)和透明度(α∈R),并预测了每个点的偏移量( ∆ ∈ R 3 ∆∈R^3 ∆∈R3),将高斯原语的均值参数化为µ=x+∆: 为每个像素构造一个完整的高斯原语,再对其渲染合成新视图。 只训练高斯预测头(DPT架构[45]),其他参数依赖于预训练MASt3R模型。

为了帮助学习高频颜色,我们试图预测每个像素的颜色和我们应用于该像素对应的高斯原语的颜色之间的残差。训练中每个样本由两张“上下文”图像,用于重建场景,以及一些带pose的“目标”图像,用于计算渲染损失。

未见区域的loss mask。“目标”图像可能包含场景的一些区域,由于被遮挡,两个上下文视图不可见,或完全在上下文视图之外。监督未见的像素的渲染损失,会适得其反,并对模型的性能造成潜在的破坏。现有的可推广的前馈辐射场预测方法试图通过只合成输入立体视图[7,10,16]之间的新视图来避免这个问题,从而减少了需要重建的不可见点的数量。相反,我们试图训练我们的视角到更远的地方,而不是两个输入图像之间的插值。

计算每个“目标”图像中,哪个像素在至少一个上下文图像中是可见的。反投影其中的每个点,到每个上下文图像上,检查渲染的深度是否与地面真实深度密切匹配。例子如图3。最终的mask重建损失为:

效果

预处理计算了训练集中每个场景的图像重叠mask:第二图像中至少ϕ%的像素在第一图像中具有直接对应,并且目标图像至少ψ%的像素出现在至少一个上下文图像中。

训练分割中的每个场景中随机抽取2张输入图像和3张目标图像。使用我们在ϕ= ψ = 0.3中设置的ϕ和ψ参数来选择视图。我们使用λMSE = 1.0和λLP IP S = 0.25,以分辨率为512×512对模型进行2000个周期(≈50万次迭代)的训练。我们使用在1.0×10−5的学习速率下的Adam优化器进行优化,权重衰减为0.05,梯度剪辑值为0.5

四、Spann3R:空间记忆提升三维重建(3D Reconstruction with Spatial Memory)(质量 )

来源:Department of Computer Science, University College London

主页:https://hengyiwang.github.io/projects/spanner

代码:soon

Spann3R,一种从有序或无序的图像,到密集的三维重建。建立在DUSt3R范式上的Spann3R使用了一个基于transformer的架构,在不事先了解场景或摄像机参数的情况下,直接从图像中回归点图。DUSt3R可以预测在其局部坐标系中表达的每个图像对点图,而Spann3R可以预测在全局坐标系中表达的每个图像点图,从而消除了基于优化的全局对齐的需要。Spann3R的关键思想是管理一个外部空间记忆,学习跟踪所有以前相关的3D信息。然后,Spann3R查询这个空间内存,以预测全局坐标系中下一个坐标系的三维结构。利用DUSt3R的预训练权重,并对数据集子集进行进一步微调,Spann3R在各种未知数据集上显示出具有竞争力的性能和泛化能力,可以实时处理有序的图像集合

图1.概述。给定一组有序或无序的图像集合,而不知道相机参数的先验知识,所提出的Spann3R可以通过直接回归在一个公共坐标系中的每个图像的点图来增量地重建三维几何图形。Spann3R在推理过程中不需要任何基于优化的对齐,即每个图像的三维重建可以通过简单的基于transformer的正向传递来解决,从而实现实时在线重建。通过对一些自捕获的图像进行重建,以说明Spann3R的泛化能力。

图2.动机。DUSt3R [81]直接在一个局部坐标系中回归每个图像对的点图。相比之下,Spann3R通过一个存储所有先前预测的空间记忆来预测一个公共坐标系中的全局点图。因此,我们的方法可以实现在线增量重建,而不需要建立一个密集的成对图和一个最终的基于优化的对齐。

图3。Spann3R的概述。我们的模型包含一个ViT [25]编码器和两个相互交织的解码器,如DUSt3R [81]。这里的目标解码器用于从图像中获取查询特征进行内存查询,而参考解码器用于使用几何特征和我们的记忆特征基于内存读出进行预测。一个轻量级的内存编码器被用来将先前预测的点图和几何特征一起编码到我们的内存键和值特征中。破折号表示在下一个时间步中的操作

细节

给定一个图像序列{ I t I_t It} t = 1 N ^N_{t=1} t=1N,训练一个网络 F F F,将每个 I t I_t It映射到其对应的点图 X t X_t Xt,并用初始帧的坐标系表示。为实现这一点,引入了一个空间内存,它编码之前的预测,以推理下一帧。

编码。向前传递中,模型以一帧 I t I_t It和前一个查询 f t − 1 Q f_{t−1}^Q ft−1Q作为输入。ViT用于将帧编码为视觉特征,查询特征 f t − 1 Q f_{t−1}^Q ft−1Q用于检索内存库中的特征,输出融合特征 f t − 1 G f_{t−1}^G ft−1G(fK和fV是内存key和value特征):

解码。融合特征 f t − 1 G f_{t−1}^G ft−1G和视觉特征 f t I f_t^I ftI被输入两个交织在一起的解码器,通过交叉注意共同处理它们。这可以使模型能够解释两个特征之间的空间关系;Target Decoder解码的特征ftH‘输入MLP,生成下一步的查询特征:

由Reference Decoder解码的特征 f t − 1 H f_{t−1}^H ft−1H被输入一个MLP头,以生成点图和置信度(同时也从 f t H ’ f_{t}^H’ ftH’生成一个点图和信心,仅供监督):

memory编码。Reference Decoder的特征和预测点图用于对存储器key和value特征进行编码:

由于memory key和value特征同时具有来自几何特征和视觉特征的信息,因此它可以实现基于外观和距离的memory readout

讨论。 与DUSt3R [81]相比,我们的架构有一个更轻量级的内存编码器和两个MLP头,用于编码查询、内存密钥和内存值特性。对于解码器,DUSt3R [81]包含两个解码器——一个参考解码器重建标准坐标系中的第一个解码器,和一个目标解码器重建第一个图像的第二个解码器。相反,我们在DUSt3R [81]中重新使用了这两个解码器。目标解码器主要用于产生查询存储器的特征,而参考解码器从存储器中提取融合的特征进行重构。在初始化方面,我们直接使用了两个视觉特征。

空间记忆。 图4显示了空间内存的概述,包括密集的工作内存、稀疏的长期内存和从内存中提取特征的内存查询机制。

空间存储器存储所有键的 f K ∈ R B s × ( T ⋅ P ) × C f^K∈R^{Bs×(T·P)×C} fK∈RBs×(T⋅P)×C和key的 f V ∈ R B s × ( T ⋅ P ) × C f^V∈R^{Bs×(T·P)×C} fV∈RBs×(T⋅P)×C特征。为了计算融合特征 f t − 1 G f^G_{t−1} ft−1G,使用查询特征 f t − 1 Q f^Q_{t −1} ft−1Q∈ R B s × P × C R^{Bs×P×C} RBs×P×C进行交叉注意力,实现内存读取:

注意图 A A A包含了当前查询中的每个token相对于内存key中的所有token的一个密集的注意权重(见图8)。我们在训练过程中应用了0.15的注意退出,以鼓励模型从记忆值的一个子集中推理几何形状。

效果。

五、DoubleTake:几何引导深度估计 Geometry Guided Depth Estimation(ECCV 2024 质量 )

来源:1Niantic 2University College London

代码:https://github.com/nianticlabs/doubletake

摘要:从一系列带pose的RGB图像中估计深度是一项基本的计算机视觉任务,在增强现实、路径规划等领域有应用。先前的工作通常利用多视图立体框架中的先前帧,依赖于在局部邻域中匹配纹理。相比之下,我们的模型通过向我们的网络提供最新的3D几何数据作为额外输入来利用历史预测。这种自生成的几何提示可以对关键帧未覆盖的场景区域的信息进行编码,与之前帧的单个预测深度图相比,它更加正则化。我们引入了一种Hint MLP,它将代价体特征与先验几何的提示相结合,从当前相机位置渲染为深度图,并对先验几何的置信度进行度量。我们证明,我们的方法可以以交互速度运行,在离线、增量和重访评估场景中实现了最先进的深度估计和3D场景重建。

我们的主要贡献是将廉价的元数据注入到特征卷中。然后,在输入到2D成本体积编码器-解码器之前,每个体积单元与MLP并行缩减为特征图。我们还使用了一个图像编码器,专门用于在成本体积编码器-解码器中在整个帧中传播和校正成本体积的深度估计时,强制执行强图像先验。该公式灵活,允许三种不同的操作模式:1)增量在线深度和重建,每帧76.6ms;2)离线高质量离线深度和重建的,每场景13.8s;3)在长时间缺席后重访位置时,以每帧62.8ms的速度重访深度估计。

几何注入。通过匹配的MLP,我们的功能量减少到成本量。然后,我们的Hint MLP将多视图立体成本量与先前预测的几何体的估计相结合。对于成本体积中的每个位置,Hint MLP将以下内容作为输入:(i)视觉匹配得分,(ii)几何提示,由渲染的深度提示与该成本体积位置处的深度平面之间的绝对差形成,以及(iii)该像素处提示的置信度估计。

六、GenWarp: 语义保留的单张图像生成3D(GenWarp: Single Image to Novel Views with Semantic-Preserving Generative Warping)(稀疏重建 )

代码:https://genwarp-nvs.github.io/

来源:1Sony AI 2Sony Group Corporation 3Korea University

针对Scene的Sparsefusion(VLDM)来了,单视图通过生成式模型生成Few View,通过Splatter3R / Instantsplat等稀疏GS方法实现场景建模

由于3D场景的复杂性和现有多视图数据集训练模型的多样性有限,从单个图像生成新视图仍然是一项具有挑战性的任务。最近将大规模文本到图像(T2I)模型与单目深度估计(MDE)相结合的研究在处理野生图像方面显示出了希望。在这些方法中,输入视图被几何扭曲为具有估计深度图的新视图,然后扭曲的图像被T2I模型修复。然而,当将输入视图扭曲为新的视点时,它们会与嘈杂的深度图和语义细节的丢失作斗争。在这篇论文中,我们提出了一种新的单目新视图合成方法,这是一种语义保持的生成扭曲框架,通过用自注意力增强交叉视图注意力,使T2I生成模型能够学习在哪里扭曲和在哪里生成。我们的方法通过在源视图图像上调节生成模型并结合几何扭曲信号来解决现有方法的局限性。定性和定量评估表明,我们的模型在域内和域外场景中都优于现有方法。

七、ReconX: 用视频扩散模型从稀疏视图重建任意场景(Reconstruct Any Scene from Sparse Views with Video Diffusion Model)(生成式 )

主页:https://liuff19.github.io/ReconX/

代码:soon

来源:Tsinghua University, 2HKUST

它将模糊的重建挑战重新定义为时间生成任务。关键的见解是释放大型预训练视频扩散模型的强生成先验,用于稀疏视图重建。然而,在预训练模型直接生成的视频帧中,3D视图的一致性很难被准确地保持。为了解决这个问题,在输入视图有限的情况下,提出的ReconX:首先构建一个全局点云,并将其编码到上下文空间中作为3D结构条件。在条件的指导下,视频扩散模型然后合成既保留细节又表现出高度3D一致性的视频帧,确保场景从各个角度的连贯性。最后,我们通过置信度感知的3D高斯散点优化方案从生成的视频中恢复3D场景。对各种真实世界数据集的广泛实验表明,我们的ReconX在质量和可推广性方面优于最先进的方法。

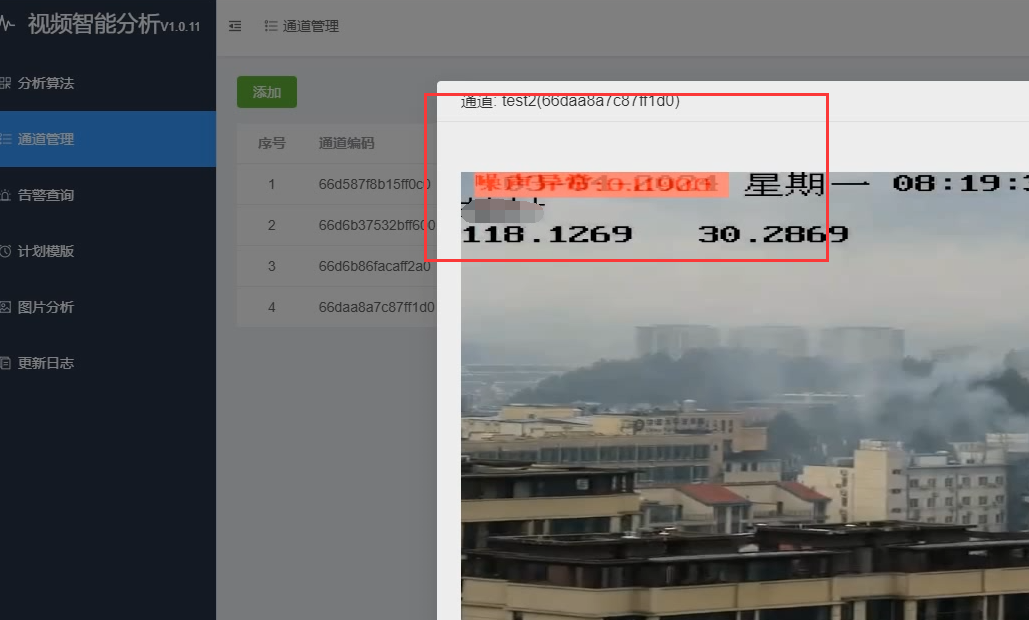

八、航空图像的大场景高斯重建(3D Gaussian Splatting for Large-scale 3D Surface Reconstruction from Aerial Images)(大场景 )

https://arxiv.org/pdf/2409.00381

大场景航拍GS建模,除了分块之外,引入了ray-tracing GS方法实现深度、法向量估计,结合多视角一致性约束,实现了与MVS方法接近的Meshing质量的同时、SOTA的GS渲染效果

九、PRoGS: 渐进高斯渲染(PRoGS: Progressive Rendering of Gaussian Splats )(压缩 )

https://arxiv.org/pdf/2409.01761

渐进式渲染一篇工作,类似压缩感知,可以在只加载10% splat的情况下达到80%质量的渲染效果,也可以结合splat压缩使用

十、大场景的分层表示(A Hierarchical 3D Gaussian Representation for Real-Time Rendering of Very Large Datasets)( 大场景 )

d \sqrt{d} d 1 8 \frac {1}{8} 81 x ˉ \bar{x} xˉ x ^ \hat{x} x^ x ~ \tilde{x} x~ ϵ \epsilon ϵ

ϕ \phi ϕ

总结

提示:这里对文章进行总结:

例如:以上就是今天要讲的内容,本文仅仅简单介绍了pandas的使用,而pandas提供了大量能使我们快速便捷地处理数据的函数和方法。