人工智能咨询培训老师叶梓 转载标明出处

如何精确控制大规模无监督语言模型(LMs)的行为一直是一个挑战。这些模型虽然通过大量数据学习到了广泛的世界知识和一些推理技能,但由于其训练的无监督性质,使得它们的行为难以精确控制。现有的方法通过收集人类对模型生成内容的相对质量标签,然后通过人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF)对无监督LM进行微调,以使其行为与这些偏好对齐。然而,RLHF是一个复杂且常常不稳定的过程,它首先拟合一个反映人类偏好的奖励模型,然后使用强化学习对大型无监督LM进行微调,以最大化估计的奖励,同时不过分偏离原始模型。

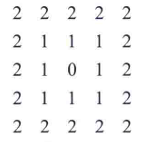

斯坦福大学的研究团队提出了一种名为“直接偏好优化”(Direct Preference Optimization, DPO)的新方法。DPO通过一种新的奖励模型参数化方法,使得可以直接提取相应的最优策略,而不需要复杂的强化学习过程。DPO算法稳定、高效且计算成本低,消除了在微调过程中从LM采样或进行大量超参数调整的需要。图 1展示了直接偏好优化(DPO)与现有方法的区别。

论文链接:https://arxiv.org/pdf/2305.18290

方法

DPO的核心思想是利用奖励函数到最优策略的解析映射,将奖励函数上的损失函数转换为策略上的损失函数。这种方法避免了显式拟合独立的奖励模型,同时在现有的人类偏好模型(如Bradley-Terry模型)下进行优化。策略网络在DPO中既代表了语言模型,也隐式地代表了奖励模型。

研究者从与先前工作相同的强化学习目标出发,通过一系列数学推导,得到了最优策略的表达式。这个表达式涉及到一个分区函数Z(x),它在实际应用中估计起来可能很昂贵。然而,通过重新排列和一些代数操作,研究者能够用最优策略πr、参考策略πref和未知的分区函数Z来表示奖励函数。特别地,Bradley-Terry模型仅依赖于两个完成之间的奖励差异,这使得分区函数在替换过程中被消去,从而可以用最优策略和参考策略来表示人类偏好概率。

研究者分析了损失函数LDPO的梯度:LDPO损失函数的梯度增加了优选完成(preferred completions)的可能性,并减少了不优选完成(dispreferred completions)的可能性。这些例子的权重取决于隐式奖励模型对不优选完成的评分,按β进行缩放,即隐式奖励模型对完成的排序错误程度,这考虑了KL约束的强度。

DPO的一般流程包括两个步骤:

1)对于每个提示x,采样完成y1, y2,并用人类偏好进行标记,构建偏好的离线数据集D;

2)优化语言模型πθ,以最小化给定πref和D以及期望的β下的LDPO。在实践中,研究者希望能够重用公开可用的偏好数据集,而不是生成样本和收集人类偏好。由于偏好数据集是使用πSFT采样的,因此通常初始化πref = πSFT。然而,当πSFT不可用时,研究者通过最大化优选完成(x, yw)的可能性来初始化πref。

研究者进一步解释了DPO方法,并提供了理论支持,将DPO的优势与RLHF中使用的演员-评论家算法(如PPO)的问题联系起来。研究者定义了奖励函数之间的等价关系,并提出了两个引理来证明在Plackett-Luce偏好框架下,同一类的两个奖励函数产生相同的偏好分布,并且同一等价类中的两个奖励函数在受约束的强化学习问题下产生相同的最优策略。

想要掌握如何将大模型的力量发挥到极致吗?叶老师带您深入了解 Llama Factory —— 一款革命性的大模型微调工具。9月22日晚,实战专家1小时讲解让您轻松上手,学习如何使用 Llama Factory 微调模型。

加助理微信提供直播链接:amliy007,29.9元即可参加线上直播分享,叶老师亲自指导,互动沟通,全面掌握Llama Factory,关注享粉丝福利,限时免费CSDN听直播后的录播讲解。

LLaMA Factory 支持多种预训练模型和微调算法。它提供灵活的运算精度和优化算法选择,以及丰富的实验监控工具。开源特性和社区支持使其易于使用,适合各类用户快速提升模型性能。

实验

实验设置:

情感控制生成:使用IMDb数据集中的电影评论前缀作为输入x,策略需要生成具有积极情感的文本y。为了进行控制评估,研究者使用预训练的情感分类器生成偏好对。

摘要生成:输入x是Reddit论坛帖子,策略必须生成帖子主要内容的摘要y。使用了Reddit TL;DR摘要数据集和由Stiennon等人收集的人类偏好。

单轮对话:输入x是人类查询,可以是任何问题或请求。策略必须产生对用户查询有帮助和吸引人的响应y。研究者使用了Anthropic Helpful and Harmless对话数据集。

评估方法:

为了分析算法在优化受约束的奖励最大化目标方面的有效性,研究者评估了每个算法在实现奖励和与参考策略的KL散度之间的权衡。

在现实世界中,真实的奖励函数是未知的,因此研究者使用GPT-4作为人类评估摘要质量和响应有帮助性的代理,来评估算法。

实验结果:

图2展示了不同算法在情感设置中的奖励-KL边界。DPO在所有KL值下都提供了最高的期望奖励,展示了优化的质量。

在TL;DR摘要任务中,DPO在0.0的采样温度下达到了约61%的胜率,超过了PPO在0.0采样温度下57%的性能。DPO在不同的采样温度下也显示出比PPO更好的鲁棒性。

在单轮对话任务中,DPO是唯一在Anthropic HH数据集中超过优选完成的方法,并且提供了与计算成本较高的Best of 128基线相似或更好的性能。

图3进一步展示了DPO在Anthropic-HH单轮对话中的胜率,以及在训练过程中不同采样温度下的胜率演变。DPO在训练过程中对数据集标签的改进在不同采样温度下相对稳定。

表 1为在CNN/DailyMail数据集上,PPO和DPO算法在不同采样温度下的GPT-4胜率与地面真相摘要的比较。DPO继续以显著的优势超越PPO策略,这为DPO策略与PPO策略的泛化能力提供了初步证据。

研究者通过人类研究验证了GPT-4判断的可靠性(表2)。研究发现,GPT-4的判断与人类的判断一致性与人类评价者之间的一致性相似或更高,这表明GPT-4是评估的合理代理。

这些实验结果表明,DPO算法在几乎不需要调整超参数的情况下,就能在多个任务上实现与或优于现有强基线算法(如使用PPO的RLHF)的性能,同时在计算上更加高效。