音乐,作为全人类共享的文化瑰宝,具有强大的凝聚力,它不仅塑造了我们的社会风貌,更为我们的身心健康带来诸多益处。然而,听力损失却无情地削弱了这份美妙的体验。据世界卫生组织预测,到2050年,全球将有高达25亿人口面临不同程度的听力损失,其中至少7亿人急需治疗。听力受损使得人们在聆听音乐时遭遇重重障碍,如细微之处难以捕捉、音高感知失准,以及歌词与乐器辨识困难等问题。

鉴于此,研发更为先进的音乐处理技术,以优化助听器和消费级设备的音质表现,对于保障听力受损人群的音乐享受与福祉显得尤为重要。对于轻度至中度听力损失的患者而言,助听器是最常见的解决方案。尽管许多助听器配备了音乐模式,但实际效果却参差不齐,高达68%的用户反映在使用助听器聆听音乐时感到困扰。这一问题的复杂性在于,助听器需根据个体听力阈值进行频率依赖性的非线性放大,同时还需应对低强度声音的快速响度增长(即响度招募)以及避免过大声音带来的不适。为实现这一目标,宽动态范围压缩系统(WDRC)被广泛应用,旨在确保声音既清晰又舒适。然而,WDRC在调整信号时序包络的过程中,其变化程度受动态响应速度影响,可能引入“泵感”等动态伪影。此外,助听器还具备语音增强、反馈抑制、风噪降低及场景分析等多种功能。然而,这些功能主要针对语音进行优化,其频率依赖性增益和压缩器响应速度等设置可能并不适用于具有独特频谱和时序特征的音乐。

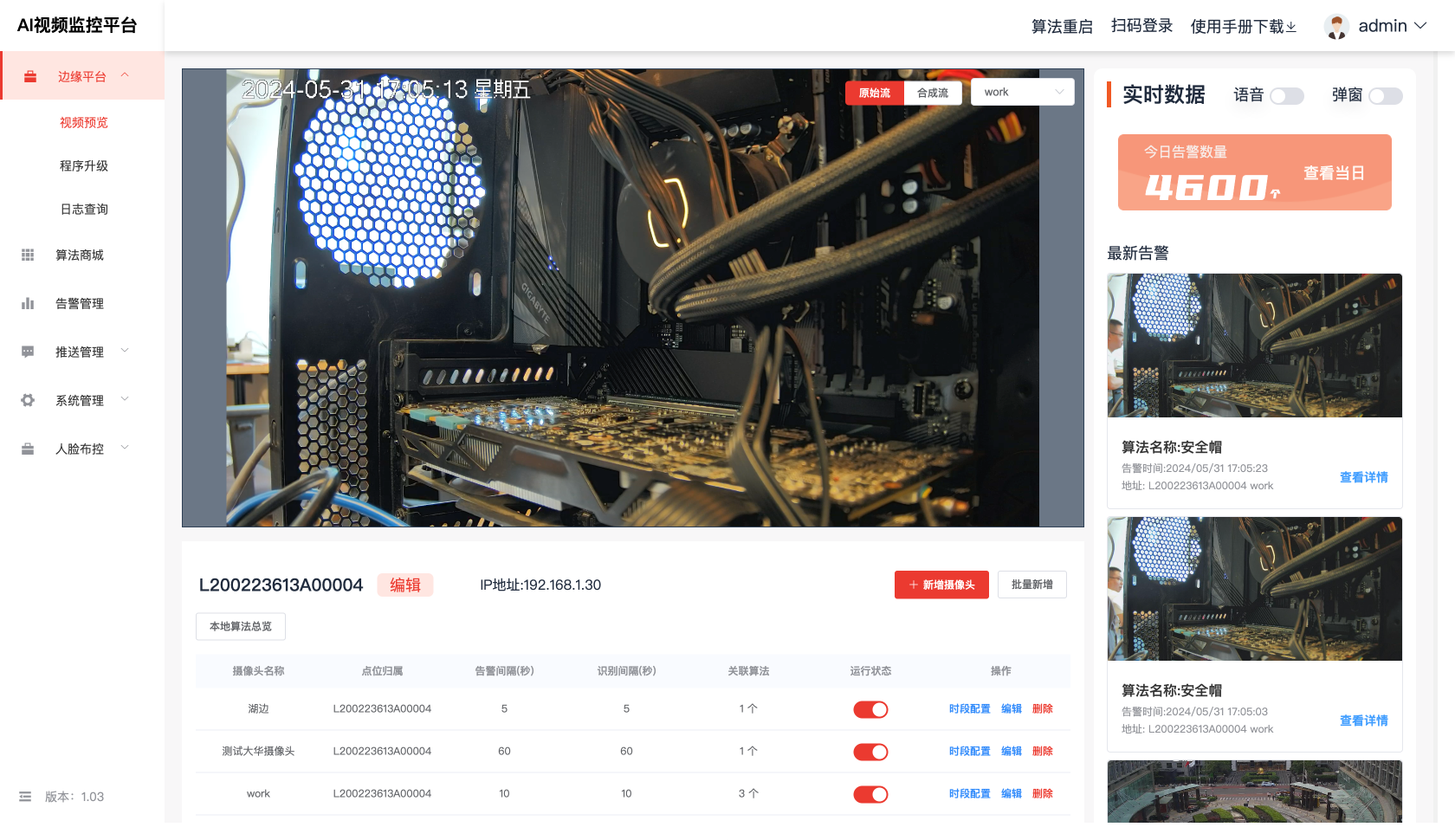

在本文中,我们描述了Cadenza项目:挑战方法首次应用于改善听力损失者音乐音质的问题。报告了两个挑战,主要区别在于第一个挑战(CAD1)是用于通过耳机收听,而第二个挑战(ICASSP24),是用于通过扬声器收听。任务目标是对立体声音乐信号进行分解,然后进行重混,因为这样的系统可以帮助解决已知的音乐收听和听力损失问题。

1 方法

两个场景均围绕听音乐构建:(a) 通过耳机听音乐,且不使用助听器;(b) 通过立体声扬声器使用助听器听音乐—见上图。对于CAD1,需要处理的信号是输送到耳机的左右信号。对于ICASSP24,左右信号来自助听器麦克风在每只耳朵处的信号。这意味着对于ICASSP24,需要处理的音乐是左右扬声器信号的混合。扬声器到助听器麦克风的声音传播是使用头相关传递函数(HRTFs)建模的。左右信号在耳朵处的组合取决于声波在肩膀、头部、耳朵和助听器周围的衍射、反射和干涉。在某些频率和方位角上,它们可能会相加,在其他情况下可能会相减。因此,与原始立体声轨道相比,耳朵处左右VDBO(声乐、鼓、低音和其他乐器)组件的强度是不同的,为ICASSP24系统与CAD1和先前的分解挑战相比带来了额外的复杂性。

1.1 数据

1.1.1 音乐数据

- MUSDB18-HQ 数据集: 包含流行/摇滚音乐的 VDBO 声部以及立体声混音,用于训练和验证分离算法。

- MoisesDB 数据集: 从中随机选取了 50 首歌曲作为独立的验证集,用于评估算法的泛化能力。

1.1.2 听者数据

- Clarity 项目数据: 包含 83 份听力图数据,用于训练和验证分离算法。根据我们更好的耳朵听力损失分类,没有无损害的人,17人轻度,44人中度,22人中重度,没有严重损害。

- von Gablenz 等人数据: 包含 50 份听力图数据,用于验证分离算法。根据分类,没有无损害的人,24人轻度,22人中度,4人中重度,0人严重。

- Cadenza 听音小组数据: 包含 53 份听力图数据,用于评估分离和重混后的音乐质量。根据分类,有3名听众无损害,13名轻度,17名中度,19名中重度,1名严重。

1.2 方法

1.2.1 分离算法

- Hybrid Demucs: 基于深度学习的声源分离算法,结合时间域和频谱域信息进行分离。

- Open-Unmix: 基于深度学习的声源分离算法,仅使用频谱域信息进行分离。

- 其他算法: 部分参赛者使用了其他声源分离算法,例如 Spleeter 和 HT-Demucs。

1.2.2 音乐增强

- NAL-R 算法: 基于听力图的频率依赖性放大算法,用于补偿听力阈值升高的影响。

- 其他算法: 部分参赛者使用了其他音乐增强算法,例如多带压缩器和线性滤波器。

1.2.3 重混算法

- 简单重混: 将分离后的 VDBO 声部直接混合成立体声信号。

- 调整音量: 调整 VDBO 声部的音量,以突出特定声部或满足用户的个性化需求。

- 均衡调整: 通过调整 VDBO 声部的均衡,改变音乐的频谱特性。

- Mid-Side 重混: 通过调整 Mid 和 Side 信号的均衡,改变音乐的立体声效果。

1.2.4 评估方法

- HAAQI (Hearing-Aid Audio Quality Index): 用于评估分离和重混后的音乐质量,考虑了听力损失和助听器的影响。

- 主观评估: 通过听音小组对音乐进行主观评估,例如音质、清晰度、自然度等。

1.2.5 数据分析

- CAD1 挑战: 由于基线算法的性能已经很高,参赛者难以取得突破性进展。

- ICASSP24 挑战: 通过增加扬声器重放场景和音量调整步骤,提高了挑战难度,并促使参赛者探索更复杂的算法和方法。

- 因果系统: 目前只有少数参赛者使用了因果系统,未来需要更多研究来探索低延迟的因果算法。

1.3 挑战赛基线架构

- 输入立体声信号:系统接收的原始立体声音乐信号,作为源分离过程的输入。

- 源分离(Source Separation):使用如Hybrid Demucs或Open-Unmix等算法将立体声音乐分解成不同的乐器和人声组件,如声乐、鼓、低音和其他乐器(VDBO)。

- 增益应用(Gain Application):在重混之前,根据听力受损者的听力图谱,对分离出的各个组件(VDBO)应用特定的增益,以补偿听力损失。

- 重混(Remixing):将经过增益调整的VDBO组件重新混合成新的立体声信号。

- 频率依赖性放大(Frequency-Dependent Amplification):使用NAL-R或其他方法对重混后的信号进行频率依赖性放大,以进一步优化听力受损者的听觉体验。

- 输出立体声信号:经过处理和优化的最终立体声音乐信号,可供听力受损者通过助听器或耳机聆听。

2 结论

2.1 CAD1 挑战赛

参赛系统数量: 7 个参赛系统,2 个基线系统,1 个不做任何处理的系统。

2.1.1 主要方法

- 大多数系统使用 HDemucs 或 OpenUnmix 进行源分离。

- 一些系统尝试了不同的重混音策略,例如改变 VDBO 信号的平衡或应用中-侧均衡。

- 一些系统尝试了不同的放大策略,例如多带压缩或线性滤波器。

2.1.2 结果

- 没有系统在 HAAQI 指标上超过最佳基线系统。

- HAAQI 分数与听力损失程度呈负相关,即听力损失越严重,分数越低。

- HDemucs 基线系统在重混音任务上表现最佳。

2.2 ICASSP24 挑战赛

参赛系统数量: 17 个参赛系统,来自 11 个团队。

2.2.1 主要方法

- 大多数系统使用 HDemucs 或 OpenUnmix 进行源分离,并进行了一些改进。

- 一些系统采用了集成学习方法,结合多个分离算法的输出。

- 一些系统尝试了不同的重混音策略,例如添加原始立体声信号的一部分或应用中-侧均衡。

- 只有一个系统尝试改进放大阶段,但由于与 HAAQI 评估中使用的 NAL-R 放大方法不一致,导致分数下降。

2.2.2 结果

- 9 个系统在 HAAQI 指标上超过了最佳基线系统。

- HAAQI 分数与听力损失程度呈负相关,即听力损失越严重,分数越低。

- 使用集成学习方法的系统表现最佳。

- 重混音前后 VDBO 信号增益差异越大,HAAQI 分数越低。

2.3 结论

D1 挑战赛表明,使用现有的源分离算法很难在 HAAQI 指标上取得突破。 ICASSP24 挑战赛通过引入扬声器重放和增益设置,使得任务更具挑战性,并鼓励了更多的创新。

两次挑战赛都表明,听力损失程度对音乐处理算法的性能有显著影响。

2.4 未来研究方向

鼓励开发低延迟、因果的信号处理算法,使其适用于助听器和现场音乐。

开发更适用于机器学习的音频质量指标,例如基于聆听测试的非侵入式指标。

扩展音乐数据集,包括更多类型的音乐,例如古典音乐。

将挑战赛任务扩展到其他领域,例如歌词清晰度。

期待下一次比赛CAD2!