发表于:WWW23

推荐指数: #paper/⭐⭐

问题背景:

背景

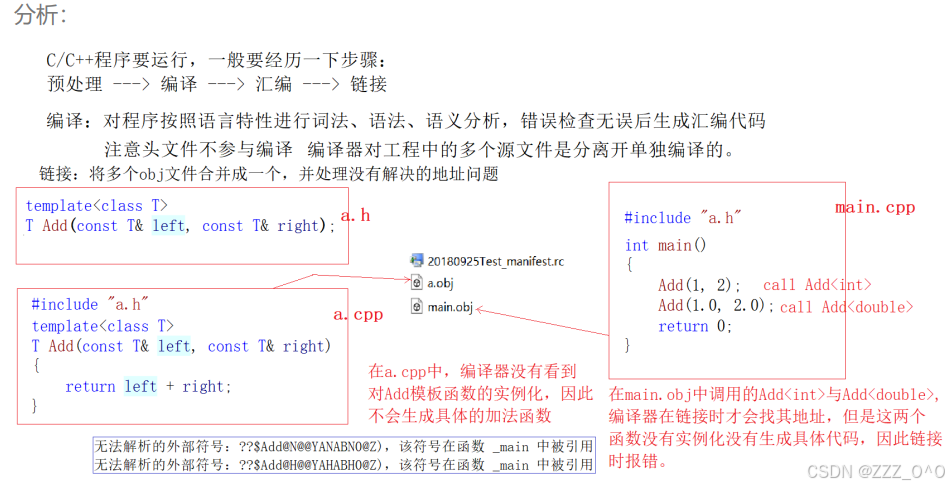

现实世界的数据很多样,阻止GNN学习公平的表示。当去偏见化后,他们面临着可学知识不足且属性有限的重大问题

解决方法:

应对公平训练导致可学习知识有限的挑战,G-Fame由多个专家神经网络组成,每个神经网络都包含自己的参数,以学习不同的知识,以实现节点表示的多样化。

此外,为了提高模型对可学习知识缺乏的抵抗力,我们提出了G-Fame++,其中我们从不同的角度设计了三种不同的策略:(1)从节点表示的角度,引入嵌入多样性正规化,使节点能够在消息传递过程中从邻居那里捕获更多不同的信息;(2)从层的角度出发,设计层多样性规则化,使不同层的输出多样化,使浅层和深层都能获得不同的表示;(3)从参数权重冗余的角度出发,提出专家权重正规化,使专家的权重参数多样化,使每个专家都能捕捉到不同的信息

框架图:

余知识

公平图增强

Fairness-Based 图增强

m i j = { 1 s i ≠ s j ∀ i , j ∈ N 0 o t h e r w i s e \left.m_{ij}=\left\{\begin{array}{cc}1&s_i\neq s_j&\forall i,j\in\mathcal{N}\\0&\mathrm{otherwise}\end{array}\right.\right. mij={10si=sjotherwise∀i,j∈N

其中, m i j = 1 m_{ij}=1 mij=1表示两个节点,他们拥有不同敏感属性是连接的。M代表mask矩阵去mask邻接矩阵。我们重新构建mask矩阵:(加了阈值)

r r ( m i j ) = { m i j with probability: p ( m i j ) = 1 2 + δ 1 − m i j with probability: p ( 1 − m i j ) = 1 2 − δ \left.rr(m_{ij})=\left\{\begin{array}{ll}m_{ij}&\text{with probability: }p(m_{ij})=\frac12+\delta\\1-m_{ij}&\text{with probability: }p(1-m_{ij})=\frac12-\delta\end{array}\right.\right. rr(mij)={mij1−mijwith probability: p(mij)=21+δwith probability: p(1−mij)=21−δ

最后,公平矩阵可以表示为:

A f a i r = A ∘ r r ( M ) A_{f\boldsymbol{air}}=A\circ rr(M) Afair=A∘rr(M)

(相当于图结构学习)

公平训练

min θ L ( D ; θ ) + λ ∥ θ ∥ 2 2 , s . t . Ω ( D ; θ ) < 0 , \min_\theta\quad\mathcal{L}(\mathcal{D};\theta)+\lambda\|\theta\|_2^2,\quad\mathrm{s.t.~}\Omega(\mathcal{D};\theta)<0, θminL(D;θ)+λ∥θ∥22,s.t. Ω(D;θ)<0,

混合专家

y = ∑ i ∈ R q i ( x ) E i ( x ) , y=\sum_{i\in\mathcal{R}}q_i(x)E_i(x), y=i∈R∑qi(x)Ei(x),

其中,q是门控,E是专家

每层的门控由下个函数计算:

q i ( x ) = exp ( H ( x ) i ) ∑ j = 0 N exp ( H ( x ) j ) , q_i(x)=\frac{\exp(H(x)_i)}{\sum_{j=0}^N\exp(H(x)_j)}, qi(x)=∑j=0Nexp(H(x)j)exp(H(x)i),

模型架构

G-FAME:图公平混合专家

传播函数:

h v ( l ) = COMBINE ( G-FAME ( l ) ( h v ( l − 1 ) ) , m v ( l ) ) ) , m v ( l ) = AGGREGATE ( { G-FAME ( l ) ( h u ( l − 1 ) ) , ∀ u ∈ N ( v ) } ) \begin{aligned}&h_{v}^{(l)}=\text{COMBINE}\left(\text{G-FAME}^{(l)}(h_{v}^{(l-1)}),m_{v}^{(l)})\right),\\&m_{v}^{(l)}=\text{AGGREGATE}\left(\left\{\text{G-FAME}^{(l)}(h_{u}^{(l-1)}),\forall u\in N(v)\right\}\right)\end{aligned} hv(l)=COMBINE(G-FAME(l)(hv(l−1)),mv(l))),mv(l)=AGGREGATE({G-FAME(l)(hu(l−1)),∀u∈N(v)})

实际就是GNN的传播函数

G − F A M E ( l ) ( h v ( l − 1 ) ) = ∑ i ∈ H ( l ) q i ( l ) ( h v ( l − 1 ) ) W i ( l ) ( h v ( l − 1 ) ) , \mathrm{G-FAME}^{(l)}(h_v^{(l-1)})=\sum_{i\in\mathcal{H}^{(l)}}q_i^{(l)}(h_v^{(l-1)})W_i^{(l)}(h_v^{(l-1)}), G−FAME(l)(hv(l−1))=i∈H(l)∑qi(l)(hv(l−1))Wi(l)(hv(l−1)),

G-FAME++ 加了多个正则化操作

样本多样性

嵌入正则化:让邻居样本相近,非邻居样本相远

L E D = − log ∑ v j ∈ V exp ( sin ( z i , z j ) / τ ) ∑ v k ∈ V exp ( sin ( z i , z k ) / τ ) , \mathcal{L}_{ED}=-\log\frac{\sum_{\boldsymbol{v}_j\in V}\exp(\sin(z_i,z_j)/\tau)}{\sum_{\boldsymbol{v}_k\in V}\exp(\sin(z_i,z_k)/\tau)}, LED=−log∑vk∈Vexp(sin(zi,zk)/τ)∑vj∈Vexp(sin(zi,zj)/τ),

层正则多样性

r cosine ( z l a , z l b ) = 1 ∣ V ∣ ∑ v i ∈ V ∣ z i l a ⊤ z i l b ∣ ∥ z i l a ∥ 2 ∥ z i l b ∥ 2 , r_{\text{cosine}}\left(z^{l_{a}}, z^{l_{b}}\right)=\frac{1}{|V|}\sum_{v_{i}\in V}\frac{\left|z_{i}^{l_{a}\top} z_{i}^{l_{b}}\right|}{\left\|z_{i}^{l_{a}}\right\|_{2}\left\|z_{i}^{l_{b}}\right\|_{2}}, rcosine(zla,zlb)=∣V∣1vi∈V∑ zila 2 zilb 2 zila⊤zilb ,

用对比损失去让相近层数靠近,相远层数相远

r contrast ( z l a , z l b ) = − 1 ∣ V ∣ ∑ v i ∈ V log exp ( z i l a ⊤ z i l b ) exp ( z i l a ⊤ z i l b ) + exp ( z i l a ⊤ ( ∑ j ≠ i z j l b n − 1 ) ) r_{\text{contrast}}\left(z^{l_{a}}, z^{l_{b}}\right) = -\frac{1}{|V|} \sum_{v_{i}\in V} \log \frac{\exp\left(z_{i}^{l_{a}\top} z_{i}^{l_{b}}\right)}{\exp\left(z_{i}^{l_{a}\top} z_{i}^{l_{b}}\right) + \exp\left(z_{i}^{l_{a}\top} \left(\frac{\sum_{j\neq i} z_{j}^{l_{b}}}{n-1}\right)\right)} rcontrast(zla,zlb)=−∣V∣1vi∈V∑logexp(zila⊤zilb)+exp(zila⊤(n−1∑j=izjlb))exp(zila⊤zilb)

L L D = ∑ l a , l b ∈ L ∣ a ≠ b r c o s i n e ( z l a , z l b ) + r c o n t r a s t ( z l a , z l b ) , \mathcal{L}_{LD}=\sum_{l_a,l_b\in L|_{a\neq b}}r_{cosine}(z^{l_a},z^{l_b})+r_{contrast}(z^{l_a},z^{l_b}), LLD=la,lb∈L∣a=b∑rcosine(zla,zlb)+rcontrast(zla,zlb),

专家多样性

max { W 1 ^ , . . . , W m ^ } ∈ S t − 1 { L M H S ( W ^ ) : = min i ≠ j ρ ( W i ^ , W j ^ ) } \max_{\{\hat{W_1},...,\hat{W_m}\}\in\mathbb{S}^{t-1}}\{\mathcal{L}_{\mathrm{MHS}}(\hat{W}):=\min_{i\neq j}\rho(\hat{W_i},\hat{W_j})\} {W1^,...,Wm^}∈St−1max{LMHS(W^):=i=jminρ(Wi^,Wj^)}

其中, ω ^ i = v e c ( W i ) ∣ ∣ v e c ( W i ) ∣ ∣ 2 \hat{\omega}_{i}=\frac{\mathrm{vec}(W_{i})}{||\mathrm{vec}(W_{i})||_{2}} ω^i=∣∣vec(Wi)∣∣2vec(Wi), S t − 1 : = { ω ^ ∈ R ∣ ∣ ∣ ω ^ ∣ ∣ 2 = 1 } \mathbb{S}^{t-1}:=\{\hat{\omega}\in\mathbb{R}| ||\hat{\omega}||_{2}=1\} St−1:={ω^∈R∣∣∣ω^∣∣2=1}, ρ ( ⋅ , ⋅ ) \rho(\cdot,\cdot) ρ(⋅,⋅)表示两个W的最短距离。

最终损失:

L G − F A M E + + = L G T + L E D + L L D + L M H S . \mathcal{L}_{\mathrm{G-FAME++}}=\mathcal{L}_{GT}+\mathcal{L}_{ED}+\mathcal{L}_{LD}+\mathcal{L}_{MHS}. LG−FAME++=LGT+LED+LLD+LMHS.

其实,如上可以总结:需要让专家之间的差距变大,否则没有意义。