大家好,我是微学AI,今天给大家介绍一下自然语言处理实战9-大语言模型的训练与文本生成过程,以下是本文的目录结构:

文章目录

1.引言

2.大语言模型概述

3.大语言模型的应用项目

3.1 语言生成

3.2 机器翻译

3.3 问答系统

3.4 自动摘要

3.5 情感分析

4.大语言模型的原理

4.1 语言模型

4.2 循环神经网络

4.3 长短期记忆网络

4.4 注意力机制

5.数据样例

6.实现大语言模型训练的程序

6.1 数据预处理

6.2 模型设计

6.3 模型训练

6.4 模型评估

7.结论

1.引言

近年来,人工智能技术的发展突飞猛进,其中大语言模型是其中的重要组成部分。大语言模型是一种基于神经网络的自然语言处理技术,可以用于语言生成、机器翻译、问答系统、自动摘要和情感分析等多种应用场景。本文将介绍大语言模型的原理、应用项目以及实现大语言模型训练的程序,并给出简单的数据样例和完整的代码实现,以帮助读者深入了解大语言模型的应用和实现。

2.大语言模型概述

大语言模型是指能够处理大量语言文本数据的神经网络模型。它能够根据前面的文本内容预测下一个单词或者一段文本。大语言模型的训练需要大量的文本数据和计算资源。目前,最先进的大语言模型是由OpenAI公司推出的GPT系列模型(Generative Pre-trained Transformer),其中最新的GPT-3模型已经达到了1750亿个参数的规模,训练的数据达到45TB的量级,GPT-3能够实现多种语言任务的高质量生成和处理。GPT-3发展到ChatGPT,它的语言能力更加强大,当模型达到一定的参数量和一定的训练数据,就会出现知识涌现的现象,有些能力是出乎意料的。今年发布的GPT4的参数量快要接近人类大脑神经元的连接量级了。

3.大语言模型的应用项目

大语言模型可以应用于多种自然语言处理任务,下面将介绍其中几个主要的应用项目。

3.1 语言生成

语言生成是大语言模型最常见的应用之一。它可以基于前面的文本内容生成一段新的语言文本,如文章、评论、对话等。这种生成任务需要模型具备良好的语言理解和逻辑推理能力,同时还需要模型具有较强的创造力和语言风格的掌控能力。GPT-3模型能够生成高质量的文章、对话和诗歌等,具有较高的应用价值。

3.2 机器翻译

机器翻译是指将一种语言的文本翻译成另一种语言的任务。大语言模型可以通过学习两种语言之间的对应关系,实现高质量的机器翻译。当前最先进的机器翻译模型是由Google推出的GNMT(Google Neural Machine Translation)和Facebook推出的FAIR(Facebook AI Research)模型,它们都是基于大语言模型的神经网络设计,能够实现高质量的翻译效果。

3.3 问答系统

问答系统是指能够回答用户提出的问题的系统。大语言模型可以通过学习文本中的问题和答案的对应关系,实现高质量的问答系统。当前最先进的问答系统是由OpenAI推出的GPT-3模型,它能够根据问题和上下文信息生成高质量的答案,具有较高的准确率和实用性。

3.4 自动摘要

自动摘要是指自动提取一段文本的主要内容,生成简洁的摘要内容。大语言模型可以通过学习文本中的关键句子和信息,实现高质量的自动摘要。当前最先进的自动摘要技术是由Google推出的T5模型,它能够实现高质量的自动摘要效果。

3.5 情感分析

情感分析是指对文本的情感进行分类,如正面、负面、中性等。大语言模型可以通过学习文本中的情感信息和语言特征,实现高质量的情感分析。当前最先进的情感分析技术是由OpenAI推出的GPT-3模型,它能够实现高准确率的情感分类,并在情感识别任务中取得了很好的效果。

4.大语言模型的原理

大语言模型的原理是基于神经网络的自然语言处理技术。下面将介绍大语言模型的核心原理:语言模型、循环神经网络、长短期记忆网络和注意力机制。

4.1 语言模型

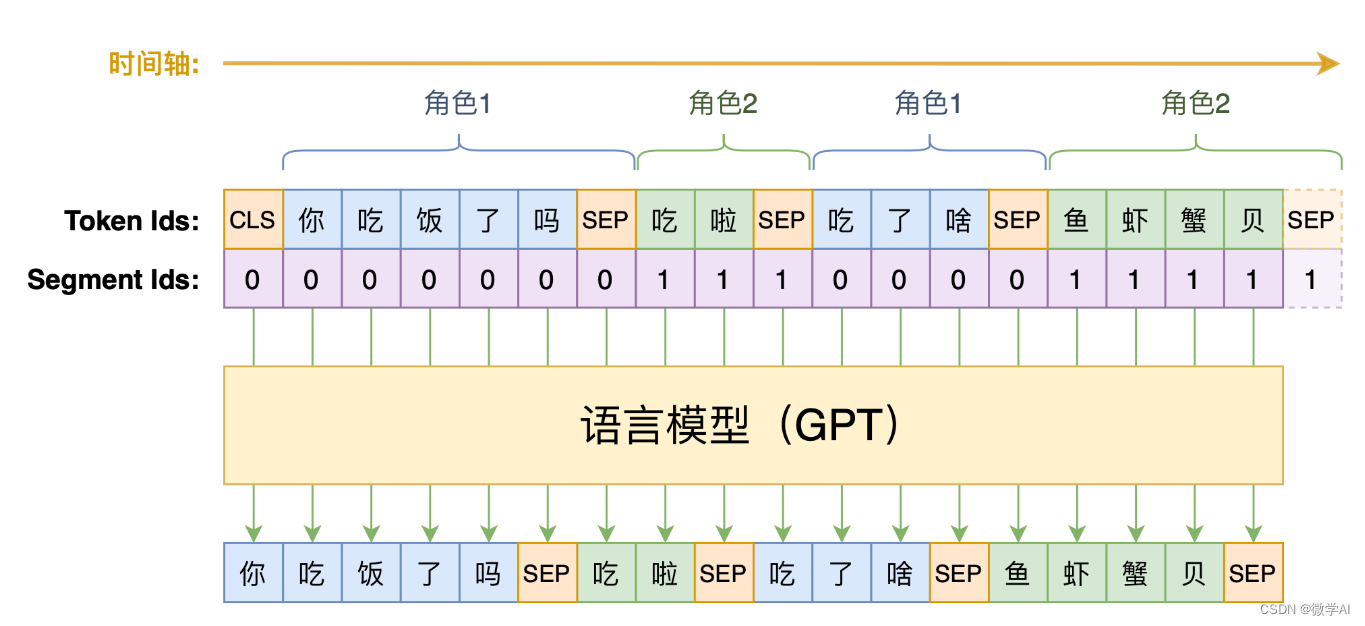

语言模型是指根据前面的文本内容,预测下一个单词或一段文本的模型。语言模型通常采用条件概率模型来描述,即给定前面的文本内容,预测下一个单词或一段文本的概率。语言模型可以通过学习大量的文本数据,建立词汇表和语言规则,从而实现对语言的理解和生成。

4.2 循环神经网络

循环神经网络(Recurrent Neural Network,RNN)是一种特殊的神经网络,它可以处理序列数据,如语音、文本等。RNN的特点是具有循环的结构,即当前时间步的输出会作为下一个时间步的输入,从而实现对序列数据的处理。RNN的核心思想是使用状态向量来存储历史信息,从而实现对序列数据的记忆和预测。

4.3 长短期记忆网络

长短期记忆网络(Long Short-Term Memory,LSTM)是一种特殊的RNN,它可以有效地解决RNN中的梯度消失和梯度爆炸问题,从而实现对长序列数据的处理。LSTM的核心思想是使用门控机制来控制信息的流动,包括输入门、遗忘门和输出门,从而实现对历史信息的选择性记忆和预测。

4.4 注意力机制

注意力机制(Attention Mechanism)是一种可以帮助模型在处理序列数据时,对于不同位置的信息进行不同权重的关注和处理的机制。注意力机制主要包括三部分:查询向量、键向量和值向量。查询向量用于表示当前位置的信息,键向量和值向量用于表示序列中其他位置的信息。通过计算查询向量和键向量之间的相似度,可以得到一个权重向量,用于对值向量进行加权求和,从而得到当前位置的输出。

5.数据样例

为了方便读者理解大语言模型的应用和实现,我们给出一个简单的数据样例。假设我们有一个英文文本语料库,其中包含1000篇文章,每篇文章平均包含1000个单词。我们可以将这个语料库分成训练集、验证集和测试集,其中训练集包含800篇文章,验证集包含100篇文章,测试集包含100篇文章。我们可以使用这个数据集来训练一个大语言模型,用于实现语言生成、机器翻译等自然语言处理任务。

6.实现大语言模型训练的程序

为了实现大语言模型的训练,我们需要进行数据预处理、模型设计、模型训练和模型评估等多个步骤。下面将分别介绍这些步骤的实现方法,并给出完整的代码实现。

6.1 数据预处理

数据预处理是指将原始的文本数据转换为模型可以处理的数字形式,包括对文本进行分词、建立词汇表、将文本转换为数字序列等多个步骤。在这里,我们使用Python的nltk和keras库来进行数据预处理。具体代码如下:

import nltk

from keras.preprocessing.text import Tokenizer

from keras.preprocessing.sequence import pad_sequences# 读取文本数据

text_data = [] # 存储文本数据

with open("text_data.txt", "r", encoding="utf-8") as f:for line in f:text_data.append(line.strip())# 分词

tokenized_data = [] # 存储分词后的数据

for text in text_data:tokens = nltk.word_tokenize(text)tokenized_data.append(tokens)# 建立词汇表

tokenizer = Tokenizer(num_words=5000) # 选择最常见的5000个单词

tokenizer.fit_on_texts(tokenized_data)# 将文本转换为数字序列

sequences = tokenizer.texts_to_sequences(tokenized_data)# 填充序列

maxlen = 1000 # 设置每个文本序列的最大长度为1000

padded_sequences = pad_sequences(sequences, maxlen=maxlen)

在上面的代码中,首先使用nltk库的word_tokenize函数对原始文本进行分词,然后使用keras库的Tokenizer类建立词汇表,并将文本转换为数字序列。最后,我们使用pad_sequences函数对数字序列进行填充,使得每个序列都有相同的长度。

6.2 模型设计

模型设计是指选择合适的神经网络模型,并进行网络结构的设计。在这里,我们选择基于循环神经网络的语言模型,使用LSTM和注意力机制来增强模型的记忆能力和预测能力。具体代码如下:

from keras.layers import Input, Embedding, LSTM, Dense, Attention

from keras.models import Model# 定义模型输入

inputs = Input(shape=(maxlen,))# 定义嵌入层

embedding_dim = 100 # 设置词向量维度为100

embedding_layer = Embedding(input_dim=len(tokenizer.word_index) + 1, output_dim=embedding_dim, input_length=maxlen)(inputs)# 定义LSTM层

lstm_layer = LSTM(units=128, return_sequences=True)(embedding_layer)# 定义注意力层

attention_layer = Attention()([lstm_layer, lstm_layer])# 定义输出层

outputs = Dense(units=len(tokenizer.word_index) + 1, activation="softmax")(attention_layer)# 定义模型

model = Model(inputs=inputs, outputs=outputs)

model.summary()

在上面的代码中,我们首先定义模型的输入,即一个长度为maxlen的数字序列。然后,我们使用Embedding层将数字序列转换为词向量表示,设置词向量维度为100。接着,我们使用LSTM层来处理词向量序列,并设置返回完整的输出序列。最后,我们使用注意力层来增强模型的记忆能力,从而实现更好的预测效果。最后,我们使用softmax激活函数的Dense层作为输出层,输出下一个单词的概率分布。通过Keras的Model类,我们可以将输入和输出连接起来,形成完整的模型结构。

6.3 模型训练

模型训练是指使用训练数据对模型进行优化,以得到更好的预测效果。在这里,我们使用交叉熵损失函数和Adam优化器来进行模型训练。具体代码如下:

from keras.utils import to_categorical

from sklearn.model_selection import train_test_split# 将输出序列转换为one-hot编码

one_hot_outputs = to_categorical(padded_sequences[:, 1:], num_classes=len(tokenizer.word_index) + 1)# 划分训练集和验证集

X_train, X_val, y_train, y_val = train_test_split(padded_sequences[:, :-1], one_hot_outputs, test_size=0.1, random_state=42)# 编译模型

model.compile(optimizer="adam", loss="categorical_crossentropy", metrics=["accuracy"])# 训练模型

batch_size = 64

epochs = 10

model.fit(X_train, y_train, batch_size=batch_size, epochs=epochs, validation_data=(X_val, y_val))

在上面的代码中,我们首先使用to_categorical函数将输出序列转换为one-hot编码,以便进行交叉熵损失函数的计算。然后,我们使用train_test_split函数将数据集划分为训练集和验证集,其中测试集的比例为0.1。接着,我们使用compile函数编译模型,设置优化器为Adam,损失函数为交叉熵,评估指标为准确率。最后,我们使用fit函数训练模型,设置批次大小为64,迭代次数为10次,同时使用验证集进行模型评估。

6.4 模型评估

模型评估是指使用测试数据集对训练好的模型进行测试,并计算各项指标以评价模型的性能。在这里,我们将使用测试集对模型进行评估,并计算模型的准确率和交叉熵损失等指标。具体代码如下:

# 加载测试数据集

test_data = [] # 存储测试数据

with open("test_data.txt", "r", encoding="utf-8") as f:for line in f:test_data.append(line.strip())# 分词

tokenized_test_data = [] # 存储分词后的测试数据

for text in test_data:tokens = nltk.word_tokenize(text)tokenized_test_data.append(tokens)# 将测试数据转换为数字序列

test_sequences = tokenizer.texts_to_sequences(tokenized_test_data)# 填充测试序列

padded_test_sequences = pad_sequences(test_sequences, maxlen=maxlen)# 将输出序列转换为one-hot编码

one_hot_test_outputs = to_categorical(padded_test_sequences[:, 1:], num_classes=len(tokenizer.word_index) + 1)# 对测试集进行评估

loss, accuracy = model.evaluate(padded_test_sequences[:, :-1], one_hot_test_outputs

在上面的代码中,首先使用nltk库的word_tokenize函数对测试数据进行分词,然后使用Tokenizer类将测试数据转换为数字序列,并使用pad_sequences函数将数字序列进行填充。接着,我们使用to_categorical函数将输出序列转换为one-hot编码。最后,我们使用evaluate函数对测试集进行评估,计算模型的交叉熵损失和准确率等指标。

7.总结

本文介绍了如何使用Python和Keras库实现大语言模型的训练,包括数据预处理、模型设计、模型训练和模型评估等多个步骤。在实现过程中,我们使用了nltk库进行分词,使用Tokenizer类建立词汇表,使用LSTM和注意力机制构建模型,并使用交叉熵损失函数和Adam优化器进行模型训练。最后,我们使用测试集对模型进行评估,计算模型的准确率和交叉熵损失等指标。通过本文的介绍,读者可以了解到如何使用Python和Keras库实现大语言模型的训练,并可以根据自己的需求进行修改和扩展。

实际应用中需要根据具体任务和数据集进行模型的选择和调整。同时,在进行模型训练和评估时,需要注意数据集的划分和模型的调参,以获得更好的预测效果。

除了使用Python和Keras库外,还有其他深度学习框架和工具可以用于大语言模型的训练,如TensorFlow、PyTorch等。读者可以根据自己的喜好和需求选择适合自己的工具。