无声语音的数字发声

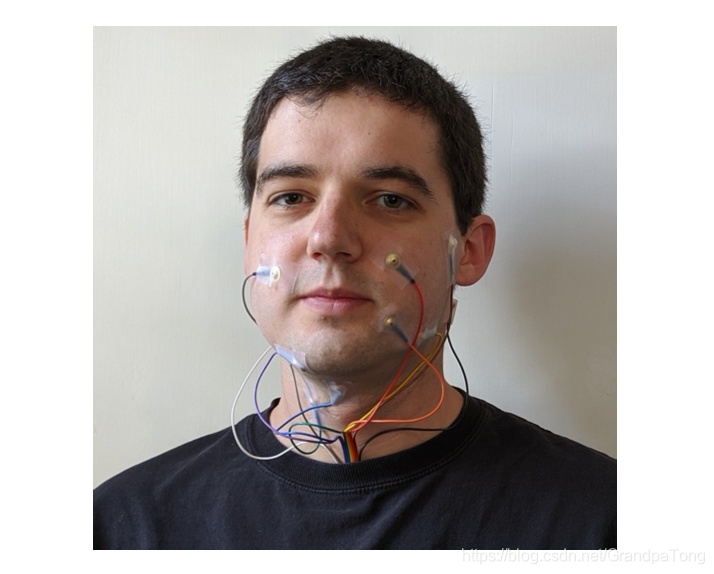

Electromyography传感器被放置在嘴部附近用来捕捉信号

摘要

此论文主要帮助“哑巴”通过EMG(electromyography)捕捉肌肉信号从而“说话”。这个论文的创新点在于,它是第一个使用EMG数据来训练语音,模型的错误率有历史性的降低。

背景

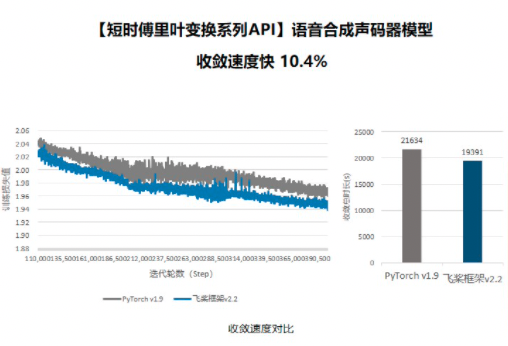

图一

我们采集的数据如图一所示,不仅要采集不发出声音时候的信号,还要才出相应发出声音的信号数据。我们可以看到它一共有8个部位的传感器。

之前有过使用EMG恢复有声数据的工作 (Toth et al., 2009; Janke and Diener, 2017; Diener et al., 2018).。但是对于恢复无声的工作的错误率很高-Toth et al. (2009)。

方法

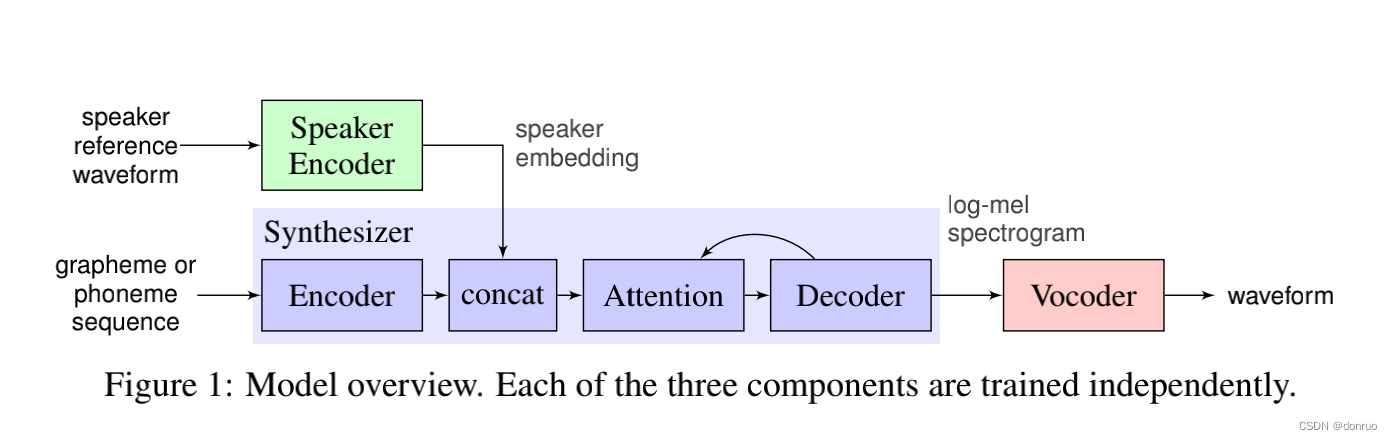

我们的方法基于从EMG特征到时间对齐语音特征的递归神经传导模型()。当仅对发声的EMG数据(EV’->A’V)进行训练时,训练此模型非常简单。但是,我们的实验表明,由于对两种语音模式的差异,仅对发声的肌电信号进行训练会导致在对无声的肌电信号进行测试时表现不佳(3.4)。

这片论文的的核心贡献在于在无声EMG信号上训练换能器模型的方法,该信号不再具有按时间排列的音频作为训练目标。

使用以无声和发声的两种语音模式录制的一组话语,找到了这两种录音之间的对齐方式,并使用它们将有声实例(AV)的语音特征与无声EMG ES 关联起来。首先使用EMG信号之间的动态时间扭曲找到对齐方式,然后使用规范相关分析(CCA)和来自部分受训模型的预测音频进行精化。最后,要根据预测的语音功能生成音频,请使用WaveNet解码器

下面将一步一步的将这几个关键步骤进行解释

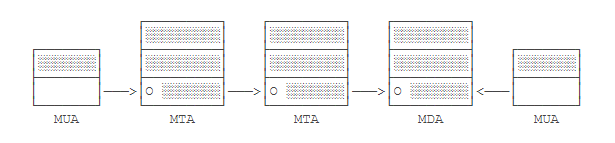

1EMG to Speech Feature Transducer

这里的监督学习使用的就是lstm,没什么好说的

2 Audio Target Transfer

关键是如何将无声和有声的数据进行对齐

这里使用的是动态时间规整算法 dynamic time warping (DTW) (Rabiner and Juang, 1993),

DTW可以计算两个时间序列的相似度,尤其适用于不同长度、不同节奏的时间序列(比如不同的人读同一个词的音频序列)。DTW将自动warping扭曲 时间序列(即在时间轴上进行局部的缩放),使得两个序列的形态尽可能的一致,得到最大可能的相似度。

但是由于无声和有声数据差别还是有些大的,所以我们还需要使用典型相关分析canonical cor- relation analysis (CCA) (Hotelling, 1936) 来帮助我们提高对齐效果。

经过对齐之后,携带有有声信息的无声数据被加入1中进行训练

WaveNet Synthesis

这就是一个解码器,将1训练出来的结果转化成音频。

结论

比之前的模型都好!