No.66

智源社区

预训练组

预

训

练

研究

观点

资源

活动

周刊订阅

告诉大家一个好消息,《预训练周刊》已经开启“订阅功能”,以后我们会向您自动推送最新版的《预训练周刊》。订阅方法:

方式1:扫描下面二维码,进入《预训练周刊》主页,选择“关注TA”。

方式2:点击本文下方的“阅读原文”,进入《预训练周刊》Hub社区版,根据内附的详细订阅步骤,完成订阅。

关于周刊

本期周刊,我们选择了8篇预训练相关的论文:多模态话题包括检索增强技术;视觉话题包括多任务提示微调,提示改进;自然语言话题包括字节级别表征,并行大模型训练;生命科学话题包括分子力场监督预训练,正则位置编码,自注意力处理薛定谔方程。此外,在资讯动态方面,我们选择了5篇预训练资讯:观点方面包括物理学和自监督的交融;工具方面包括OpenAI新ChatGPT,代码学习方面包括上期周刊的Altdiffusion的代码使用;行业资讯包括百度行业大模型和智源大模型创新论坛的一些最新内容。

周刊采用社区协作的模式产生,欢迎感兴趣的朋友们参与我们的工作,一起来推动预训练学习社群的分享、学习和交流活动。可以扫描文末的二维码加入预训练群。

(本期贡献者:翟珂 吴新刚)

论文推荐

【多模态研究】

标题:斯坦福大学、Meta、华盛顿大学 | Retrieval-Augmented Multimodal Language Modeling(检索增强的多模态语言建模)了解详情

作者:Michihiro Yasunaga、Armen Aghajanyan、 Weijia Shi 等

简介:本文研究检索增强多模态模型(检索和引用外部存储器以生成图像和文本的新方法)。最近的多模态模型(如DALL-E和CM3)在文本到图像和图像到文本生成方面取得了显著进展。然而,这些模型将所有学习到的知识(例如埃菲尔铁塔的外观)存储在模型参数中,需要越来越大的模型和训练数据来获取更多的知识。为了以更可扩展和模块化的方式集成知识,作者提出了一种检索增强的多模态模型,该模型使基础多模态模型(生成器)能够引用检索器从外部存储器中获取的相关知识。具体来说:作者使用预训练的CLIP模型实现检索器,使用CM3 Transformer架构实现生成器,并使用LAION数据集训练该模型。作者得到的模型名为检索增强CM3(RA-CM3),是第一个可以检索和生成文本和图像混合的多模态模型。实验表明:RA-CM3在图像和字幕生成任务上显著优于基线多模态模型。

论文下载:https://arxiv.org/pdf/2211.12561.pdf

【NLP研究】

标题:复旦大学、Amazon | Word-Level Representation From Bytes For Language Modeling(基于字节的词级表示,用于语言建模)了解详情

作者:Chu-Tak Lee,Qipeng Guo,Xipeng Qiu

简介:本文研究新的字符感知方法。先前关于图像分类的工作证明,将原始输入拆分为一系列的chuck包:是一种强大的、与模型无关的归纳偏差。基于这一观察,作者重新思考现有的字符感知方法,该方法采用字符级输入、但可以进行词级序列建模和预测。作者通过引入直接从字节构建单词级表示的交叉注意力网络来彻底改造这种方法,以及基于词级隐藏状态的子词级预测,以避免词级预测的时间和空间要求。结合这两项改进,作者提出了一个无标记模型,它具有用于下游任务的精简输入嵌入;作者将该方法命名为:Byte2Word,并对语言建模和文本分类进行评估。实验表明Byte2Word与BERT强子词基线:不相上下、但只占嵌入大小的 10%。作者进一步测试了作者关于合成噪声和跨语言迁移的方法,发现都比基线方法都更具竞争力!

论文下载:https://arxiv.org/pdf/2211.12677.pdf

标题:苏黎世联邦理工学院、北邮 | PipeFisher: Efficient Training of Large Language Models Using Pipelining and Fisher Information Matrices(使用Pipelining和Fisher信息矩阵高效训练大型语言模型)了解详情

作者:Kazuki Osawa, Shigang Li, Torsten Hoefler

简介:本文研究Pipeline并行训练中的气泡(即空闲时间)问题、以显著提升GPU利用率。Pipeline并行机制实现了大规模分布式加速器集群上大型语言模型(LLM)的高效训练。然而,启动和终止Pipeline过程中的气泡降低了加速器的利用率。为利用率的最大化,尽管已经提出了具有微批处理和双向管道的高效Pipeline方案,但使用无论是正向同步还是反向通过:都无法填充这些大量气泡。为解决该问题,作者建议为气泡分配额外的工作,以在LLM训练中获得辅助效益。作者提出了PipeFisher:它将K-FAC(一种基于Fisher信息矩阵的二阶优化方法)的工作分配给气泡以加速收敛。在BERT-Base和BERT-Large模型的首个阶段预训练中,PipeFisher通过大幅提高加速器利用率并受益于K-FAC改进的收敛性,将训练时间减少到50-75%!

论文下载:https://arxiv.org/pdf/2211.14133.pdf

【CV研究】

标题:加州大学伯克利分校、TikTok | Multitask Vision-Language Prompt Tuning(多任务视觉语言提示调优)了解详情

作者:Sheng Shen, Shijia Yang, Tianjun Zhang,等

简介:本文研究在视觉语言领域多任务学习中的Prompt技术。提示调优(Prompt Tuning)现有的方法通常考虑从头开始独立地学习每个任务的提示向量,从而无法在不同的视觉语言任务中利用丰富的可共享知识。在本文中,作者提出了多任务视觉语言提示调优(MVLPT),它将跨任务知识纳入视觉语言模型的提示调优中。具体而言,(i)作者证明了从多个源任务学习单个可转移提示以初始化每个目标任务的提示的有效性;(ii)作者表明许多目标任务可以从共享提示向量中相互受益,因此可以通过多任务提示调优来共同学习。作者使用三种代表性的提示调优方法对所提出的MVLPT进行基准测试,即:文本提示调优、视觉提示调优、统一视觉语言提示调优。在20个视觉任务中的实验结果表明:本文所提出的方法优于所有单任务基线提示调优方法,在小样本ELEVATER基准和跨任务泛化基准上斩获了新的SOTA水平。

论文下载:https://arxiv.org/pdf/2211.11720.pdf

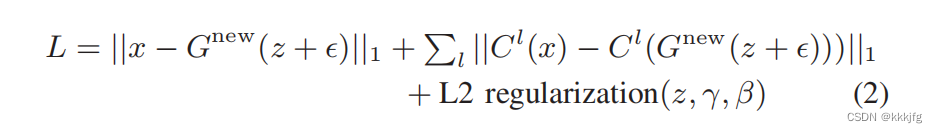

标题:密歇根州立大学、IBM | Understanding and Improving Visual Prompting: A Label-Mapping Perspective(理解和改进视觉提示:以标签映射的视角)了解详情

作者:Aochuan Chen, Yuguang Yao, Pin-Yu Chen, 等

简介:本文重新审视并改进了视觉Prompt提示(VP)。VP可以通过简单地将通用提示(根据输入扰动模式)结合到下游数据点中,来重新编程固定的、预训练的源模型,以完成目标域中的下游任务。然而,即使给定源类和目标类之间的无规则标签映射(LM),VP仍然保持有效的原因仍然难以理解。受上述启发,试问:LM与VP是如何相互关联的?如何利用这种关系来提高目标任务的准确性?作者研究了LM对VP的影响,并提供了一个肯定的答案,即更好的LM“质量”(通过映射精度和解释进行评估)可以持续提高VP的有效性。为优化LM,作者提出了一种新的VP框架、称为ILM-VP(基于迭代标签映射的视觉提示),它自动将源标签重新映射到目标标签,并逐步提高VP的目标任务准确性。广泛的实验表明:作者的建议显著优于最先进的VP方法。

论文下载:https://arxiv.org/pdf/2211.11635.pdf

【生命科学研究】

标题:字节跳动 | Supervised Pretraining for Molecular Force Fields and Properties Prediction(分子力场和性质预测的监督预训练)了解详情

作者:Xiang Gao, Weihao Gao等

简介:本文提出了分子力场的监督预训练。机器学习方法在分子建模任务中已经变得很流行,包括分子力场和性质预测。传统的监督学习方法由于缺乏特定任务的标记数据而受到影响,促使人们将大规模数据集用于其他相关任务。本文在一个8600万个分子组成的数据集上预训练神经网络,以原子电荷和三维几何形状作为输入,以分子能量作为标签。实验表明,与从头开始训练相比,对预训练的模型进行微调可以显著提高七个分子特性预测任务和两个力场任务的性能。本文还证明了从预训练模型中学到的表征包含足够的分子结构信息,表征可以预测许多分子性质,包括原子类型、原子间距离、分子骨架和分子片段的类别。本文的研究结果表明,监督预训练是分子模型中一个很有前途的研究方向。

论文下载:https://arxiv.org/pdf/2211.14429v1.pdf

标题:字节跳动 | Learning Regularized Positional Encoding for Molecular Prediction(学习正则化位置编码以进行分子预测)了解详情

作者:Xiang Gao, Weihao Gao等

简介:本文提出了一种在连续可微分的位置编码以提升预训练模型性能。位置相关编码对于原子间距离和键角很重要,在分子物理学中起着关键作用。现有的工作依赖于对其表征的精细设计。为了以更多的端到端方法对预测分子属性的复杂非线性进行建模,本文用连续和可微分的可学习嵌入来编码位置,采用正则化技术来优化沿物理维度的嵌入平滑性。本文对各种分子特性和力场预测任务进行了实验。在插入正则化的位置编码方法后,观察到三种不同的模型结构,EGNN、DimeNet++和Transformer上的性能得到了改善。此外,学习到的位置编码可以更容易地进行基于物理学的解释;另外可以观察到,位置编码也可以和物理学的性质之间有较好的对应。

论文下载:https://arxiv.org/pdf/2211.12773v1.pdf

标题:Deepmind | A Self-Attention Ansatz for Ab-initio Quantum Chemistry(量子化学的自注意力拟设)了解详情

作者:Ingrid von Glehn, James S. Spencer, David Pfau

简介:本文提出了一种利用自注意力的新型神经网络结构,波函数Transformer (Psiformer),它可以作为解决多电子薛定谔方程的Ansatz。该方程是量子化学和材料科学的基本方程,可以从第一性原理来解决,不需要外部训练数据。近年来,像FermiNet和PauliNet一样的深度神经网络已经被用来显著提高这些第一原理计算的准确性,但它们缺乏类似于注意力的机制来控制电子之间的相互作用。本文展示了Psiformer可以作为这些神经网络的替代方案,在进行了预训练方面的多种优化(比如提升训练时间、改进采样等)后,可以极大地提高计算的准确性,特别是在较大的分子上,比以前的方法有了质的飞跃。这表明,自注意力网络可以学习电子之间复杂的量子力学关联,是在更大的系统上达到更高化学计算精度的潜在途径。

论文下载:https://arxiv.org/pdf/2211.13672v1.pdf

【基础研究】

标题:用热传导方程来指导自监督学习了解详情

作者:苏剑林

简介:本文介绍了QB-Heat,这是一种用热传导方程来指导自监督学习的方案,它跟MAE的区别是用简单的预测而不是掩码来作为剩余部分图像传入到解码器的特征。基于物理中热传导方程的解,与CAM、积分梯度等显著性方法得到的归因热力图的相似程度,作者认为热传导方程可以作为好的视觉特征的一个重要先验。具体来说,原始图像经过编码后得到的特征,应该尽量满足由热传导方程导出的拉普拉斯方程的衍生式,并以此目的提出了QB-Heat,即每次只输入一小部分图像,经过编码后的到对应的特征,通过离散化来预测完整图像的特征,然后将特征传入一个小的解码器来重建完整图像。作者认为这种方法通过连续性和线性性假设给特征向量做了显式预测,从而起到了隐式的正则化作用。

论文下载:https://arxiv.org/abs/2211.13228

工具代码

【工具资源】

标题:OpenAI | ChatGPT手把手debug代码!了解详情

简介:近日OpenAI开放工具ChatGPT。作为对话模型有以下优点:基于GPT3.5,有着更多样的训练数据,debug代码能力很强。强大的多轮上下文理解能力,从指代消解、写信的例子看出来的,如果对历史消息没有很好的记忆理解,可能就新起一个话题了。更像人,目前大部分模型都是直接回答,而ChatGPT显然跟用户有一个「Chat」的过程,比如debug代码的时候,上来先回复「很难说,再多给点信息」。制作过程包括:用监督数据基于GPT3.5训练一个对话模型,训练数据是标注人员手把手写出来的;人工标注模型生成的多个结果,训练一个给对话回复打分的模型;用打分模型作为反馈,基于PPO算法训练一个对话模型。但依然存在一些局限:说一些不明所以毫无疑义的话,重复问相同的问题,或者轻微调整后答案变化很大

很啰嗦,也不是所有模糊情况都会反问,有些黄赌毒问题还是没法识别,作者们在打算用API解决

试用地址:https://chat.openai.com/

标题:百度 | 以落地考验价值,大模型的产业大考来了了解详情

简介:在今日举行的百度 WAVE SUMMIT+2022 深度学习开发者峰会上,百度产业级深度学习开源开放平台飞桨以及产业级知识增强大模型文心均迎来了重大升级,在全新发布的 11 个大模型中,包括 5 个行业大模型,分别是泰康-百度 · 文心、深燃-百度 · 文心、吉利-百度 · 文心、TCL-百度 · 文心以及辞海-百度 · 文心。在仅仅半年的时间里,百度文心行业大模型的数量已经达到了 11 个,覆盖能源电力、金融、航天、传媒、影视、汽车、城市管理、燃气、保险、电子制造和社科等多个领域,文心行业大模型逐渐形成自己的核心特色---行业知识增强。另一方面,还新增了 5 个基础大模型,它们分别是知识增强轻量级大模型 ERNIE 3.0 Tiny、跨模态理解大模型 ERNIE ViL 2.0、跨模态生成大模型 ERNIE ViLG 2.0、文档智能大模型 ERNIE-Layout 和单序列蛋白质结构预测大模型 HelixFold-Single;1 个任务大模型,即代码大模型 ERNIE-Code。

【代码学习】

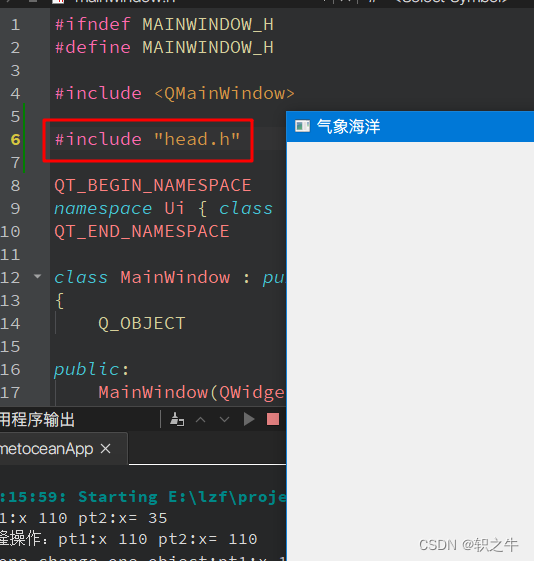

标题:FlagAI | 在Altdiffusion上使用Dreambooth! 属于你的Stable diffusion!了解详情

简介:近日,智源研究院发布了中英双语图像生成模型AltDiffusion,并在不到一周的时间内推出升级版AltDiffusion-m9,全面支持中、英、西、法、日、韩、阿、俄、意等九种不同语言的文生图任务。目前,AltDiffusion已经集成到Huggingface diffusers中,可以用diffusers库方便使用AltDiffusion。下方展示了测试代码案例,训练代码请参见“了解详情”。

import torch

from diffusers import AltDiffusionPipeline

output_dir = "path-to-save-model"

!git clone https://github.com/huggingface/diffusers.git

#cd 到dreambooth代码所在的地址:

!cd /diffusers/examples/dreambooth

#安装所需要的环境:

!pip install -U -r requirements.txt

pipe = AltDiffusionPipeline.from_pretrained(output_dir,torch_dtype=torch.float16

).to("cuda:0")

prompt = '一张鸣人男孩的照片,背景是沙漠,masterpieces'

image = pipe(prompt, guidance_scale=7.5, height=512, width=512,num_inference_steps=50).images[0]

image.save("alt_diffusion.png")代码地址:

https://huggingface.co/BAAI/AltDiffusion-m9

活动预告

标题:智源 | 2022大模型创新论坛发布,训练营、峰会、创业大赛等六大板块全预告了解详情

简介:2022年12月10-20日,由北京智源人工智能研究院主办的「2022大模型创新论坛」将线上召开,论坛包含训练营、峰会、创业大赛、黑客马拉松、闭门研讨会、创新应用榜单6个环节,邀请关注AI大模型技术与应用创新的研究员、产业专家、创业者、投资人、学生共同参与,围绕当前学术、产业、投资、公众、媒体等最关注的相关话题展开讨论。参与本次活动的包括Anthropic、OpenAI、智源研究院等科研机构;阿里、百度、华为、微软等企业;北大、牛津、清华、斯坦福、人民大学、中央音乐学院等高校院所;红杉、启明创投等投资机构。CCF计算艺术分会、海淀创业园、Hugging Face、安远AI、OpenBMB开源社区、拾象科技、并行科技共同参与了本次活动筹办。

如果你正在从事或关注预训练学习研究、实现与应用,欢迎加入“智源社区-预训练-交流群”。在这里,你可以:

学习前沿知识、求解疑难困惑

分享经验心得、展示风貌才华

参与专属活动、结识研究伙伴

请扫描下方二维码加入预训练群(备注:“姓名+单位+预训练”才会验证进群哦)