点击上方“Python爬虫与数据挖掘”,进行关注

回复“书籍”即可获赠Python从入门到进阶共10本电子书

今

日

鸡

汤

归来池苑皆依旧,太液芙蓉未央柳。

大家好,我是皮皮。

一、前言

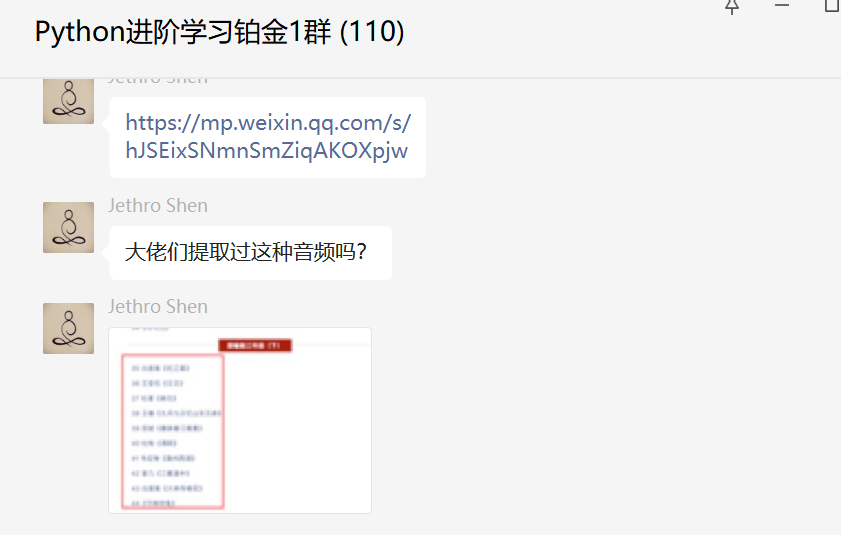

前几天在Python钻石交流群【Jethro Shen】问了一个Python网络爬虫的问题,这里拿出来给大家分享下。

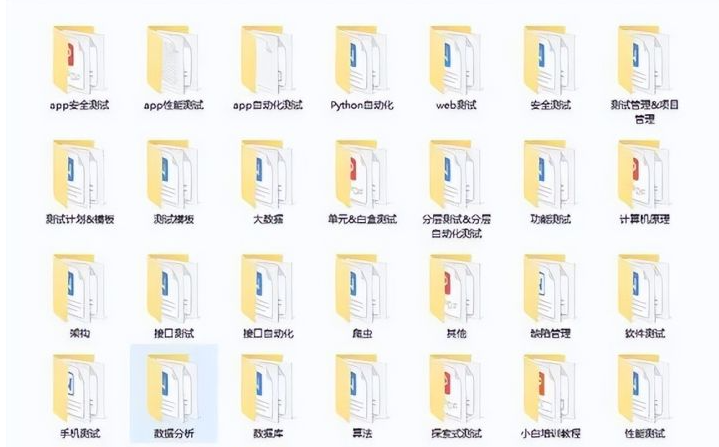

他想获取全部文件,但是实际上,只能获取单个文件。

二、实现过程

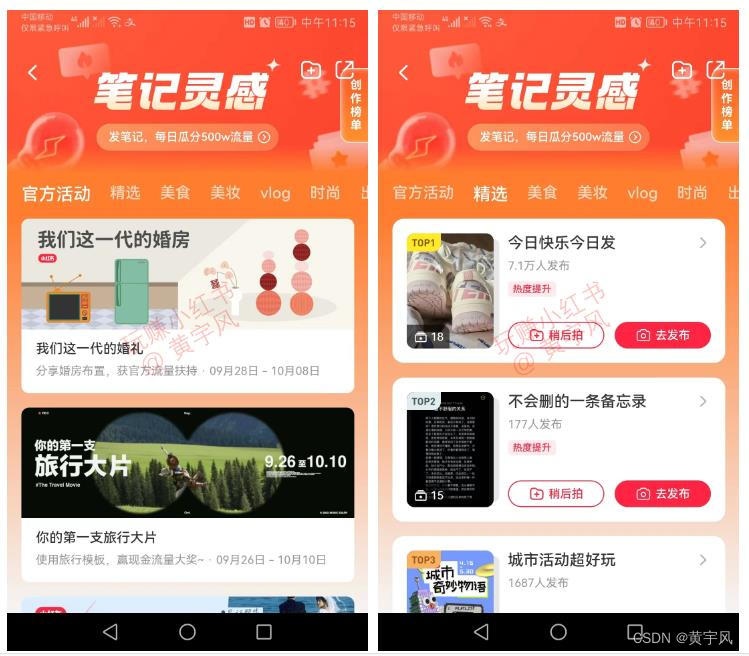

这里【甯同学】给了一个解决思路,如下图所示:

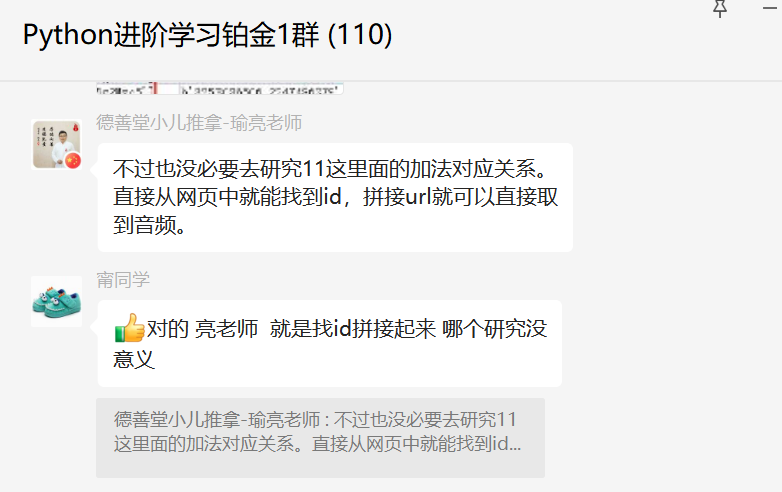

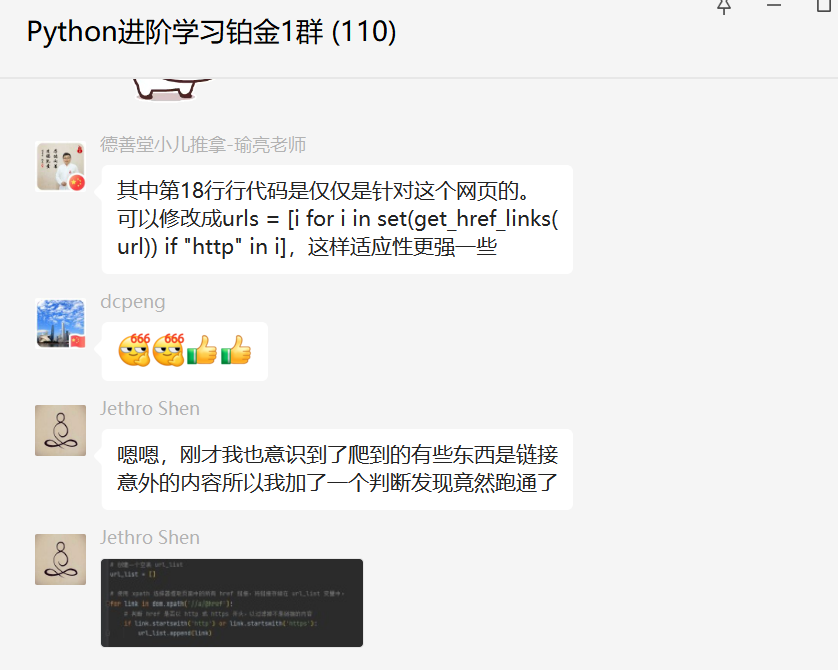

后来【瑜亮老师】也提供了一种方法。

直接一步到位。

下面是具体的代码:

import requests

import time

from lxml import html

from lxml import etreeheaders = {'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/109.0.0.0 ''Safari/537.36'}def get_href_links(url):response = requests.get(url, headers=headers)page_content = response.contentdom_tree = html.fromstring(page_content)href_links = dom_tree.xpath('//a/@href')return href_linksurl = "https://mp.weixin.qq.com/s/BANHI5apQzlpeTTdLZAIvg"

urls = set(get_href_links(url)[1:-5])

mp3_d_url = 'https://res.wx.qq.com/voice/getvoice?mediaid={}'

for url in urls:response = requests.get(url, headers=headers)html = response.textselector = etree.HTML(html)voice_encode_fileid = selector.xpath('//mpvoice/@voice_encode_fileid')[0]name = selector.xpath('//mpvoice/@name')[0]d_url = mp3_d_url.format(voice_encode_fileid)response = requests.get(d_url)if response.status_code == 200:with open(name, 'wb') as f:f.write(response.content)print('{} 下载成功!'.format(name))else:print('{} 下载失败!'.format(name))time.sleep(1) # 设置请求间隔时间为1秒,避免被封IP顺利地解决了粉丝的问题。

三、总结

大家好,我是皮皮。这篇文章主要盘点了一个Python网络爬虫的问题,文中针对该问题,给出了具体的解析和代码实现,帮助粉丝顺利解决了问题。

最后感谢粉丝【Jethro Shen】提问,感谢【甯同学】、【瑜亮老师】、给出的思路和代码解析,感谢【eric】等人参与学习交流。

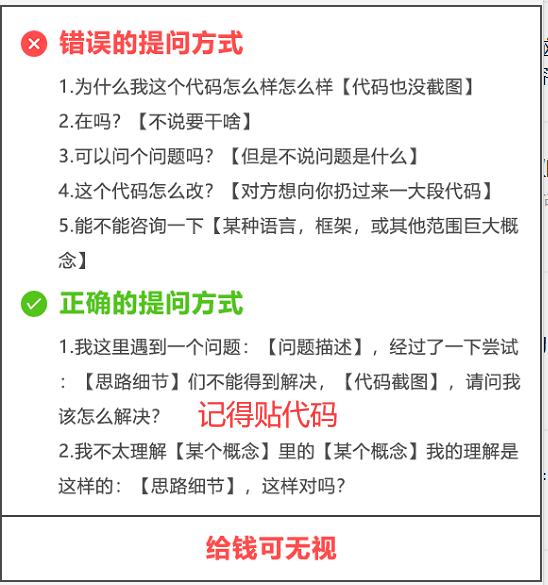

【提问补充】温馨提示,大家在群里提问的时候。可以注意下面几点:如果涉及到大文件数据,可以数据脱敏后,发点demo数据来(小文件的意思),然后贴点代码(可以复制的那种),记得发报错截图(截全)。代码不多的话,直接发代码文字即可,代码超过50行这样的话,发个.py文件就行。

大家在学习过程中如果有遇到问题,欢迎随时联系我解决(我的微信:pdcfighting1),应粉丝要求,我创建了一些高质量的Python付费学习交流群和付费接单群,欢迎大家加入我的Python学习交流群和接单群!

小伙伴们,快快用实践一下吧!如果在学习过程中,有遇到任何问题,欢迎加我好友,我拉你进Python学习交流群共同探讨学习。

------------------- End -------------------

往期精彩文章推荐:

if a and b and c and d:这种代码有优雅的写法吗?

Pycharm和Python到底啥关系?

都说chatGPT编程怎么怎么厉害,今天试了一下,有个静态网页,chatGPT居然没搞定?

站不住就准备加仓,这个pandas语句该咋写?

欢迎大家点赞,留言,转发,转载,感谢大家的相伴与支持

想加入Python学习群请在后台回复【入群】

万水千山总是情,点个【在看】行不行

/今日留言主题/

随便说一两句吧~~