一、下载

docker pull mysql:5.7

docker pull nacos/nacos-server:v2.2.2

docker images

二、mysql部署

1、创建目录存储数据信息

mkdir ~/mysql

cd ~/mysql

2、运行 MySQL 容器

docker run -id \

-p 3306:3306 \

--name mysql \

-v $PWD/conf:/etc/mysql/conf.d \

-v $PWD/logs:/logs \

-v $PWD/data:/var/lib/mysql \

-e MYSQL_ROOT_PASSWORD=root \

mysql5.7

3、登录数据库:

docker exec -it mysql mysql -uroot -p

创建数据库nacos导入

create database nacos;

导入sql文件:

docker exec -i -t mysql mysql -unacos -p < mysql-chema.sql

交互:

docker exec -it mysql /bin/bash

三、nacos部署

1、创建目录存储数据信息

mkdir ~/nacos

cd ~/nacos

2、运行 nacos 容器

docker run -d \

--name nacos\

-p 8848:8848 \

-e MODE=standalone \

-e SPRING_DATASOURCE_PLATFORM=mysql \

-e MYSQL_SERVICE_HOST=127.0.0.1 \

-e MYSQL_SERVICE_PORT=3306 \

-e MYSQL_SERVICE_USER=root \

-e MYSQL_SERVICE_PASSWORD=root \

-e MYSQL_SERVICE_DB_NAME=nacos \

-v /root/nacos/data:/home/nacos/data\

nacos/nacos-server:v2.2.2

3、登录web

http://localhost:8848/nacos/index.html

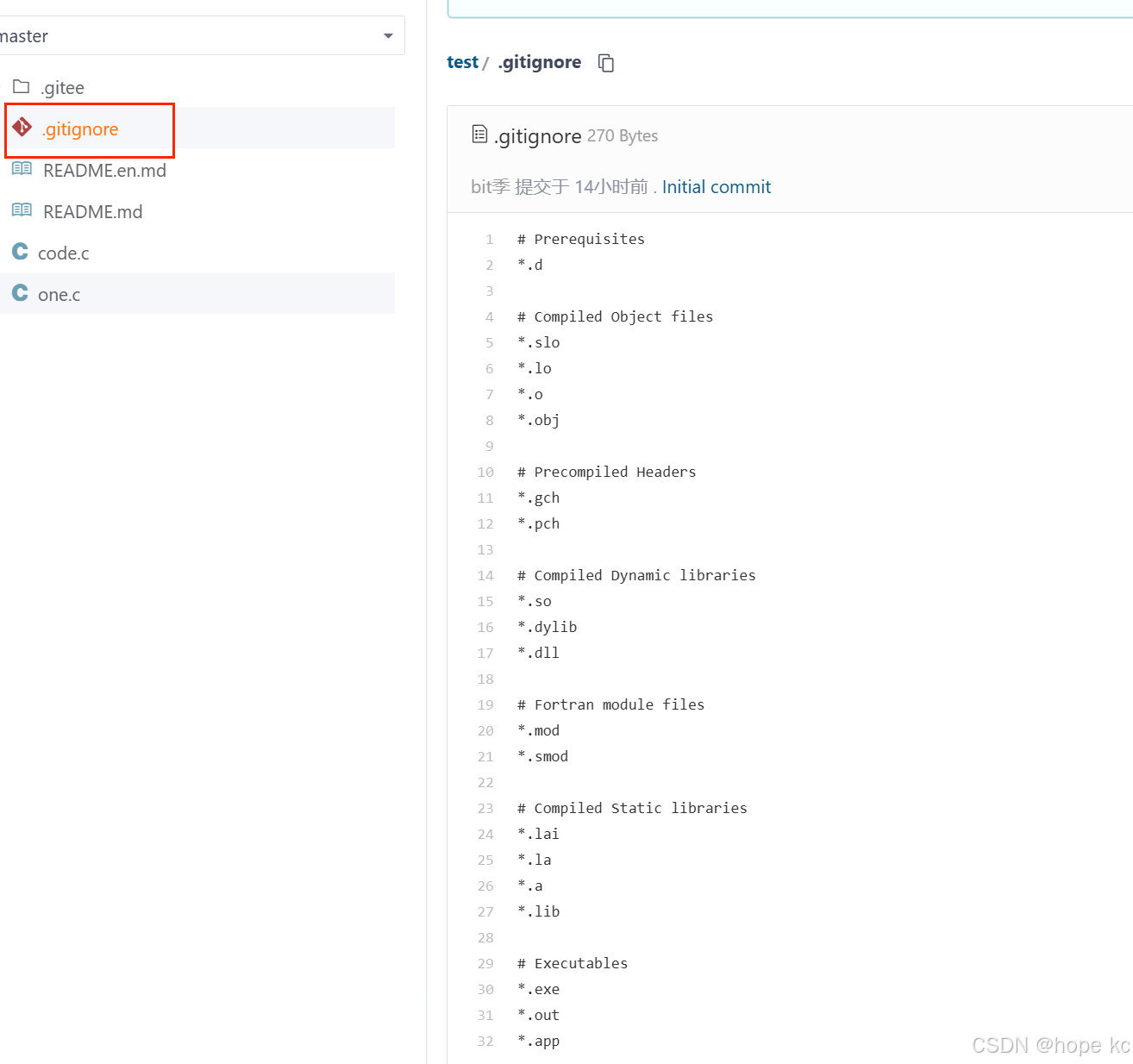

其他命令相关:

修改配置文件和日志操作:

docker start 316c

docker exec -it nacos /bin/bash

docker cp nacos:/home/nacos/conf/schema.sql ~/nacos

docker cp nacos:/home/nacos/logs/nacos.log ~/nacos

docker cp ~/nacos/application.properties nacos:/home/nacos/conf/application.properties

查看容器信息:

docker inspect nacos

检查防火墙状态:

systemctl status firewalld centos

systemctl status ufw ubuntu

配置防火墙:

sudo iptables -L

sudo iptables -A INPUT -p tcp --dport 8848 -j ACCEPT

数据库相关:

mysql -u root -p

# 使用mysql数据库

use mysql;

# mysql8之前版本的授权语句如下

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '密码' WITH GRANT OPTION;

# mysql8版本的授权语句

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' WITH GRANT OPTION;

ALTER USER 'root'@'%' IDENTIFIED WITH mysql_native_password BY 'root';

#刷新权限

FLUSH PRIVILEGES;