目录

FreeRTOS的中断管理

1、STM32中断优先级管理

2、FreeRTOS任务优先级管理

3、寄存器和内存映射寄存器

4、BASEPRI寄存器

5、FreeRTOS与STM32中断管理结合使用

vPortRaiseBASEPRI

vPortSetBASEPRI

6、FromISR后缀

7、在中断服务函数中调用FreeRTOS的API函数需注意

FreeRTOS的临界段代码

1、通过中断管理临界区

1)taskENTER_CRITICAL():进入临界区

2)taskEXIT_CRITICAL():退出临界区

3)taskENTER_CRITICAL_FROM_ISR():进入临界区(中断级)

4)taskEXIT_CRITICAL_FROM_ISR():退出临界区(中断级)

2、通过挂起和恢复任务调度器管理临界区

1)uxSchedulerSuspended

2)vTaskSuspendAll():挂起任务调度器

3)xTaskResumeAll():恢复任务调度器

FreeRTOS的中断管理

1、STM32中断优先级管理

在STM32中,中断优先级是通过中断优先级配置寄存器的高4位 [7:4] 来配置的。因此STM32支持最多16级中断优先级,其中数值越小表示优先级越高,即更紧急的中断。

2、FreeRTOS任务优先级管理

FreeRTOS任务调度的优先级相反,数值越大越优先。任务优先级的最大值由FreeRTOSConfig.h中的配置项configMAX_PRIORITIES决定,默认为5,如下。

#define configMAX_PRIORITIES ( 5 )该配置项在当前环境下不能大于32,否则编译报错,如下。

#if ( configMAX_PRIORITIES > 32 )#error configUSE_PORT_OPTIMISED_TASK_SELECTION can only be set to 1 when configMAX_PRIORITIES is less than or equal to 32. It is very rare that a system requires more than 10 to 15 difference priorities as tasks that share a priority will time slice.

#endif因此,可以得出结论,在当前配置下,FreeRTOS的任务最多可以有32个优先级。

优先级范围[0, configMAX_PRIORITIES),即最大优先级为configMAX_PRIORITIES-1。

3、寄存器和内存映射寄存器

这里的寄存器不同于STM32的外设寄存器,后者是内存映射寄存器,实际上是在内存中划分特定的地址空间,用于访问和控制外设的功能。而此处的寄存器是Cortex-M3内核中“真正的”寄存器,基于SR锁存器构建。

4、BASEPRI寄存器

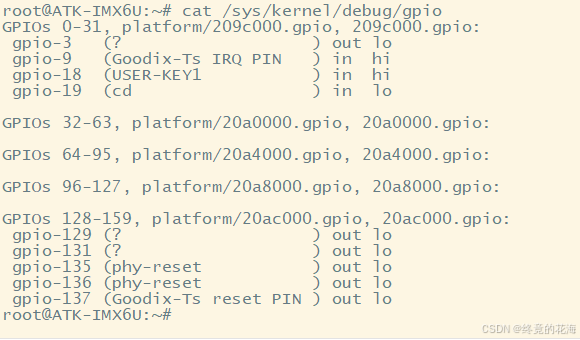

BASEPRI寄存器即Base Priority Mask Register(基本优先级屏蔽寄存器)。顾名思义,该寄存器是用来屏蔽中断响应的,位定义如下。

BASEPRI只有bit7-bit4起作用,当这四位不为0时,会屏蔽优先级数值上大于等于该值的中断响应。如:BASEPRI设置为0x50(只看bit7-bit4,也就是5),代表中断优先级在5~15内的均被屏蔽,0~4的中断优先级正常执行。

当bit7-bit4为0时无效,即不屏蔽任何中断。

5、FreeRTOS与STM32中断管理结合使用

FreeRTOS可以与STM32原生的中断机制结合使用。

FreeRTOS初始化时,PendSV和SysTick被设置最低中断优先级(数值最大,15),保证系统任务切换不会阻塞系统其他中断的响应。

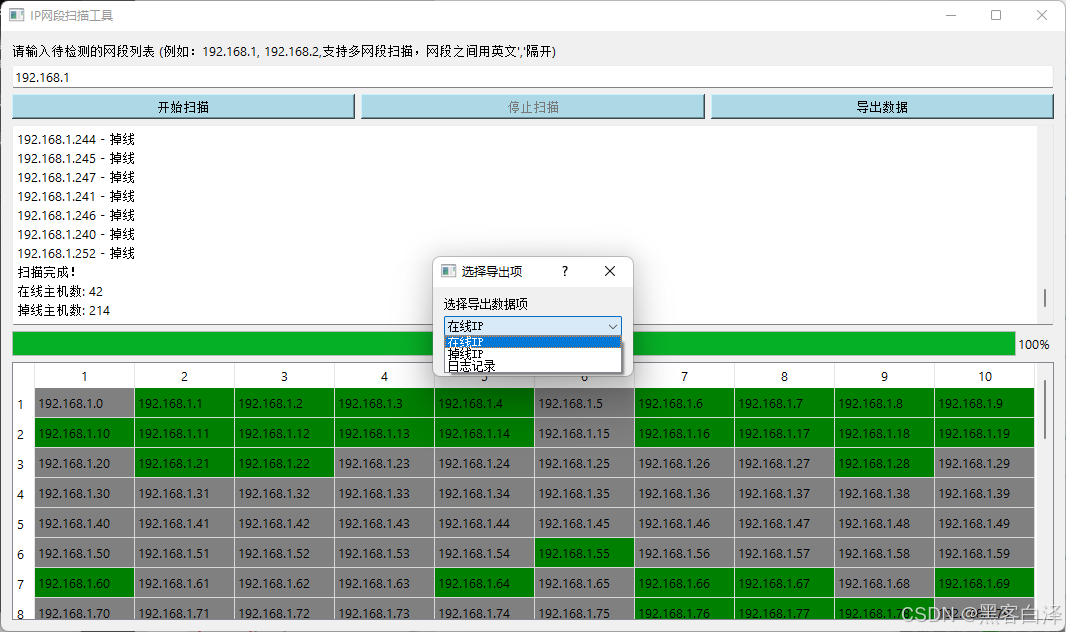

FreeRTOS提供了一组宏定义用于禁用和启用中断,如下。

#define portDISABLE_INTERRUPTS() vPortRaiseBASEPRI()

#define portENABLE_INTERRUPTS() vPortSetBASEPRI( 0 )vPortRaiseBASEPRI

vPortRaiseBASEPRI是一个内连汇编函数,如下。

static portFORCE_INLINE void vPortRaiseBASEPRI( void )

{uint32_t ulNewBASEPRI = configMAX_SYSCALL_INTERRUPT_PRIORITY;__asm{/* Set BASEPRI to the max syscall priority to effect a critical* section. */

/* *INDENT-OFF* */msr basepri, ulNewBASEPRIdsbisb

/* *INDENT-ON* */}

}该函数先把configMAX_SYSCALL_INTERRUPT_PRIORITY赋值给ulNewBASEPRI,然后通过msr指令将ulNewBASEPRI的值赋给basepri寄存器。上述过程实际上是将configMAX_SYSCALL_INTERRUPT_PRIORITY配置项的值赋给了basepri寄存器。该配置项在FreeRTOSConfig.h中定义,默认值为191。因为是赋给basepri的,所以只有bit7-bit4有效,因而191等价于0xB0。

#define configMAX_SYSCALL_INTERRUPT_PRIORITY 191该配置项默认值为191,那么,默认情况下,FreeRTOS进入临界区时会屏蔽中断优先级数值上大于等于11的中断。我们可以说FreeRTOS管理的最大优先级为11。

在STM32F103ZET6单片机上使用FreeRTOS时,建议将上述配置项设置为较低的优先级值(逻辑上优先级较高),通常是5。需要注意的是,vPortRaiseBASEPRI函数中,会将configMAX_SYSCALL_INTERRUPT_PRIORITY直接赋值给BASEPRI寄存器,而不会进行移位操作,因此,当我们要让FreeRTOS可以管理的最大优先级设置为5时,要确保configMAX_SYSCALL_INTERRUPT_PRIORITY的bit7-bit4为5,通常赋值为0x50。

vPortSetBASEPRI

vPortSetBASEPRI也是一个内联汇编函数,如下。

static portFORCE_INLINE void vPortSetBASEPRI( uint32_t ulBASEPRI )

{__asm{/* Barrier instructions are not used as this function is only used to* lower the BASEPRI value. */

/* *INDENT-OFF* */msr basepri, ulBASEPRI

/* *INDENT-ON* */}

}该函数将ulBASEPRI赋值给BASEPRI寄存器。因此,portENABLE_INTERRUPTS()宏的逻辑是将0赋给BASERPI,不再屏蔽任何中断。

6、FromISR后缀

FreeRTOS提供了一组带FromISR后缀的函数,这类函数是对应无后缀API的另一个版本,专门用于在ISR(Interrupt Service Routine,中断服务函数或例程)中调用,相较于无后缀版本,增加了一些额外操作。

7、在中断服务函数中调用FreeRTOS的API函数需注意

1、中断服务函数的优先级需在FreeRTOS所管理的范围内,阈值由configMAX_SYSCALL_INTERRUPT_PRIORITY指定。

2、建议将所有优先级位指定为抢占优先级位,方便FreeRTOS管理。

3、在中断服务函数里边需调用FreeRTOS的API函数,必须使用带“FromISR”后缀的函数。

FreeRTOS的临界段代码

临界段代码,又称为临界区,指的是那些必须在不被打断的情况下完整运行的代码段。例如,某些外设的初始化可能要求严格的时序,因此在初始化过程中不允许被中断打断。

1、通过中断管理临界区

在FreeRTOS中,临界段代码需要被“临界区进入”和“临界区退出”函数保护起来。临界区的进入和退出可以通过中断来实现,相关函数有 4 个:

1)taskENTER_CRITICAL():进入临界区

void vPortEnterCritical( void )

{portDISABLE_INTERRUPTS();uxCriticalNesting++;/* This is not the interrupt safe version of the enter critical function so* assert() if it is being called from an interrupt context. Only API* functions that end in "FromISR" can be used in an interrupt. Only assert if* the critical nesting count is 1 to protect against recursive calls if the* assert function also uses a critical section. */if( uxCriticalNesting == 1 ){configASSERT( ( portNVIC_INT_CTRL_REG & portVECTACTIVE_MASK ) == 0 );}

}是通过portDISABLE_INTERRUPTS()宏禁用中断实现的。

2)taskEXIT_CRITICAL():退出临界区

void vPortExitCritical( void )

{configASSERT( uxCriticalNesting );uxCriticalNesting--;if( uxCriticalNesting == 0 ){portENABLE_INTERRUPTS();}

}是通过调用portENABLE_INTERRUPTS()宏启用中断实现的。

3)taskENTER_CRITICAL_FROM_ISR():进入临界区(中断级)

4)taskEXIT_CRITICAL_FROM_ISR():退出临界区(中断级)

进入和退出临界区是成对使用的。每进入一次临界区,全局变量uxCriticalNesting都会加一,每调用一次退出临界区,uxCriticalNesting减一,只有当 uxCriticalNesting 为 0 时才会调用函数 portENABLE_INTERRUPTS()使能中断。这确保了在存在多个临界区代码的情况下,不会因为某个临界区代码的退出而破坏其他临界区的保护。只有当所有的临界区代码都退出时,中断才会被重新使能。

上文提到,PendSV和SysTick两个中断的优先级在FreeRTOS初始化时都被置为最低优先级15,而这两个中断时FreeRTOS任务切换的核心。因此,在进入临界区时,FreeRTOS无法执行任务切换,保证了临界区操作的原子性。但要注意,优先级高于(数值上低于)配置项configMAX_SYSCALL_INTERRUPT_PRIORITY的中断未被FreeRTOS管理,仍然可以打断任务执行。

2、通过挂起和恢复任务调度器管理临界区

挂起和恢复任务调度器, 调用此函数不需要关闭中断:

1)uxSchedulerSuspended

这是一个全局变量,声明及初始化如下。

PRIVILEGED_DATA static volatile UBaseType_t uxSchedulerSuspended = ( UBaseType_t ) pdFALSE;pdFALSE数值上为0,如下。

#define pdFALSE ( ( BaseType_t ) 0 )在FreeRTOS中,任务调度器可以被多次挂起,uxSchedulerSuspended用于记录调度器被挂起的次数,只要它不为0,则无法进行任务切换。

2)vTaskSuspendAll():挂起任务调度器

该函数的核心逻辑只有一行,如下。

++uxSchedulerSuspended;调用该函数后,任务切换被禁止,当前任务的执行不会被其它任务打断,从而保护了临界区代码。

3)xTaskResumeAll():恢复任务调度器

该函数核心逻辑如下。

--uxSchedulerSuspended;if( uxSchedulerSuspended == ( UBaseType_t ) pdFALSE ){……}首先将uxSchedulerSuspended减1,而后判断是否为pdFALSE,是则说明所有临界区已退出,可以恢复任务调度,执行相关操作。

vTaskSuspendAll和xTaskResumeAll是成对出现的,临界区可以嵌套,仅在所有临界区全部退出时,才能恢复任务切换。

与中断管理临界区不同的是,挂起任务调度器时未关闭中断;这种方式仅仅防止了任务之间的资源争夺,中断仍然可以直接响应;挂起调度器的方法适用于临界区位于任务与任务之间的情况;这样既不需要延迟中断,同时又能确保临界区的安全性。