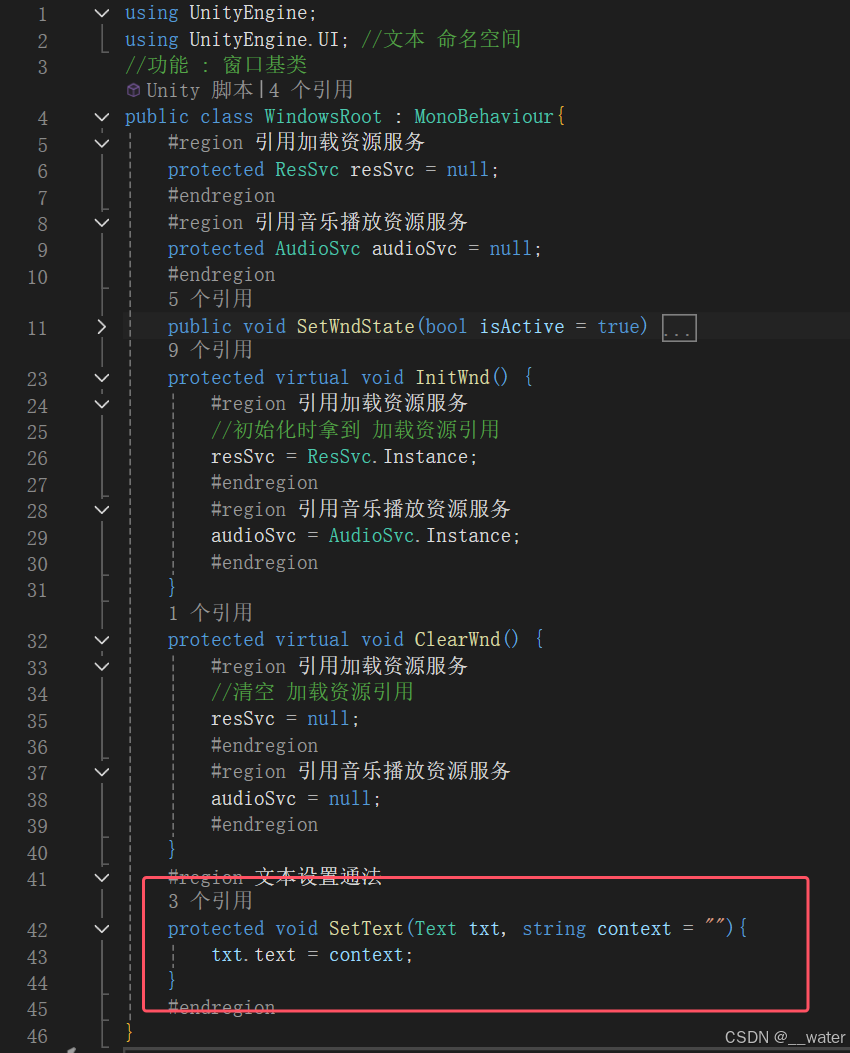

QuestionViewCell.h文件代码,定义代理协议

@protocol QuestionViewCellDelegate <NSObject>- (void)cellIsOpenDidChangeAtIndexPath:(NSIndexPath *)indexPath;@end@interface QuestionViewCell : UITableViewCell@property (nonatomic, weak) id<QuestionViewCellDelegate> delegate;@endQuestionViewCell.m文件调用代理代码

#import "QuestionViewCell.h"@interface QuestionViewCell ()@end@implementation QuestionViewCell- (void)awakeFromNib {[super awakeFromNib];[FontSizeUtil setupWidgets:@[self.titleLabel, self.contentLabel]pingfangWithFontSizes:@[@12, @11]];

}- (IBAction)openClickAction:(id)sender {if (self.delegate && [self.delegate respondsToSelector:@selector(cellIsOpenDidChangeAtIndexPath:)]) {[self.delegate cellIsOpenDidChangeAtIndexPath:self.indexPath];}

}@endUITableView设置代理对象

- (UITableViewCell *)tableView:(UITableView *)tableView cellForRowAtIndexPath:(NSIndexPath *)indexPath {、QuestionViewCell *cell = [tableView dequeue:QuestionViewCell.class forIndexPath:indexPath];cell.indexPath = indexPath;cell.delegate = self;return cell;

}ViewController.m 委托者实现代理协议

@interface TestViewController ()

<QuestionViewCellDelegate,

UITableViewDelegate,

UITableViewDataSource>

@end@implementation TestViewController#pragma mark - QuestionViewCellDelegate- (void)cellIsOpenDidChangeAtIndexPath:(NSIndexPath *)indexPath {//刷新Row行[self.tableView reloadRowsAtIndexPaths:@[indexPath] withRowAnimation:UITableViewRowAnimationAutomatic];

}@end

![2025.1.21——八、[HarekazeCTF2019]Avatar Uploader 2(未完成) 代码审计|文件上传](https://i-blog.csdnimg.cn/direct/2ed2898343e04e32b561c201cb7d5cf5.png)