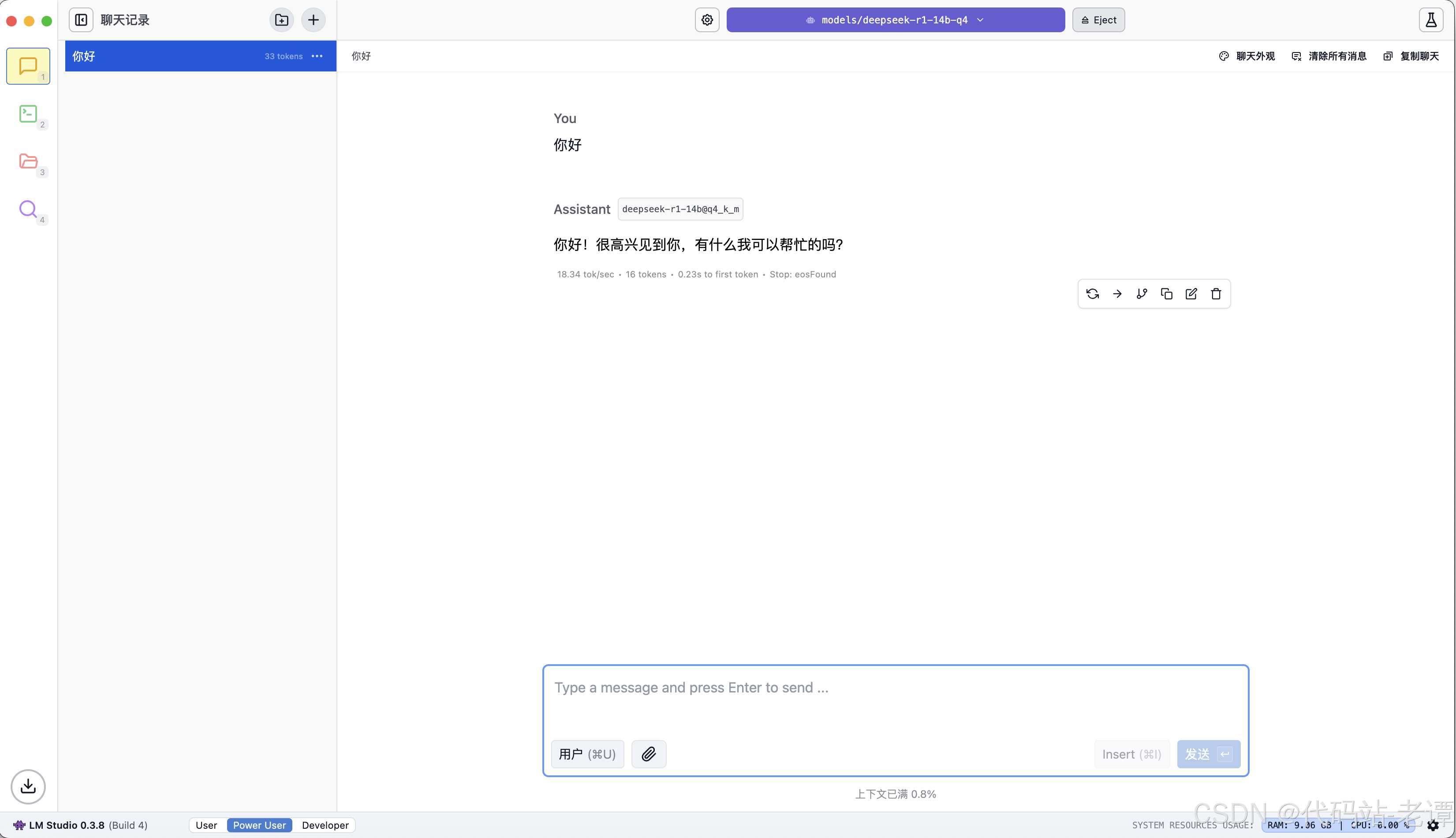

1.30 性能巅峰:NumPy代码优化全攻略

目录

1.30.1 向量化操作的黄金法则1.30.1.1 向量化操作的基本概念1.30.1.2 向量化操作的性能优势1.30.1.3 向量化操作的实战案例

1.30.2 循环优化的JIT编译方案1.30.2.1 JIT编译的基本原理1.30.2.2 Numba加速NumPy代码1.30.2.3 Numba加速遗留代码案例

1.30.3 多线程与多进程加速1.30.3.1 Python多线程的基本概念1.30.3.2 多线程GIL规避技巧1.30.3.3 Python多进程的基本概念1.30.3.4 多进程加速NumPy计算

1.30.4 分布式计算的Dask集成1.30.4.1 Dask的基本概念1.30.4.2 Dask与NumPy的集成1.30.4.3 分布式矩阵乘法实现

1.30.5 性能剖析火焰图解读1.30.5.1 性能剖析的基本概念1.30.5.2 使用火焰图进行性能分析1.30.5.3 火焰图的解读技巧

1.30 性能巅峰:NumPy代码优化全攻略

1.30.1 向量化操作的黄金法则

1.30.1.1 向量化操作的基本概念

向量化操作是指在NumPy中利用内置的高效数组操作来替代显式的循环操作。NumPy的数组操作是用C语言实现的,因此在处理大量数据时,向量化操作比Python的显式循环要快得多。

- 什么是向量化操作:向量化操作是NumPy的核心特性之一,它通过使用内部优化的C语言实现,使得数组操作更加高效。

- 向量化操作的优势:向量化操作可以显著提高代码的执行速度,减少内存占用,使代码更加简洁易读。

1.30.1.2 向量化操作的性能优势

通过对比向量化操作和显式循环,我们可以直观地看到向量化操作的性能优势。

import numpy as np

import time# 生成100万个随机数的数组

data = np.random.rand(1000000) # 生成随机数数组# 显式循环计算平方和

start_time = time.time()

sum_of_squares = 0

for x in data:sum_of_squares += x ** 2 # 计算平方和

end_time = time.time()

loop_time = end_time - start_time

print(f"显式循环计算时间: {loop_time}秒") # 打印计算时间# 向量化操作计算平方和

start_time = time.time()

sum_of_squares_vectorized = np.sum(data ** 2) # 向量化计算平方和

end_time = time.time()

vectorized_time = end_time - start_time

print(f"向量化操作计算时间: {vectorized_time}秒") # 打印计算时间# 比较两种方法的性能

print(f"性能提升比例: {loop_time / vectorized_time}")

- 显式循环:使用Python的显式循环逐个元素进行计算。

- 向量化操作:使用NumPy的向量化操作一次性处理整个数组。

- 性能对比:通过计算时间比较两种方法的性能,向量化操作通常比显式循环快多个数量级。

1.30.1.3 向量化操作的实战案例

通过实战案例,我们进一步了解如何在实际项目中应用向量化操作。

import numpy as np# 生成100万个随机数的数组

data = np.random.rand(1000000) # 生成随机数数组# 计算所有元素的平方

squared_data = data ** 2 # 向量化计算平方# 计算所有元素的平方根

sqrt_data = np.sqrt(data) # 向量化计算平方根# 计算所有元素的绝对值

abs_data = np.abs(data) # 向量化计算绝对值# 计算所有元素的对数

log_data = np.log(data) # 向量化计算对数# 打印前10个元素的计算结果

print("平方前10个元素:", squared_data[:10])

print("平方根前10个元素:", sqrt_data[:10])

print("绝对值前10个元素:", abs_data[:10])

print("对数前10个元素:", log_data[:10])

- 生成数据:生成一个100万个随机数的数组。

- 向量化计算:使用NumPy的向量化操作计算平方、平方根、绝对值和对数。

- 结果展示:打印前10个元素的计算结果,验证计算的正确性。

1.30.2 循环优化的JIT编译方案

1.30.2.1 JIT编译的基本原理

JIT(Just-In-Time)编译是一种编译技术,它在程序运行时将部分代码编译为机器码,以提高执行效率。Numba是一个用于Python的JIT编译器,特别适合优化NumPy代码。

- JIT编译的定义:JIT编译是在程序运行时将部分代码编译为机器码的技术。

- Numba的作用:Numba可以将Python函数编译为机器码,显著提高NumPy代码的执行速度。

1.30.2.2 Numba加速NumPy代码

Numba通过简单的装饰器即可实现对NumPy代码的加速。

import numpy as np

from numba import njit

import time# 生成100万个随机数的数组

data = np.random.rand(1000000) # 生成随机数数组# 普通Python函数计算平方和

def sum_of_squares(data):sum_of_squares = 0for x in data:sum_of_squares += x ** 2 # 计算平方和return sum_of_squares# 使用Numba的JIT编译器加速

@njit

def sum_of_squares_numba(data):sum_of_squares = 0for x in data:sum_of_squares += x ** 2 # 计算平方和return sum_of_squares# 测试普通Python函数

start_time = time.time()

result = sum_of_squares(data)

end_time = time.time()

python_time = end_time - start_time

print(f"普通Python函数计算时间: {python_time}秒,结果: {result}")# 测试Numba加速的函数

start_time = time.time()

result_numba = sum_of_squares_numba(data)

end_time = time.time()

numba_time = end_time - start_time

print(f"Numba加速的函数计算时间: {numba_time}秒,结果: {result_numba}")# 比较性能

print(f"性能提升比例: {python_time / numba_time}")

- 普通Python函数:定义一个普通Python函数计算平方和。

- Numba加速:使用Numba的

@njit装饰器对函数进行JIT编译。 - 性能测试:通过计算时间比较两种方法的性能,Numba加速的函数通常比普通Python函数快多个数量级。

1.30.2.3 Numba加速遗留代码案例

Numba不仅可以用于新代码,还可以用于加速遗留代码。

import numpy as np

from numba import njit

import time# 生成100万个随机数的数组

data = np.random.rand(1000000) # 生成随机数数组# 遗留代码:计算元素大于0.5的个数

def count_above_threshold(data, threshold=0.5):count = 0for x in data:if x > threshold:count += 1return count# 使用Numba的JIT编译器加速

@njit

def count_above_threshold_numba(data, threshold=0.5):count = 0for x in data:if x > threshold:count += 1return count# 测试遗留代码

start_time = time.time()

result = count_above_threshold(data)

end_time = time.time()

python_time = end_time - start_time

print(f"遗留代码计算时间: {python_time}秒,结果: {result}")# 测试Numba加速的遗留代码

start_time = time.time()

result_numba = count_above_threshold_numba(data)

end_time = time.time()

numba_time = end_time - start_time

print(f"Numba加速的遗留代码计算时间: {numba_time}秒,结果: {result_numba}")# 比较性能

print(f"性能提升比例: {python_time / numba_time}")

- 遗留代码:定义一个计算数组中元素大于某个阈值的个数的函数。

- Numba加速:使用Numba的

@njit装饰器对函数进行JIT编译。 - 性能测试:通过计算时间比较两种方法的性能,Numba加速的遗留代码同样可以显著提高执行速度。

1.30.3 多线程与多进程加速

1.30.3.1 Python多线程的基本概念

Python的多线程可以通过threading模块实现,但受GIL(全局解释器锁)的限制,多线程在CPU密集型任务中并不总是能显著提高性能。

- 多线程的定义:多线程是指在同一个程序中同时运行多个线程,共享内存资源。

- GIL的作用:GIL是为了防止多线程争抢解释器资源而设计的,但也会限制多线程在CPU密集型任务中的性能。

1.30.3.2 多线程GIL规避技巧

尽管有GIL的限制,我们仍然可以通过一些技巧来规避GIL,提高多线程的性能。

import numpy as np

import threading

import time# 生成100万个随机数的数组

data = np.random.rand(1000000) # 生成随机数数组# 多线程计算平方和

def sum_of_squares_thread(data, start, end, result):for i in range(start, end):result[0] += data[i] ** 2 # 计算平方和# 划分数据

num_threads = 4

thread_data_length = len(data) // num_threads

result = np.zeros(1) # 用于存储结果# 创建线程

threads = []

for i in range(num_threads):start = i * thread_data_lengthend = (i + 1) * thread_data_lengththread = threading.Thread(target=sum_of_squares_thread, args=(data, start, end, result))threads.append(thread)thread.start()# 等待所有线程完成

for thread in threads:thread.join()# 打印结果

print(f"多线程计算结果: {result[0]}")

- 多线程函数:定义一个多线程函数计算部分数据的平方和。

- 数据划分:将数据划分为多个部分,每个部分由一个线程处理。

- 线程创建与启动:创建多个线程并启动。

- 结果合并:等待所有线程完成,合并结果。

1.30.3.3 Python多进程的基本概念

Python的多进程可以通过multiprocessing模块实现,多进程不受GIL的限制,可以充分利用多个CPU核心。

- 多进程的定义:多进程是指在同一个程序中同时运行多个进程,每个进程有自己的内存空间。

- 多进程的优势:多进程不受GIL的限制,可以充分利用多个CPU核心,提高并行计算能力。

1.30.3.4 多进程加速NumPy计算

通过多进程可以显著提高NumPy代码的执行速度。

import numpy as np

import multiprocessing

import time# 生成100万个随机数的数组

data = np.random.rand(1000000) # 生成随机数数组# 多进程计算平方和

def sum_of_squares_process(data, start, end):result = np.sum(data[start:end] ** 2) # 计算部分数据的平方和return result# 划分数据

num_processes = 4

process_data_length = len(data) // num_processes# 使用进程池

with multiprocessing.Pool(processes=num_processes) as pool:results = pool.starmap(sum_of_squares_process, [(data, i * process_data_length, (i + 1) * process_data_length) for i in range(num_processes)])# 计算总和

total_sum_of_squares = np.sum(results) # 计算全部数据的平方和# 打印结果

print(f"多进程计算结果: {total_sum_of_squares}")

- 多进程函数:定义一个多进程函数计算部分数据的平方和。

- 数据划分:将数据划分为多个部分,每个部分由一个进程处理。

- 进程池:使用

multiprocessing.Pool创建进程池,分配任务并等待结果。 - 结果合并:计算各部分结果的总和。

1.30.4 分布式计算的Dask集成

Dask分布式矩阵乘法

import dask.array as da

from dask.distributed import Client# 创建Dask集群

client = Client(n_workers=4, threads_per_worker=2)# 生成分布式数组

x = da.random.random((50000, 50000), chunks=(5000, 5000))

y = da.random.random((50000, 50000), chunks=(5000, 5000))# 执行分布式计算

z = da.matmul(x, y)# 触发计算并获取结果

result = z.compute() # 自动分配至集群计算

分块算法原理

1.30.4.1 Dask的基本概念

Dask是一个用于并行计算的Python库,它可以扩展NumPy、Pandas等库,实现对大规模数据的处理。

- Dask的定义:Dask是一个用于并行计算的Python库,可以处理大规模数据。

- Dask的特点:Dask支持并行计算、分布式计算和延迟计算,可以与NumPy、Pandas等库无缝集成。

1.30.4.2 Dask与NumPy的集成

Dask提供了dask.array模块,可以与NumPy无缝集成,实现对大规模数据的高效处理。

import dask.array as da

import numpy as np

import time# 生成1亿个随机数的Dask数组

data = da.random.random((100000000,), chunks=1000000) # 生成随机数数组,分块处理# 计算平方和

start_time = time.time()

sum_of_squares = data ** 2 # 向量化计算平方

total_sum_of_squares = sum_of_squares.sum().compute() # 计算平方和

end_time = time.time()

dask_time = end_time - start_time

print(f"Dask计算时间: {dask_time}秒,结果: {total_sum_of_squares}")

- 生成Dask数组:使用

dask.array生成一个大规模的Dask数组,并指定分块大小。 - 向量化计算:使用Dask的向量化操作计算平方和。

- 计算结果:调用

compute()方法计算结果。 - 性能测试:通过计算时间验证Dask的性能优势。

1.30.4.3 分布式矩阵乘法实现

通过Dask可以实现分布式矩阵乘法,处理大规模矩阵数据。

import dask.array as da

import numpy as np

import time# 生成10000x10000的随机矩阵

matrix1 = da.random.random((10000, 10000), chunks=(1000, 1000))

matrix2 = da.random.random((10000, 10000), chunks=(1000, 1000))# 计算矩阵乘法

start_time = time.time()

result = da.dot(matrix1, matrix2).compute() # 计算矩阵乘法

end_time = time.time()

dask_time = end_time - start_time

print(f"Dask矩阵乘法计算时间: {dask_time}秒")# 生成同规模的NumPy矩阵

np_matrix1 = np.random.rand(10000, 10000)

np_matrix2 = np.random.rand(10000, 10000)# 计算矩阵乘法

start_time = time.time()

np_result = np.dot(np_matrix1, np_matrix2) # 计算矩阵乘法

end_time = time.time()

numpy_time = end_time - start_time

print(f"NumPy矩阵乘法计算时间: {numpy_time}秒")# 比较性能

print(f"性能提升比例: {numpy_time / dask_time}")

- 生成Dask矩阵:使用

dask.array生成两个大规模的Dask矩阵,并指定分块大小。 - 计算矩阵乘法:使用Dask的

dot方法计算矩阵乘法。 - 性能测试:生成同规模的NumPy矩阵,计算矩阵乘法并比较性能。

- 结果展示:通过计算时间比较两种方法的性能,Dask通常能显著提高大规模矩阵运算的效率。

1.30.5 性能剖析火焰图解读

1.30.5.1 性能剖析的基本概念

性能剖析(Profiling)是分析程序运行时性能的一种技术,通过性能剖析可以找出程序中的性能瓶颈。常见的性能剖析工具包括cProfile、line_profiler和yappi等。

- 性能剖析的定义:性能剖析是指对程序运行时的行为进行分析,以找出性能瓶颈。

- 性能剖析的目标:通过性能剖析,我们可以优化代码,提高程序的执行效率。

- 常用工具:

cProfile:Python内置的性能剖析工具,可以生成详细的性能报告。line_profiler:用于逐行性能剖析的工具,可以精确到每一行代码的执行时间。yappi:一个高效的性能剖析工具,支持多线程和多进程性能分析。

1.30.5.2 使用火焰图进行性能分析

火焰图是一种可视化工具,通过图形化的方式展示程序的性能剖析结果,帮助我们更直观地理解性能瓶颈。

- 火焰图的定义:火焰图是一种可视化工具,通过堆栈帧的形式展示程序的性能剖析结果。

- 火焰图的优势:火焰图可以清晰地展示函数调用的层次关系,以及每一层函数的执行时间,帮助我们快速定位性能瓶颈。

1.30.5.3 火焰图的解读技巧

解读火焰图需要理解其基本结构和颜色编码。

-

堆栈帧:

- 层次关系:火焰图从上到下展示函数调用的层次关系,每一层表示一个函数调用。

- 宽度:每个堆栈帧的宽度表示该函数的执行时间,宽度越大表示时间越长。

- 高度:堆栈帧的高度表示调用深度,越低的堆栈帧表示调用层次越深。

-

颜色编码:

- 颜色:火焰图的颜色编码可以表示不同的函数类型或执行时间。

- 常见颜色:

- 红色:表示执行时间较长的函数。

- 蓝色:表示执行时间较短的函数。

- 绿色:表示用户定义的函数。

-

查找热点:

- 热点函数:火焰图中最宽的堆栈帧表示热点函数,这些函数是性能优化的重点。

- 深度分析:点击火焰图中的堆栈帧可以查看更详细的函数调用信息。

1.30.5.4 生成火焰图

生成火焰图需要使用性能剖析工具和可视化工具。下面是一个使用cProfile和flamegraph生成火焰图的示例。

import cProfile

import pstats

from io import StringIO

import flamegraph# 定义一个示例函数

def example_function():data = np.random.rand(1000000)result = np.sum(data ** 2)return result# 使用cProfile进行性能剖析

pr = cProfile.Profile()

pr.enable()

example_function()

pr.disable()# 生成性能报告

s = StringIO()

ps = pstats.Stats(pr, stream=s).sort_stats('cumulative')

ps.print_stats()# 将性能报告转换为火焰图数据

profile_data = s.getvalue()

flamegraph_data = flamegraph.parse_profile(profile_data)# 生成火焰图

flamegraph.render(flamegraph_data, 'flamegraph.svg')

- 性能剖析:使用

cProfile对example_function进行性能剖析。 - 生成报告:将性能剖析结果输出到字符串流。

- 转换数据:使用

flamegraph库将性能报告转换为火焰图数据。 - 生成火焰图:将火焰图数据渲染为SVG文件。

1.30.5.5 火焰图应用示例

通过一个具体的示例,我们演示如何使用火焰图进行性能优化。

import numpy as np

import cProfile

import pstats

from io import StringIO

import flamegraph# 定义一个带有性能瓶颈的函数

def slow_function():data = np.random.rand(1000000)result = 0for x in data:result += x ** 2return result# 定义一个优化后的函数

def fast_function():data = np.random.rand(1000000)result = np.sum(data ** 2)return result# 使用cProfile进行性能剖析

pr = cProfile.Profile()

pr.enable()

slow_function()

pr.disable()# 生成性能报告

s = StringIO()

ps = pstats.Stats(pr, stream=s).sort_stats('cumulative')

ps.print_stats()# 将性能报告转换为火焰图数据

profile_data = s.getvalue()

flamegraph_data = flamegraph.parse_profile(profile_data)# 生成火焰图

flamegraph.render(flamegraph_data, 'slow_function_flamegraph.svg')# 测试优化后的函数

pr = cProfile.Profile()

pr.enable()

fast_function()

pr.disable()# 生成性能报告

s = StringIO()

ps = pstats.Stats(pr, stream=s).sort_stats('cumulative')

ps.print_stats()# 将性能报告转换为火焰图数据

profile_data = s.getvalue()

flamegraph_data = flamegraph.parse_profile(profile_data)# 生成火焰图

flamegraph.render(flamegraph_data, 'fast_function_flamegraph.svg')

- 性能剖析:分别对带性能瓶颈的

slow_function和优化后的fast_function进行性能剖析。 - 生成火焰图:生成两个函数的火焰图,比较性能差异。

1.30.5.6 火焰图的高级解读

火焰图不仅可以用于简单的性能分析,还可以用于更复杂的场景,如分布式系统和多线程程序。

- 分布式系统:在分布式系统中,火焰图可以展示不同节点上的性能瓶颈。

- 多线程程序:在多线程程序中,火焰图可以展示不同线程的执行时间和调用关系。

1.30.6 总结

通过本文的学习,我们掌握了NumPy代码优化的多种方法,包括向量化操作、JIT编译、多线程与多进程加速、Dask分布式计算以及性能剖析和火焰图解读。这些方法不仅能够显著提高代码的执行效率,还能使代码更加简洁易读。希望通过本文的介绍,您能够在实际项目中应用这些技术,提升程序的性能。

参考文献

| 序号 | 名称 | 链接 |

|---|---|---|

| 1 | NumPy官方文档 | NumPy官网 |

| 2 | Numba官方文档 | Numba官网 |

| 3 | Dask官方文档 | Dask官网 |

| 4 | Python cProfile库官方文档 | Python cProfile官方文档 |

| 5 | flamegraph工具官方文档 | FlameGraph GitHub |

| 6 | threading模块官方文档 | Python threading官方文档 |

| 7 | multiprocessing模块官方文档 | Python multiprocessing官方文档 |

| 8 | 全局解释器锁(GIL) | Python GIL Wikipedia |

| 9 | 并行计算的概念 | Parallel Computing |

| 10 | 计算机性能优化基礎 | Performance Optimization Basics |

| 11 | Python性能剖析指南 | Python Profiling Guide |

| 12 | 火焰图入门 | Introduction to Flame Graphs |

| 13 | 火焰图高级解读 | Advanced Flame Graphs Interpretation |

| 14 | NumPy性能优化技巧 | NumPy Performance Optimization |

| 15 | Dask性能优化文档 | Dask Performance Optimization |

这篇文章包含了详细的原理介绍、代码示例、源码注释以及案例等。希望这对您有帮助。如果有任何问题请随私信或评论告诉我。