CentOS 7 基于1 Panel面板安装 JumpServer 堡垒机

- 一、前言

- 二、设备要求

- 三、环境要求

- 四、安装

- 4.1 环境安装

- 4.2 JumpServer安装

- 4.3 访问JumpServerWeb端,进行登录

- 五、登录Web控制台

一、前言

JumpServer是广受欢迎的开源堡垒机。运维必备神器!JumpServer 支持事前授权、事中监察、事后审计,满足等保合规要求。本篇文章记录如何在CentOS 7上基于1 Panel面板安装 JumpServer 堡垒机。

飞致云官网:JumpServer-开源堡垒机

1 Panel面板安装参照:最新-CentOS 7安装1 Panel Linux 服务器运维管理面板

二、设备要求

三、环境要求

四、安装

安装JumpServer 之前,如果是使用离线安装的1 Panel面板,请先使用以下命令安装最新版docker-compose。

# 自动下载最新的稳定版

sudo curl -L "https://github.com/docker/compose/releases/latest/download/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

# 确保 docker-compose 文件有执行权限

sudo chmod +x /usr/local/bin/docker-compose

# 检查版本,确保更新成功

docker-compose --version

4.1 环境安装

MySQL安装

根据以下图片中的步骤进行安装MySQL数据库,除注明参数之外可任意设置。

Redis安装

根据以下图片中的步骤进行安装Redis数据库,除注明参数之外可任意设置。

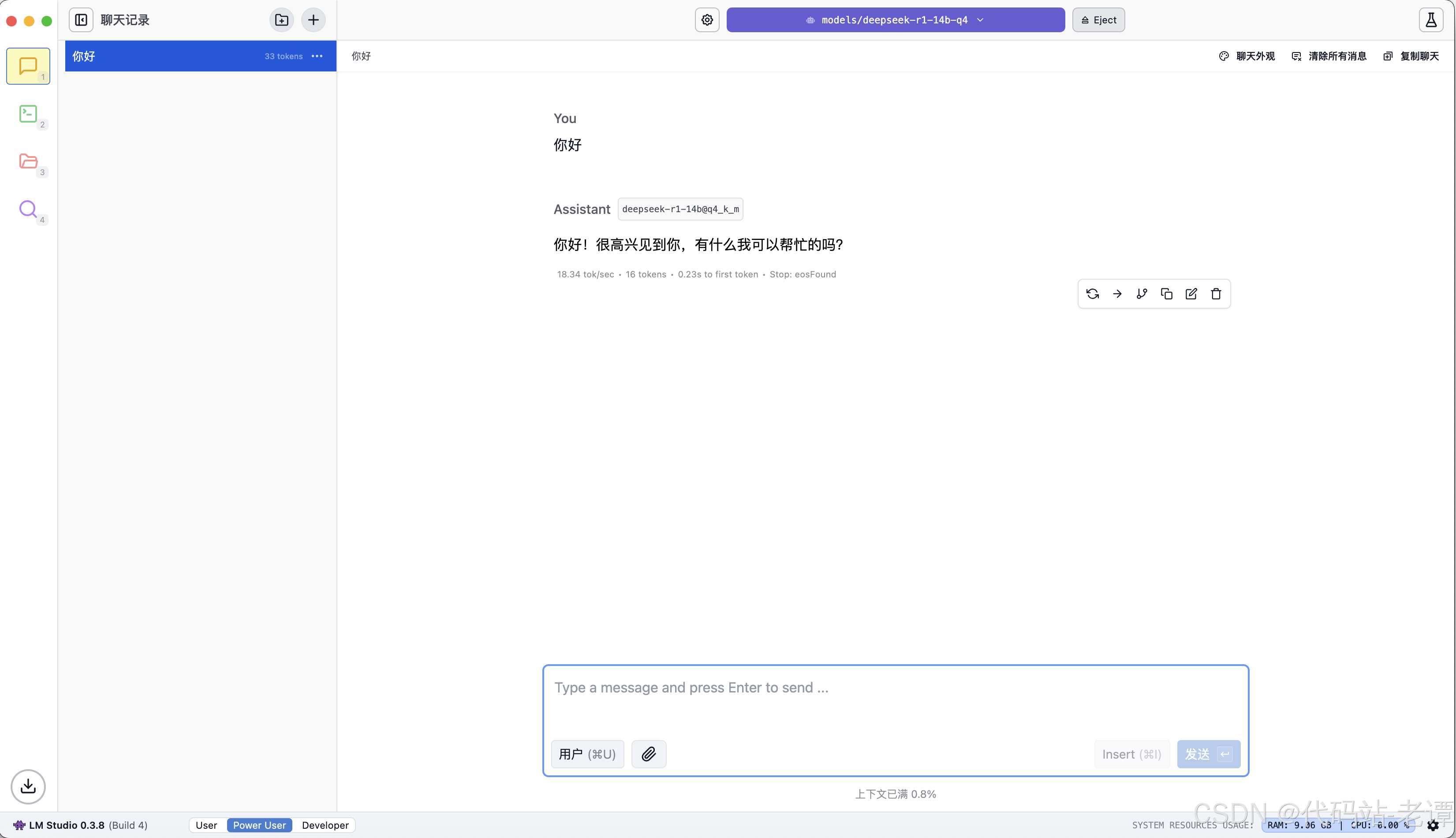

4.2 JumpServer安装

应用商店->更多->安全

点击JumpServer的安装按钮,勾选端口外部访问,确认。

安装完成

4.3 访问JumpServerWeb端,进行登录

在浏览器中输入IP地址+端口号访问JumpServerWeb端,我这里是192.168.230.128:8080(默认8080)。

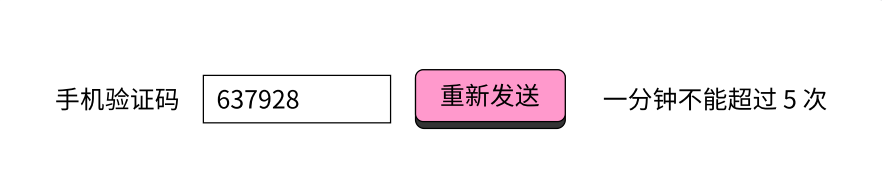

首次登录用户名:admin

密码:v3 版本默认密码为 admin,v4 版本默认密码为 ChangeMe。

我这里是v4版本。

按下回车键,发现报错,复制DOMAINS字段的值(也就是IP地址:端口号),返回1 Panel面板。

在应用商店->已安装->JumpServer->参数->编辑

将复制的DOMAINS字段的值(也就是IP地址:端口号)粘贴至DOMAINS内,点击确认。

首次登录成功之后,需要重置密码。

五、登录Web控制台

输入新设置的密码登录。

登录成功