文章目录

- 前言

- 第一部分:STM32-HAL库

- HAL库编程

- 优势

- 1.抽象层

- 2.易于上手

- 3.代码可读性

- 4.跨平台性

- 5.维护和升级

- 6.中间件支持

- 劣势

- 1.性能

- 2.灵活性

- 3.代码大小

- 4.复杂性

- 直接寄存器操作编程

- 优势

- 1.性能

- 2.灵活性

- 3.代码大小

- 4.学习深度

- 劣势

- 1.复杂性

- 2.可读性

- 3.可维护性

- 4.跨平台性

- 总结

- 第二部分:STM32内部、外部时钟

- 内部时钟

- 1.RC振荡器(HSE)

- 2.精准内部振荡器(LSI)

- 3.系统振荡器(MSI)

- 外部时钟

- 1.晶振/陶瓷谐振器(HSE)

- 2.外部时钟输入(HSE bypass)

- 时钟系统特点

- 1.稳定性和精度

- 2.系统启动

- 3.灵活性

- 4.时钟树

- 第三部分:STM32主频&锁相环&分频器

- STM32的主频

- 1.主频范围

- 2.时钟源

- 锁相环(PLL)

- PLL的工作原理

- 1.输入

- 2.倍频

- 3.分频

- 4.相位锁定

- PLL配置

- 1.预分频器

- 2.倍频因子

- 3.系统时钟分频器

- 分频器

- 分频器类型

- 1.AHB分频器

- 2.APB分频器

- 3.其他分频器

- 分频器设置

- 示例配置

- 总结

前言

以上就是今天要讲的内容,本文简单介绍了STM32的HAL库、内外部时钟、微控制器主频、锁相环PPL、分频器相关知识。

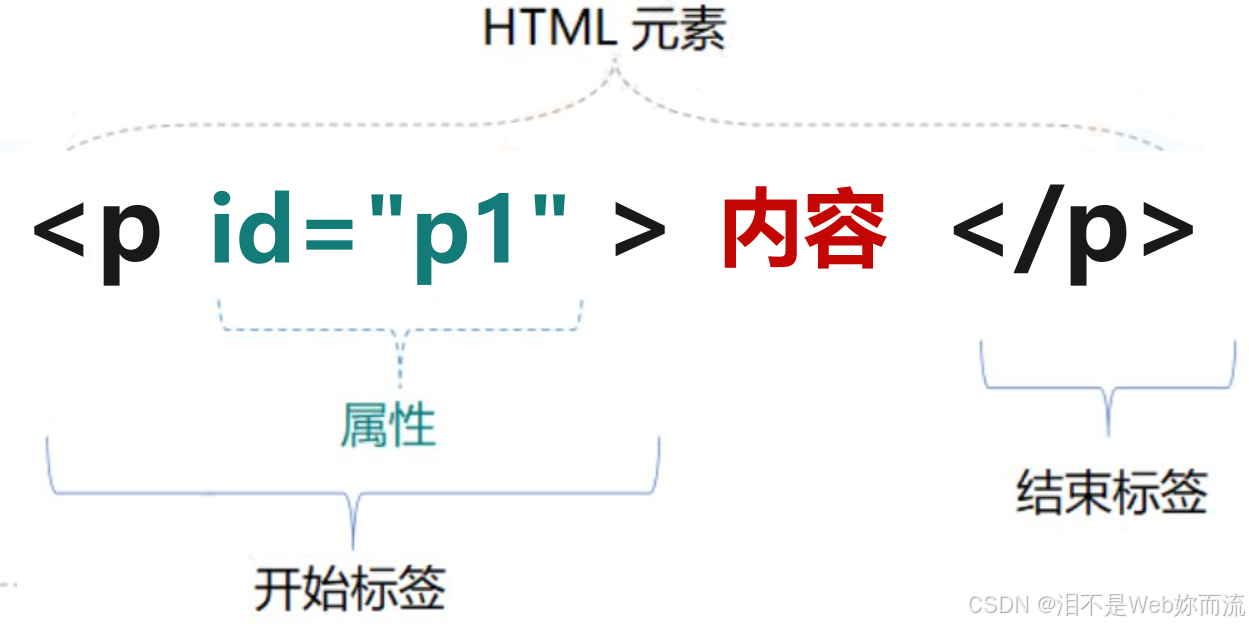

第一部分:STM32-HAL库

STM32的HAL(Hardware Abstraction Layer)库是由ST公司提供的一套中间件,用于简化STM32微控制器的编程。除了HAL库之外,另一种常见的编程方法是直接使用寄存器操作,也称为**“裸机编程”或“寄存器级编程”**。以下是两种方法的优缺点详细解释:

HAL库编程

优势

1.抽象层

抽象层:

HAL库提供了一套硬件抽象层,使得开发者不需要直接操作硬件寄存器,降低了编程复杂度。

2.易于上手

易于上手:

对于初学者或需要快速开发的工程师来说,HAL库更容易上手。

3.代码可读性

代码可读性:

HAL库函数通常具有自解释的名称,提高了代码的可读性。

4.跨平台性

跨平台性:

使用HAL库编写的代码可以在不同的STM32系列之间轻松迁移。

5.维护和升级

维护和升级:

ST公司定期更新HAL库,修复bug并增加新功能,使得维护和升级更为方便。

6.中间件支持

中间件支持:

HAL库通常与ST提供的其他中间件(如RTOS、USB、Ethernet等)集成良好。

劣势

1.性能

性能:

HAL库可能会引入额外的开销,导致性能不如直接操作寄存器。

2.灵活性

灵活性:

HAL库提供的抽象可能会限制对硬件的某些高级操作。

3.代码大小

代码大小:

HAL库可能会增加最终程序的代码大小,对于资源有限的微控制器来说可能是个问题。

4.复杂性

复杂性:

对于简单的应用,HAL库可能显得过于复杂,增加了不必要的代码和配置。

直接寄存器操作编程

优势

1.性能

性能:

直接操作寄存器可以编写出性能最优的代码,因为没有额外的抽象层开销。

2.灵活性

灵活性:

开发者可以完全控制硬件的每一个细节,实现更精细的操作。

3.代码大小

代码大小:

直接操作寄存器通常可以生成更小的代码,节省存储空间。

4.学习深度

学习深度:

通过直接操作寄存器,开发者可以更深入地理解微控制器的内部工作原理。

劣势

1.复杂性

复杂性:

直接操作寄存器需要开发者对硬件有深入的了解,编程难度较高。

2.可读性

可读性:

寄存器操作的代码可能不如HAL库代码直观,可读性较差。

3.可维护性

可维护性:

由于代码更接近硬件,维护和升级可能会更加困难。

4.跨平台性

跨平台性:

直接操作寄存器的代码通常不具备跨平台性,迁移到不同的STM32系列可能需要大量修改。

总结

选择HAL库编程还是直接寄存器操作编程,取决于项目的具体需求、开发者的经验以及对性能和资源的要求。对于大多数应用,HAL库提供了足够的性能和方便的接口,适合快速开发和维护。而对于那些对性能和资源有极端要求的应用,直接操作寄存器可能是更好的选择。在实际开发中,开发者也可能会结合使用这两种方法,以实现最佳的开发效率和性能。

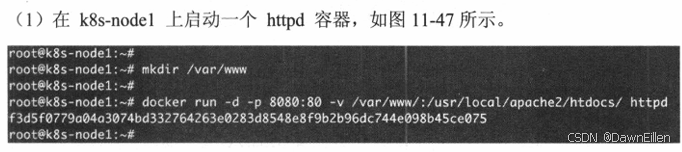

第二部分:STM32内部、外部时钟

STM32微控制器支持多种时钟源,以供系统时钟(SYSCLK)使用。这些时钟源可以分为两大类:内部时钟和外部时钟。

内部时钟

1.RC振荡器(HSE)

高速内部时钟(HSI):

HSI是一个内部RC振荡器,通常频率为16 MHz。

它不需要外部时钟元件,因此可以降低成本和电路复杂性。

HSI的精度相对较低,通常在1%左右,但在某些STM32系列中,可以通过内部校准提高精度。

2.精准内部振荡器(LSI)

低速内部时钟(LSI):

LSI是一个低功耗、低精度的RC振荡器,通常用于实时时钟(RTC)或者其他对时钟精度要求不高的应用。

频率一般在32 kHz左右。

3.系统振荡器(MSI)

多速内部时钟(MSI):

MSI是一个可编程的内部RC振荡器,可以在多种频率下工作,通常范围在65 kHz到4 MHz之间。

它的精度可以通过软件校准来提高。

MSI特别适用于低功耗应用,因为它可以在低频率下工作,从而降低功耗。

外部时钟

1.晶振/陶瓷谐振器(HSE)

高速外部时钟(HSE):

HSE是一个外部时钟源,可以通过连接一个晶振或陶瓷谐振器到HSE引脚来使用。

它可以提供更高的精度,通常在几十ppm(百万分之几十)。

频率范围通常在4 MHz到32 MHz之间。

2.外部时钟输入(HSE bypass)

外部时钟输入:

HSE也可以通过外部时钟信号直接输入,这称为HSE bypass模式。

在这种模式下,外部时钟源可以是另一个微控制器的时钟输出、时钟发生器等。

时钟系统特点

1.稳定性和精度

内部时钟:通常精度较低,但无需外部元件,成本较低。

外部时钟:通常精度较高,但需要**外部晶振或谐振器,**成本相对较高。

2.系统启动

在系统启动时,STM32通常会使用**HSI(高速内部时钟)**作为默认时钟源,随后可以通过软件配置切换到其他时钟源。

3.灵活性

STM32的时钟系统非常灵活,允许在运行时动态地改变时钟配置,以适应不同的运行模式,比如低功耗模式或高性能模式。

4.时钟树

STM32具有复杂的时钟树,可以通过多个PLL(锁相环)和分频器来生成多个时钟,用于不同的外设和内核。

选择使用内部时钟还是外部时钟,取决于具体的应用需求,如精度、成本、功耗和电路复杂性等因素。通常,对于精度要求高的应用,如通信系统,会使用外部时钟源;而对于成本敏感或低功耗的应用,内部时钟源可能是更好的选择。

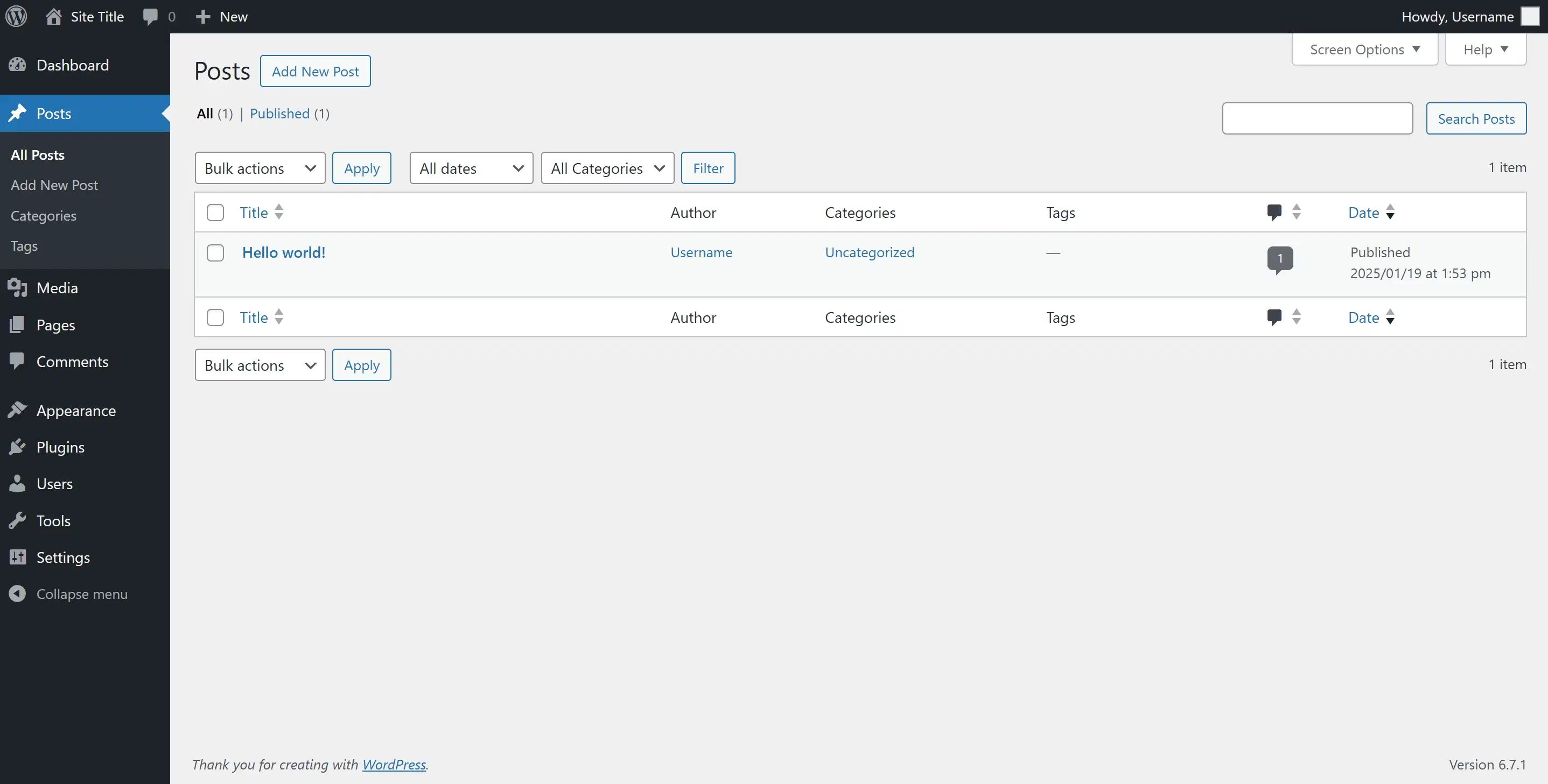

第三部分:STM32主频&锁相环&分频器

STM32的主频

主频是指微控制器(MCU)的中央处理单元(CPU)的时钟频率,它决定了CPU执行指令的速度。STM32微控制器的主频可以通过多种方式配置,以下是一些关键点:

1.主频范围

STM32系列微控制器的主频范围很广,从几MHz到几百MHz不等,具体取决于所使用的STM32型号。

例如,STM32F0系列的主频最高可达48 MHz,而STM32H7系列的主频可以高达400 MHz。

2.时钟源

主频的来源可以是内部时钟源(如HSI、MSI)或外部时钟源(如HSE)。

主频也可以通过锁相环(PLL)来倍频,以获得更高的CPU操作速度。

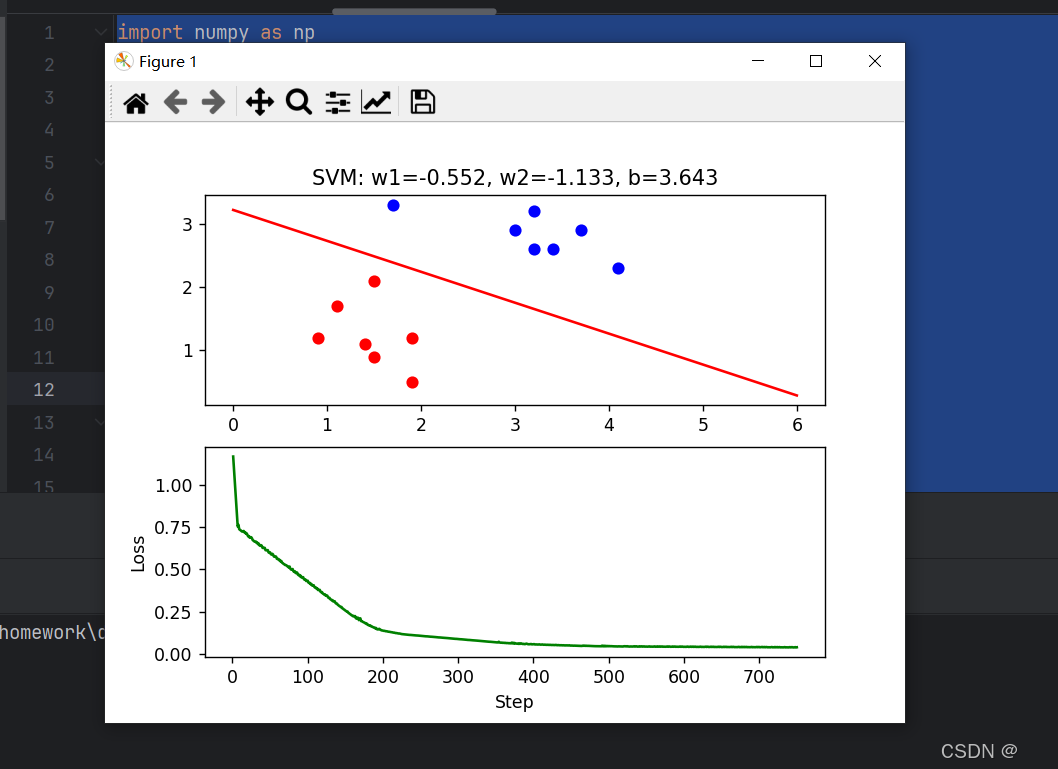

锁相环(PLL)

锁相环(PLL)是一种反馈控制系统,它能够生成一个频率和相位与输入信号同步的输出信号。在STM32中,PLL用于提高时钟频率。

PLL的工作原理

1.输入

输入:PLL通常接收来自**内部或外部时钟源(如HSI、HSE)**的信号作为输入。

2.倍频

倍频:通过PLL的倍频器,可以将输入频率乘以一个整数(称为PLL倍频因子),以获得更高的输出频率。

3.分频

分频:在倍频之后,输出频率可以被一个分频器分频,以获得所需的频率。

4.相位锁定

相位锁定:PLL内部有一个相位-频率检测器(PFD),它比较输入信号和输出信号的相位和频率,通过反馈环路调整VCO(压控振荡器)的频率,使得输出信号的相位和频率与输入信号同步。

PLL配置

STM32的PLL配置通常通过时钟配置寄存器来完成,可以设置以下参数:

1.预分频器

预分频器(PREDIV):对输入时钟进行预分频,以降低VCO的工作频率。

2.倍频因子

倍频因子(M):设置PLL的倍频倍数。

3.系统时钟分频器

系统时钟分频器(N):对PLL的输出进行分频,以得到系统时钟(SYSCLK)。

分频器

分频器用于降低时钟频率,它在STM32的时钟系统中扮演着重要角色。

分频器类型

1.AHB分频器

AHB分频器:用于生成AHB总线时钟(HCLK),这个时钟用于大部分外设和内存。

2.APB分频器

APB分频器:进一步分频AHB时钟,生成APB1和APB2时钟,这些时钟用于低速外设。

3.其他分频器

其他分频器:例如,为特定的外设(如USB、SDIO)提供特定频率的时钟。

分频器设置

分频器的配置通常通过时钟控制寄存器来完成。

分频因子通常是2的幂,例如,1、2、4、8等,具体取决于微控制器的型号。

示例配置

以下是一个STM32时钟配置的简化示例:

- HSE(外部晶振)作为时钟源,频率为8 MHz。

- PLL配置:

预分频器(PREDIV)设置为1,因此VCO的输入频率为8 MHz。

倍频因子(M)设置为9,因此VCO的输出频率为72 MHz。

系统时钟分频器(N)设置为1,因此PLL的输出频率(即系统时钟(SYSCLK))为72 MHz。

AHB分频器设置为1,因此HCLK也为72 MHz。

APB1分频器设置为2,因此PCLK1(APB1时钟)为36 MHz。

APB2分频器设置为1,因此PCLK2(APB2时钟)为72 MHz。

这样的配置可以确保CPU和各个外设以适当的频率运行,以满足应用需求。需要注意的是,具体的寄存器配置和可用的分频因子会根据不同的STM32系列和型号有所不同。

总结

以上就是今天要讲的内容,本文仅仅简单介绍了STM32的HAL库、内外部时钟、微控制器主频、锁相环PPL、分频器相关知识。