目录

一、网络爬虫的概念和应用

二、Jsoup库的功能和优势

三、使用Java与Jsoup库编写网络爬虫

四、网络爬虫的法律和道德问题

五、注意事项

六、总结

本文将深入探讨如何使用Java与Jsoup库构建一个实际且有趣的网络爬虫项目。我们将首先简要介绍网络爬虫的概念和应用,然后详细介绍Jsoup库的功能和优势。接着,我们将通过一个具体的案例——爬取某网站的图片链接,展示如何使用Java与Jsoup库编写网络爬虫程序,并附上完整的代码。最后,我们将讨论网络爬虫的法律和道德问题,并提出一些建议。

一、网络爬虫的概念和应用

网络爬虫是一种自动抓取互联网信息的程序,它们按照一定规则,自动访问并抓取网页信息。网络爬虫在许多领域都有广泛应用,如搜索引擎、数据挖掘、价格监控等。对于企业和研究人员,网络爬虫是获取大量数据、分析竞争对手、进行市场调研的重要工具。

二、Jsoup库的功能和优势

Jsoup是一个用于处理HTML的Java库。它提供了非常便利的API,用于提取和操作数据,使用的是类似于jQuery的DOM方法。Jsoup的主要优势在于其强大的HTML解析和操作能力,以及简单易用的API。

三、使用Java与Jsoup库编写网络爬虫

接下来,我们将通过一个具体的案例——爬取某网站的图片链接,来演示如何使用Java与Jsoup库编写网络爬虫。

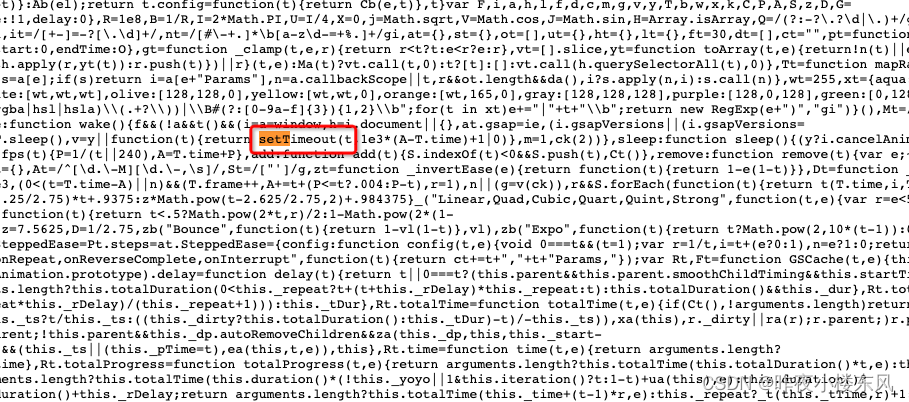

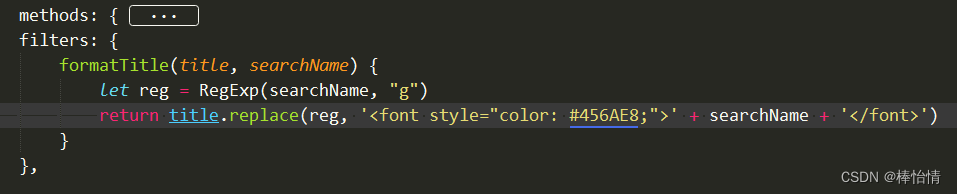

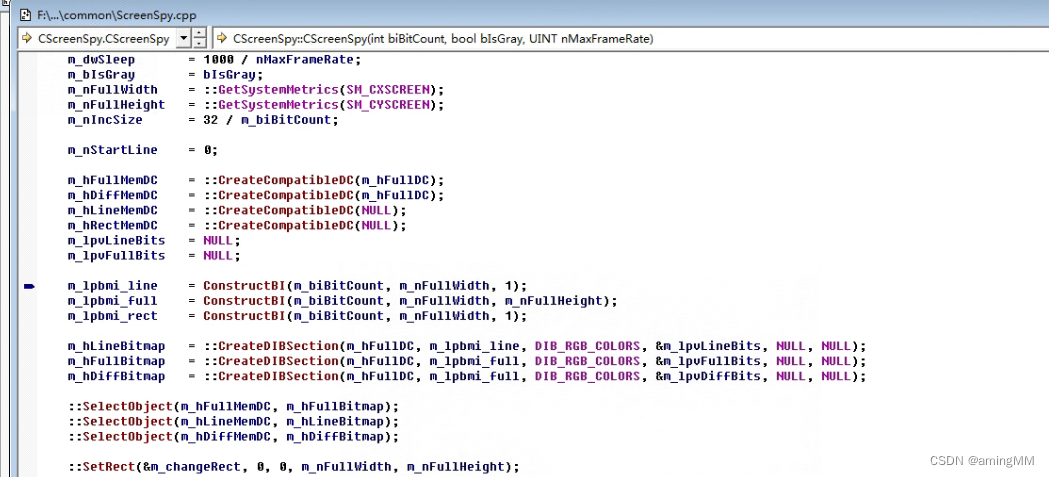

首先,我们需要引入Jsoup库。如果你使用Maven,可以在pom.xml文件中添加以下依赖:

<dependencies> <dependency> <groupId>org.jsoup</groupId> <artifactId>jsoup</artifactId> <version>1.14.2</version> <!-- 版本号可能会有更新,请检查最新版本 --> </dependency>

</dependencies>然后,我们可以编写爬虫程序:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements; import java.io.IOException; public class ImageCrawler { public static void main(String[] args) { String url = "https://example.com"; // 目标网站URL try { Document doc = Jsoup.connect(url).get(); // 连接网站并获取HTML文档 Elements imgElements = doc.select("img"); // 使用CSS选择器选择所有的图片元素 for (Element img : imgElements) { String imgUrl = img.absUrl("src"); // 获取图片的URL System.out.println(imgUrl); // 输出图片URL } } catch (IOException e) { e.printStackTrace(); } }

}

在上述代码中,我们首先指定了目标网站的URL,然后使用Jsoup.connect(url).get()方法连接网站并获取HTML文档。然后,我们使用CSS选择器doc.select("img")选择所有的图片元素。最后,我们遍历每个图片元素,获取其URL并输出。

四、网络爬虫的法律和道德问题

在编写和运行网络爬虫时,我们必须注意法律和道德问题。首先,我们需要遵守网站的robots.txt文件,这是一个用于指示爬虫如何访问网站的标准。其次,我们需要尊重用户的隐私和数据,不能爬取和使用用户的私人信息。此外,我们需要遵守版权法,不能随意使用和分发爬取到的内容。为了避免这些问题,我们应在法律和道德的框架内使用网络爬虫。

五、注意事项

在使用Java与Jsoup库进行网络爬虫编写时,以下是一些注意事项:

- 遵守网站规则:在爬取网站数据前,确保你已经阅读并理解网站的

robots.txt文件,遵循其中的规则,避免对网站正常运营造成影响。 - 设置合理的爬取速率:爬取速率过快可能会导致目标服务器的压力过大,甚至可能被视为攻击行为。因此,你需要设置合理的爬取速率,保证爬虫在获取数据的同时,不会对目标服务器产生过大的负担。

- 处理反爬虫机制:很多网站都有反爬虫机制,例如IP封锁、验证码等。你需要对这些机制有所预期,并准备相应的对策,例如使用代理IP、识别并处理验证码等。

- 数据清洗和处理:爬取的数据可能包含大量无用或重复的信息,需要进行清洗和处理,提取出真正需要的数据。同时,要注意数据的格式和编码,确保数据的准确性和完整性。

- 错误处理和日志记录:网络爬虫在运行过程中可能会遇到各种错误,如网络中断、数据格式错误等。要编写有效的错误处理代码,避免程序因错误而停止。同时,记录详细的日志,有助于查找和解决问题。

- 尊重隐私和版权:在爬取和使用数据时,要尊重隐私权和版权,不要爬取和使用私人或敏感信息,遵守相关的法律法规。

以上就是在使用Java与Jsoup库进行网络爬虫编写时需要注意的事项。总的来说,编写网络爬虫需要细心和耐心,也需要遵守相应的规则和法律法规,以确保数据的获取和使用都是合法和正当的。

六、总结

本文通过实际案例展示了如何使用Java和Jsoup库编写网络爬虫。我们不仅介绍了网络爬虫和Jsoup的基础知识,也讨论了如何在实际案例中应用这些知识。最后,我们还提出了网络爬虫面临的法律和道德问题,提醒大家在使用网络爬虫时要遵守相关规定,尊重他人权益。希望这篇文章能帮助你更好地理解和使用网络爬虫。