目录

一、引言

二、Scrapy框架概述

1、Scrapy框架特点

2、Scrapy框架结构

三、Scrapy框架的使用

1、安装Scrapy框架

2、创建Scrapy项目

3、创建爬虫

4、运行爬虫

四、Scrapy框架常见问题及解决方案

1、请求被网站封禁

2、处理动态加载的页面

3、避免被网站检测到爬虫行为

4、爬虫速度过快导致被封禁

五、案例分析:使用Scrapy框架抓取链家网房源信息

1、确定目标网站

2、分析页面结构

3、创建爬虫文件

4、定义请求规则和中间件

5、提取数据

6、定义数据存储规则

7、代码示例

六、总结与展望

一、引言

在当今的数字化时代,网络数据抓取已成为许多领域的重要工具。其中,Python语言凭借其强大的功能性和丰富的库资源,在网络爬虫领域中占据了举足轻重的地位。Scrapy框架是Python中一个功能强大的爬虫框架,它提供了简单易用的API,使得开发者能够快速构建高效的爬虫程序。本文将详细介绍Scrapy框架的基本原理、使用方法和常见问题解决方案,帮助读者更好地理解和应用Scrapy进行数据抓取。

二、Scrapy框架概述

1、Scrapy框架特点

Scrapy框架具有以下特点:易用性、灵活性、可扩展性、速度快、易维护等。它提供了丰富的中间件和插件,支持各种数据抓取任务,并可轻松地与其他库集成。

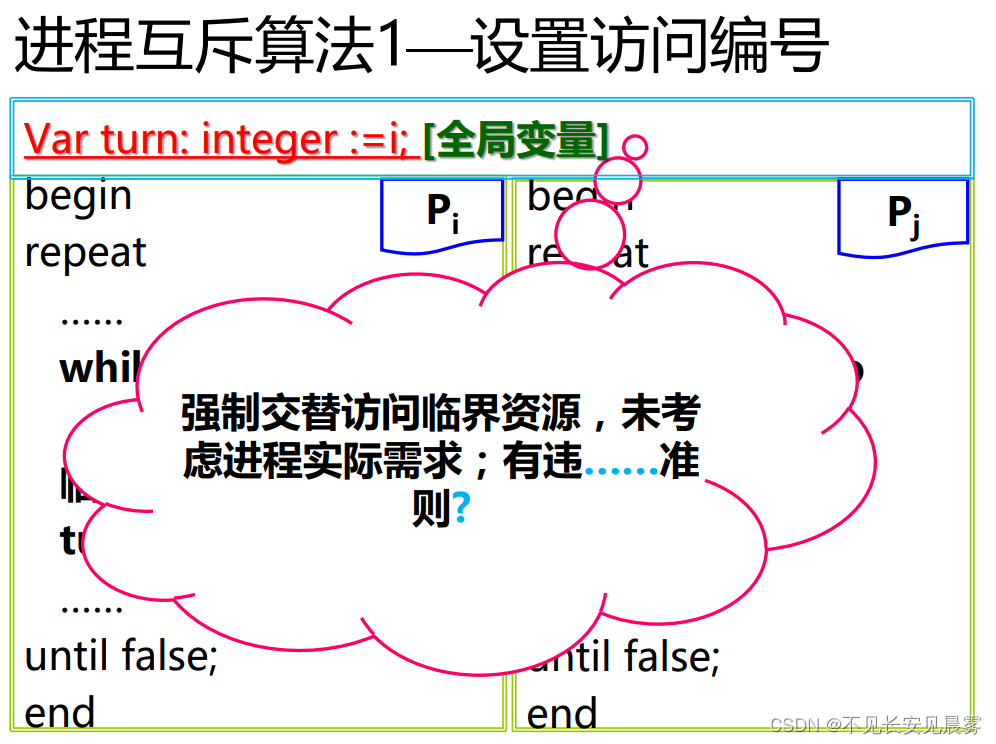

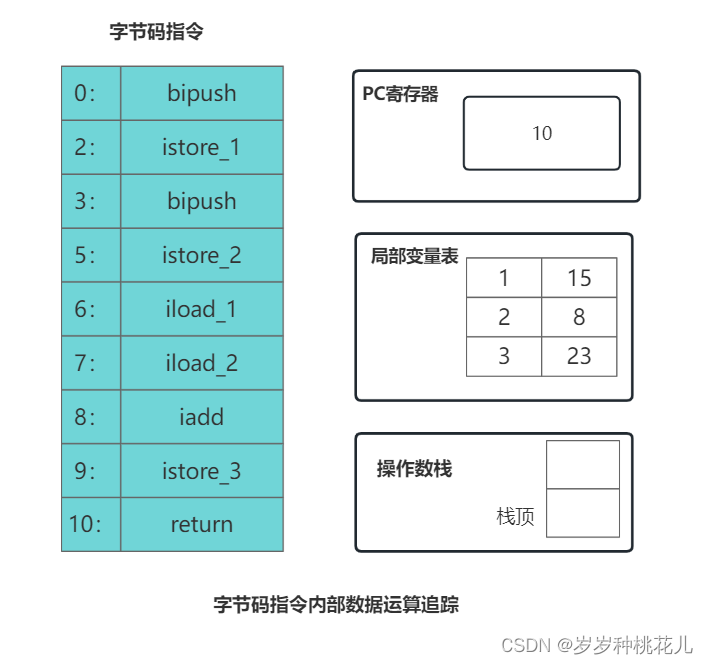

2、Scrapy框架结构

Scrapy框架主要由以下几个组件组成:引擎(Engine)、调度器(Scheduler)、下载器(Downloader)、爬虫(Spider)等。各组件之间通过事件流的方式进行通信,协同完成数据抓取任务。

三、Scrapy框架的使用

1、安装Scrapy框架

Scrapy框架可以通过pip命令进行安装,打开终端并输入以下命令即可完成安装:

pip install scrapy2、创建Scrapy项目

使用Scrapy框架创建项目非常简单,只需在终端中输入以下命令:

scrapy startproject myproject这将在当前目录下创建一个名为myproject的Scrapy项目。

3、创建爬虫

在Scrapy项目中,爬虫是一个重要的组件,用于解析网页并提取数据。在myproject目录下创建一个名为myspider的爬虫文件:

cd myproject

scrapy genspider myspider example.com这将生成一个名为myspider的爬虫文件,并指定要抓取的网站为example.com。在myspider文件中,我们可以定义各种方法来提取数据。例如,在parse方法中可以定义要抓取的页面和提取的数据。此外,还可以使用XPath或CSS选择器等来提取数据。

4、运行爬虫

在终端中回到myproject目录下,输入以下命令运行爬虫:

scrapy crawl myspider这将启动Scrapy框架并开始运行爬虫。Scrapy框架将按照预先定义好的规则自动处理请求和响应,并将解析后的数据传递给爬虫进行提取。一旦数据提取完成,Scrapy框架将自动将数据保存到指定的位置。

四、Scrapy框架常见问题及解决方案

1、请求被网站封禁

有些网站可能会封禁来自Scrapy的请求。解决此问题的方法之一是在请求头中添加User-Agent信息,模拟成正常浏览器用户发送请求。在Scrapy中可以通过设置Request对象的headers属性来实现:

request.headers['User-Agent'] = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

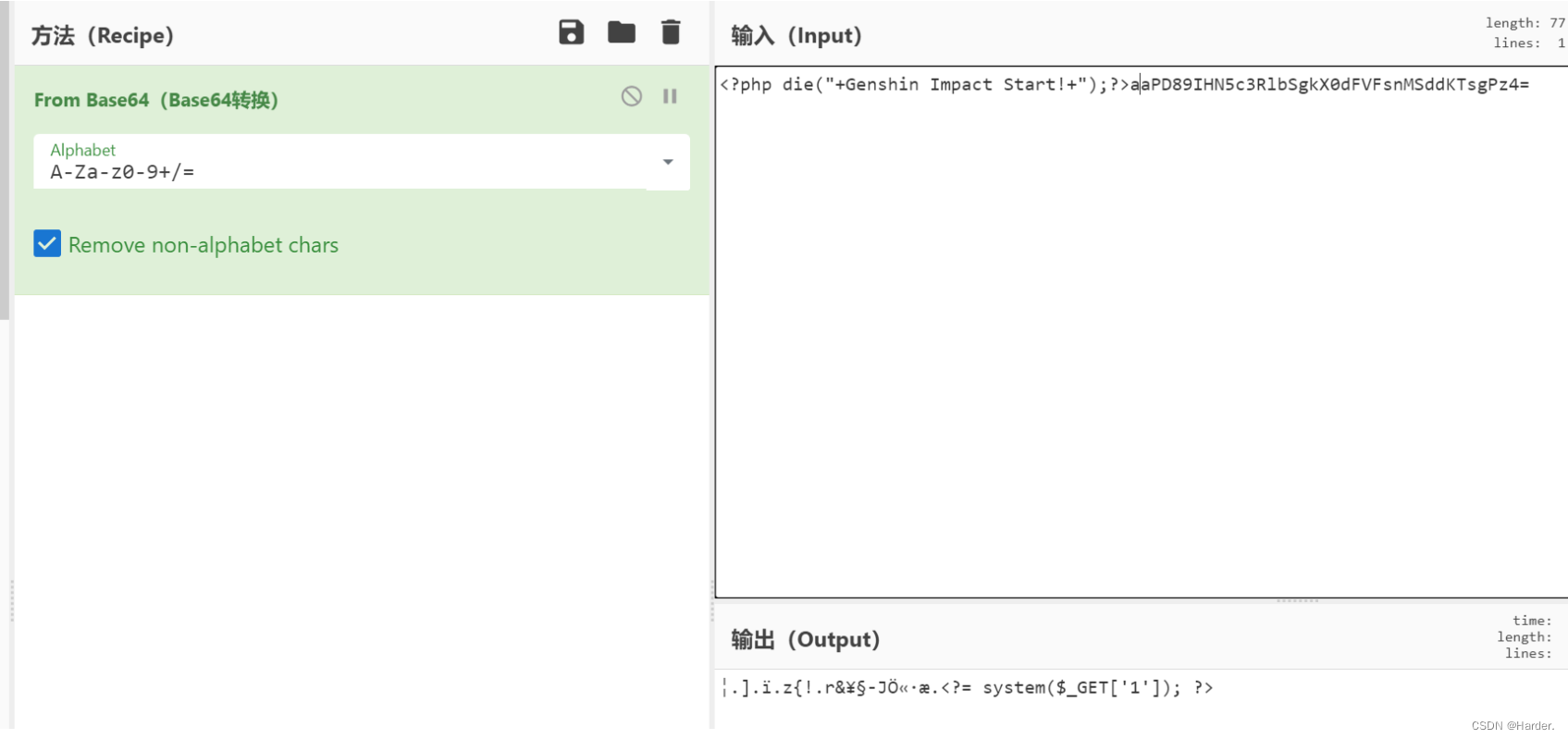

2、处理动态加载的页面

有些网站使用JavaScript动态加载数据,这使得直接抓取网页的方法无法获取完整的页面内容。为了处理这种情况,可以使用Scrapy的Selenium插件或Splash中间件来模拟浏览器行为,从而获取动态加载的数据。

3、避免被网站检测到爬虫行为

有些网站可能会检测到来自Scrapy的请求,并采取措施阻止爬虫访问。为了避免这种情况,可以在请求头中添加一些随机化的参数,如User-Agent、Referer等。此外,还可以使用Scrapy的Random User Agent插件或设置User-Agent池来生成随机User-Agent。

4、爬虫速度过快导致被封禁

有些网站可能会封禁爬虫速度过快的IP地址。为了解决这个问题,可以使用Scrapy的Rate限制中间件来限制爬虫的请求速度。此外,还可以使用代理IP或使用分布式爬虫来分散爬虫请求的压力。

五、案例分析:使用Scrapy框架抓取链家网房源信息

为了更好地说明Scrapy框架的使用,我们以抓取链家网房源信息为例进行详细分析。

1、确定目标网站

首先,我们需要确定要抓取的目标网站,即链家网。打开链家网并找到需要抓取的房源页面。

2、分析页面结构

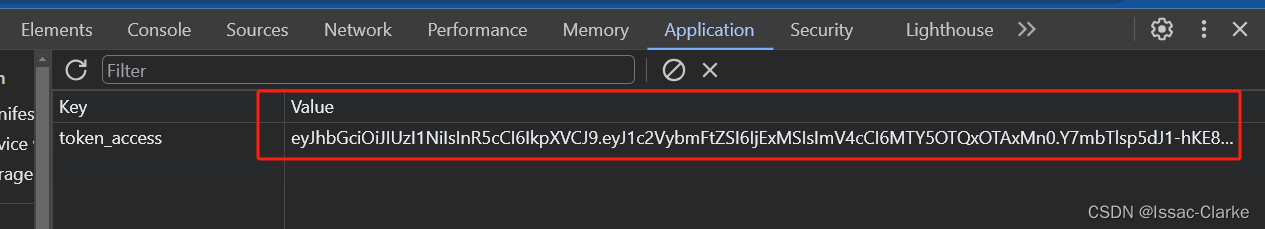

使用Chrome浏览器开发者工具来分析页面结构。在页面上右键单击并选择“检查”选项,即可看到页面的HTML结构和CSS样式。通过分析页面结构,我们可以确定需要抓取的数据所在的HTML标签和属性。

3、创建爬虫文件

在Scrapy项目中创建一个名为“lianjia”的爬虫文件。在该文件中,我们需要定义各种方法和设置,以实现数据抓取任务。

4、定义请求规则和中间件

在爬虫文件中定义请求规则和中间件,以实现数据的抓取任务。请求规则用于指定要抓取的URL地址和请求方法,而中间件则用于处理请求和响应,如添加请求头、处理重定向等。

5、提取数据

在爬虫文件中使用XPath或CSS选择器等选择器来提取数据。通过定义parse方法并使用选择器来提取需要的数据,并将其保存在item字段中。在本例中,我们需要提取房源的标题、价格、面积等信息。

6、定义数据存储规则

最后,我们需要定义数据存储规则,以将抓取的数据保存到指定的位置。在本例中,我们将数据保存到CSV文件中。在Scrapy框架中,可以使用Pipeline组件来实现数据存储功能。在爬虫文件中定义一个Pipeline类,实现数据存储功能,并在settings.py文件中启用该Pipeline。

7、代码示例

# -*- coding: utf-8 -*-

import scrapy

from scrapy.selector import Selector

from scrapy.http import Request

from scrapy.spider import BaseSpider

from lianjia.items import LianJiaItem class LianJiaSpider(BaseSpider): name = 'lianjia' allowed_domains = ['lianjia.com'] start_urls = ['http://www.lianjia.com/city/'] def parse(self, response): # 获取当前页面的所有房源URL urls = response.xpath('//div[@class="list-title"]/a/@href').extract() for url in urls: yield Request(response.urljoin(url), self.parse_房源) def parse_房源(self, response): # 使用XPath选择器提取房源信息 sel = Selector(response) item = LianJiaItem() item['标题'] = sel.xpath('//div[@class="list-info"]/h1/text()').extract()[0] item['价格'] = sel.xpath('//div[@class="list-info"]/span[2]/text()').extract()[0] item['面积'] = sel.xpath('//div[@class="list-info"]/span[3]/text()').extract()[0] return item

在这个示例中,我们创建了一个名为“LianJiaSpider”的爬虫类,并定义了两个方法:parse和parse_房源。parse方法用于获取当前页面的所有房源URL,并将每个URL传递给parse_房源方法进行解析。parse_房源方法使用XPath选择器提取房源信息,并将提取的数据保存在LianJiaItem对象中。

最后,我们将LianJiaItem对象返回给调用者。请注意,在此示例中,我们假设页面结构是固定的,因此使用XPath选择器提取数据的方式可能不适用于所有页面。如果需要抓取的页面结构发生变化,我们需要相应地修改代码。

六、总结与展望

本文介绍了Scrapy框架的基本原理、使用方法和常见问题解决方案,并通过案例分析的方式详细阐述了如何使用Scrapy框架抓取链家网房源信息。Scrapy框架具有易用性、灵活性和可扩展性等优点,是进行网络数据抓取的理想工具。

在未来的工作中,我们可以继续深入学习Scrapy框架的高级功能和技术,如使用Scrapy-Redis实现分布式爬虫等,以提高数据抓取的效率和稳定性。同时,我们也需要遵守网站的爬虫规则和法律法规,以合法的方式进行数据抓取任务。