使用Java API操作HDFS,是在安装和配置Maven、IDEA中配置Maven成功情况下进行的,如果Maven安装和配置不完全将不能进行Java API操作HDFS。

由于Hadoop是使用Java语言编写的,因此可以使用Java API操作Hadoop文件系统。使用HDFS提供的Java API构造一个访问客户端对象,然后通过客户端对象对HDFS上的文件进行操作(增、删、改、查)。

可以使用单元测试法操作HDFS。这里不使用单元测试法。

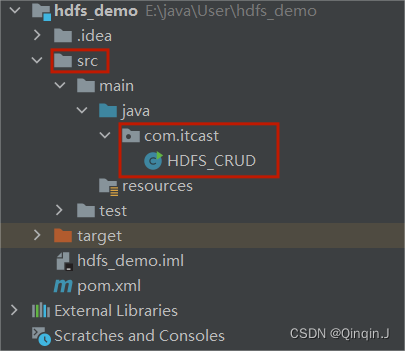

一、创建HDFS_CRUD.java文件

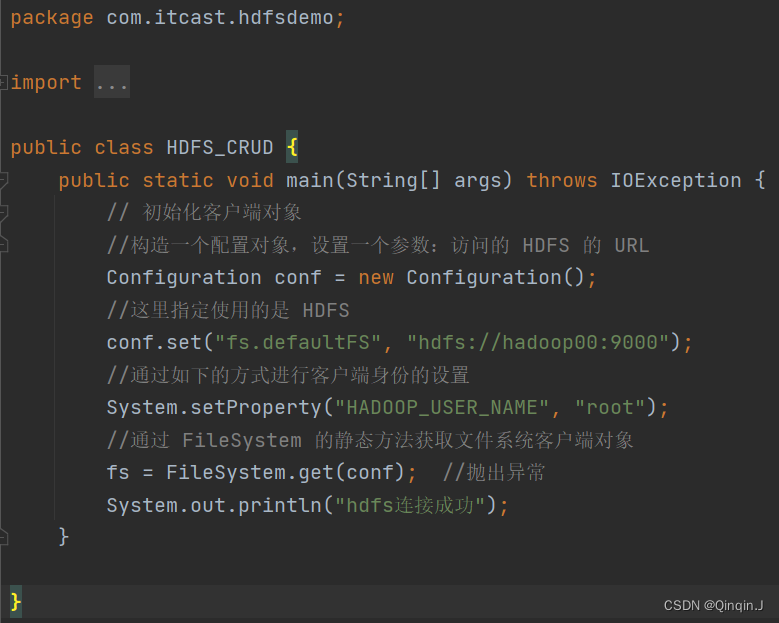

二、初始化客户端对象

通过 main() 方法调用进行HDFS增、删、改、查

public class HDFS_CRUD {public static void main(String[] args) throws IOException {// 初始化客户端对象//构造一个配置对象,设置一个参数:访问的 HDFS 的 URLConfiguration conf = new Configuration();//这里指定使用的是 HDFSconf.set("fs.defaultFS", "hdfs://hadoop00:9000");//通过如下的方式进行客户端身份的设置System.setProperty("HADOOP_USER_NAME", "root");//通过 FileSystem 的静态方法获取文件系统客户端对象fs = FileSystem.get(conf); //抛出异常System.out.println("hdfs连接成功");}}三、本地上传文件到HDFS

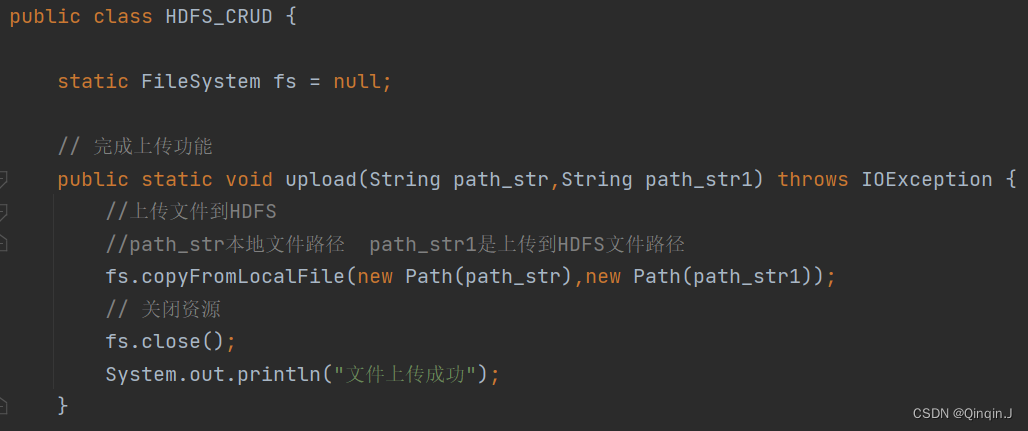

static FileSystem fs = null;声明了一个静态的FileSystem对象fs,并将其初始化为null。FileSystem是Java中用于操作Hadoop分布式文件系统(HDFS)的类。通过这个对象,可以执行一些与HDFS相关的操作,如创建文件、删除文件、读取文件等。在这段代码中,fs被声明为静态的,意味着它可以在整个类中被共享和访问。初始值为null,可能是因为在代码的其他部分会对其进行初始化。

下面对上传功能进行编译

// 完成上传功能public static void upload(String path_str,String path_str1) throws IOException {//上传文件到HDFS//path_str本地文件路径 path_str1是上传到HDFS文件路径fs.copyFromLocalFile(new Path(path_str),new Path(path_str1));// 关闭资源fs.close();System.out.println("文件上传成功");}//main()方法中调用upload("D:/大数据/word.txt","/input"); //上传四、从HDFS下载文件到本地

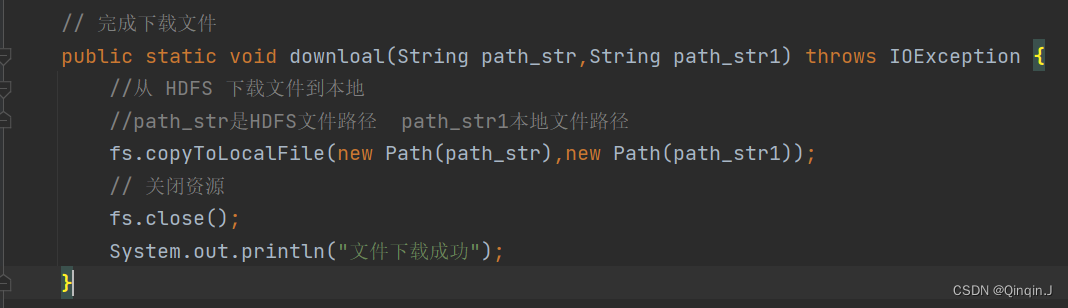

// 完成下载文件public static void downloal(String path_str,String path_str1) throws IOException {//从 HDFS 下载文件到本地//path_str是HDFS文件路径 path_str1本地文件路径fs.copyToLocalFile(new Path(path_str),new Path(path_str1));// 关闭资源fs.close();System.out.println("文件下载成功");}

//main()方法中调用downloal("/data.txt","D:/大数据/文件"); //下载五、创建目录

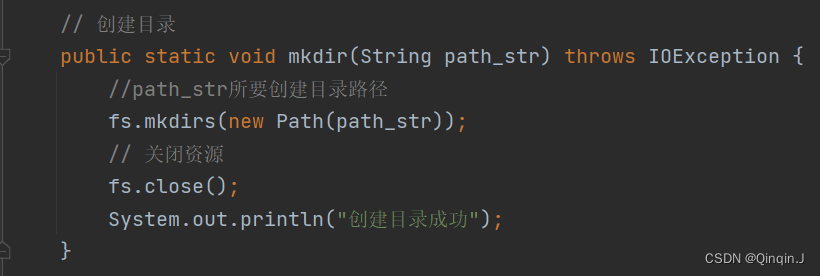

// 创建目录public static void mkdir(String path_str) throws IOException {//path_str所要创建目录路径fs.mkdirs(new Path(path_str));// 关闭资源fs.close();System.out.println("创建目录成功");} //main()方法中调用mkdir("/input"); //创建目录六、重命名文件或文件夹

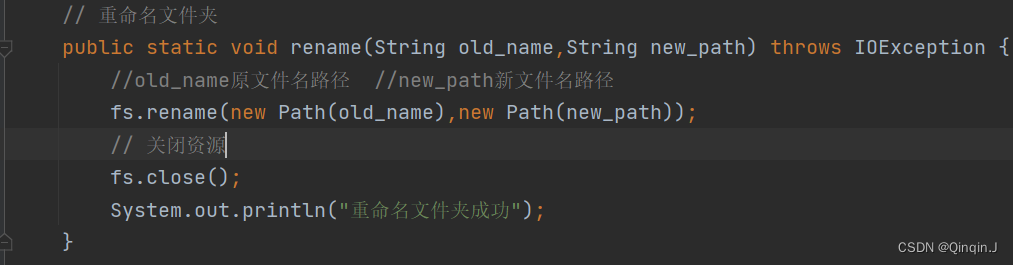

// 重命名文件夹public static void rename(String old_name,String new_path) throws IOException {//old_name原文件名路径 //new_path新文件名路径fs.rename(new Path(old_name),new Path(new_path));fs.close();System.out.println("重命名文件夹成功");} //main()方法中调用rename("/aa","/aa2"); //重命名文件夹七、删除文件

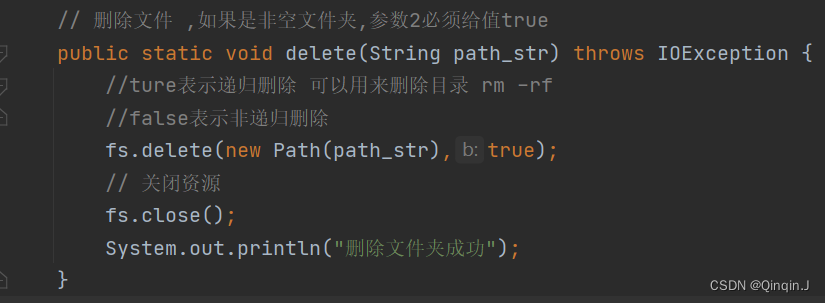

// 删除文件 ,如果是非空文件夹,参数2必须给值truepublic static void delete(String path_str) throws IOException {//ture表示递归删除 可以用来删除目录 rm -rf//false表示非递归删除fs.delete(new Path(path_str),true);// 关闭资源fs.close();System.out.println("删除文件夹成功");} //main()方法中调用delete("/aa2"); //删除文件八、查看文件信息

1、查看文件信息

// 查看文件信息public static void listFiles(String path_str) throws IOException {//获取迭代器对象RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path(path_str),true);//遍历while (listFiles.hasNext()){LocatedFileStatus fileStatus = listFiles.next();//打印当前文件名System.out.println(fileStatus.getPath().getName());//打印当前文件块大小System.out.println(fileStatus.getBlockLocations());//打印当前文件权限System.out.println(fileStatus.getPermission());//打印当前文件内容长度System.out.println(fileStatus.getLen());//获取该文件块信息(包含长度、数据块、datanode的信息)

// BlockLocation[] blockLocations = fileStatus.getBlockLocations();

// for (BlockLocation bl : blockLocations){

// System.out.println("block-length:" + bl.getLength()+"--"+"block-offset:"+bl.getOffset());

// String[] hosts = bl.getHosts();

// for (String host : hosts){

// System.out.println(host);

// }

// }}System.out.println("--------分割线---------");fs.close();} //main()方法中调用listFiles("/data.txt"); //查看文件信息2、统计目录下所有文件(包括子目录)

// 1、统计目录下所有文件(包括子目录)// 1、统计某个路径(由main方法决定哪个路径),下所有的文件数里,例如:输出:该路径下共有 3 个文件public static void count(String path_str) throws IOException {//获取迭代器对象RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path(path_str),true);//遍历int count = 0;while (listFiles.hasNext()) {LocatedFileStatus fileStatus = listFiles.next();count++;}System.out.println("路径:【"+ path_str +"】下,文件数量为"+count);fs.close();} //main()方法中调用count("/"); //统计3、列出某个路径下所有的文件数里

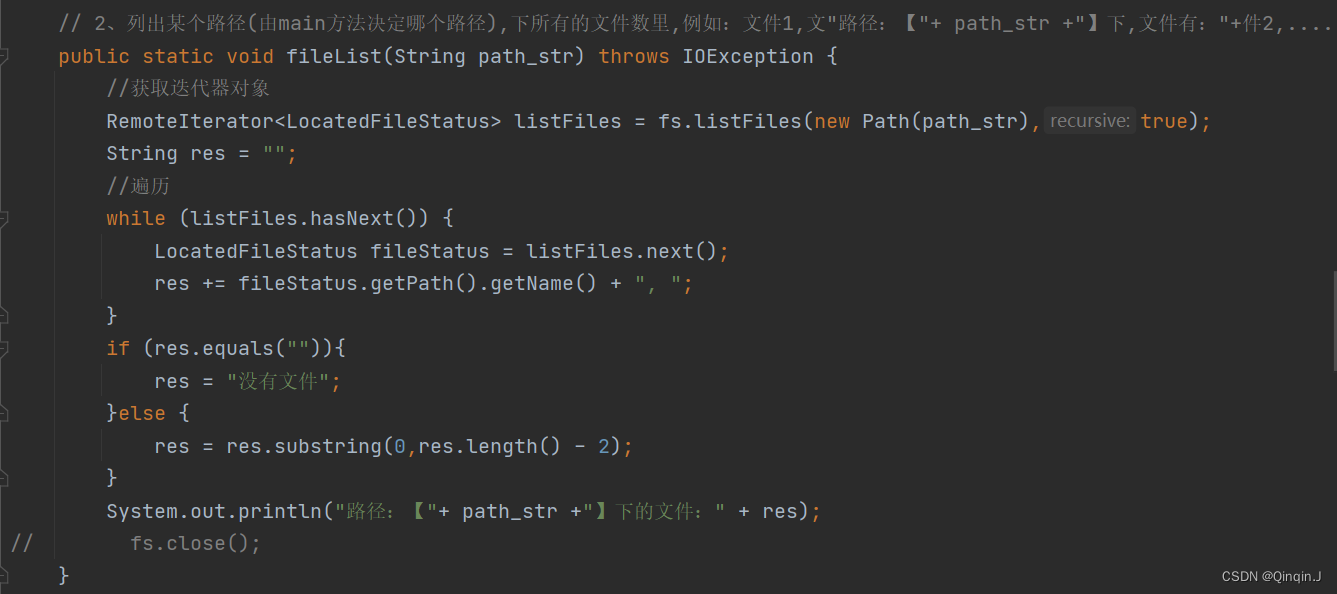

// 2、列出某个路径(由main方法决定哪个路径),下所有的文件数里,例如:文件1,文"路径:【"+ path_str +"】下,文件有:"+件2,....public static void fileList(String path_str) throws IOException {//获取迭代器对象RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path(path_str),true);String res = "";//遍历while (listFiles.hasNext()) {LocatedFileStatus fileStatus = listFiles.next();res += fileStatus.getPath().getName() + ", ";}if (res.equals("")){res = "没有文件";}else {res = res.substring(0,res.length() - 2);}System.out.println("路径:【"+ path_str +"】下的文件:" + res);

// fs.close();} //main()方法中调用fileList("/"); //查看有什么文件fileList("/input"); //查看有什么文件4、查看所有文件

/* 路径【/】下共有 7 子文件文件数量:1,文件列表:data.txt目录数量:6,文件列表:a, exp, input, output, test, tmp*/public static void list(String path) throws IOException {FileStatus[] fileStatuses = fs.listStatus(new Path(path));String res = "路径【" + path + "】下共有 " + fileStatuses.length + " 子文件";int file_num = 0;String file_list = "";int dir_num = 0;String dir_list = "";for (FileStatus fileStatus:fileStatuses){if (fileStatus.isFile()){file_num ++;file_list += fileStatus.getPath().getName() + ", ";}else {dir_num ++;dir_list += fileStatus.getPath().getName() + ", ";}}if (file_num != 0) res += "\n\t文件数量:" + file_num + ",文件列表:" + file_list.substring(0,file_list.length()-2);if (dir_num != 0) res += "\n\t目录数量:" + dir_num + ",文件列表:" + dir_list.substring(0,dir_list.length()-2);System.out.println(res);} //main()方法中调用list("/"); //查看所有5、判断是文件还是目录

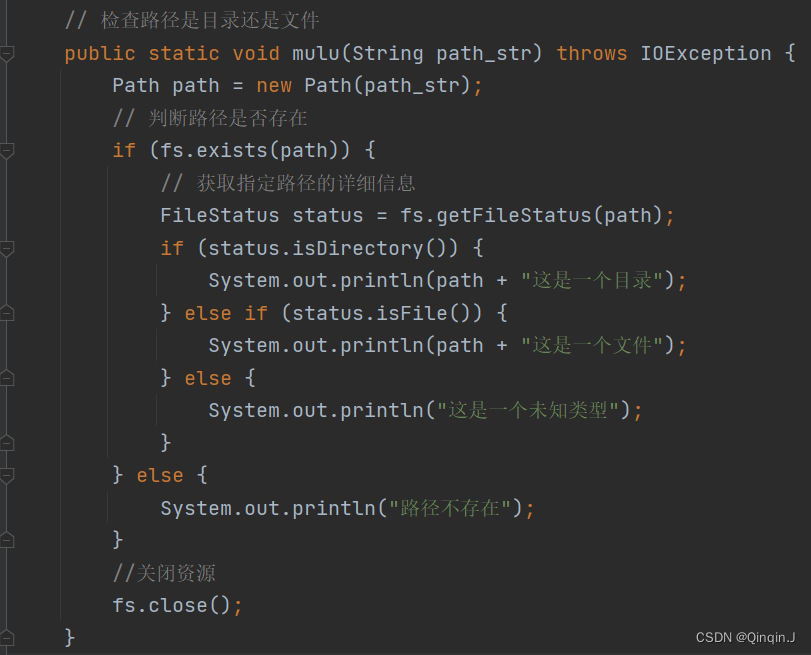

// 检查路径是目录还是文件public static void mulu(String path_str) throws IOException {Path path = new Path(path_str);// 判断路径是否存在if (fs.exists(path)) {// 获取指定路径的详细信息FileStatus status = fs.getFileStatus(path);if (status.isDirectory()) {System.out.println(path + "这是一个目录");} else if (status.isFile()) {System.out.println(path + "这是一个文件");} else {System.out.println("这是一个未知类型");}} else {System.out.println("路径不存在");}//关闭资源fs.close();} //main()方法中调用mulu("/exp/word.txt"); //检查路径是目录还是文件九、源代码

package com.itcast.hdfsdemo;import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.yarn.webapp.hamlet.Hamlet;

import sun.tracing.dtrace.DTraceProviderFactory;import java.io.IOException;

import java.util.Arrays;public class HDFS_CRUD {static FileSystem fs = null;// 完成上传功能public static void upload(String path_str,String path_str1) throws IOException {//上传文件到HDFS//path_str本地文件路径 path_str1是上传到HDFS文件路径fs.copyFromLocalFile(new Path(path_str),new Path(path_str1));// 关闭资源fs.close();System.out.println("文件上传成功");}// 完成下载文件public static void downloal(String path_str,String path_str1) throws IOException {//从 HDFS 下载文件到本地//path_str是HDFS文件路径 path_str1本地文件路径fs.copyToLocalFile(new Path(path_str),new Path(path_str1));// 关闭资源fs.close();System.out.println("文件下载成功");}// 创建目录public static void mkdir(String path_str) throws IOException {//path_str所要创建目录路径fs.mkdirs(new Path(path_str));// 关闭资源fs.close();System.out.println("创建目录成功");}// 重命名文件夹public static void rename(String old_name,String new_path) throws IOException {//old_name原文件名路径 //new_path新文件名路径fs.rename(new Path(old_name),new Path(new_path));// 关闭资源fs.close();System.out.println("重命名文件夹成功");}//main()方法中调用

// rename("/aa","/aa2"); //重命名文件夹// 删除文件 ,如果是非空文件夹,参数2必须给值truepublic static void delete(String path_str) throws IOException {//ture表示递归删除 可以用来删除目录 rm -rf//false表示非递归删除fs.delete(new Path(path_str),true);// 关闭资源fs.close();System.out.println("删除文件夹成功");}// 查看文件信息public static void listFiles(String path_str) throws IOException {//获取迭代器对象RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path(path_str),true);//遍历while (listFiles.hasNext()){LocatedFileStatus fileStatus = listFiles.next();//打印当前文件名System.out.println(fileStatus.getPath().getName());//打印当前文件块大小System.out.println(fileStatus.getBlockLocations());//打印当前文件权限System.out.println(fileStatus.getPermission());//打印当前文件内容长度System.out.println(fileStatus.getLen());//获取该文件块信息(包含长度、数据块、datanode的信息)

// BlockLocation[] blockLocations = fileStatus.getBlockLocations();

// for (BlockLocation bl : blockLocations){

// System.out.println("block-length:" + bl.getLength()+"--"+"block-offset:"+bl.getOffset());

// String[] hosts = bl.getHosts();

// for (String host : hosts){

// System.out.println(host);

// }

// }}System.out.println("--------分割线---------");fs.close();}//把查看文件信息分解为下面几个方法// 1、统计目录下所有文件(包括子目录)// 1、统计某个路径(由main方法决定哪个路径),下所有的文件数里,例如:输出:该路径下共有 3 个文件public static void count(String path_str) throws IOException {//获取迭代器对象RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path(path_str),true);//遍历int count = 0;while (listFiles.hasNext()) {LocatedFileStatus fileStatus = listFiles.next();count++;}System.out.println("路径:【"+ path_str +"】下,文件数量为"+count);fs.close();}// 2、列出某个路径(由main方法决定哪个路径),下所有的文件数里,例如:文件1,文"路径:【"+ path_str +"】下,文件有:"+件2,....public static void fileList(String path_str) throws IOException {//获取迭代器对象RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path(path_str),true);String res = "";//遍历while (listFiles.hasNext()) {LocatedFileStatus fileStatus = listFiles.next();res += fileStatus.getPath().getName() + ", ";}if (res.equals("")){res = "没有文件";}else {res = res.substring(0,res.length() - 2);}System.out.println("路径:【"+ path_str +"】下的文件:" + res);

// fs.close();}/* 路径【/】下共有 7 子文件文件数量:1,文件列表:data.txt目录数量:6,文件列表:a, exp, input, output, test, tmp*/public static void list(String path) throws IOException {FileStatus[] fileStatuses = fs.listStatus(new Path(path));String res = "路径【" + path + "】下共有 " + fileStatuses.length + " 子文件";int file_num = 0;String file_list = "";int dir_num = 0;String dir_list = "";for (FileStatus fileStatus:fileStatuses){if (fileStatus.isFile()){file_num ++;file_list += fileStatus.getPath().getName() + ", ";}else {dir_num ++;dir_list += fileStatus.getPath().getName() + ", ";}}if (file_num != 0) res += "\n\t文件数量:" + file_num + ",文件列表:" + file_list.substring(0,file_list.length()-2);if (dir_num != 0) res += "\n\t目录数量:" + dir_num + ",文件列表:" + dir_list.substring(0,dir_list.length()-2);System.out.println(res);}// 检查路径是目录还是文件public static void mulu(String path_str) throws IOException {Path path = new Path(path_str);// 判断路径是否存在if (fs.exists(path)) {// 获取指定路径的详细信息FileStatus status = fs.getFileStatus(path);if (status.isDirectory()) {System.out.println(path + "这是一个目录");} else if (status.isFile()) {System.out.println(path + "这是一个文件");} else {System.out.println("这是一个未知类型");}} else {System.out.println("路径不存在");}//关闭资源fs.close();}//调用public static void main(String[] args) throws IOException {// 初始化客户端对象//构造一个配置对象,设置一个参数:访问的 HDFS 的 URLConfiguration conf = new Configuration();//这里指定使用的是 HDFSconf.set("fs.defaultFS","hdfs://hadoop00:9000");//通过如下的方式进行客户端身份的设置System.setProperty("HADOOP_USER_NAME","root");//通过 FileSystem 的静态方法获取文件系统客户端对象fs = FileSystem.get(conf); //抛出异常System.out.println("hdfs连接成功");//main()方法中调用

// list("/"); //查看所有//main()方法中调用

// fileList("/"); //查看有什么文件

// fileList("/input"); //查看有什么文件//main()方法中调用

// count("/"); //统计//main()方法中调用

// mulu("/exp/word.txt"); //检查路径是目录还是文件//main()方法中调用

// listFiles("/data.txt"); //查看文件信息//main()方法中调用

// delete("/aa2"); //删除文件//main()方法中调用

// rename("/aa","/aa2"); //重命名文件夹//main()方法中调用

// upload("D:/大数据/word.txt","/input"); //上传//main()方法中调用

// mkdir("/input"); //创建目录//main()方法中调用

// downloal("/data.txt","D:/大数据/文件"); //下载}

}