源:量子位

从2012年到2022年,机器学习引发的新一轮人工智能热潮已经十年。

巧合的是,2022年的Diffusion和ChatGPT,以大众可感知、可体验的方式,让大模型涌现的超能力成功破圈。

从学术界到工业界,从政府到投融资,从巨头到创业团队,或兴奋、或焦虑、或担忧、或冷静。

站在过去和未来的交叉点,从学界和业界大咖的视角,会如何看待过去,看待当下、看待未来?每一位行业中人,又该如何应对?

近日,清华大学美术学院、清华未来实验室主任徐迎庆教授,微软亚洲研究院网络图形组首席研究员、微软全球合伙人童欣博士,粤港澳大湾区数字经济研究院讲席科学家、认知计算与自然语言研究中心负责人张家兴博士,和小冰公司技术副总裁王宝元博士,进行了一次圆桌对谈。

以下为对话实录(做了不影响原意的精简):

王宝元博士:各位老师好。第一个问题是,面对ChatGPT,你们是什么样的心情和心态?

张家兴博士:我是来自IDEA的张家兴,刚才宝元也说了,我也是在这一波ChatGPT创业的大潮里边,准备入局。

我个人的理解,这是一个非常重大的机会,因为这代表着人工智能从2012以来的新旧十年。

过去十年,如果只用两个词来说,叫做Deep Understanding,就是Deep Learning加上Content Understanding。

ChatGPT的出现,开启了一个新十年。新的十年,就是Generative + General,就是未来是属于生成式AI和通用AI的。

过去十年,Deep Understanding这条路其实已经很成熟了,或者说面临瓶颈了。现在我们终于找到了一个新的方向,下一个十年的方向,所以说我感觉非常兴奋。

王宝元博士:童老师呢?

童欣博士:我自己是做图形和视觉方向的,那么这个ChatGPT出来对我来说一方面非常的震撼。

因为它所表现的这个能力,可以说至少在自然语言界是我们长期梦寐以求的,大模型所展现出的能力和技术特点,都值得研究和学习。

第二点就是紧迫感,就是说我们做图形生成的,那么我们的ChatGPT什么时候出现,视觉领域的涌现能力怎么表现?所以是既震撼又紧迫。

王宝元:我觉得前面两位老师都很激动,那徐老师你一定也很激动。

徐迎庆教授:我觉得ChatGPT打开了一个新的可能性,它目前主要围绕着NLP的应用,但是未来在设计上、在建筑上,也利用类似的思想和技术,做全新的探索。

我昨天从香港到上海,一路上大家都在谈论它。

但我觉得它的应用和有效性,还有待于就是用户真的大批量开始用,并且经过一段时间的检验,才能真正的发现它到底怎么用、能用多深以及怎么往前走。

我们知道,以前也有过类似的很好的技术。

但是释放了以后,比如说一些NLP模型,但是胡说八道,说一些不该说的话,说一些有悖于社会准则,就是普遍人类共同认知的话,那就会带来一些困惑。

如何让ChatGPT更加合理、更加有效、更加能够符合人类共同认知,能够让它真正活跃起来,我觉得可能还有很长的路要走。

但是无论怎样,它毕竟开拓了一个新的时代。ChatGPT不同于过去几年的技术创新,它是颠覆性的,所以我很期待它的未来。

王宝元博士:感谢三位老师,大家总体来讲都是非常的兴奋。

那么我们深入讨论下,究竟是什么新突破,令现在所有人一夜之间都对它充满了期待?

家兴博士,您谈一下主要的技术突破在哪里?

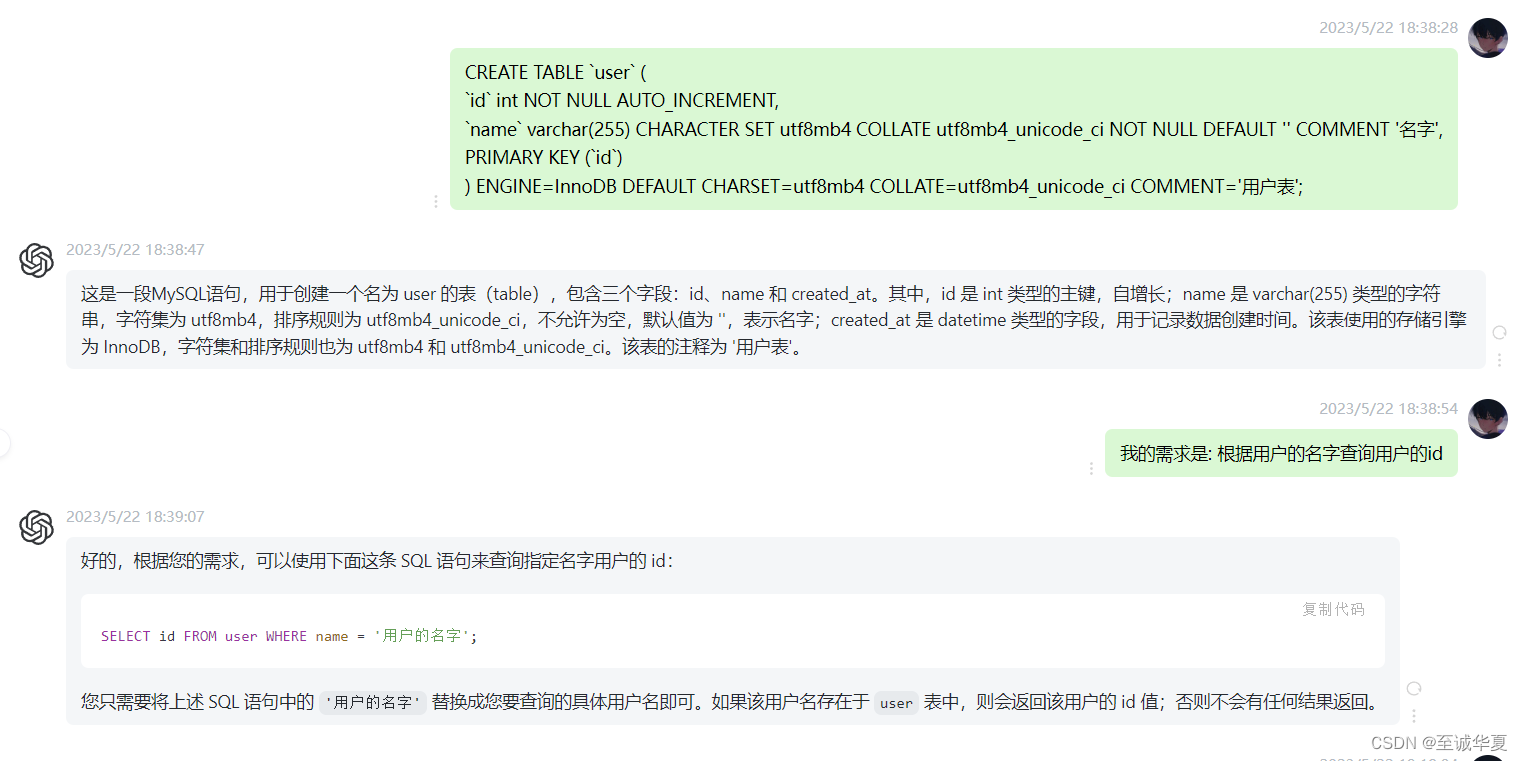

张家兴博士:好的,我主要从NLP来谈。NLP在过去这些年,随着深度学习有很大进步,比如当年GPT3就有重大进步,但影响力还主要在学术和行业,普通大众没有感知。

那为什么ChatGPT一来,大家就街头巷尾人人必谈?我觉得深层次看的话,这涉及一个重大变化,就是AI能力触达最终用户方式的方式变了。

过去的自然语言专家,擅长于自己的领域,有人专门做文本分类、有人专门做信息抽取、有人做问答、有人做阅读理解。

大家会定义自然语言领域的各种各样的任务,这些任务可能有上百个,非常多。

每个任务都有专门的模型和框架,然后还有专门的专家,根据专门数据训练出来,然后摆在那儿供大家调用,所有这些NLP能力,就像一个工具集,成百上千个工具摆在架子上。

那么这个对于想触达这些能力的人来说,就存在挑战,就是我怎么知道成千上百个工具,哪个是适合我的。

所以还需要算法专家进一步解释,你面临的这个问题是文本分类问题,那个问题是阅读理解问题,再把工具给你。

所以大家可以看到,制造AI能力的人,跟最终使用这个能力的人中间,是巨大的Gap,如何去弥补?

其实我们之前一直没有想到很好的方法,大家做了各种各样的平台,都试图去弥补Gap,但现在看起来都不成功。

最终ChatGPT告诉我们一件事情,弥补AI自然语言能力跟用户之间Gap的方法,就是自然语言本身,让用户他用自然语言去描述,让大模型去理解用户想干什么,然后把这个能力给到它。

举个例子,请描述一下中国足球的未来。

这个容易,如果加一个约束,请简短的用三条来描述,这个在过去的问答系统里边,你就很难让实现,需要算法专家把它专门变成一个有约束的问题。

现在ChatGPT不用了,你能用自然语言去描述你想做什么就可以了,ChatGPT都能理解。

所以大模型实际上缩短了AI能力跟用户之间的距离,所有人都可以用了,一下子就火了。

王宝元博士:那可不可以这么理解,原来很多传统NLP的任务已经不存在了?

张家兴博士:如果我们套用《三体》里面非常著名的一句话,“物理学不存在了”,那么我们今天从某种意义上也可以说,NLP技术不存在了。

王宝元博士:这个讲法非常大胆。

张家兴博士:对,NLP技术不存在了。但还是要加一句解释,只是传统的那种。不再需要单纯的算法专家去设计单个的NLP能力。

那新的NLP方式是什么,就是努力去做一个通用的ChatGPT,把所有提供给用户的能力,都注入到一个模型里,让这个模型可以通过自然语言的方式,给用户提供所有的能力。

王宝元博士:谢谢家兴博士。

童老师,你做Graphics有二十多年了,看到AIGC,特别是文生图、文生视频,或文生几何Mesh,它的进程是非常快的。

那从您的角度看,大模型对传统Graphics研究,是不是也带来了很大冲击?有没有具体的一些范式也迁移了?

童欣博士:大模型的出现,对图形学和三维的研究,解决了两个根本性的问题,提供了全新的路径和方式。

首先是多模态带来的维度跃迁,第一次摆脱了要用图形的输入创造图形的方法,实现了梦寐以求的跨模态生成。

另一个是DreamFusion出现后,第一次实现了,向大模型里输入图片去训练,就能拥有所需要的海量三维数据,不再需要传统的三维建模和三维重构,只需要去思考如何从大模型里有效提取这些三维数据。

王宝元博士:所以也是就是说把Language作为Interface,去创造图形?

童欣博士:对,一是把Language作为Interface;第二就是,从图片出发,自动生成你想要的所有高质量的三维内容,这个跃迁以前是做不到的。

王宝元博士:我们自己在小冰内部做这个图像生成、视频生成也有同感。

这个进展可能超过想象,所以我们其实有类似的焦虑感,就是都要花很多的精力去理解,新技术到底意味着什么,看懂以后还要转化成动作。

那么徐老师,您做很多年自然用户界面设计,有大量了不起的成就。

您过去几年做大量嗅觉的研究, ChatGPT跟嗅觉的研究有没有一些关系,研究范式会不会有变化?

徐迎庆教授:对,我想多说两句。ChatGPT因为数据量太大了,不再是过去我们传统意义上的Domain数据,那它对未来的知识学习、传承都会产生深远的影响。

比如我自己,我现在在美术学院当老师,但是实际上我本科是学代数的,又做了七年的计算机动画和电影电视广告专业,后来读了计算机博士,然后又做了几年ERP,后来在MSRA做了几年研究,现在是清华美术学院信息设计系教书。

回顾这几十年很有意思,我是在不断把已有的知识为基础,做新的迁移和学习,不断的获取新的知识。

那这个过程,我拿自己当试验,花了30多年。如果有ChatGPT来帮助我,也许三个月或者三年就够了,学习效率和实践成本都会大大加速和降低。

谈到大模型对研究的影响,我认为大模型对学科之间的融合、交叉创兴,有可能产生革命性、颠覆性的影响。

比如,我们在做的嗅觉计算中包括气味检测,人类知识库里有很多对气味的自然语言描述,比如花香调的香水,这些香水通过语言描述,会让人直接感受到心理学上的认知。

我们在做数据的时候特别需要这一部分。另一个可能性,是大模型是否可能建立类似几何空间、色彩空间一样的嗅觉空间,用少量的参数就能够定义和描述。

王宝元博士:谢谢徐老师。家兴博士,就是刚才徐老师讲嗅觉的表达,以及嗅觉有可能跟语言本身的描述是有这个关联的。

但是其实我们看到这样的工作其实很少的,那你觉得就是说从NLP的角度,有没有可能大模型本身已经蕴含了隐式的嗅觉,我们怎么把它给提出来,然后用来做嗅觉相关的研究?

张家兴博士:关于嗅觉我了解的不是特别多,但嗅觉跟情感是有关系的。当我们讨论嗅觉的时候,很多时候也是在说情感。

而在情感方面,有这方面的研究,也是清华的学者研究的,在大模型里面发现了情感神经元,大概意思是输入一个正向情感,对应的某个神经元就激活;输入负向情感的,另一个神经元就激活。

其实这一点,我觉得跟嗅觉所产生的情感是类似的,我相信如果把嗅觉跟语言放在一起训练的话,那么正向的这种嗅觉感受,它也会在语言空间会激活。

现在整个认知科学里,尤其ChatGPT出来之后,语言跑的比较靠前,原因正如童老师说的,语言原始数据多而且成本很低,只要花点人工把它清洗好就可以,这个跟3D内容没法比。

所以说语言率先实现了突破,也足够完整,大家想要的所有东西也许自然语言大模型里都有。

所以或许可以通过语言空间的表示其他的模态,比如包括情感的、视觉的、嗅觉的都牵起来,这是是一个可能。

徐迎庆教授:我插一句,刚才家兴提了非常好的一个点,在自然语言里有很多很多比如情感的表达,或者对一些味道描述的表达。

但是这种表达其实也是一个新的挑战,比如我们经常会说一些正面情绪、负面情绪,但在嗅觉里什么是正面、什么是负面,其实是非常不一样的。

对群体来说,有趋势性的正面和趋势性的负面,但是放到任何一个人身上,就完全不一样。

比如说,统计上讲都喜欢闻比较香的味道,比较舒适的味道,比如花香让你舒适,那么臭味很少有人喜欢。

但是你换一个场景,比如你吃臭豆腐、榴莲的时候,那个臭味是非常吸引你的,你要的就是那个味。

所以在这个时候,怎么更加精准地提供标注和分类,实际上我觉得,这倒是提了一个很大的难题。

王宝元博士:谢谢家兴和徐老师。

童老师,AIGC可能大部分人讲的概念可能更多的还是说内容生成,但是对Graphics而言,其实有很多交互式应用。

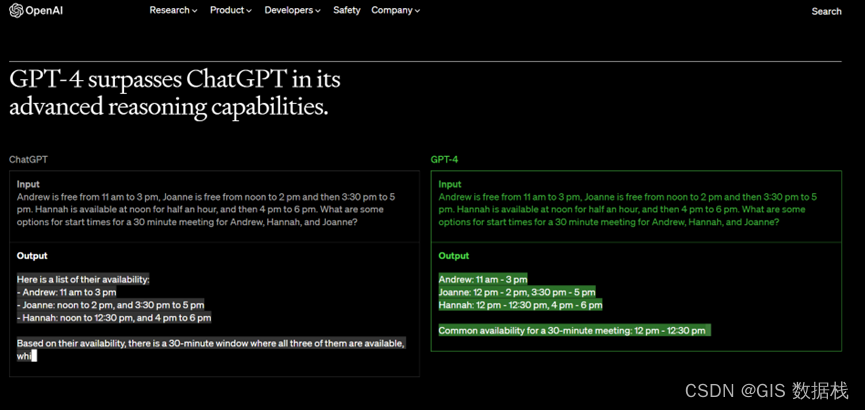

那我们知道ChatGPT当然展示了多轮语言交互,但它还没有多模态,也许马上GPT4可能会多模态,那在图形学的交互上,您觉得有哪些新的研究问题会涌现?

童欣博士:对我来讲,其实ChatGPT或者大模型接下来,我主要想研究两件事儿,一个是最后一公里,一个是开始一公里。

首先是大模型生成三维模型的落地,需要解决最后一公里的问题,因为大模型生成的三维内容和真正使用的三维模型之间还有一个距离,为什么?

因为真正使用的三维模型的每个语义、每个面的东西都是分割好了的,有了这些才能支持后面所有的动作、形态、交互,甚至是两个物体之间的交互。

所有这些物理属性都需要赋予给它,那么大家以前建立了一套很好的流水线来做这个事情。

那么现在AIGC做了第一步,后续怎么用新的流水线把这些特性也走完,这是最后一公里的事情。

开始一公里,是说有没有可能基于新的表达,创造一个全新的三位内容生产方式和流水线?

比如NeRF或者其他的新表达方式,就要做开始一公里。

过去的流水线很沉重,工业界被绑架了,甚至大家觉得就应该这么用。

但是有了新工具的时候,也许现在可能是一个最好的机会,我们能够创造一个全新的三维内容生产的一个方式,整个的表达、生成、交互都是完全不同的。

如果有一个这样的三维世界模型在这里,可能只需要给video输出,它不需要去识别这个物体是什么,那个物体是什么,它就能够做出正确的动作。

那么假设你有一个神经网络,你给出人的初始动作,我就把这个环境的所有的视频、应该发生的改变给你,这有点像“缸中之脑”的那个概念了。

那么它即使不是三维表达,但是可能已经满足你很多应用的需求了,这个方面我觉得会有很多非常开脑洞的、全新的课题出来,我是觉得非常激动人心的。

王宝元博士:所以不光是用户体验会有颠覆性,同时对于技术研究或者是开发人员来讲,无论如何都要去跟进、去拥抱、去理解它到底意味着什么。

不过我们讲了这么多的范式迁移,童老师讲了Graphics新的问题,徐老师讲嗅觉的新问题,那大模型依然有很多问题没有解决,我们在兴奋的同时也要冷静。

就是说有哪些问题其实是急需要解决的,但是就是目前还感觉没有找到特别好的办法?家兴先谈一下NLP这边?

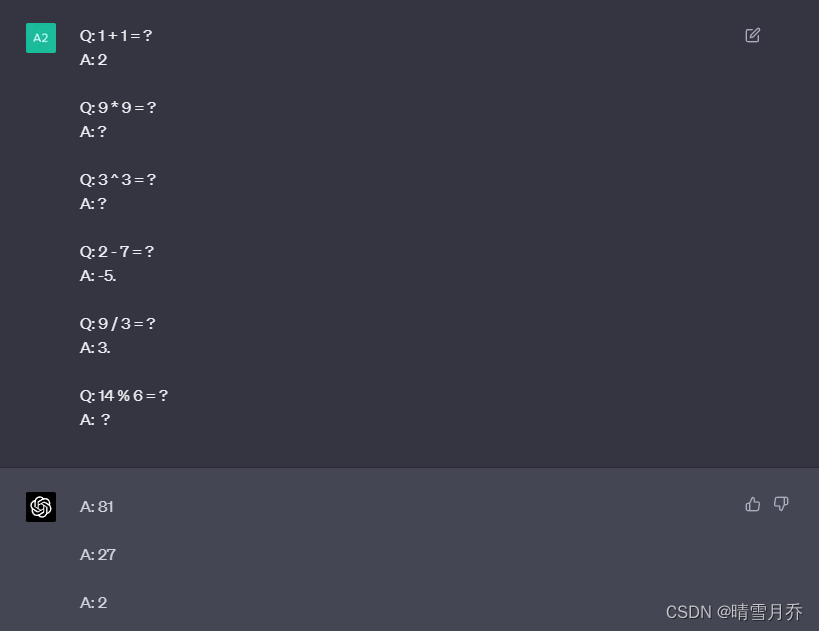

张家兴博士:现在亟待解决的一个问题是,如果真如我们所想的那样,希望用自然语言的形式把NLP的能力呈现给用户,我们需要把所有的能力都去用这样一个ChatGPT去承载的话,那么会涉及到两个问题:

一个是说我们现有这些大模型,哪怕你是ChatGPT,1000多亿参数,这个容量够不够,你可能是存不下所有的能力的,所以这个是一个问题。

再一个问题是,是不是所有的任务都要灌注到同一个模型结构。我们过去做了99个开源训练模型,叫预训练大模型体系,然后为每个任务都有专门的模型结构。

比如自然语言理解的任务,其实双向处理的模型是最好的,就是BERT这类,比如我们两亿参数的BERT模型,我们在零样本分类上就敢去PK Google的5400亿参数的PaLM,这就说明有些任务它天然适合一个特定模型。

但是如果要全用ChatGPT呈现给用户,非要把所有的任务都要注入到一个Decoder-Only的Transformer结构里边,反而让准确率再也做不上来?

这是一个非常大的担心,从我做自然语言的角度来说,就是ChatGPT它是通用的、万能的,但是有些功能永远也做不到单一模型那么好,这是我一个担心。

王宝元:对,我有个非常想问的问题,就是说我们也是觉得对很多具体的问题来讲,会不会有“大炮打苍蝇”的这种问题?

就是说你强迫所有的问题都要统一用这个GPT的架构,强迫所有任务用一个Model,但是对于很多小的问题来说,它也许不需要那么大,会不会有这样的?

张家兴:是的,这个问题问的挺好。

这其实涉及到ChatGPT未来的发展,到底是我们需要一个大而全的、什么都能做的,还是说其实我们需要一个一个小的,它可能也是类似ChatGPT的,也能多轮对话,也具有一定通用性,但是每个模型尺寸不大,但是只解决一类问题。

终归来说,我觉得ChatGPT这条总的路线是没有错的,就是说我们不要再去强调一定要用户去按照算法专家所设计的格式输入。

哪怕就是只做抽取信息,抽取实体、抽取关系,能不能也做成多轮对话的?在这个过程中,你可以不断地以交互的方式,去提取出里边所有的东西。

ChatGPT的方式没有错,但是不是一定需要把所有能力都要压缩到一个大模型里边,这个我觉得是值得考虑的。

王宝元博士:除了结构的担忧以外,现在ChatGPT包括New Bing,曝出有很多问题,比如捏造事实,家兴你觉得,有哪些好的办法?

第一解决溯源问题,大模型生成的内容源到底是从哪里来的;第二,怎么确保不要乱讲,就是说不要捏造事实。在这方面有什么想法?

张家兴博士:现在ChatGPT最大的问题就是,它不知道自己不知道。它非常自信,什么都想去回答,但是其实它不知道。

那这个问题怎么解决呢?

那有人可能就说,第一个是让模型自己去学,去学“自己知道不知道”,或者旁边放一个监督模型去学“你知道不知道”,但是恐怕“知道不知道”这个事情,要比随机问答的难度高一个级别。

所以如果要解决大模型“知道不知道”的问题,会是复杂度上一个数量级的挑战,因为你要让新的监督模型知道ChatGPT不知道,新的监督模型要比ChatGPT还要复杂的多。

那么我觉得,在当下的技术水平,更加合理的选择,还是让大模型学会使用工具。

就是比如说学会使用搜索引擎去搜一下,每一次它都是在搜索出结果的情况下,先做验证,然后输出,这是目前比较现实的一个解决方案。

王宝元博士:有点像Meta前段时间放出的ToFormer。

张家兴:对,这是目前学术界一个热点了,其实整个2022年,大家一直都在做这个事情,也有很多好的工作了。

王宝元博士:好,谢谢家兴。

童老师,您能谈一下这个Graphics这边您看到的这个大模型有哪些大的限制,前段时间那个ControlNet非常火。

单张图片生成已经非常的惊艳、真实,但如果拿这样的技术去做视频,那么立刻你会发现一致性有很大挑战,比如说背景不能动,衣服要保持,identity不能乱变。

所以这里面肯定有新技术要突破。那除此之外,童老师您看到哪些大的问题?

童欣博士:我觉得首要的也是本质的问题,就是所谓一致性的问题。

之所以很多时候视觉用三维表达,因为它可以提供视觉表达的一致性。

如果你没有这个物理世界的表达,你直接去学的时候,这个一致性能表达,当大模型学会这个一致性,就意味着它知道了隐含的三维表达,只不过它的表达是隐性、显性,这肯定是第一个根本的问题。

第二个问题就是,How and Why。

How是说,假如有这么一个类似ChatGPT的视觉大模型,那用什么方式把三维数据提取出来,就像现在大家用Prompt方法抽取语言大模型,这是一个技术上的挑战。

还有一个问题就是,怎么保证大模型输出的东西是事实。

在视觉领域类似的情况是,如果生成一张图或一个三维内容,如果只是天马行空,那怎么漂亮怎么来。

但如果要落地在实际应用中,比如在一个Game Engine,它要去动,它要合理的时候,它要符合一些基础物理规则,那么我们靠什么东西,就像事实检测一样,我们怎么知道这个东西它该不该动、动起来是不是合理呢?

我们需要一个检测器,比如有Fake Call Simulator,可以给你提供反馈。

我觉得这是另外一个非常有趣的研究方向,就是怎么通过检测器给大模型反馈,让它能够学会生成符合规则的内容。

王宝元博士:就是说现在的AIGC大模型,它本身并不提供物理特性、物流规则,所以说它只能是一种参考,它达不到这种物理仿真的级别。

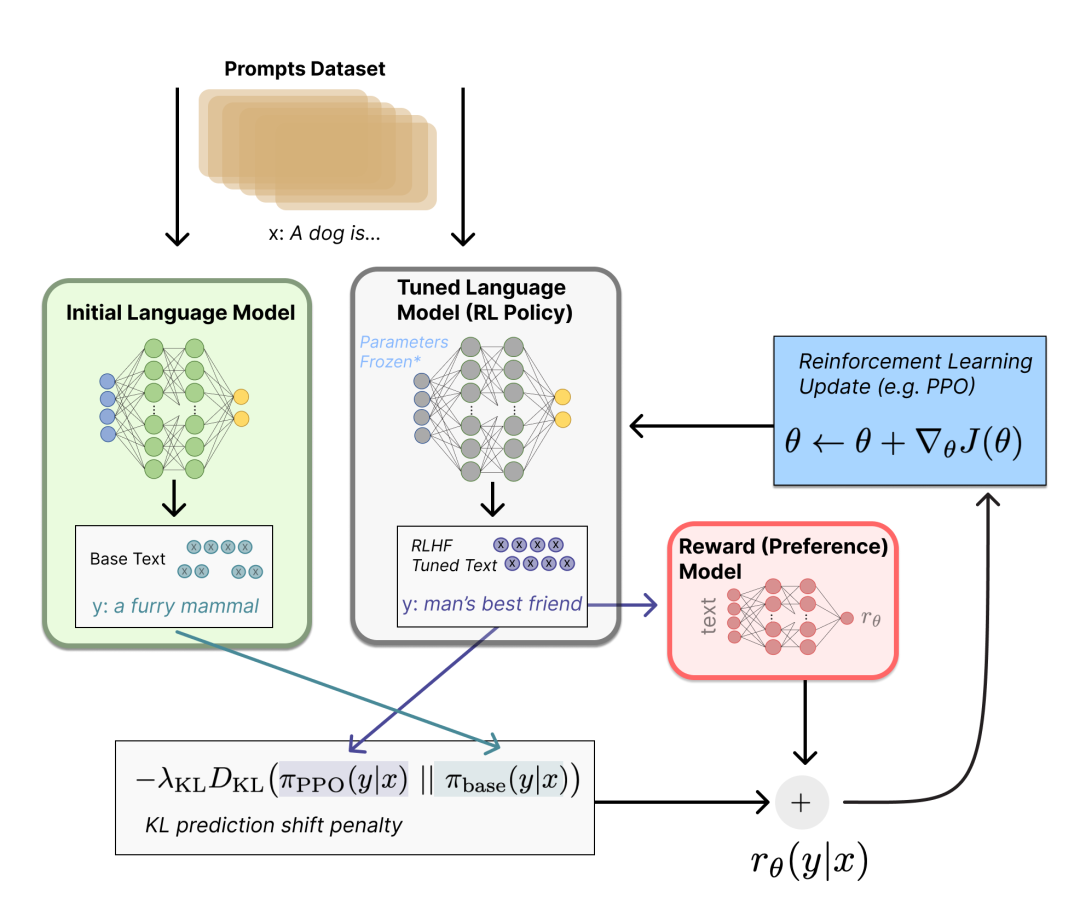

童欣博士:对,或者说它只有一个前向的生成过程,然后这个生成了以后,你是没办法给它另外一个反馈让它形成一个闭环的,现在这个反馈来自于人,通过RLHF来做。

但我希望,未来有一个自动的物理反馈给它,那这两个东西互相动,那也许生成的就不太一样了。

王宝元博士:徐老师有没有补充的?

徐迎庆教授:ChatGPT现象发生的时候,我是最兴奋的。

因为我做人机交互,觉得它为人机交互和人机协同工作打开了一个全新的时代。ChatGPT代表了最最重要的新一代交互模式,所以各位开发者,我建议在这个方向可以下功夫。

第一点,是大模型的逻辑推理还需要优化。

比如刚才李笛讲了一个例子,说ChatGPT无法回答“刺杀林肯的凶手和林肯是不是在同一个大陆上”。

然后小冰链(X-CoTA)可以做到,然后它基于时序推理、上下文推理,先问什么时候发生的、然后在哪儿等等推理了一大堆,然后最后得到结论是在一个大陆上。

但其实人不是这么想问题的,如果人机交互,人就跟机器说笨蛋,在19世纪,一个人要刺杀另一个人,一定得在同一个环境下,不然他怎么开枪呢?他也没有现在的远程武器。

所以人类想问题和所有的大模型推理是不太一样的,这是第一点。

第二点,刚才两位也都谈到Physical Based Modeling和Physical Based Simulation。

这需要经过物理试验,才能真正应用在创新。举个例子,现在要设计一辆新车,需要上百个设计师、工程师做好几年,然后进行各种各样的测试。

但是在未来,可能当ChatGPT的知识足够的时候,说我们要给20出头、刚工作的年轻人设计一个城市通勤和郊游为主的新车,那它可能一晚上给你100个方案。

这些方案一定不是完美的,但它能包括外观、材料、底盘、发动机、油箱等总成,还包括去哪儿采购,供应链关系等,甚至市场推广怎么做都做好了,然后用少量的设计师、工程师和相关人力,就可以完成了。

所以未来就是人类可以做很多外叉的事情,那么目前机器做的大部分是内叉的任务,少部分是外叉。那么以前三年、三十年的任务,未来也许三个月就完成了。

所以我觉得ChatGPT未来一个非常大的影响,可能是正面的,也可能是负面的。

正面的是,会大大加速社会进步、技术进步;负面的是,很多人确实要考虑自己的工作应该怎么保住,我就讲这个。

王宝元博士:徐老师引出非常好的一个问题,不过我想稍微反问一下,就是说那ChatGPT学出来的创造的能力,它也是从人类大量的作品学出来的对吧?

徐迎庆教授:对。

王宝元博士:那它不一定能够生成真正有用的知识,或者有用的这种创意的idea,会吗?应该是以怎么样的方式去结合,跟人去协同创造?

徐迎庆教授:对,是这样。

比如说我们以前做过一个案例,我们自己的人工智能系统,给它看了4万张椅子的照片,然后说要生成一把新椅子,生成了31万把椅子,人工看是看不过来的,加了一个约束后得到了十几把。

这十几把椅子的概念,有的合理、有的不合理,我们挑了一个最喜欢的,就真的做了一把椅子出来,从设计师的角度看是非常酷的,它既有明代风格,又有现代风格,融合了很多东西。

那这样的人机协同设计,就变得非常现实,这就是我说的一定要人机协同工作,光靠大模型肯定不行,无论如何都不行。

王宝元博士:非常同意徐老师这个观点。

最后有一个问题非常重要,我也想最后每个人都总结一下,就是今天来了这么多的开发者,我想大家都是可能非常年轻的刚进入这个行业,有的还是学生。

各位有没有一些具体的建议,告诉他们应该以什么样的心态,去面对新技术带来的变革?

徐迎庆教授:第一个就是,大家不要怕这个东西。

因为其实我们想一想历史,比如当摄影术刚发明的时候,很多画家很恐慌,因为他画了半年、一年,结果那个镁光灯一亮,整个影像就记录下来了。

那其实对当时以贵族、商人肖像画为主的画家带来了很大的威胁,反而逼着新的艺术流派诞生。

走到今天,摄影成了一个单独的门类,艺术绘画还在那里。

第二个,学会掌握新的工具,ChatGPT是你大脑里的一支画笔。

最早人类记录影像、文字,是有颜色的石块,后来是木棍、鹅毛、铅笔、钢笔、鼠标、数字笔,他们都是笔的延伸。

数字笔在数字板上是很滑的,不像在纸上的感觉,所以比较难学,但ChatGPT比数字笔还要难适应。但你要去适应它,如果你不去适应,那你永远用不好这杆笔。

第三个,当然我作为一个老师,这就更逼着大家,特别是年轻的一代,要去学习一些全新的知识,逼着自己去学,不学习没有出路。

现在一个很明显的现象,据我所知有很多非常先进的设备,但能开的人非常少,为什么?

因为他要储存和具备足够的知识和技能,那ChatGPT是一样的。如果每个人都以另外一种方式在前进,而你还不会,那就和这个时代脱节了。

这些不一定对,但是跟大家分享。

王宝元博士:谢谢徐老师,家兴。

张家兴博士:我做过学术研究,也在工业界做过各种技术落地,经过多年的观察和思考,我的建议时候,当我们把自己定位成技术人的时候,我们不能只是低头走路,还要抬头看看天。

这个时代变化太快。大家今天为ChatGPT惊呼,但再往前推,其来有自。2020年是GPT3,2018年是BERT,2017年是Transformer,2015年ResNet,2012年深度学习兴起,技术范式的变化是加速度,而不是是匀速。基本两年一个大变局。

其实当年GPT3和BERT出来的时候,已经冲击非常大了,很多当时做NLP的就不知道接下来论文该怎么写了,要跟BERT比还是不比?

而且当时一个趣事是,BERT最开始大家觉得这个只是学术界用,但实际上也就三个月到半年,工业界就都用了,所以技术范式的变化速度真是大家以前想象不到的。

所以我的建议是,大家除了每天学好技术细节,做好手头工作之外,一定一定要关注,整体技术范式的变化,多做一些更深层次的、更抽象的、更大框架下的思考,到底我们这个时代,技术在发生什么变化,有些时候可能你听别人讲很多,但大家得形成自己的思想和判断。

当你自己的思想和判断越来越准,这时你自己选择说,我该投身于哪个技术方向,还是要带一个更大的团队,甚至为一个公司制定技术战略,这都是非常重要的。

这些能力,要从年轻的时候开始积累和培养,这就是我的建议。

王宝元博士:童老师。

童欣博士:刚才两位老师讲了很多关于技术、关于知识储备、学习方面的,我讲点稍微不一样的。

我做研究做了二十多年,可以说做了很多工作,但是我现在越来越意识到,就是现在真的是太卷了。

这个时代也许会越来越卷,因为技术的发展进入奇点时代,只会越来越快,但是我想跟大家讲的是,就是说什么时候,都不要忘了你首先是一个人。

什么意思呢?在你不断的做这些工作的时候,最重要的还是学会享受你生活中的乐趣。

当你最后回顾自己的一生,你不会说ChatGPT这个那个,你想到的,最终还是你生活中特别幸福美好的那些瞬间。

别忘了,那些瞬间最重要,不管时代怎么变,你永远是幸福的。我越来越意识到,让自己感到幸福,比技术还重要。

王宝元博士:谢谢。我听完三位老师最后的建议,我自己的焦虑感都瞬间少了很多,不管你们信不信,反正我是全信了。因为时间关系,今天就聊到这儿,再次感谢三位嘉宾,谢谢大家。

附:圆桌对谈金句摘要

张家兴博士

1、过去十年属于Deep Understanding,未来十年属于Generative和General。这是一个让人兴奋的新时代。

2、传统的NLP技术不存在了。

3、如何解决大模型一本正经胡说八道的问题?目前比较好的方式,是让大模型学会使用工具,比如搜索引擎。

4、技术人不能只是低头走路,还要抬头看天。做好日常重要,更重要的是关注整体技术范式的变化,多做深层次的、抽象的、更大框架下的思考,得有自己的思想和判断。

童欣博士

1、ChatGPT非常震撼,它涌现出很多梦寐以求的能力。这给我们带来了紧迫感,视觉领域的大模型涌现能力该如何表现?

2、大模型的出现,解决了两个根本性的问题,提供了全新的路径和方式。

首先是多模态带来的维度跃迁,实现了梦寐以求的跨模态生成;另一个是DreamFusion第一次实现了,输入图片获得三维数据。传统的三维建模和三维重构不重要了。

3、大模型生成三维内容的落地,需要解决两个一公里的问题。现在AIGC走出了革新的第一步,往下有没有机会,创造出一个全新的三维内容的生产方式与流程?

4、视觉领域的大模型生成,目前还需要解决一些限制和挑战。

比如,大模型生成的三维表达和真实世界物理三维表达一致性的问题;大模型生成三维输出的How和Why的问题,这个领域的prompt该如何做;其三是大模型生成的三维表达如何在具体场景里自动学习、遵守相应的规则。

5、人生的幸福瞬间,比技术变革更重要。任何时候都要先记得,自己首先是一个人,不是机器。你回顾一生的时候,你首先想到的,都是特别幸福的那些瞬间。

徐迎庆教授

1、大模型对学科之间的融合、交叉创兴,有可能产生革命性、颠覆性的影响。

我们在做的嗅觉计算中包括气味检测,人类知识库里有很多对气味的自然语言描述,比如花香调的香水,这些香水通过语言描述,会让人直接感受到心理学上的认知,我们在做数据的时候特别需要这一部分。

另一个可能性,是大模型是否可能建立类似几何空间、色彩空间一样的嗅觉空间,用少量的参数就能够定义和描述。

2、ChatGPT为人机交互和人机协同,打开了一个全新的时代。它能让人类更好地发挥创造力,可能三个月就能完成三年、三十年才能完成的任务。

3、ChatGPT是一支新的笔,在你的大脑里,用它来描绘出什么,取决于你是不是能掌握它,用好它。如果你没有足够的知识和技能,没有足够的创造力,那你可能就会和这个时代脱节。

一起交流

想和你一起学习进步!『NewBeeNLP』目前已经建立了多个不同方向交流群(机器学习 / 深度学习 / 自然语言处理 / 搜索推荐 / 图网络 / 面试交流 / 等),名额有限,赶紧添加下方微信加入一起讨论交流吧!(注意一定o要备注信息才能通过)