先简短介绍一下CLIP模型:

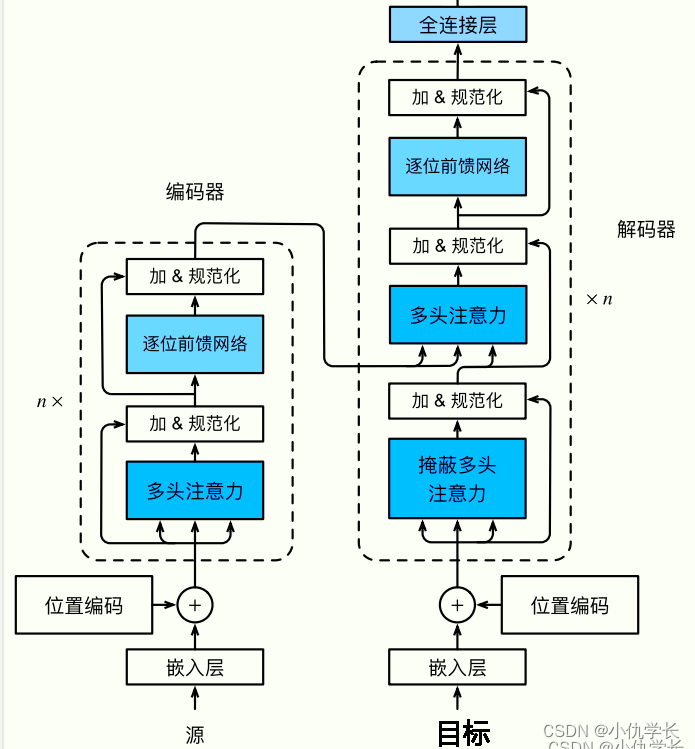

CLIP (Contrastive Language–Image Pretraining) 是由 OpenAI 开发的先进的多模态视觉模型,结合了图像和文本处理能力。

CLIP 模型的主要特色在于它不仅可以理解图像,同时也能理解描述这些图像的文本。通过这样的方式,CLIP 能在理解图像和文本方面做到更准确且富有洞察力。CLIP 模型的训练办法是以大规模数据集为基础,这些数据集包含了数百万的文本-图像配对。这种训练方式允许模型学习到如何通过文本理解图像,反之亦然。

比如,你可以向 CLIP 查询一个文本描述,然后让它从一个图像数据库中找出与这个描述最匹配的图像。或者,你也可以给 CLIP 一个图像,让它生成一个描述这个图像的文本。这种灵活性让 CLIP 模型能够在许多不同的应用中展现它的价值,包括图像生成、图像编辑,甚至是内容过滤等等。

以下是一些应用例:

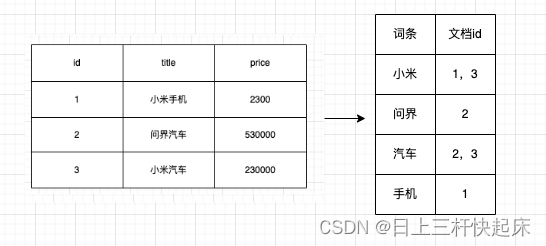

图像-文本匹配: CLIP 可以确定图像描述(文本)与给定图像的匹配程度。这对于图像检索或图像字幕等任务非常有用。

文本引导图像编辑:使用文本描述,CLIP 可以指导图像编辑以达到预期结果。这为创造性的文本到图像操作打开了大门。

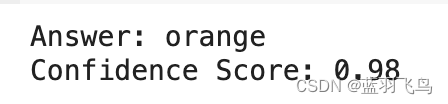

视觉问答(VQA): CLIP可以集成到回答图像问题的系统中。例如,给定场景图像和“汽车是什么颜色?”之类的问题,CLIP可以分析图像和文本以提供一个答案。

零样本学习: CLIP 可用于将图像分类为新类别,而无需对这些类别进行任何事先训练,这是通过利用文本和图像之间的连接来实现的。

图像-文本匹配,零样本分类见CLIP用于图片检索,

本文用CLIP做视觉问答。

首先安装相关库

pip install git+https://github.com/openai/CLIP.git

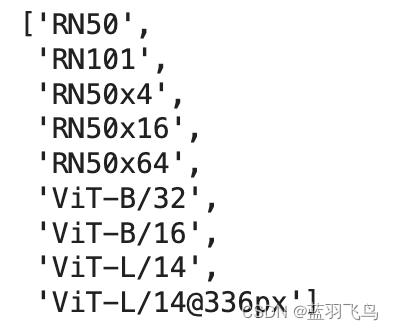

安装完之后可以确认可用的CLIP模型

import clip

clip.available_models()

引入VQA(视觉问答)相关库,处理一张小猫的图片。

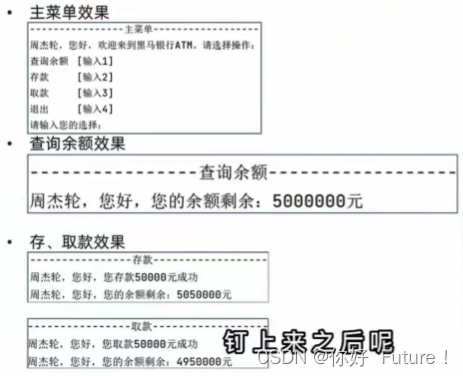

提个简单的问题:“这个猫是什么颜色?”

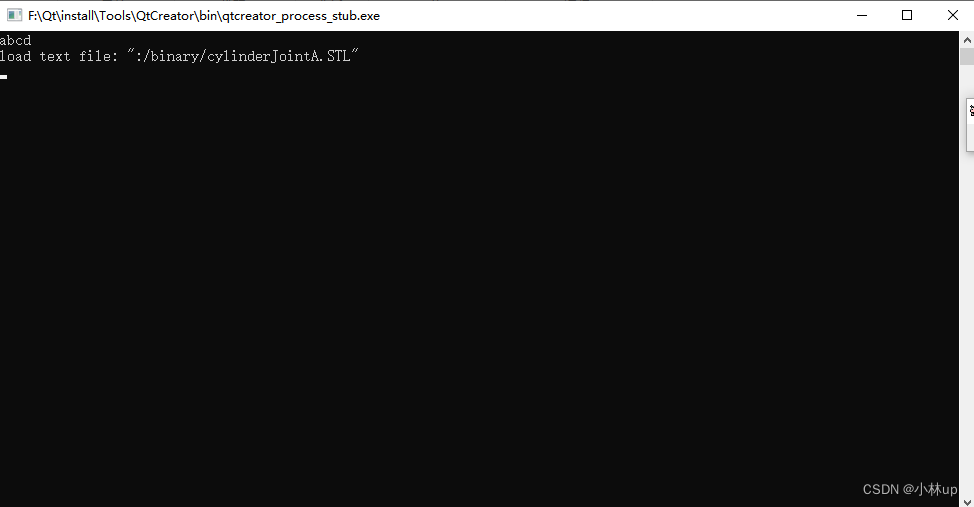

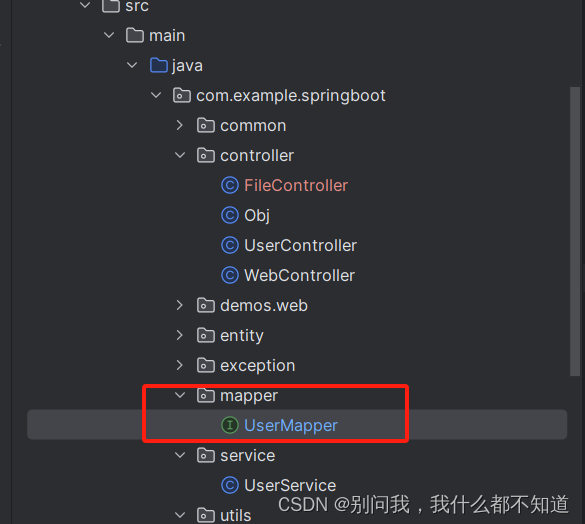

先引入VQA相关的库,如果online安装不了,就去hugging face下载如下文件走offline模式。

from transformers import pipeline

vqa_pipeline = pipeline("visual-question-answering")

# Load your image (replace with actual path)

image = Image.open("cat.jpg")# Define your question

question = "What color is the cat?"# Generate answer using CLIP VQA pipeline

answer = vqa_pipeline(image=image, question=question)# Print the answer

print(f"Answer: {answer[0]['answer']}")

print(f"Confidence Score: {answer[0]['score']:.2f}")