信息检索中的大语言模型

- 大语言模型提升信息检索任务

- 利用大语言模型进行信息检索

- 大语言模型增强的信息检索模型.

- 检索增强的大语言模型

- 输入优化策略.

- 指令微调策略.

- 预训练策略.

- 总结

- 应用建议

- 未来方向

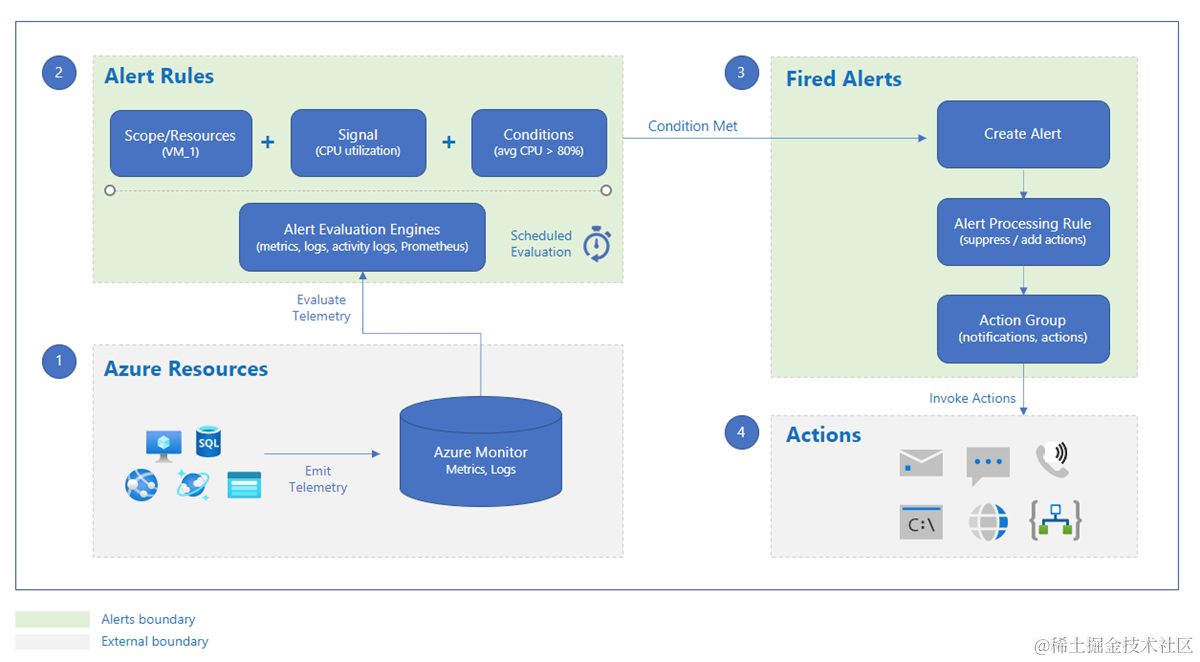

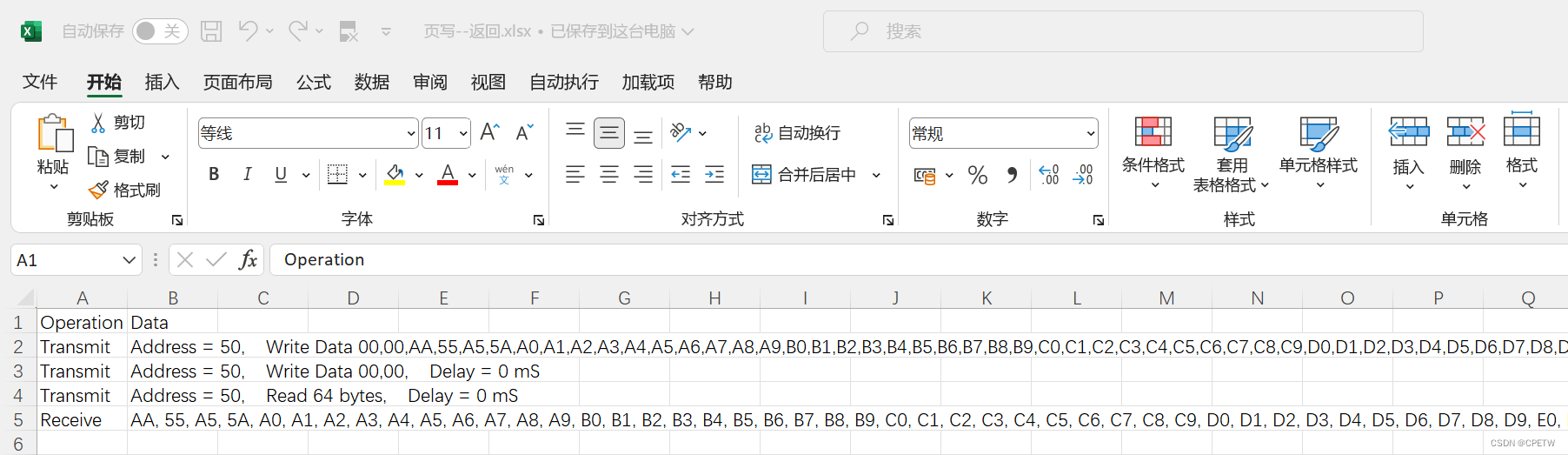

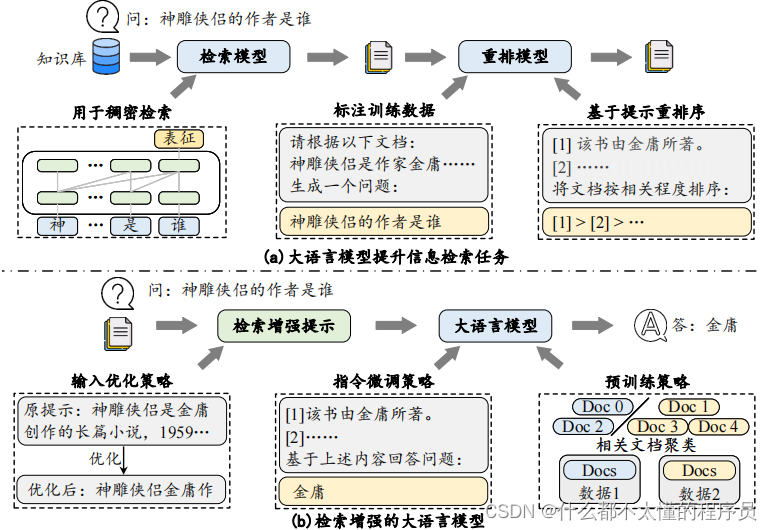

大语言模型对于传统信息检索技术与应用范式带来了重要影响。这两者在技术路径上具有紧密的互补性。大语言模型拥有强大的语言理解、推理与生成能力,能够助力构建更为智能的信息检索系统;而信息检索技术能够高效地从外界获取所需要的相关信息,可以为大语言模型提供更为精确、可靠的上下文信息。本部分将概要介绍如何利用大语言模型提升信息检索效果,以及检索增强的大语言模型,如下图:

大语言模型提升信息检索任务

首先,针对第一个方面展开探讨,介绍大语言模型如何推动信息检索领域的技术发展,包括利用大语言模型进行信息检索和大语言模型增强的信息检索模型。

利用大语言模型进行信息检索

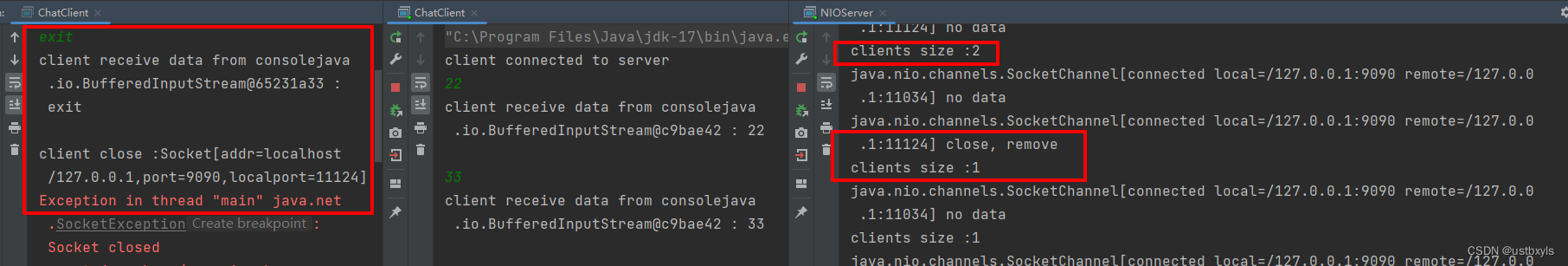

现代信息检索系统通常采用检索-重排序的流水线框架。在这个框架内,检索模型首先从大规模语料库中检索相关的候选信息,然后由重排序模型对候选信息进行精细排序,以优化检索结果。利用大语言模型改进信息检索系统的研究工作主要可以分为两类。第一类方法将语言模型作为检索基座模型,其沿用以往稠密检索的训练方法,通过在检索数据上进行微调,构建检索器或重排序器,利用大语言模型较好的语义理解能力,提升文本表示的质量,进而提高检索效果。由于检索任务对于效率要求较高,研究人员一般使用规模相对较小的语言模型(如 Mistral-7B)用于稠密检索。第二类方法通过设计特殊的指令(例如“请判断下述查询和文档的相关程度”),直接引导大语言模型生成两者的相关程度(如相关度分类或者打分),用于对候选文档集合进行排序以完成检索任务。出于效率考虑,大多数研究工作主要将大语言模型应用于重排序阶段,通常可以采用逐点评测法(Pointwise)、成对比较法(Pairwise)以及列表排序法(Listwise)三种方法对于召回的候选文档列表进行重排序。

大语言模型增强的信息检索模型.

由于大语言模型具有出色的语义理解与生成能力,其可以为信息检索模型补充相关性信息。主要可以分为以下两类方法。第一类方法通过构造特殊的提示,使得大语言模型能够充当人类标注者的角色,以较低成本完成大规模训练数据的标注工作,为传统检索模型补充高质量标注数据。例如,针对检索语料库中的文档,可以引导大语言模型基于该文档生成一个候选查询,并将这组数据对扩充到训练数据中,实现训练数据增强。第二类方法同样通过设计特殊的提示,利用大语言模型对输入查询进行改写,辅助信息检索模型精准理解用户的需求。此外,还可以利用大语言模型对查询进行详细解释和扩充,并将这些内容附加到原始查询之后,帮助信息检索模型获取更全面的结果。

检索增强的大语言模型

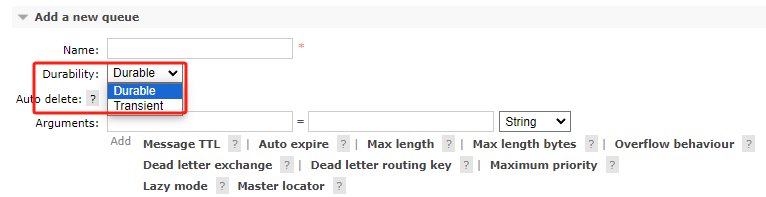

受限于训练数据的时效性和局限性,当涉及实时新闻或特定专业领域内知识时,大语言模型的生成结果可能不够准确。为弥补这一不足,研究人员引入了检索增强生成(Retrieval-Augmented Generation, RAG)技术。该技术旨在通过信息检索系统从外部知识库中获取相关信息,为大语言模型提供时效性强、领域相关的外部知识,以减少大语言模型生成内容中的错误。然而,真实的应用场景下,检索返回的结果可能受限于检索质量、呈现格式、输入长度等问题,从而导致大语言模型不能很好地利用这些信息。为了使大语言模型在检索增强生成场景中有更好的表现,本节将介绍三种改进策略:输入优化,指令微调,和预训练策略。

输入优化策略.

在检索增强生成的场景中,大语言模型主要面临两个主要挑战。首先,当处理包含多个参考文档的长文本时,其信息利用能力往往会下降;其次,检索到的结果中可能包含与任务无关的文档,这可能会干扰模型对关键信息的识别和处理。为了克服这些挑战,可以使用过滤、压缩、摘要等技术,在文档和词元两个层级优化模型输入。在文档层面,可以使用相关度排序模型度量文档与查询之间的相关程度,过滤与查询相关程度较低的候选文档。在词元层面,可以采用压缩或摘要方法来实现更细粒度的内容优化。具体来说,可以使用自动摘要模型对查询和检索文档生成综合性摘要,从中抽取更加精炼且与查询紧密相关的内容。由于这一过程可能会丢失重要的信息(例如人名中姓氏被删除),故可以预先对关键实体等重要信息进行抽取和保留,之后再对其进行恢复。

指令微调策略.

指令微调策略可以用来加强大语言模型对于检索结果中所包含信息的利用能力。该策略的核心在于构造面向检索文档利用的指令数据,并通过对大语言模型进行微调,提升其对文档信息的处理和理解能力。在指令设计时,需要关注两个问题。首先,需要确保模型能够平等地关注输入中不同位置(如开头、中间、结尾)的内容,以缓解某些位置的信息容易被忽略的问题(如中间位置)。其次,当存在不相关信息的检索文档时,大语言模型应尽可能地避免被这些信息干扰。基于这两点,可以通过添加特殊的指令数据,例如将相关文档放置于不同的位置,或包含不相关文档,以提升大语言模型在检索增强生成任务上的表现。

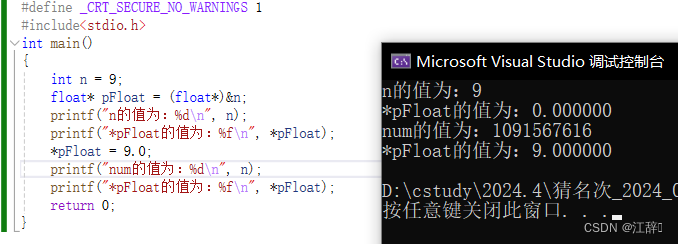

预训练策略.

如果大语言模型最终主要用于信息检索任务,还可以在预训练阶段采用特殊的学习任务对其检索生成能力进行针对性的加强。一种常见的策略是将语料库中文档的标题或第一段文字作为查询,其余内容作为期望的生成结果,调用检索器依据查询获得相关文档。也有一些研究工作将每段话分为长度相等的两部分,其中前半部分作为查询,后半部分作为期望的生成结果。为了进一步强化大模型理解和利用相关文档的能力,还可以基于聚类方法构造相关文档集合,通过拼接关联文档以得到针对性的预训练数据。

总结

下面总结大语言模型与信息检索技术融合的应用建议与未来研究方向。

应用建议

信息检索技术和大语言模型可以互相促进。在提升信息检索系统方面,大语言模型凭借其强大的语义理解能力,能够作为检索或重排序基座模型。此外,大语言模型还可以为信息检索任务提供高质量标注数据和或用于改写用户查询,进一步提升信息检索模型的性能。在另一方面,信息检索系统能够从其他数据源中为大语言模型提供相关参考信息,能够缓解大语言模型无法获取实时信息与领域信息的问题,进而提升大语言模型在知识密集型任务中的表现。

未来方向

目前来说,大语言模型与信息检索技术的融合也存在一些技术挑战。首先,大语言模型需要大规模的算力资源支持,在真实信息检索场景中难以广泛进行部署。因此,如何确定大语言模型的应用场景,以及如何将其与小型检索模型进行有效结合,是平衡效率和性能的关键问题。其次,下游场景中并不总是需要检索增强,大语言模型凭借自身内部知识可能就足以支持某些任务。因此,如何设计可以进行主动性触发与使用检索机制是一个值得研究的方向。此外,检索结果中可能包含长度较长的文本内容,而且其中可能存在噪声信息,如何加强大语言模型对于上下文中相关信息的选择与利用,也具有重要的研究意义。