利用CUDA加速卷积计算:原理、实践与示例代码

在深度学习领域,卷积神经网络(Convolutional Neural Networks,CNN)是目前最流行和有效的模型之一。然而,随着模型复杂度的增加,卷积计算的计算量也随之增加,这使得在CPU上进行卷积计算变得非常耗时。因此,利用CUDA加速卷积计算成为了一个热门话题。在本文中,我们将详细介绍如何利用CUDA加速卷积计算,包括原理、实践和示例代码,帮助您更好地理解和应用CUDA加速技术。

CUDA加速原理

1.1 CUDA架构

NVIDIA推出的CUDA(Compute Unified Device Architecture)架构是目前最流行的GPU编程模型之一。CUDA架构将GPU抽象为一个多线程并行处理器,并提供了一套丰富的编程接口,使得开发者可以轻松地将计算任务分配到GPU上执行。

1.2 卷积计算的并行化

卷积计算可以被分解为多个独立的乘加操作,这些操作可以并行执行。在CUDA中,我们可以将这些操作分配给不同的线程,从而充分利用GPU的并行计算能力。

1.3 共享内存和常量内存

在CUDA中,共享内存和常量内存是两种重要的内存类型。共享内存是线程块内所有线程共享的内存空间,可以用于加速线程块内数据的共享和通信。常量内存是只读内存空间,可以用于存储卷积核等常量数据,从而减少全局内存访问次数并提高性能。

实践:利用CUDA加速卷积计算

2.1 环境配置

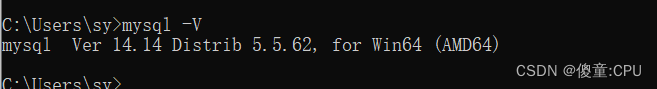

要利用CUDA加速卷积计算,首先需要配置合适的环境。您可以按以下步骤进行配置:

安装CUDA驱动和CUDA Toolkit。

安装支持CUDA加速的深度学习框架,如TensorFlow、PyTorch或MXNet。

确保您的GPU支持CUDA,并配置好相应的环境变量。

2.2 卷积计算的CUDA实现

在CUDA中,我们可以使用CUDA C/C++语言编写卷积计算的核函数。以下是一个简单的CUDA核函数示例,用于实现2D卷积计算:

__global__ void conv2d(float *input, float *kernel, float *output, int width, int height, int kernel_size) {int x = blockIdx.x * blockDim.x + threadIdx.x;int y = blockIdx.y * blockDim.y + threadIdx.y;if (x < width && y < height) {float sum = 0;for (int i = 0; i < kernel_size; i++) {for (int j = 0; j < kernel_size; j++) {int input_x = x + i - kernel_size / 2;int input_y = y + j - kernel_size / 2;if (input_x >= 0 && input_x < width && input_y >= 0 && input_y < height) {sum += input[input_y * width + input_x] * kernel[i * kernel_size + j];}}}output[y * width + x] = sum;}

}在主机端,我们可以使用以下代码调用上述核函数:

```cpp

int main() {// ...// 配置核函数参数dim3 block_size(16, 16);