- Paper:https://arxiv.org/pdf/2311.10122v2

- Github:https://github.com/PKU-YuanGroup/Video-LLaVA

- Huggingface:https://huggingface.co/spaces/LanguageBind/Video-LLaVA

- Author:Bin Lin et al. 北大袁粒团队

文章目录

- 1 Video-LLaVA总结(省流版)

- 1.1 Video-LLaVA是什么?

- 1.2 Video-LLaVA能干什么?

- 1.2.1 Image understanding

- 1.2.2 Video understanding

- 2 Method

- 3 训练细节

- 4 相关数据

- 参考资料

1 Video-LLaVA总结(省流版)

1.1 Video-LLaVA是什么?

Video-LLaVA是北大袁粒团队提出的一个视觉理解模型,是他们之前工作的延申LanguageBind。

核心创新点: 通过将Image和Video特征隐射到一个统一的视觉空间进行对齐,得到统一的visual representation。

当前LLM模型的问题:

- LLMs as scheduler: 视觉模型被作为即插即用模块,LLM根据特定的任务来schedule(VisualChatGPT、HuggingGPT、MM-REACT、ViperGPT),这些模型不需要端到端训练,也无需对每种模态进行联合和训练和对齐;

- LLMs as decoder:

- MiniGPT-4:使用线性投影层将图像与文本对齐;这种对齐很弱且缺乏人类指令反馈;

- mPLUG-Owl:2阶段:先自回归将图像和文本对齐,再使用人类指令进行微调;

- InstructBLIP、LLaVA:使用人类指令数据集进行端到端训练;

- VideoChat、VideoLLaMA:通过联合训练来实现对齐,可同时处理图像和视频。

1.2 Video-LLaVA能干什么?

Video-LLaVA可以实现是视觉理解,即图像、视频问答:

1.2.1 Image understanding

1.2.2 Video understanding

2 Method

- LanguageBind [也是他们组的工作]:

- 能从多种模态(image、video)中提取特征隐射到文本特征的空间;

- 使用ViT-L/14初始化(OpenCLIP);

- 参数冻结

- LLM: Vicuna-7B v1.5;

- Projection layer: 2 fully connected layers;

- Word embedding layer: LLaMA;

3 训练细节

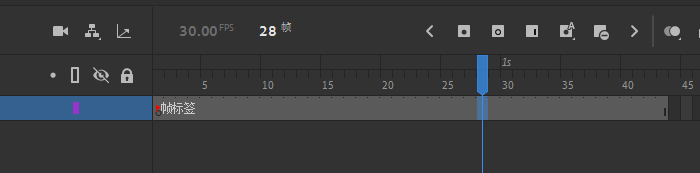

- Stage1 Understanding training:使用question+visual feature作为输入,answer作为gt;

- 558K LAION-CC-SBU image-text pairs

- 702k video-text pairs WebVid(Valley)

- Stage2 Instruction tuning:对话轮数大于1时,需要concat之前所有的对话和回答作为输入;

- 665k image-text pairs LLaVA v1.5

- 100k video-text pairs Video-ChatGPT

数据处理方式:

- Image: resize&crop,224x224

- Video:均匀采样8帧,每帧处理与image一致

每个batch中随机组合image和videos:

- Stage1: batchsize=256

- Stage2: batchsize=128

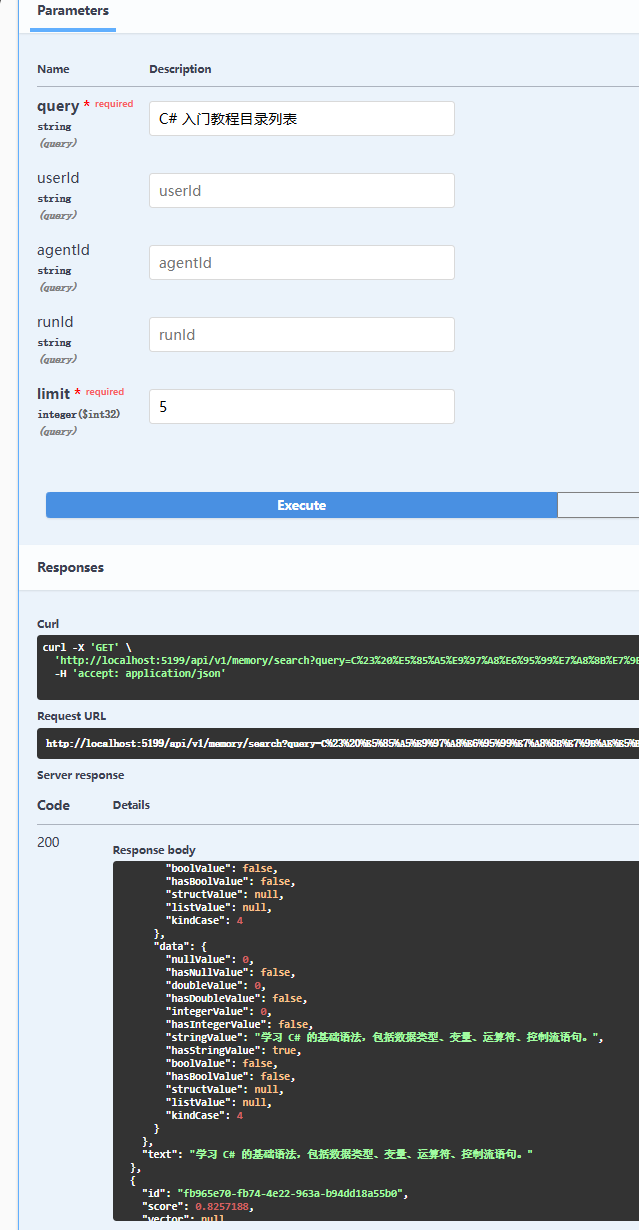

4 相关数据

- The images pretraining dataset is from LLaVA

- The images tuning dataset is from LLaVA.

- The videos pretraining dataset is from Valley

- The videos tuning dataset is from Video-ChatGPT

| Datasets | Baidu Disk | Size |

|---|---|---|

| Image pretraining | Link | 25.48G |

| Image tuning | Link | 66.44G |

| Video pretraining | Link | 431.87G |

| Video tuning | Link | 160.07G |

参考资料

[1] LanguageBind

[2] LLaVA

[3] Valley

[4] Video-ChatGPT

![[云原生]三、Kubernetes(1.18)](https://i-blog.csdnimg.cn/direct/733b5754ee894f95aa9ebe5ab6ddb36d.png)