目录

前言

一、DBSCAN算法

1.动图展示(图片转载自网络)

2.步骤详解

3.参数配置

二、代码实现

1.完整代码

2.代码详解

1.导入数据

2.通过循环确定参数最佳值

总结

前言

DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法。它可以发现任意形状的簇并能够处理噪声数据。

一、DBSCAN算法

1.动图展示(图片转载自网络)

- 如图所示是DBSCAN算法的实现过程

- 这里使用参数是半径为1,最小样本量为4

2.步骤详解

- 初始化:从数据集中的每个点开始,初始化簇的构建。

- 核心点检测:判断每个点是否为核心点(即其邻域点的数量是否大于或等于

min_samples)。 - 簇扩展:

- 对于每个核心点,将其邻域内的所有点添加到簇中。

- 递归扩展这些点的邻域,直到簇扩展完成。

- 标记噪声点:那些没有被包含在任何簇中的点被标记为噪声点。

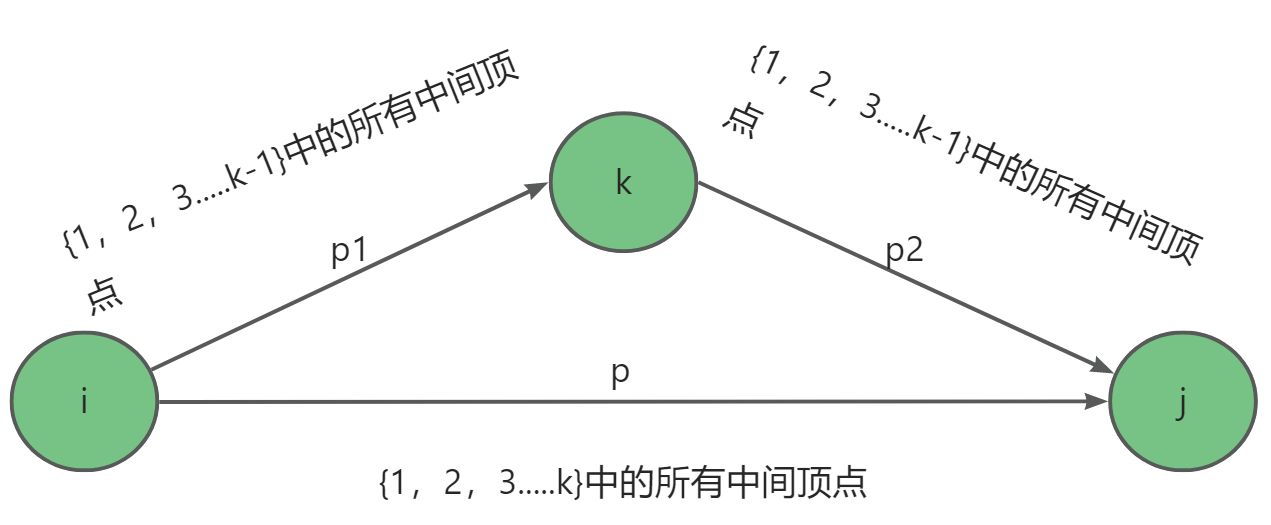

如图所示:

- 从A点开始,根据给定半径判断邻域内样本数是否符合给定最小样本量从而确定该点是不是核心

- 再遍历该邻域内每个点,重复上述步骤

- 直到某个点邻域内样本数小于给定最小样本量

- 至此簇扩展完成

- 此图 A B C 三点为一个簇内的点 N是离群点

3.参数配置

-

eps: 定义了一个点的邻域的最大距离(即半径)。如果一个点的邻域内有至少min_samples个点,则这些点被认为是一个簇的一部分。 -

min_samples: 形成一个簇所需的最小点数。如果一个点的邻域内的点数大于或等于min_samples,则这些点被视为核心点,并且它们的邻域中的点将成为同一簇的一部分。

二、代码实现

1.完整代码

import pandas as pd

from sklearn.cluster import DBSCAN

from sklearn import metricsdata = pd.read_csv('data.txt', sep=' ')

x = data.iloc[:, 1:5]

# from sklearn.preprocessing import StandardScaler

# std = StandardScaler()

# x = std.fit_transform(x)"""

eps:半径

min_samples:最小密度

labels:分类结果 自动分类 -1为离群点

"""

scores = []

for i in range(2, 20):db = DBSCAN(eps=i, min_samples=2).fit(x)labels = db.labels_score = metrics.silhouette_score(x, labels)scores.append(score)print(scores)

best_i = scores.index(max(scores)) + 2

print("最佳半径为:", best_i)

db = DBSCAN(eps=best_i, min_samples=2).fit(x)

labels = db.labels_

score = metrics.silhouette_score(x, labels)

print("此时轮廓指数为:", score)data['cluster_db'] = labels

data = data.sort_values('cluster_db', ascending=True)pass

输出结果:

[-0.03670705609846274, -0.03670705609846274, -0.06781609566358748, -0.06781609566358748, 0.1626084889128696, 0.12626205982196476, 0.16564759416041527, 0.42951251219183106, 0.49530955296776086, 0.49530955296776086, 0.49530955296776086, 0.49530955296776086, 0.5857040721127795, 0.5857040721127795, 0.5238781710613801, 0.5238781710613801, 0.6731775046455796, 0.6731775046455796]

最佳半径为: 18

此时轮廓指数为: 0.6731775046455796

2.代码详解

1.导入数据

可以进行标准化也可以不进行标准化

import pandas as pd

from sklearn.cluster import DBSCAN

from sklearn import metricsdata = pd.read_csv('data.txt', sep=' ')

x = data.iloc[:, 1:5]

# from sklearn.preprocessing import StandardScaler

# std = StandardScaler()

# x = std.fit_transform(x)

2.通过循环确定参数最佳值

- 最后还将分类好的标签添加进了原数据

- 聚类算法通过轮廓系数来评价算法的好坏:

- 轮廓系数范围在[-1,1]之间。该值越大,越合理

"""

eps:半径

min_samples:最小密度

labels:分类结果 自动分类 -1为离群点

"""

scores = []

for i in range(2, 20):db = DBSCAN(eps=i, min_samples=2).fit(x)labels = db.labels_score = metrics.silhouette_score(x, labels)scores.append(score)print(scores)

best_i = scores.index(max(scores)) + 2

print("最佳半径为:", best_i)

db = DBSCAN(eps=best_i, min_samples=2).fit(x)

labels = db.labels_

score = metrics.silhouette_score(x, labels)

print("此时轮廓指数为:", score)

data['cluster_db'] = labels

data = data.sort_values('cluster_db', ascending=True)

输出:

总结

两种聚类算法已讲完,聚类算法适合原本没有标签只有特征的数据进行使用