引言

神经网络是机器学习的一种方法,它通过模拟人脑神经元的工作原理来构建算法

文章目录

- 引言

- 一、神经网络

- 1.1 定义

- 1.2 主要组成部分

- 1.3 工作原理

- 1.4 应用

- 1.5 类型

- 1.6 优化算法

- 1.7 总结

- 二、隐藏层

- 2.1 定义

- 2.2 隐藏层的作用

- 2.3 隐藏层的数量和大小

- 2.4 隐藏层的结构

- 2.5 激活函数

- 2.6 如何选择隐藏层的数量

- 2.7 总结

- 三、胶囊网络(Capsule Network,CapsNet)

- 3.1 胶囊网络的定义

- 3.2 胶囊网络对神经网络领域产生的影响

- 3.3 总结

一、神经网络

1.1 定义

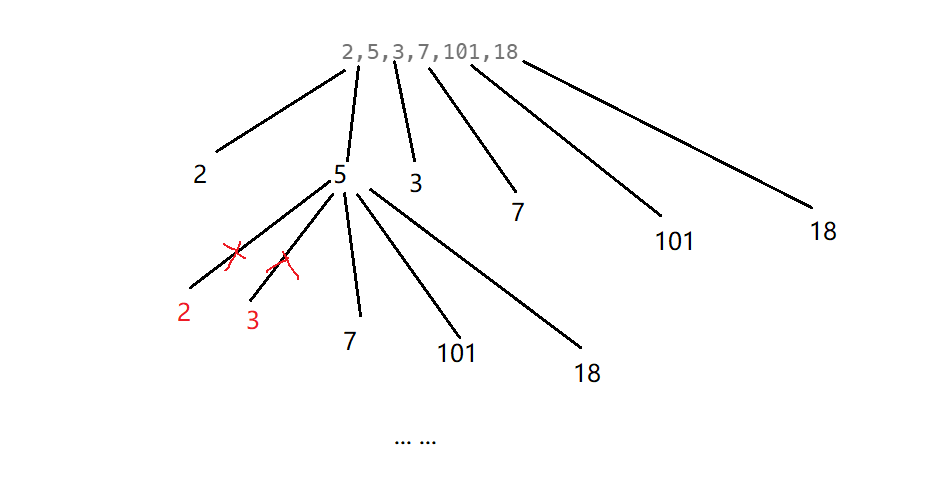

神经网络由大量相互连接的节点(称为神经元)组成,这些节点分为不同的层次:输入层、隐藏层和输出层。每个神经元接收来自前一层节点的输入,并通过一个激活函数(如Sigmoid、ReLU等)处理这些输入,然后将结果传递给下一层

1.2 主要组成部分

- 输入层:接收输入数据

- 隐藏层:包含大量神经元,用于处理和传递数据。一个神经网络可以有多个隐藏层

- 输出层:产生最终结果

- 权重和偏置:连接不同神经元的参数,决定了数据在网络中的流动方式

- 激活函数:用于将神经元的输入值转换为输出值

1.3 工作原理

- 前向传播:数据从输入层开始,经过隐藏层,最后到达输出层。在每个节点,输入数据与权重和偏置相乘,然后通过激活函数处理

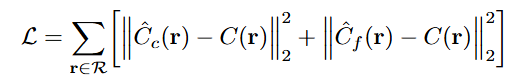

- 反向传播:通过计算输出与实际值之间的差异(即误差),然后根据误差调整权重和偏置。这个过程称为梯度下降

- 迭代:重复前向传播和反向传播过程,每次迭代都使得模型对数据的拟合程度更高

1.4 应用

神经网络在许多领域都有广泛应用,包括图像识别、自然语言处理、推荐系统等

1.5 类型

- 前馈神经网络:最常见的神经网络类型,包括多层感知机(MLP)、卷积神经网络(CNN)等

- 递归神经网络:用于处理序列数据,包括循环神经网络(RNN)、长短期记忆网络(LSTM)等

- 自编码器:用于特征提取和降维

- 生成对抗网络(GANs):用于生成新的数据,如图像、音频等

1.6 优化算法

- 梯度下降:最常用的优化算法,用于调整权重和偏置

- 随机梯度下降(SGD):在每次迭代中只使用一个样本的梯度

- 动量法:结合历史梯度信息,加快收敛速度

- 自适应学习率算法:如Adagrad、Adam等,根据梯度的大小动态调整学习率

1.7 总结

神经网络是一种强大的机器学习工具,但它们也存在一些挑战,如过拟合、参数调整等。在使用神经网络时,需要仔细设计网络结构、选择合适的激活函数和优化算法,并进行充分的训练和验证

二、隐藏层

2.1 定义

在神经网络中,隐藏层(Hidden Layer)是一个或多个位于输入层和输出层之间的层,它们对输入数据进行变换和处理,以学习数据的复杂模式和特征。隐藏层是神经网络能够进行高级特征提取和模式识别的关键组成部分

2.2 隐藏层的作用

- 特征提取:隐藏层能够从原始输入数据中提取出更加抽象和有用的特征,这些特征对于解决复杂问题至关重要

- 非线性建模:隐藏层可以捕捉数据中的非线性关系,这是许多实际问题中的常见特征。通过非线性变换,神经网络可以学习到输入数据中复杂的模式

- 增加模型的表达能力:隐藏层越多,神经网络的表达能力就越强,它可以学习到更加复杂的函数。然而,过多的隐藏层也可能导致过拟合

- 多任务学习:在某些情况下,隐藏层可以同时学习到多个相关的任务,从而实现多任务学习

2.3 隐藏层的数量和大小

- 数量:隐藏层的数量取决于具体问题的复杂性和数据的特点。在实践中,通常需要通过实验来确定最佳的隐藏层数量

- 大小:隐藏层的大小通常指该层中神经元的数量。更大的隐藏层可以提供更多的特征表示,但同时也可能导致模型复杂度增加,需要更多的数据和计算资源

2.4 隐藏层的结构

隐藏层可以有不同的结构,常见的包括:

- 全连接层:每个神经元都连接到输入层的所有神经元,以及下一层的每个神经元

- 卷积层:在图像识别等任务中常用,它允许神经元只与输入数据的一个局部区域进行连接

- 递归层:在处理序列数据时使用,神经元不仅与当前的输入数据连接,还与之前的输入数据连接

2.5 激活函数

隐藏层的神经元通常使用激活函数来增加模型的非线性能力。常见的激活函数包括:

- Sigmoid:将输入值压缩到0到1之间

- ReLU:将负值设置为0,正值保持不变

- Tanh:类似于Sigmoid,但压缩到-1到1之间

- Softmax:用于分类问题,将神经元的输出转换为概率分布

2.6 如何选择隐藏层的数量

选择隐藏层数量是一个复杂的过程,通常需要通过实验和交叉验证来确定最佳设置

- 问题复杂性:如果问题的复杂性较高,可能需要更多的隐藏层来捕捉数据中的复杂模式

- 数据集大小:数据集越大,通常可以容忍更多的隐藏层,因为更多的数据有助于模型学习

- 计算资源:隐藏层数量的增加会带来更多的参数和计算需求。确保您有足够的计算资源来训练更复杂的模型

- 过拟合风险:增加隐藏层数量可能会增加过拟合的风险。可以通过交叉验证来评估模型的泛化能力

- 性能指标:使用不同的性能指标(如准确率、损失函数等)来评估不同隐藏层数量的模型性能

- 经验法则:一些研究者提出了一些经验法则,如“每增加一层,训练时间增加大约一个数量级”,但这并不是一个严格的规则

- 架构搜索:使用自动化架构搜索工具,如神经架构搜索(NAS),可以帮助找到最佳的隐藏层数量和结构

- 模型复杂度与数据量的平衡:通常,模型复杂度应该与数据量相匹配。如果数据量较小,过多的隐藏层可能会导致过拟合

- 模型评估:在训练过程中定期评估模型的性能,并根据需要调整隐藏层数量

- 专家意见:如果可能,可以咨询领域内的专家,他们可能会提供关于隐藏层数量的建议

2.7 总结

隐藏层的设计是神经网络构建中的一个重要方面,它直接影响到模型的性能和训练难度。通过合理设计隐藏层的数量、大小和结构,可以构建出适合特定任务的神经网络模型

三、胶囊网络(Capsule Network,CapsNet)

3.1 胶囊网络的定义

胶囊网络(Capsule Network,CapsNet)是由Hinton及其团队在2017年提出的一种新型神经网络架构,它旨在解决传统卷积神经网络(CNN)在某些任务中的局限性,特别是对于视角变化、大小变化、光照变化和遮挡等问题的鲁棒性

3.2 胶囊网络对神经网络领域产生的影响

- 对传统CNN的改进:传统的CNN在处理物体检测和图像识别任务时,对物体姿态和外观的变化比较敏感。胶囊网络通过引入胶囊的概念,能够更好地捕捉物体的整体形状和姿态,从而提高了对物体变化的鲁棒性

- 提高模型的泛化能力:胶囊网络的设计使得模型能够学习到更加鲁棒的特征表示,这有助于提高模型的泛化能力,使其能够更好地适应新环境和任务

- 对网络架构的创新:胶囊网络提出了胶囊和动态路由(Dynamic Routing)的概念,这些新的设计元素为神经网络架构的创新提供了新的思路

- 对优化算法的挑战:胶囊网络的动态路由机制和内部表示的计算方式对传统的优化算法提出了挑战,需要开发新的算法来有效地训练胶囊网络

- 推动多模态学习:胶囊网络的多胶囊结构为多模态学习提供了可能,使得模型能够同时处理来自不同模态(如图像、文本、声音等)的数据

- 促进计算机视觉研究:胶囊网络的出现推动了计算机视觉领域的研究,特别是在物体检测、图像识别和图像分割等任务上

3.3 总结

尽管胶囊网络在理论上具有许多优点,但它在实际应用中仍然面临一些挑战,如计算复杂性、训练难度和参数优化等。因此,胶囊网络的研究和应用仍在不断发展中

统一的列表初始化 | 声明 | STL中一些变化 | emplace的优化 | move](https://img-blog.csdnimg.cn/img_convert/ecb438f417b16dbff5c3ad423317cb6b.png)

![[米联客-XILINX-H3_CZ08_7100] FPGA程序设计基础实验连载-24 TPG图像测试数据发生器设计](https://i-blog.csdnimg.cn/direct/96f5dbecc8654442a4ac28421b147546.png)