目录

一、准备工作

二、基础理论知识

三、步骤详解

数据预处理

情感分析

关键词提取

四、案例分享

数据爬取

数据分析

五、优化

六、结论

在当今信息爆炸的时代,社交媒体平台如微博已成为公众表达意见和情感的重要渠道。微博舆情分析通过对大量微博数据进行挖掘和分析,可以揭示公众对某些事件或话题的态度和情绪。本文将详细介绍如何使用Python进行微博舆情分析,包括数据获取、预处理、情感分析、关键词提取和数据可视化等步骤,并附上完整的代码示例和案例,希望对新手朋友有所帮助。

一、准备工作

在进行微博舆情分析之前,需要做一些准备工作,包括数据获取、环境搭建和依赖库的安装。

数据获取

- 微博API:通过微博开放平台提供的API获取微博数据。申请API权限并遵守API的使用规定。

- 爬虫技术:使用Python的爬虫框架如Scrapy或BeautifulSoup进行微博数据抓取。需要注意的是,爬虫技术需遵守相关法律法规和网站的robots.txt协议,避免过度抓取导致IP被封禁。

环境搭建

- Python版本:建议使用Python 3.6及以上版本。

- 依赖库:安装必要的Python库,如requests(用于HTTP请求)、pandas(用于数据处理)、jieba(用于中文分词)、snownlp或gensim(用于情感分析)。

pip install requests pandas jieba snownlp

二、基础理论知识

- 分词:将句子拆分成单词或词组,是中文文本处理的基础。

- 情感分析:判断文本的情感倾向,如正面、负面或中立。

- 关键词提取:从文本中提取出重要的词语或短语。

三、步骤详解

数据预处理

数据预处理是舆情分析的重要步骤,包括去除HTML标签、特殊字符和停用词,以及中文分词。

import pandas as pd

import requests

import jieba

import matplotlib.pyplot as plt

from wordcloud import WordCloud

from snownlp import SnowNLP

from sklearn.feature_extraction.text import TfidfVectorizer# 假设微博数据已经存储在CSV文件中

data = pd.read_csv('weibo_data.csv')# 去除HTML标签和换行符

def preprocess_text(text):text = requests.utils.unquote(text)text = text.replace('<br />', '')text = text.replace('\n', '')# 去除停用词stopwords = set(['的', '了', '在', '是', '我', '你', '他', '她', '它', '们', '有', '和', '都', '一', '个', '上', '下', '不'])words = jieba.cut(text)filtered_words = [word for word in words if word not in stopwords]return ' '.join(filtered_words)data['processed_text'] = data['text'].apply(preprocess_text)情感分析

使用snownlp进行情感分析,snownlp提供了简单的接口来判断文本的情感倾向。

def sentiment_analysis(text):s = SnowNLP(text)return s.sentiments # 情感得分,0.0-1.0表示负面到正面data['sentiment'] = data['processed_text'].apply(sentiment_analysis)# 绘制情感分布图

plt.figure(figsize=(10, 6))

plt.hist(data['sentiment'], bins=20, alpha=0.75, color='blue', edgecolor='black')

plt.title('Sentiment Distribution')

plt.xlabel('Sentiment Score')

plt.ylabel('Frequency')

plt.grid(axis='y', alpha=0.75)

plt.show()关键词提取

使用TF-IDF(词频-逆文档频率)算法进行关键词提取。

tfidf_vectorizer = TfidfVectorizer()

tfidf_matrix = tfidf_vectorizer.fit_transform(data['processed_text'])

feature_names = tfidf_vectorizer.get_feature_names_out()# 获取前10个关键词

top_n_words = 10

top_tfidf_feat = tfidf_matrix.toarray().sum(axis=0)

top_indices = top_tfidf_feat.argsort()[-top_n_words:][::-1]

top_words = [feature_names[i] for i in top_indices]# 绘制词云图

wordcloud = WordCloud(width=800, height=400, background_color='white').generate(' '.join(top_words))

plt.figure(figsize=(10, 5))

plt.imshow(wordcloud, interpolation='bilinear')

plt.axis('off')

plt.show()四、案例分享

以下是一个具体的微博舆情分析案例,通过爬取某条微博的评论数据,并进行情感分析和可视化展示。

数据爬取

使用Python的requests库和正则表达式爬取微博评论数据。

import requests

import re

import time

import randomheaders = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}params = (('id', '4654152979845247'),('mid', '4654152979845247'),('max_id_type', '0'),

)for page in range(1, 10000):if page == 1:response = requests.get('https://m.weibo.cn/comments/hotflow', headers=headers, params=params)a = response.json()['data']['max_id']b = response.json()['data']['max_id_type']else:params = (('id', '4654152979845247'),('mid', '4654152979845247'),('max_id', str(a)),('max_id_type', str(b)),)for i in response.json()['data']['data']:pinglunshijian = i['created_at']neirong = re.sub(r'<[^>]*>', '', i['text'])with open('comments.txt', 'a', encoding='utf-8') as f:f.write(f'{neirong}\n')print(f'爬取第{page}页数据......')time.sleep(random.randint(1, 3))数据分析

读取爬取到的评论数据,并进行情感分析和可视化展示。

# 读取评论数据

comments = []

with open('comments.txt', 'r', encoding='utf-8') as f:comments = f.readlines()# 情感分析

sentiments = []

for comment in comments:s = SnowNLP(comment)sentiments.append(s.sentiments)# 绘制情感分布图

plt.figure(figsize=(10, 6))

plt.hist(sentiments, bins=20, alpha=0.75, color='blue', edgecolor='black')

plt.title('Sentiment Distribution of Comments')

plt.xlabel('Sentiment Score')

plt.ylabel('Frequency')

plt.grid(axis='y', alpha=0.75)

plt.show()# 关键词提取和词云图

processed_comments = ' '.join(comments)

tfidf_vectorizer = TfidfVectorizer()

tfidf_matrix = tfidf_vectorizer.fit_transform([processed_comments])

feature_names = tfidf_vectorizer.get_feature_names_out()top_n_words = 20

top_tfidf_feat = tfidf_matrix.toarray().sum(axis=0)

top_indices = top_tfidf_feat.argsort()[-top_n_words:][::-1]

top_words = [feature_names[i] for i in top_indices]# 绘制词云图

wordcloud = WordCloud(width=800, height=400, background_color='white').generate(' '.join(top_words))

plt.figure(figsize=(10, 5))

plt.imshow(wordcloud, interpolation='bilinear')

plt.axis('off')

plt.show()五、优化

通过上述步骤,我们完成了一个简单的微博舆情分析流程,包括数据获取、预处理、情感分析、关键词提取和可视化展示。然而,这只是一个起点,实际项目中可能还需要更多的优化和提升:

数据获取:

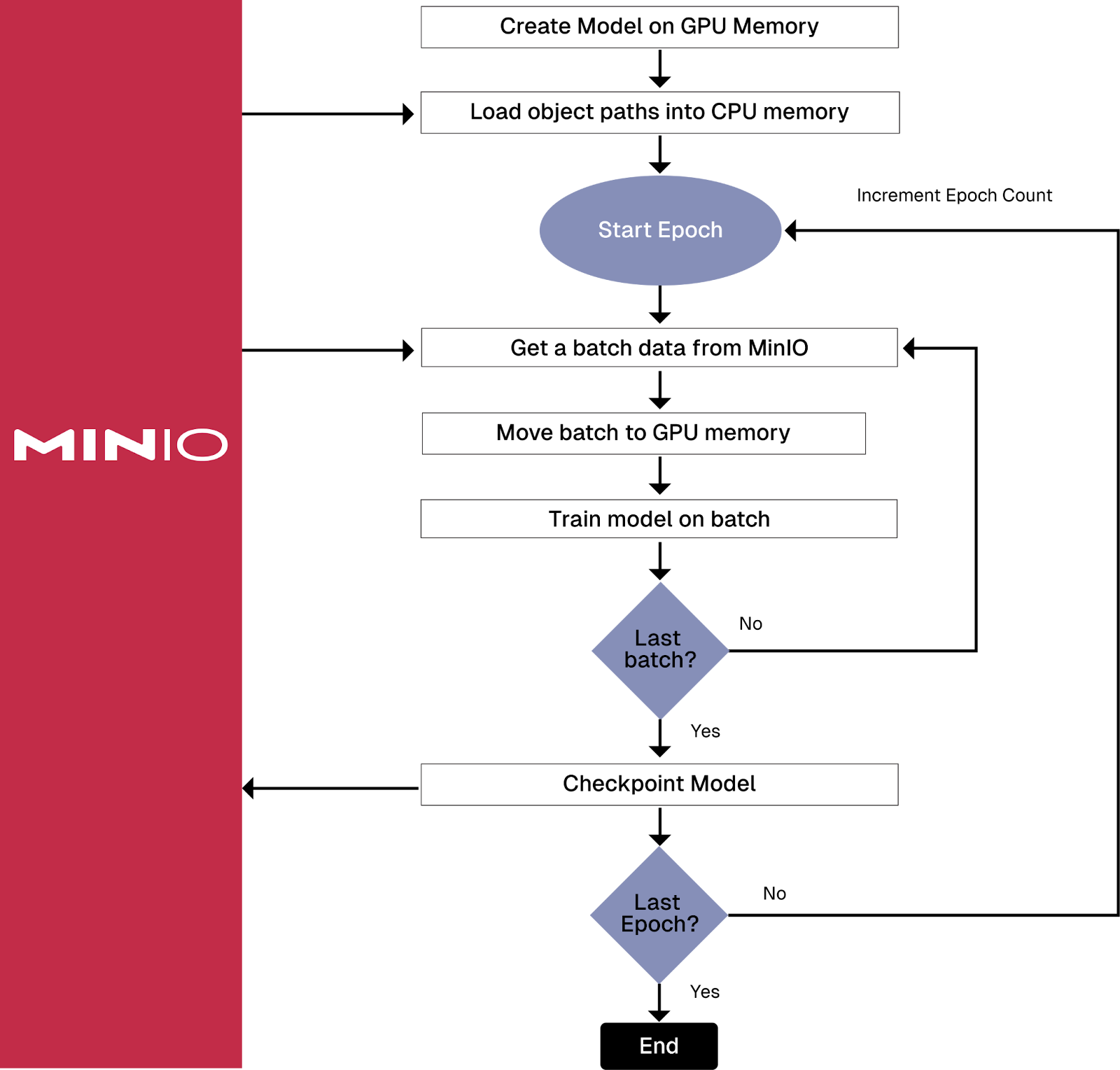

提高数据获取的效率和稳定性,如使用多线程或异步IO。

遵守微博API的使用规定,避免触发反爬虫机制。

数据预处理:

使用更复杂的停用词表和正则表达式,以提高文本清洗的效果。

尝试使用更先进的分词工具,如LTP或Stanford NLP。

情感分析:

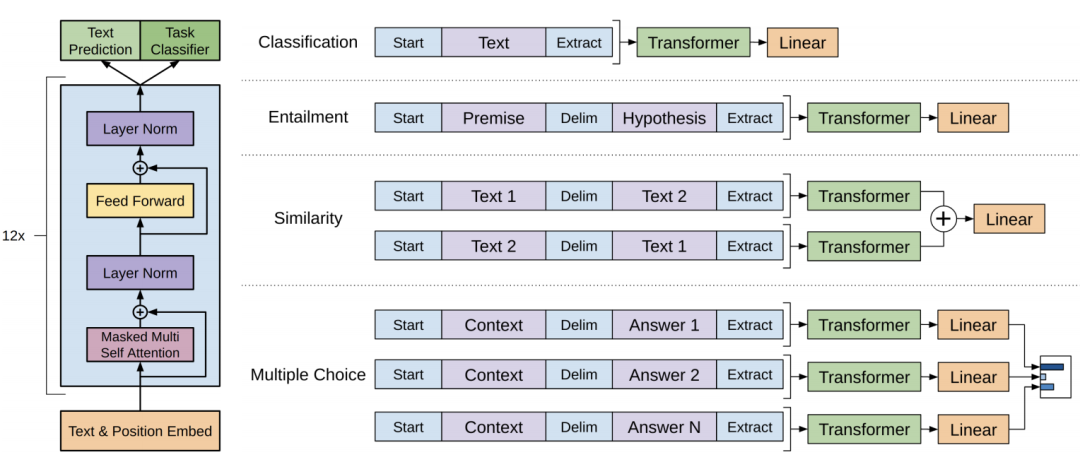

尝试使用深度学习模型(如BERT或GPT)进行情感分析,以提高准确性。

结合上下文信息,进行更细粒度的情感分析。

关键词提取:

除了TF-IDF,还可以尝试使用TextRank或LDA等算法进行关键词提取。

结合领域词典,提取更具领域特色的关键词。

可视化展示:

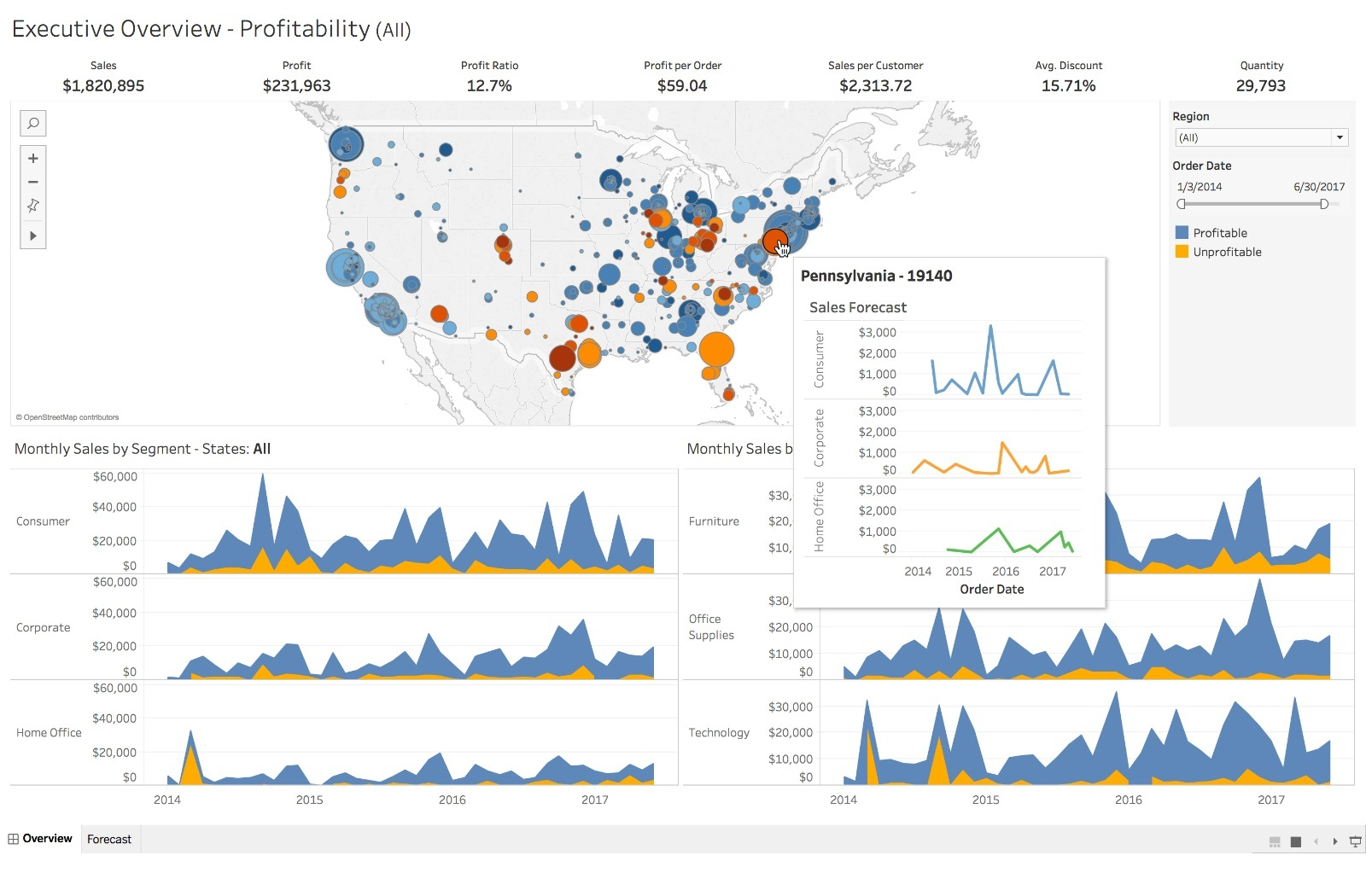

使用更丰富的图表类型,如热力图、雷达图等,展示分析结果。

将分析结果嵌入到交互式仪表盘中,方便用户查看和交互。

六、结论

微博舆情分析是一个复杂而有趣的任务,通过Python和相关的自然语言处理技术,我们可以有效地挖掘和分析微博数据,揭示公众对某些事件或话题的态度和情绪。希望本文能为新手朋友提供一个入门级的指导,并在未来的实践中不断学习和提升。

![[HCTF 2018]WarmUp 1--详细解析](https://i-blog.csdnimg.cn/direct/2bde6cc7672a4cd789748d08f81766a8.png)