摘要

BERT(Bidirectional Encoder Representations from Transformers)是一种强大的预训练模型,广泛应用于自然语言处理任务。本文将详细介绍BERT模型中的两个重要组件:嵌入后处理和注意力掩码的创建。通过理解这些组件的工作原理,读者可以更好地掌握BERT模型的内部机制,并在实际应用中进行优化和调整。

1. 引言

BERT模型的核心在于其强大的嵌入表示能力和多头自注意力机制。在模型的输入阶段,嵌入后处理是一个重要的步骤,它包括词嵌入、段嵌入和位置嵌入的叠加。此外,注意力掩码的创建也是确保模型正确处理序列数据的关键。本文将详细介绍这两个组件的实现。

2. 嵌入后处理

2.1 函数定义

def embedding_postprocessor(input_tensor,use_token_type=False,token_type_ids=None,token_type_vocab_size=16,token_type_embedding_name="token_type_embeddings",use_position_embeddings=True,position_embedding_name="position_embeddings",initializer_range=0.02,max_position_embeddings=512,dropout_prob=0.1):"""Performs various post-processing on a word embedding tensor.Args:input_tensor: float Tensor of shape [batch_size, seq_length, embedding_size].use_token_type: bool. Whether to add embeddings for `token_type_ids`.token_type_ids: (optional) int32 Tensor of shape [batch_size, seq_length].Must be specified if `use_token_type` is True.token_type_vocab_size: int. The vocabulary size of `token_type_ids`.token_type_embedding_name: string. The name of the embedding table variablefor token type ids.use_position_embeddings: bool. Whether to add position embeddings for theposition of each token in the sequence.position_embedding_name: string. The name of the embedding table variablefor positional embeddings.initializer_range: float. Range of the weight initialization.max_position_embeddings: int. Maximum sequence length that might ever beused with this model. This can be longer than the sequence length ofinput_tensor, but cannot be shorter.dropout_prob: float. Dropout probability applied to the final output tensor.Returns:float tensor with same shape as `input_tensor`.Raises:ValueError: One of the tensor shapes or input values is invalid."""input_shape = get_shape_list(input_tensor, expected_rank=3)batch_size = input_shape[0]seq_length = input_shape[1]width = input_shape[2]output = input_tensorif use_token_type:if token_type_ids is None:raise ValueError("`token_type_ids` must be specified if""`use_token_type` is True.")token_type_table = tf.get_variable(name=token_type_embedding_name,shape=[token_type_vocab_size, width],initializer=create_initializer(initializer_range))flat_token_type_ids = tf.reshape(token_type_ids, [-1])one_hot_ids = tf.one_hot(flat_token_type_ids, depth=token_type_vocab_size)token_type_embeddings = tf.matmul(one_hot_ids, token_type_table)token_type_embeddings = tf.reshape(token_type_embeddings,[batch_size, seq_length, width])output += token_type_embeddingsif use_position_embeddings:assert_op = tf.assert_less_equal(seq_length, max_position_embeddings)with tf.control_dependencies([assert_op]):full_position_embeddings = tf.get_variable(name=position_embedding_name,shape=[max_position_embeddings, width],initializer=create_initializer(initializer_range))position_embeddings = tf.slice(full_position_embeddings, [0, 0],[seq_length, -1])num_dims = len(output.shape.as_list())position_broadcast_shape = []for _ in range(num_dims - 2):position_broadcast_shape.append(1)position_broadcast_shape.extend([seq_length, width])position_embeddings = tf.reshape(position_embeddings,position_broadcast_shape)output += position_embeddingsoutput = layer_norm_and_dropout(output, dropout_prob)return output2.2 功能解析

- 输入张量形状检查:首先,函数检查输入张量的形状是否符合预期(即

[batch_size, seq_length, embedding_size])。 - 段嵌入:如果

use_token_type为True,则添加段嵌入。段嵌入用于区分不同句子的标记。 - 位置嵌入:如果

use_position_embeddings为True,则添加位置嵌入。位置嵌入用于编码每个标记在序列中的位置信息。 - 层归一化和dropout:最后,对输出张量进行层归一化和dropout处理,以提高模型的泛化能力。

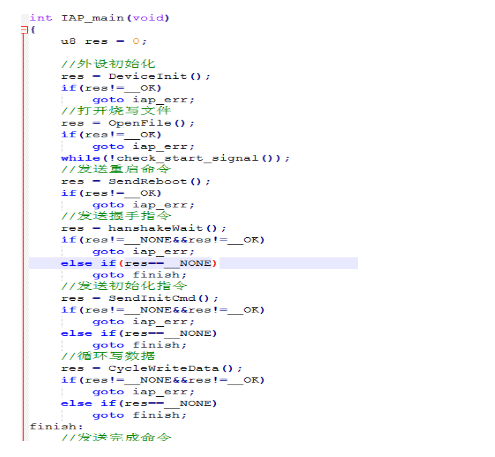

3. 注意力掩码的创建

3.1 函数定义

def create_attention_mask_from_input_mask(from_tensor, to_mask):"""Create 3D attention mask from a 2D tensor mask.Args:from_tensor: 2D or 3D Tensor of shape [batch_size, from_seq_length, ...].to_mask: int32 Tensor of shape [batch_size, to_seq_length].Returns:float Tensor of shape [batch_size, from_seq_length, to_seq_length]."""from_shape = get_shape_list(from_tensor, expected_rank=[2, 3])batch_size = from_shape[0]from_seq_length = from_shape[1]to_shape = get_shape_list(to_mask, expected_rank=2)to_seq_length = to_shape[1]to_mask = tf.cast(tf.reshape(to_mask, [batch_size, 1, to_seq_length]), tf.float32)broadcast_ones = tf.ones(shape=[batch_size, from_seq_length, 1], dtype=tf.float32)mask = broadcast_ones * to_maskreturn mask3.2 功能解析

- 输入张量形状检查:首先,函数检查

from_tensor和to_mask的形状是否符合预期。 - 重塑和类型转换:将

to_mask重塑为[batch_size, 1, to_seq_length]并转换为浮点数。 - 广播和乘法:创建一个全1的张量

broadcast_ones,形状为[batch_size, from_seq_length, 1]。然后将broadcast_ones与to_mask相乘,得到最终的注意力掩码。

4. 应用示例

假设我们有一个输入张量 input_tensor 和一个输入掩码 input_mask,我们可以使用上述函数进行嵌入后处理和注意力掩码的创建:

import tensorflow as tf# 假设的输入张量和掩码

input_tensor = tf.random.uniform([2, 10, 128])

input_mask = tf.constant([[1, 1, 1, 0, 0, 0, 0, 0, 0, 0],[1, 1, 1, 1, 1, 0, 0, 0, 0, 0]], dtype=tf.int32)# 嵌入后处理

output_tensor = embedding_postprocessor(input_tensor=input_tensor,use_token_type=True,token_type_ids=tf.zeros_like(input_mask),use_position_embeddings=True,initializer_range=0.02,max_position_embeddings=512,dropout_prob=0.1

)# 注意力掩码的创建

attention_mask = create_attention_mask_from_input_mask(input_tensor, input_mask)with tf.Session() as sess:sess.run(tf.global_variables_initializer())output_tensor_val, attention_mask_val = sess.run([output_tensor, attention_mask])print("Output Tensor Shape:", output_tensor_val.shape)print("Attention Mask Shape:", attention_mask_val.shape)5. 结论

本文详细介绍了BERT模型中的嵌入后处理和注意力掩码的创建。通过这些组件,BERT模型能够有效地处理自然语言任务中的输入数据,并生成高质量的嵌入表示。希望本文能为读者在自然语言处理领域的研究和开发提供有益的参考。