目录

一、背景

二、问题

三、解决问题

四、Attention U-Net网络结构

简单总结Attention U-Net的操作:增强目标区域的特征值,抑制背景区域的目标值。抑制也就是设为了0。

一、背景

为了捕获到足够大的、可接受的范围和语义上下文信息,在标准的CNN结构中,特征图被逐步下采样,以获得粗粒度的特征图,扩大感受野范围。粗粒度特征图能反应空间信息。虽然粗粒度特征图能在全局尺度上进行模型定位,反应组织间的关系,但是当目标是不同形状的小目标时,减少错正率保持着困难。所以要提高分割精度。

二、问题

- 为提升精度,当前的分割框架依赖额外的预先定位模型,将任务分为目标定位和后续分割。

- 全卷机网络FCNs和U-Net是常见的网络架构。尽管他们有很好的表征性能,但是他们的结构是多级级联CNN,级联框架提取ROI,对特定的ROI进行稠密预测。这种方式会导致计算资源和模型参数的冗余使用。使用级联的所有模型都会重复提取相似的低级特征。

三、解决问题

为解决以上两个现状问题,本文提出了注意力门Attention Gate(AG)。本文将AG加入到U-Net的跳跃连接中,通过较粗粒度的特征图,获得语义上下文信息,进而对来自同层的encoder的特征图中不相关的特征进行抑制,提高模型对目标区域的灵敏度和准确性。(没有提取ROI,也实现了目标定位)

四、Attention U-Net网络结构

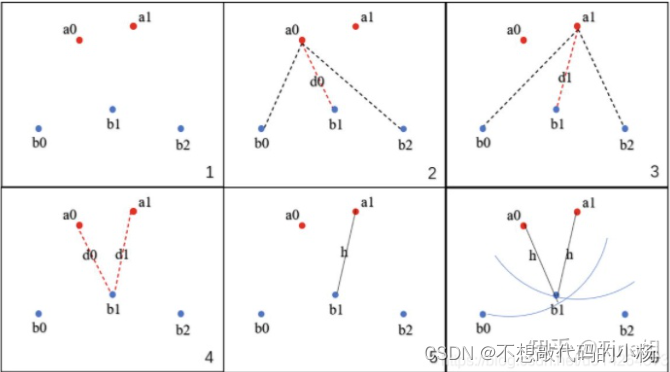

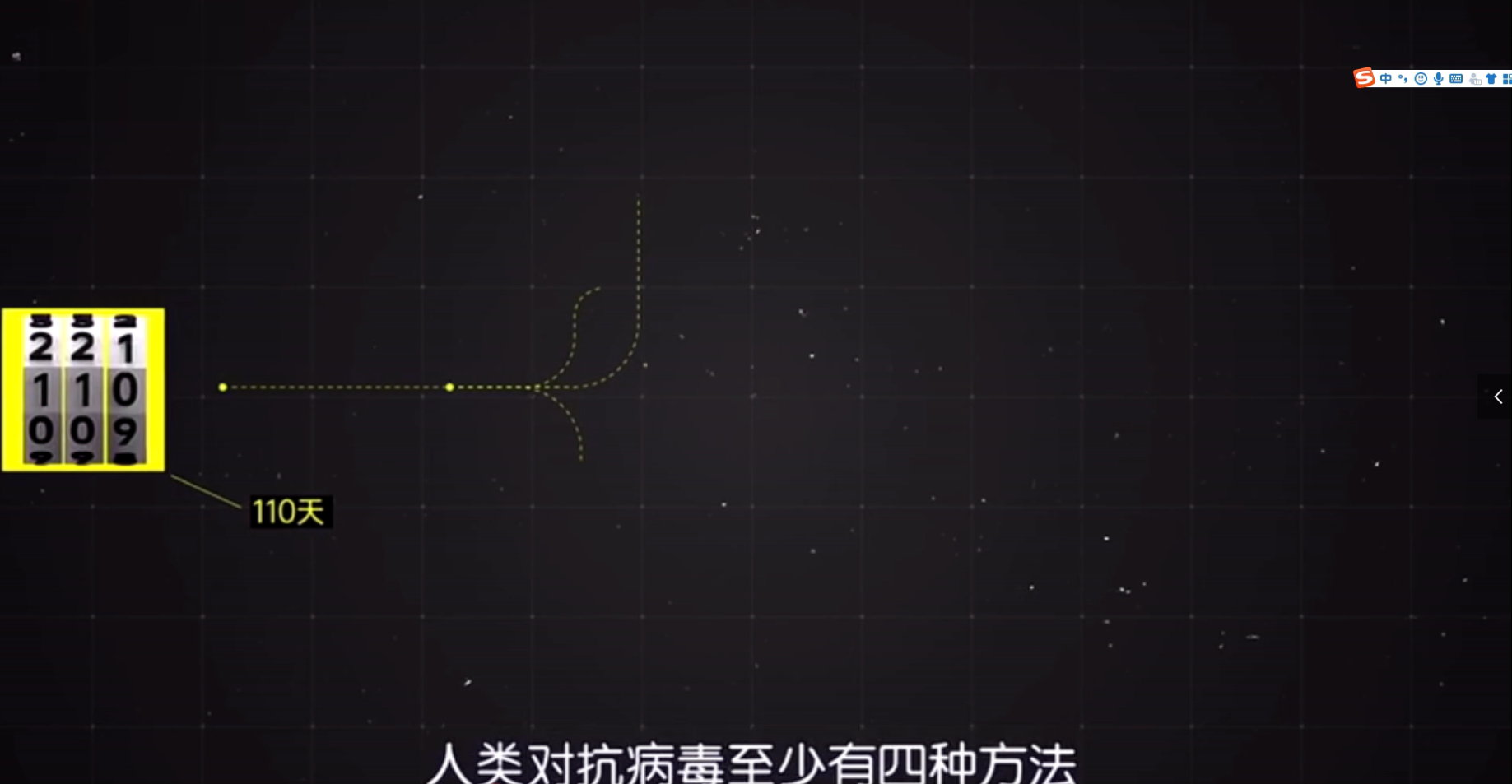

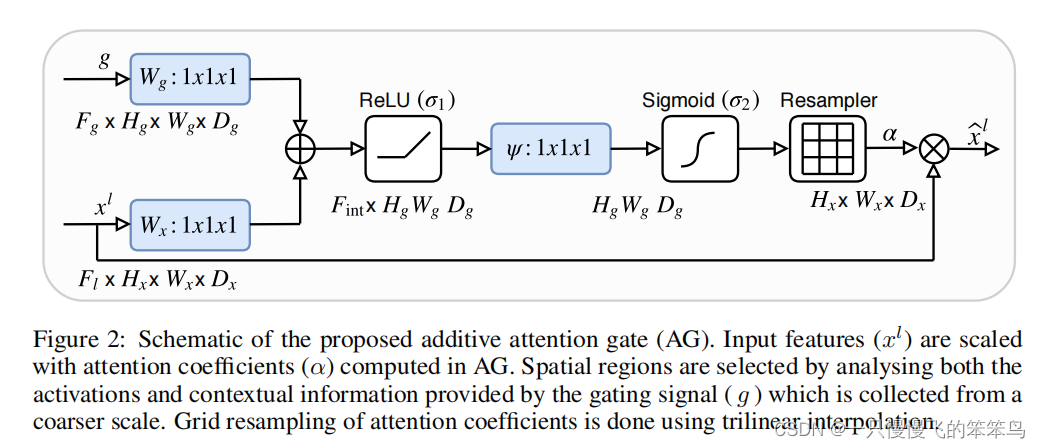

图1 AG的简图

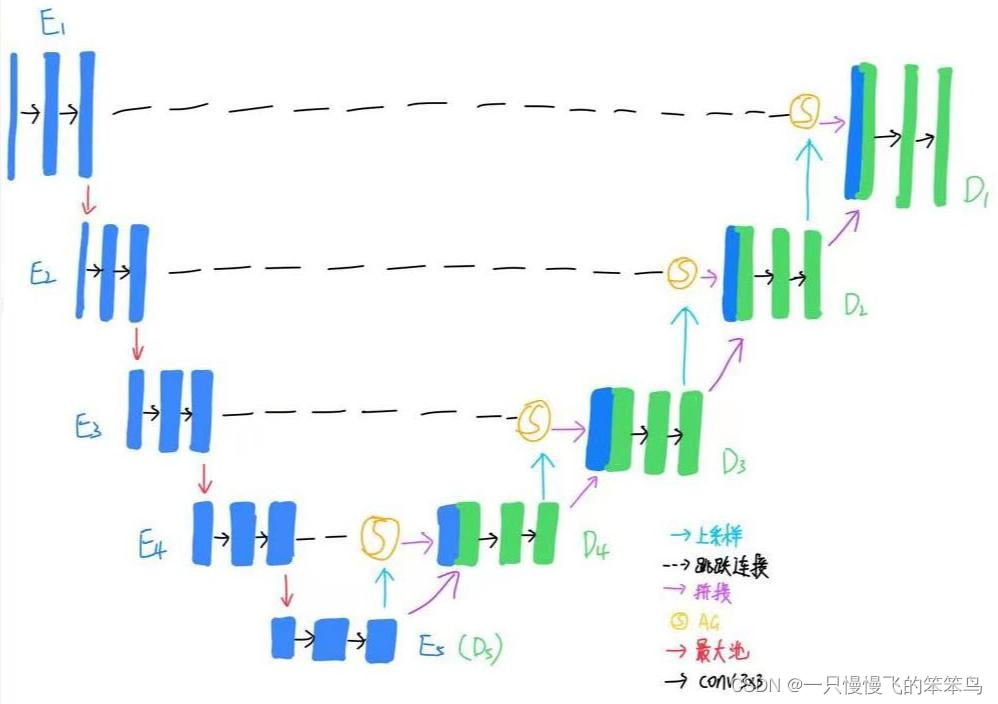

图2 AttentionU-Net网络结构

Attention U-Net网络结构,即在U-Net的跳跃连接上加入了Attention Gate模块,通过跳跃连接提高显示特征。从粗粒度尺度上提取信息用在门控中,以消除跳跃连接中的无关的和噪声响应。AGs在前向过程和反向过程期间过滤神经元激活。背景区域的梯度在反向过程中向下加权,较浅区域的模型参数被更新。为减少AGs的训练参数量和计算复杂度,执行了线性变换。在较粗尺度上,AG提供器官的粗略轮廓。

编码层和U-Net的编码层操作一样,此处不再过多讲解。详情见另一篇U-Net博客。

解码层:拿D3举例子,来介绍每层的具体实现:

- (对D4上采样,达到E3的分辨率)先D4上采样,得到de4,此时de4的特征数量由512至256;

- (将D4、E3输入到AG中,即跳跃连接处的操作)然后将de4与E3输入到AG中,通过卷积操作,将de4的特征数量256降至128,E3的特征数量由256降至128,然后将de4与E3相加,得到psi,相加是为了对目标区域做增强操作,即将目标区域的特征值变大;然后对psi做relu操作,特征数量变为256,此时还称为psi。然后对psi通过卷积操作实现线性变换,特征数量由256变为1,做sigmoid操作,sigmoid的操作即结果非0即1,也就是将背景设为0,目标区域设为1, 即实现了背景抑制的目的,消除跳跃连接中无关的和噪声干扰,此时也实现了减少AG的训练参数量和计算复杂度,进一步得到psi。然后将最初的E3与此时的psi相乘,就得到了对最初的E3做了背景抑制的处理,此时的结果称为en3。(此步骤为AG的操作)

- (此时是D3出的操作)将通过AG处理的en3与上采样后的de4进行拼接操作,此时特征数量由256变为512;之后做两次conv3*3,特征通道变为256,完成D3部分的操作。

D1的最后,还有一个conv1*1,用来实现将特征数量由64变为需要的数量num_classes。

Attention U-Net的优势:

没有多模型训练和大量的额外模型参数。