本文约2800字,建议阅读5分钟通过10张图观察AI应用的全景。2023年4 月 3 日,斯坦福大学以人为本人工智能研究所(Stanford HAI)正式发布了《2023 年人工智能指数报告》(Artificial Intelligence Index Report 2023)。这是该机构发布的第 6 份年度报告,分析了人工智能的影响和年度趋势。本次报告长达302页,比 2022 年的报告多出近 60%。

新报告显示了 2022 年 AI 行业的几个主要趋势:

AI 在许多基准测试中继续发布最先进的结果,但在几个方面的同比改进微乎其微。此外,达到基准饱和的速度也在增加。许多用于衡量 AI 进展的传统基准测试,如 ImageNet 和 SQuAD,似乎已不足。新的、更全面的基准测试套件,例如 BIG-bench 和 HELM 已经被发布,以挑战功能日益强大的 AI 系统。

DALL-E 2、Stable Diffusion 和 ChatGPT 等生成式 AI 模型已成为时代潮流的一部分。它们显示出令人印象深刻的能力,同时也引发了一系列道德问题。“文生图” 通常在性别维度上存在偏见,而像 ChatGPT 这样的聊天机器人,可能会传递错误信息或被用于邪恶的目的。

大语言模型(LLMs)推动了最近的 AI 进展,它现在变得更大、更昂贵。例如,PaLM 是 2022 年发布的 AI 模型之一,其成本是 2019 年首批推出的 LLMs 之一 GPT-2 的 160 倍,体积是其 360 倍。

AI 正在帮助加速科学进步。2022 年,AI 模型被用于控制氢聚变,提高矩阵运算效率,并产生新的抗体。AI 也开始构建更好的 AI。Nvidia 使用 AI 强化学习代理来改进为 AI 系统提供动力的芯片设计。同样,谷歌最近使用其 LLMs 之一 PaLM 来建议改进同一模型的方法。

2023 年的报告包含比以往任何时候都多的 AI Index 团队的原创数据与分析。今年的报告还包括了对基础模型的新分析,包括地缘政治和训练成本、人工智能系统的环境影响、K-12 人工智能教育以及人工智能的舆论趋势。报告还将其对全球人工智能立法的追踪范围从 2022 年的 25 个国家扩大到 2023 年的 127 个。

通过10张图观察AI应用的全局景象

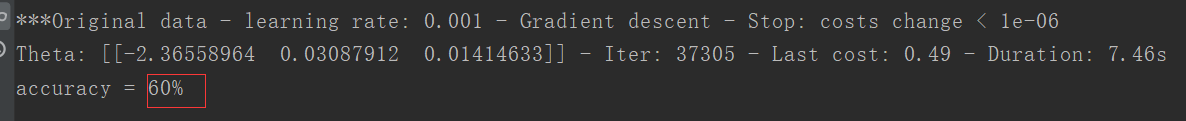

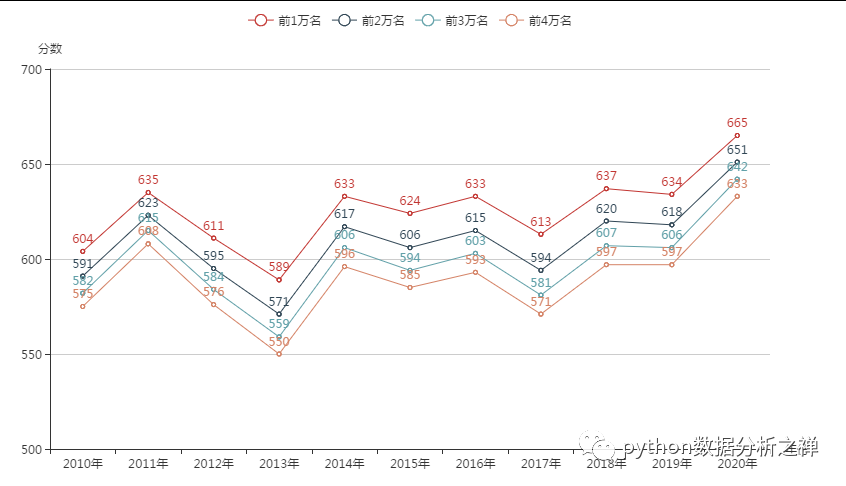

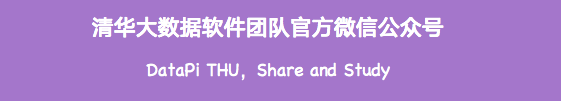

1.大语言模式训练成本高昂

虽然大语言模型(如ChatGPT)的功能已显著增强,但训练此类模型的成本也显著增加。在所有机器学习系统中,语言模型占用的计算资源最多。

图1 各类大语言模型的训练成本

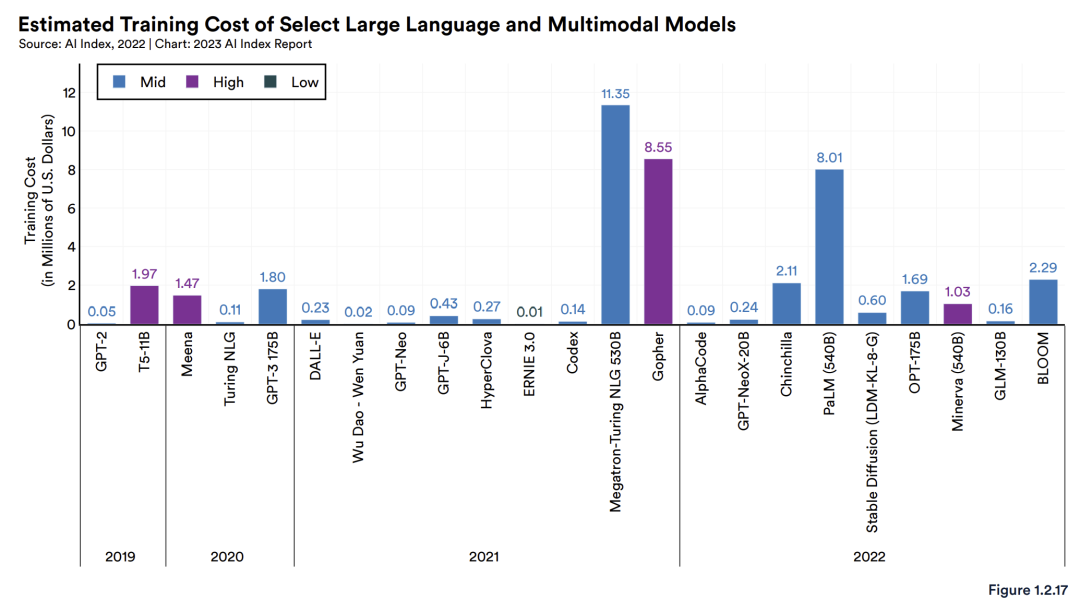

2.AI对于减碳既有危害也有帮助

虽然估算 AI 系统的碳排放量并不容易,但 AI Index 团队考虑了模型中的参数数量、数据中心的能源效率以及用于输送电力的发电类型,给出了最佳的结果。根据 Luccioni 等人的研究,2022 年,BLOOM 的训练所排放的碳比一个从纽约到旧金山的单程航空旅客多 25 倍。与此同时,像 BCOOLER 这样的新强化学习模型表明,人工智能系统可以用来优化能源使用。

图2 大语言模型的碳排放测算

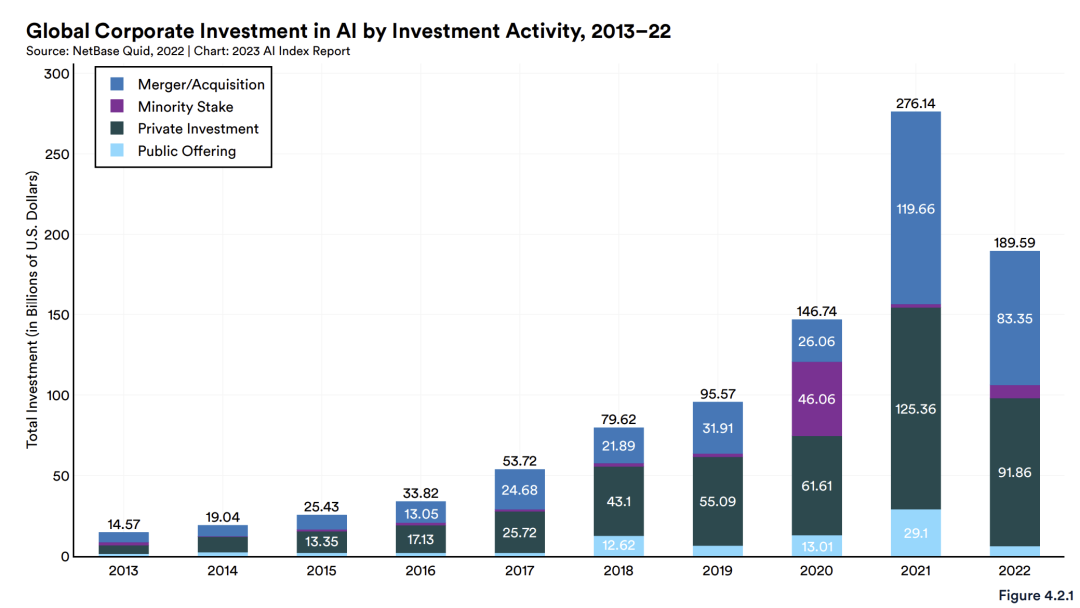

3.AI产业的民营资本投资首次下降,政府投资则持续增加

民营资本对AI的投资十年来首次出现减少,从 2021 年下降约三分之一至 1896 亿美元。AI Index 指导委员会联合主任 Ray Perrault 表示:“2022 年民营资本对初创企业的投资总体下降; 但是,其原因尚不清楚,我们目前还无法回答 AI 初创公司的投资缩水幅度是否大于或小于其他领域的问题。”

人工智能研究的积极一面是,根据该报告,政府投资有所增加,至少在美国是这样。人工智能指数报告显示,美国非国防政府机构在 2022 年为人工智能研发拨款 17 亿美元,比 2021 年增长 13.1%。美国国防部要求在 2023 财年拨款 11 亿美元用于非机密人工智能特定研究,相比于2022年增长了26.4% 。Perrault表示:这些数字来之不易。斯坦福大学AI Index 团队采用了几种不同的测量方法,得出了大致相似的数字,但无法从世界各地收集可比数据。

Perrault 指出:这种增长有几个潜在来源。例如,美国有一个研究人工智能的国家安全委员会在 2021 年发布了报告,建议增加约 10 亿美元的资金用于 AI 本身,另外 10 亿美元用于高性能计算。这一报告提出的建议看起来这有点效果。过去人工智能是由少数机构资助的,比如 DARPA、NSF 和一些国防部组织,但现在,鉴于人工智能被视为与更广泛利益相关的问题 ,就像生物学一样,它正在资金投入的各个领域发生巨大的影响。

图3 全球民营资本在AI领域的投资金额

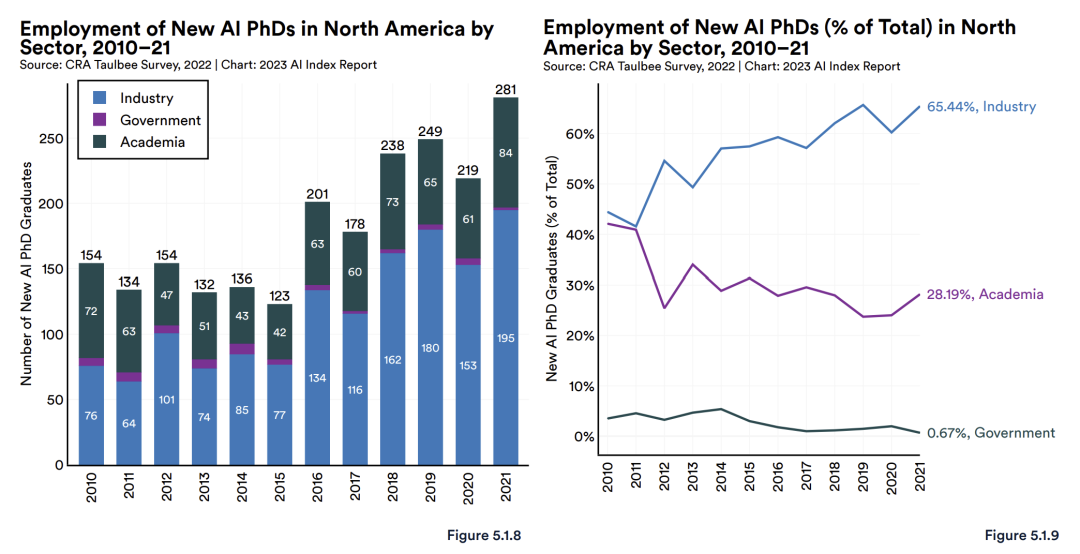

4.工业界比学术界招收了更多的AI专业博士毕业生

根据 AI Index Report,截止到 2021年发布的最新数据,所有 AI 专业方向的博士毕业生中有 65.4% 进入了工业界,而在学术界工作的这一比例为 28.2%。其他人是个体经营者、失业者或报告为“其他”。最初这三个领域的比例几乎持平,这种分化自 2011 年以来一直在稳步扩大。此外,在美国有数据的每个部门中(农业、林业、渔业和狩猎业除外),与人工智能相关的工作岗位的数量平均从 2021 年的 1.7% 增加到 2022 年的 1.9%。美国的雇主正越来越多地寻找具有人工智能相关技能的工人。

图4 北美地区人工智能方向PhD毕业生的就业情况

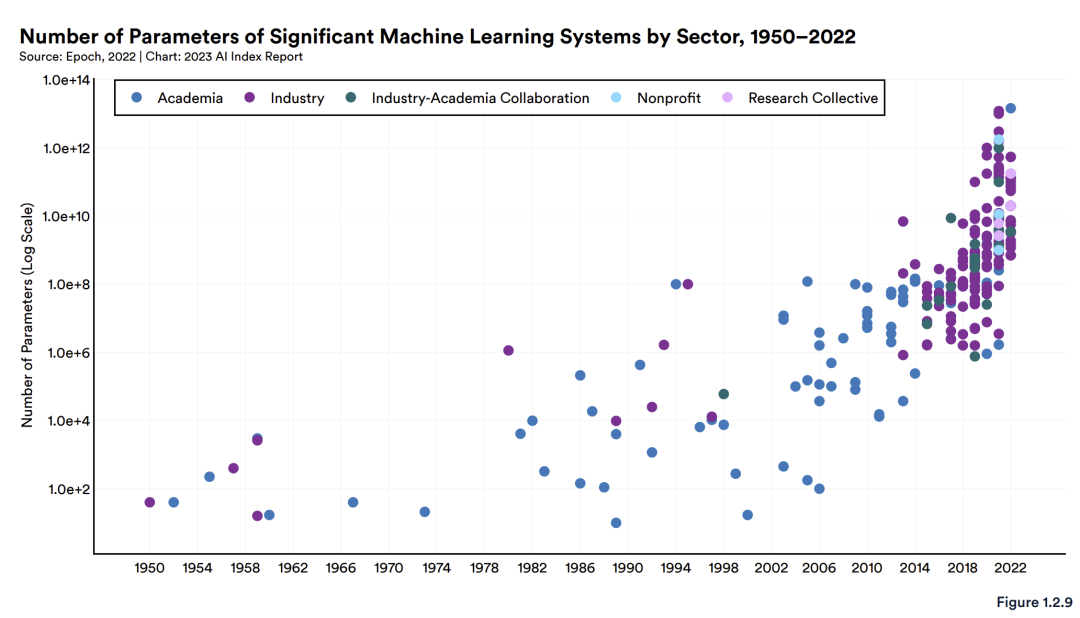

5.学术界在大模型领域的贡献日益落后于产业界

随着博士数量在工业领域就业的增加,工业界在创造新的机器学习模型方面跑在学术界前面也就不足为奇了。直到 2014 年,大多数新的机器学习模型都来自学术界,但工业界已经开始迅速崛起。根据 HAI 收集的数据,到 2022 年,工业界创造的机器学习模型有 32 个,而学术界只有 3 个。AI 指数报告指出,工业在获取构建最先进的 AI 系统所必需的大量数据、计算机能力和资金方面也具有优势。

鉴于这种趋势,Perrault 说,“一个大问题是大学将在多大程度上获得资源来构建自己的大型模型,而不是修补来自外部的模型。”

图5 各部门的大语言模型创造数量

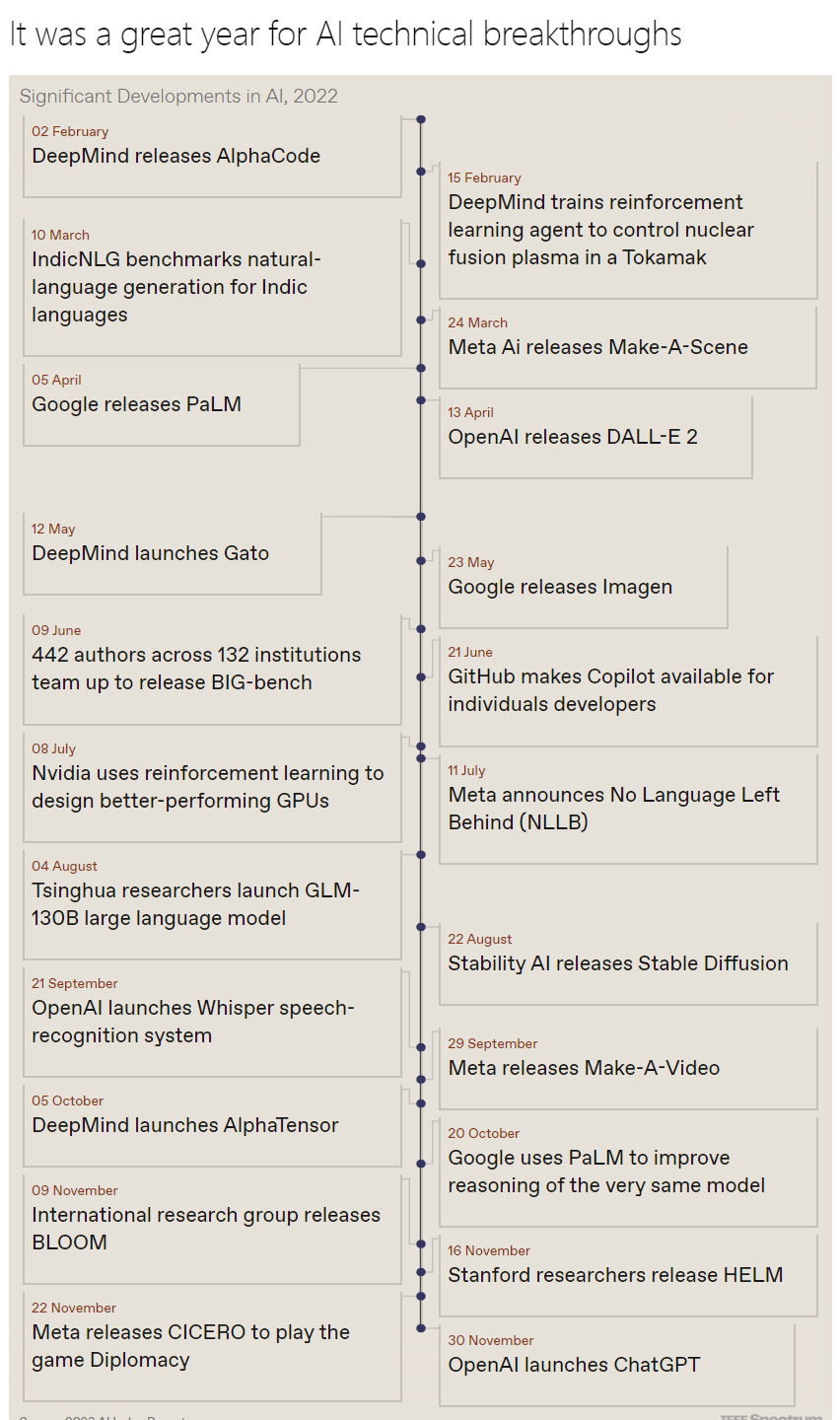

6.大语言模型不断的推陈出新

AI Index Report指导委员会选择了近年来大模型最重要的技术发展,并按时间顺序呈现。Perrault 说:这个“月度模型”对研究团队来说是新的形式,正在增加自制的数据收集,而不是仅仅依赖于其他人发表的研究。目前,美国、中国、加拿大是大语言模型的出现涌现地。

图6 新兴大语言模型不断涌现

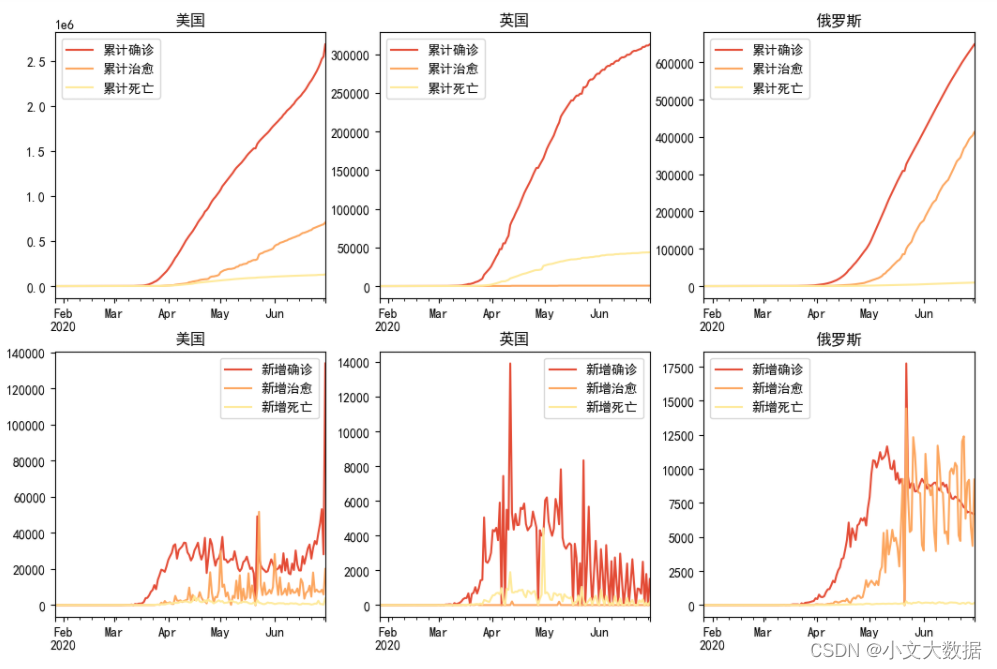

7.滥用人工智能的事件正在逐步增加

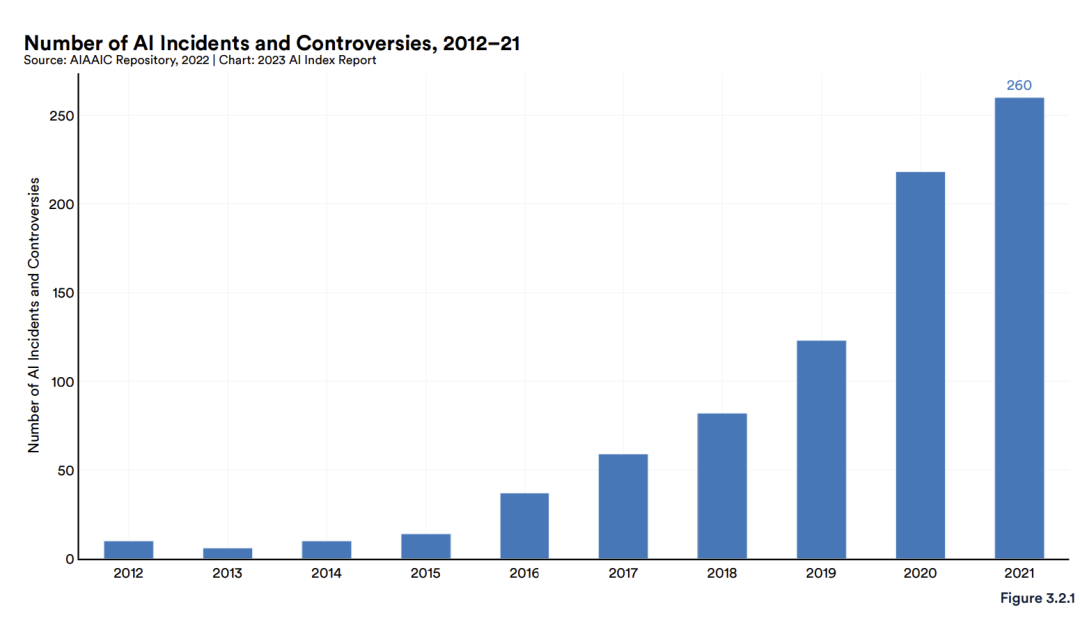

AI Index Report使用来自 AIAAIC Repository的数据报告称,有关滥用 AI 的事件数量正在激增。 该数据大约滞后一年,允许对报告进行审查。当然,该数据也包括了2022 年初的一些事件,例如乌克兰总统 泽连斯基投降的深度伪造以及英特尔开发了一个学生情绪监控系统的消息。

图7 人工智能风险事件数量统计

图7 人工智能风险事件数量统计

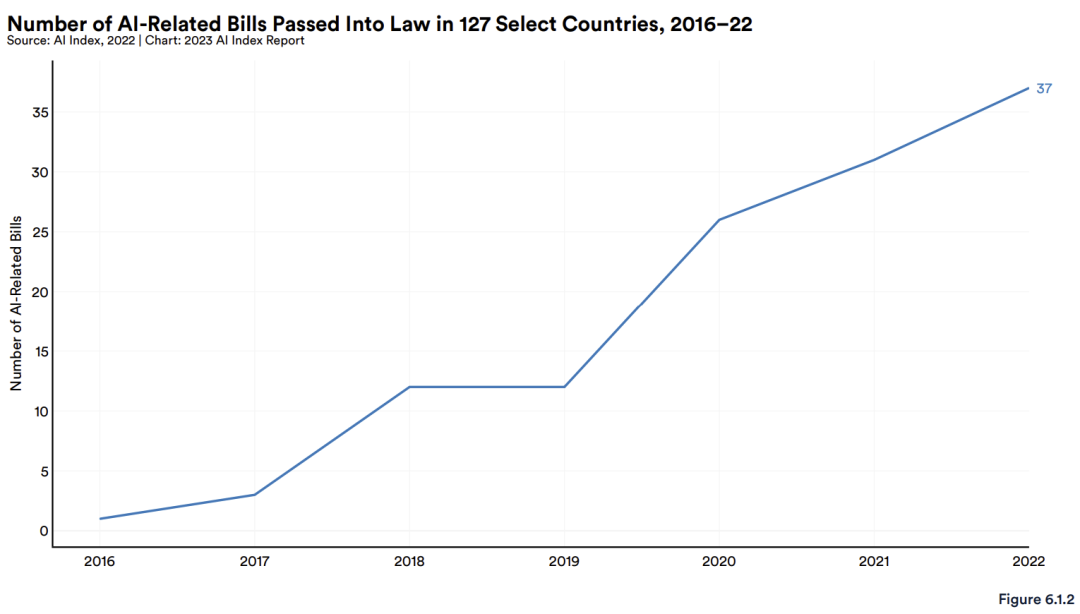

8.立法者越来越关注于人工智能治理

根据AI Index Report,与 AI 相关的法律在 127 个国家/地区通过的总数量正在激增。2016 年仅通过了一项AI法律,而 2022 年通过了 37 项。其中包括对拉脱维亚国家安全法的修正案,以限制对国家安全具有重要意义的组织,包括开发AI产品的商业;包括一项西班牙法案,其要求公共行政部门使用的 AI 算法考虑偏见最小化标准。

图8 人工智能立法数量统计

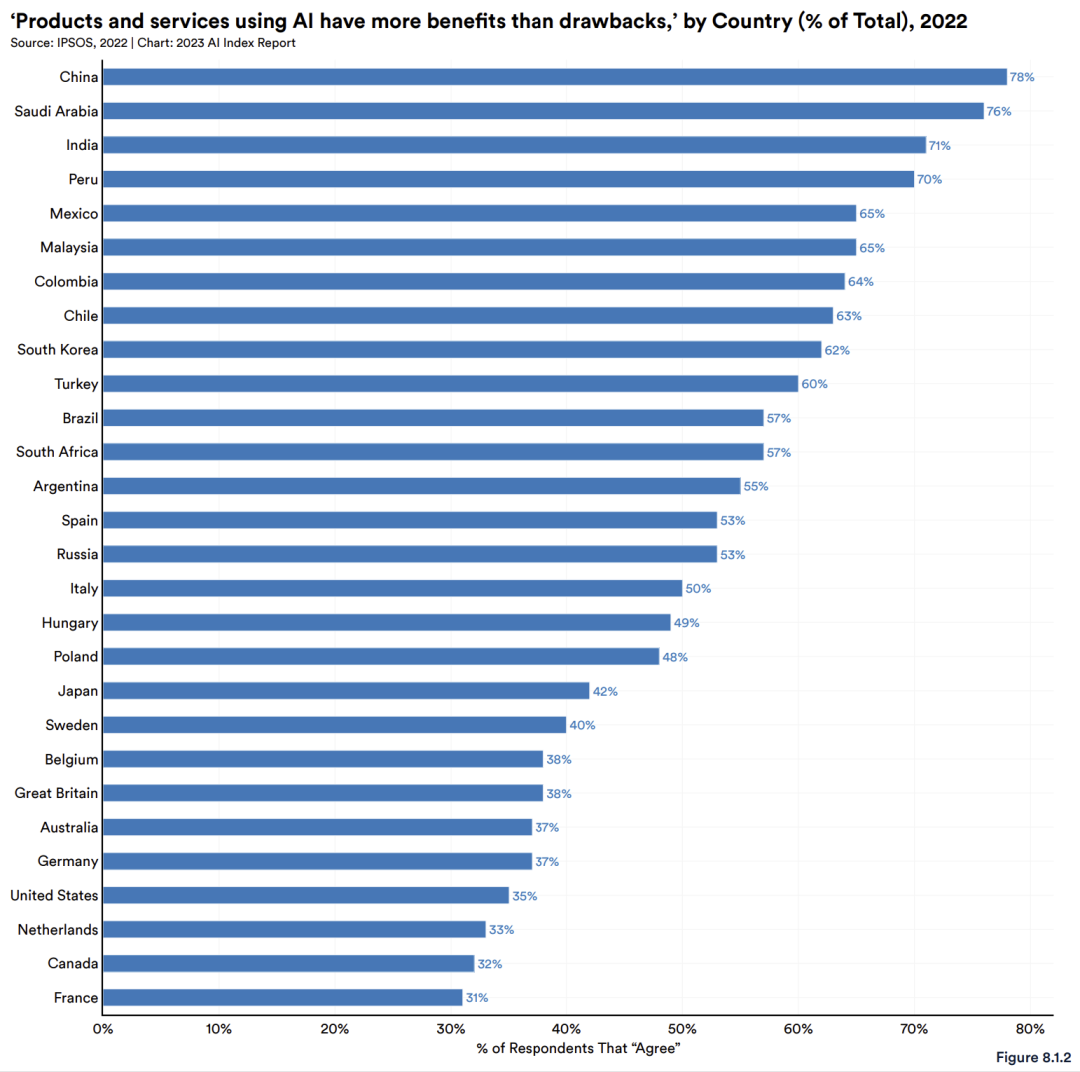

9.中国的民众对于人工智能更加乐观,美国、法国相对落后

根据全球研究公司 IPSOS 进行的一项调查,78% 的中国受访者认为使用人工智能的产品和服务利大于弊。在美国,只有 35% 的人认为人工智能利大于弊,法国则只有 31%受访者认为人工智能发展利大于弊。 此外,据 IPSOS 报道,一般来说,男性对人工智能的态度比女性更积极。

图9 各国民众关于人工智能发展利大于弊的支持率

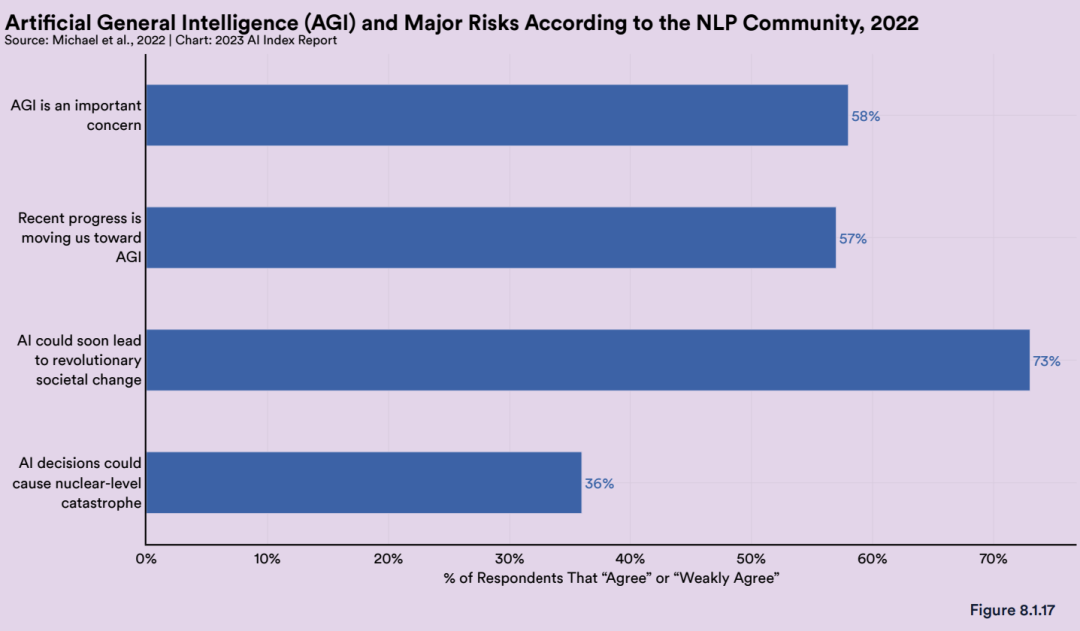

10. NLP专家同时关注到了AI的潜能和风险

根据AI Index Report,他们对自然语言处理(NLP)研究人员进行了调查,以了解 AI 专家对 AI 研究的看法。虽然近 90% 的人表示人工智能过去和未来的利大于弊,但他们并没有忽视它的力量或风险。绝大多数人(73%)预计人工智能将很快导致革命性的社会变革,而36%的人认为人工智能可能导致核级灾难。Perrault表示:“这是一个非常有趣的调查结果。因为这些人大多是技术领域的内行专家。这个调查结果已经过时一年了,考虑到大型语言模型正在发生新的变化,现在可能会有新的调查结果。”

图10 NLP专家对人工智能应用风险的态度统计

注明:AI Index 是 Stanford HAI 的一项独立计划。自 2017 年起,由斯坦福大学主导,来自 MIT、OpenAI、哈佛、麦肯锡等机构的多位专家教授,组建了一个小组,每年发布 AI 指数年度报告,全面追踪人工智能的最新发展状态和趋势。

编辑:于腾凯

校对:杨学俊