大家好,我是微学AI,今天给大家介绍一下人工智能基础部分19-强化学习的原理和简单应用,随着人工智能的不断发展,各种新兴技术不断涌现。作为人工智能的一个重要分支,强化学习近年来受到了广泛关注。本文将介绍强化学习的原理,并通过一个简单的实例来分析强化学习的运用。

一、强化学习的原理

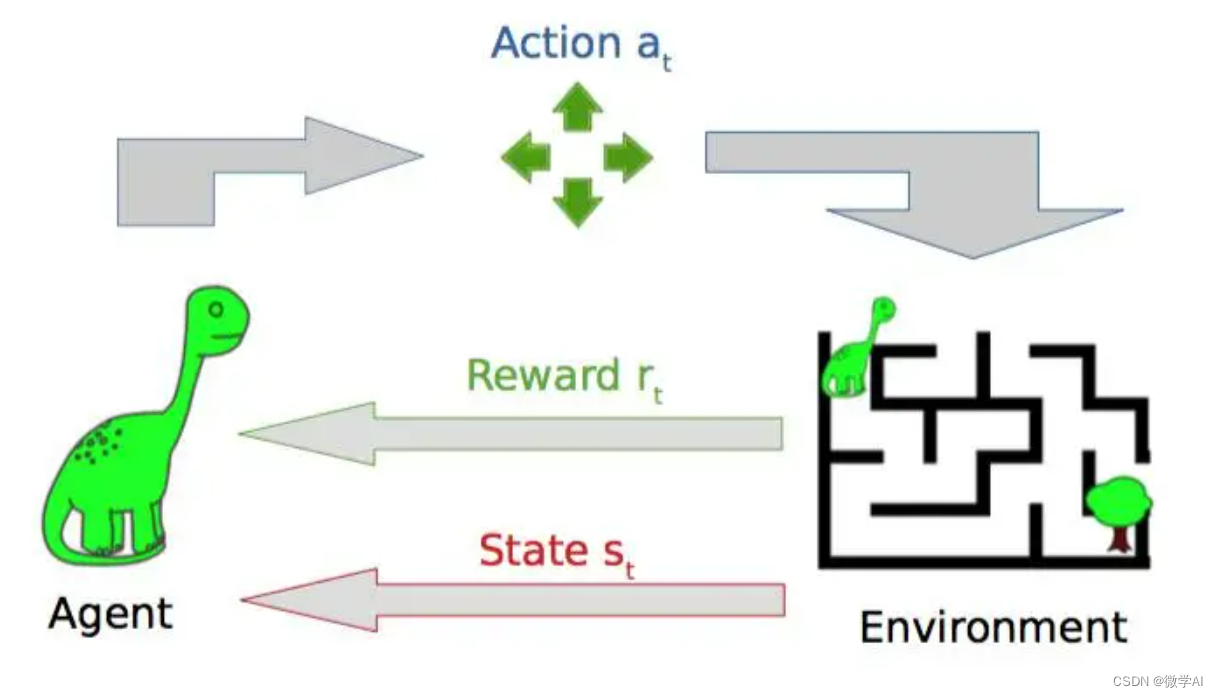

强化学习(RL)是一种通过智能体(Agent)与环境(Environment)的交互,通过试错来学习控制策略的方法。智能体在环境中执行动作,观察到环境状态的变化,并根据所获得的奖励,不断改进自己的策略以适应未来的任务。强化学习的基本组成部分包括:状态、动作、奖励和策略函数。其中状态和动作是智能体的内部状态,奖励是智能体从环境中获取的反馈信号,策略是决定智能体下一步应该采取哪种行动的规则。在强化学习中,智能体通过采用不同的策略分布来探索环境,在不同的状态下采取不同的行动,从而得到奖励,并利用这些奖励重新调整策略,以获得累积奖励的最大化。

强化学习的主要原理包括:

环境模型:强化学习中,智能体需要与环境进行交互,因此需要对环境进行建模和描述。环境模型描述了智能体在哪些状态下可以采取哪些行动,并给定了每个状态下采取不同行动的奖励信号。

状态空间和动作空间:在强化学习中,智能体的行为是由状态空间和动作空间决定的。状态空间是指智能体可以处于的所有状态的集合,动作空间是指智能体可以采取的所有行动的集合。

奖励函数:奖励函数是指智能体从环境中获得的反馈信号。奖励函数给出了在不同状态下采取不同行动的奖励值,以指导智能体的决策策略。

策略函数:策略函数是指智能体在给定状态下应该采取哪种行动的规则。策略函数可以是确定性的或者随机性的。

自适应学习:强化学习中,智能体需要不断地与环境进行交互,根据获得的奖励信号调整策略和行动,从而逐渐学习到最优的行动策略。自适应学习是指智能体可以根据获得的奖励信号调整策略和行动,以逐渐达到最优化的目标。

强化学习的基本数学算法包括:

Markov决策过程(MDP):MDP是强化学习的基础框架。它是一个五元组:状态集合、行动集合、奖励函数、状态转移函数和折扣因子。其中,状态集合表示系统的所有可能状态,行动集合表示智能体可以采取的所有行动,奖励函数表示智能体采取某个行动后系统所给予的奖励,状态转移函数表示智能体采取行动后下一个状态的概率分布,折扣因子表示未来回报的折扣率。

策略和价值函数:策略是智能体在特定状态下应采取的行动的函数。价值函数表示状态或状态行动对的期望回报。策略和价值函数是强化学习中的核心概念,决定了智能体采取行动的方式和评估当前状态的好坏程度。

Q-learning和TD-learning:Q-learning是一种基于价值迭代的算法,目标是通过最大化状态行动对的Q值,来更新策略和价值函数。TD-learning是一种基于时序差分的算法,目标是通过预测未来状态的价值,来更新当前状态的Q值和价值函数。

Actor-Critic算法:Actor-Critic算法是一种组合了策略梯度方法和价值函数估计方法的强化学习算法。它同时学习策略和价值函数,并以最大化长期累积奖励为目标。其中,Actor是策略函数,Critic是价值函数,两者相互作用来指导智能体在状态空间中的探索。

二、强化学习的应用

强化学习与监督学习中的预知事先给出的标签不同,强化学习方法不需要事先给出决策的正确答案。强化学习着重于从环境中的反馈学习如何进行决策,而非根据给出的答案。与无监督学习中的学习结构不同,强化学习更多地关注于如何支配产生这些结构的过程。强化学习广泛应用于游戏智能、机器人控制、自动驾驶汽车等领域。例如,DeepMind 的 AlphaGo 通过强化学习技术成功挑战围棋世界冠军;OpenAI 的 DOTA 2 智能体通过强化学习战胜了 DOTA2 世界顶尖选手。

三、强化学习的代码案例

现在我们设计一个简单的Q-learning算法来学习一个6 x 6的网格迷宫。在训练过程中,智能体在每一步都使用epsilon-greedy策略来选择动作,更新Q表格。最终训练完成后,打印出学习到的Q表格。

import numpy as np# 定义动作和状态空间大小

num_states = 6

num_actions = 2# 定义奖励矩阵

rewards = np.array([[0, 0, 0, 0, 0, 0],[1, 0, 0, 0, 0, 0],[0, -1, 0, 0, 0, 0],[0, 0, 0, 0, 0, 1],[0, 0, 0, 0, 0, -1],[0, 0, 0, 0, 0, 0]

])# 定义智能体的Q表格

Q = np.zeros((num_states, num_actions))# 定义超参数

alpha = 0.1 # 学习率

gamma = 0.99 # 折扣率

epsilon = 0.1 # epsilon-greedy策略# 定义训练函数

def train(iterations):for i in range(iterations):state = np.random.randint(0, num_states) # 随机初始状态while state != 5: # 直到达到终止状态# epsilon-greedy选择动作if np.random.uniform() < epsilon:action = np.random.randint(0, num_actions)else:action = np.argmax(Q[state, :])# 获取下一个状态和奖励next_state = np.random.randint(0, num_states)reward = rewards[state, next_state]# 更新Q表格Q[state, action] += alpha * (reward + gamma * np.max(Q[next_state, :]) - Q[state, action])state = next_state# 训练10次,并打印最终Q表格

train(50)

print(Q)运行输出Q表格:

[[ 4.11925982e-02 4.39469201e-03][ 2.22485294e-01 3.93210790e-02][-5.42652962e-03 -1.38996022e-01][ 2.54590976e-01 1.54935722e-04][-2.71647569e-01 -9.66296584e-02][ 0.00000000e+00 0.00000000e+00]]这个Q表格表示了智能体在每个状态下采取两个动作中的一个的Q值。在这个例子中,Q表格的每一行对应一个状态,每一列对应一个动作。例如,第一行表示智能体在状态0下采取两个动作中的一个时的Q值。每次智能体遇到一个新的状态时,会更新Q表格中对应的行。通过学习这些示例,我们可以更好地理解强化学习算法如何工作,并了解如何将它们应用于更广泛的问题领域。

往期作品:

深度学习实战项目

1.深度学习实战1-(keras框架)企业数据分析与预测

2.深度学习实战2-(keras框架)企业信用评级与预测

3.深度学习实战3-文本卷积神经网络(TextCNN)新闻文本分类

4.深度学习实战4-卷积神经网络(DenseNet)数学图形识别+题目模式识别

5.深度学习实战5-卷积神经网络(CNN)中文OCR识别项目

6.深度学习实战6-卷积神经网络(Pytorch)+聚类分析实现空气质量与天气预测

7.深度学习实战7-电商产品评论的情感分析

8.深度学习实战8-生活照片转化漫画照片应用

9.深度学习实战9-文本生成图像-本地电脑实现text2img

10.深度学习实战10-数学公式识别-将图片转换为Latex(img2Latex)

11.深度学习实战11(进阶版)-BERT模型的微调应用-文本分类案例

12.深度学习实战12(进阶版)-利用Dewarp实现文本扭曲矫正

13.深度学习实战13(进阶版)-文本纠错功能,经常写错别字的小伙伴的福星

14.深度学习实战14(进阶版)-手写文字OCR识别,手写笔记也可以识别了

15.深度学习实战15(进阶版)-让机器进行阅读理解+你可以变成出题者提问

16.深度学习实战16(进阶版)-虚拟截图识别文字-可以做纸质合同和表格识别

17.深度学习实战17(进阶版)-智能辅助编辑平台系统的搭建与开发案例

18.深度学习实战18(进阶版)-NLP的15项任务大融合系统,可实现市面上你能想到的NLP任务

19.深度学习实战19(进阶版)-SpeakGPT的本地实现部署测试,基于ChatGPT在自己的平台实现SpeakGPT功能

20.深度学习实战20(进阶版)-文件智能搜索系统,可以根据文件内容进行关键词搜索,快速找到文件

21.深度学习实战21(进阶版)-AI实体百科搜索,任何名词都可搜索到的百科全书

22.深度学习实战22(进阶版)-AI漫画视频生成模型,做自己的漫画视频

23.深度学习实战23(进阶版)-语义分割实战,实现人物图像抠图的效果(计算机视觉)

24.深度学习实战24-人工智能(Pytorch)搭建transformer模型,真正跑通transformer模型,深刻了解transformer的架构

25.深度学习实战25-人工智能(Pytorch)搭建T5模型,真正跑通T5模型,用T5模型生成数字加减结果

26.深度学习实战26-(Pytorch)搭建TextCNN实现多标签文本分类的任务

27.深度学习实战27-Pytorch框架+BERT实现中文文本的关系抽取

28.深度学习实战28-AIGC项目:利用ChatGPT生成定制化的PPT文件

29.深度学习实战29-AIGC项目:利用GPT-2(CPU环境)进行文本续写与生成歌词任务

(待更新)