一、自由度是什么?

- 定义:构成样本统计量的独立的样本观测值的数目

- 解释:从书中所给的平均数的角度进行

二、讲一下对t检验的理解?

t检验适用于两个变量均数间的差异检验。同时用t检验的前提下:正态性和方差齐性。t检验是目前医学研究中使用频率最高,医学论文中最常见的处理定理资料的假设检验方法。

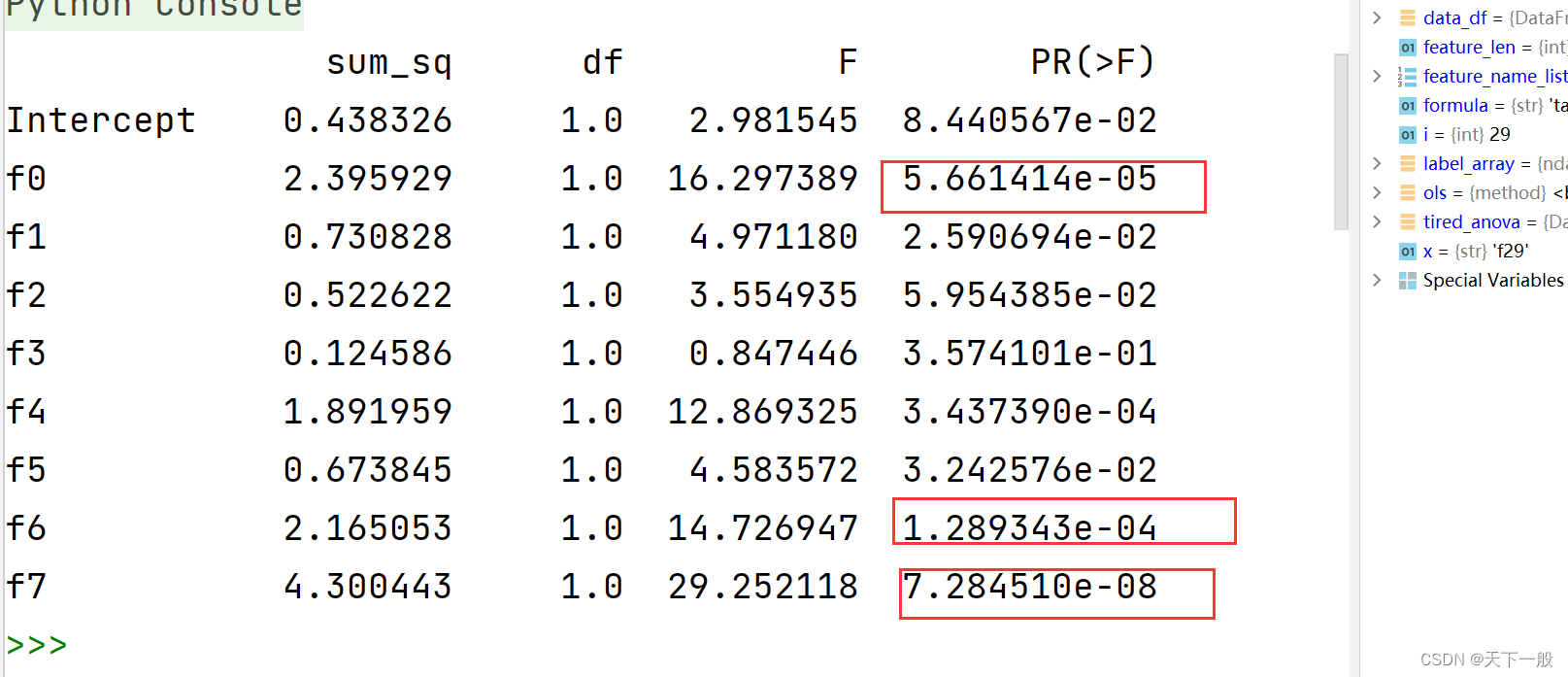

三、如何判定结果具有真实的显著性?

通常,许多科学领域中产生p值的结果<=0.05被认为是统计学意义的边界线,但是这显著性水平还是包含了相当高的犯错的可能性。可以根据实际需要来设定,针对高精度需要,可以要求小于0.01.

四、卡方检验的结果,值越大越好还是越小越好?

与其它检验一样,所计算出的统计量越大,在分布中越接近分布的尾端。另外一般都说显著,而不用好坏来描述。

五、各统计分布的描述

- 几何分布

- 二项分布(伯努利分布)

- 柏松分布

- 指数分布

- 均匀分布

- 正态分布

六、如何给没有学过统计学的人解释正态分布?

正态分布的密度函数曲线是“钟型”曲线。也可以用例子来解释:大多数人在中间,越中间人越多,小部分人在一头一尾且数量相等

七、列举常用的大数定理及区别

- 主要有辛钦大数定理、伯努利大数定理、切比雪夫大数定理

- 区别:伯努利大数定理是辛钦大数定理的特殊形式,若辛钦大数定理的中的随机变量服从特定的伯努利二次分布,就可以得到伯努利大数定理。相比于前者,切比雪夫定理不要求同分布,只要求独立或不相关,因此具有更强的广泛性。

八、贝叶斯定理和全概率公式的应用

- 贝叶斯定理定义:公式+说明是后验概率+举例工厂的例子(这一点机器学习中十分常用)

- 全概率公式:解释完备事件组+正向概率+举例工厂的例子

九、PCA是什么?为什么PCA要去中心化?PCA的主成分是什么?

- PCA是主成分分析,是一种简化数据的技术

- 去中心化的原因?因为要算协方差,单纯的线性变换无法消除量纲的影响

- 主成分:根据实际需要从中可以取出几个较少的综合变量尽可能多地反映原来变量的信息的统计方法叫做主成分分析或称主变量分析,也是数据上处理降维的一种方法。

十、矩的理解

先谈矩的分类,分为中心矩和原点矩,矩是在数理统计学中有一类数字特征成为矩

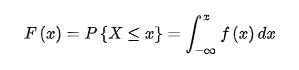

十一、分布函数属于什么变量?

分布函数是用于描述随机变量性质的函数。随机变量的取值具有随机性,而分布函数就可以视为这种随机性的一种刻画表述。或者说,定量地把“不确定性”给“确定”下来。所以它并不是一个随机变量,而是一个具有确定性意义的函数。

十二、偏度峰度公式

网上详细介绍

- 偏度—联系3阶中心矩

- 峰度—联系4阶中心矩

十三、分布的可加性有哪些满足?

回答的时候建议回答简单一点的

- 简单一点的有:泊松分布,正态分布,二项分布,负二项分布,卡方分布

- 复杂一点的有:gamma分布,复合泊松分布

十四、经验分布是不是分布函数?

两者是有区别的。但是根据大数定理,随着样本量的逐渐增加,分布函数收敛于经验分布

十五、分布函数的定义

- 连续型随机变量

- 离散型随机变量:用分布律(概率函数)而不是分布函数来描述离散型随机变量

十六、讲一讲假设检验的p值法

- 先解释p值的含义:当原假设为真时,样本观测结果或更为极端结果所出现的概率,就是p值。p值是观测得到的显著性水平。通俗的讲,就是我们的样本出现的概率。

- 解释一下假设检验的原理:小概率原理。所以需要比较p值和所谓的小概率,这里的小概率是人为规定的小概率。

- p<a,则拒绝原假设,p越小拒绝的理由越充分。

十七、特征函数的作用

特征函数能够用来判断随机变量的分布是否相同!同时,相比如传统的通过概率密度函数通过积分的方式计算各阶矩,通过特征函数求微分在计算上面更加简单!

十八、什么是概率?

- 古典定义

- 统计定义

- 主观定义

十九、3σ原则⭐️

- 如果总体是对程分布

68%的数据位于1σ内

95%的数据位于2σ内

99%的数据位于3σ内 - 如果总体是非对程分布,由切比雪夫不等式得

75%的数据位于2σ内

89%的数据位于3σ内

94%的数据位于4σ内

二十、事件的独立性和随机变量的独立性有什么联系和区别?

-

区别

1、 相互独立事件(independent events): 事件A(或B)是否发生对事件B(A)发生的概率没有影响,这样的两个事件叫做相互独立事件。

2、 随机变量独立满足变量独立的定义:P(AB)=P(A)*P(B) -

联系

随机变量的独立性都是在事件独立性的基础上来定义的。因此随机变量的独立性是指由他们生成的所有的事件都独立。

二十一、举例说明相互独立的意义?

这一点可以用朴素贝叶斯在实际中的例子来说明。只有各特征相互独立的时候,才方便计算。

二十二、为什么要把拒绝域叫做a的拒绝域?

当我们拒绝H0的时候,有可能犯弃真错误,犯此类错误的概率计为a,所以叫做a的拒绝域

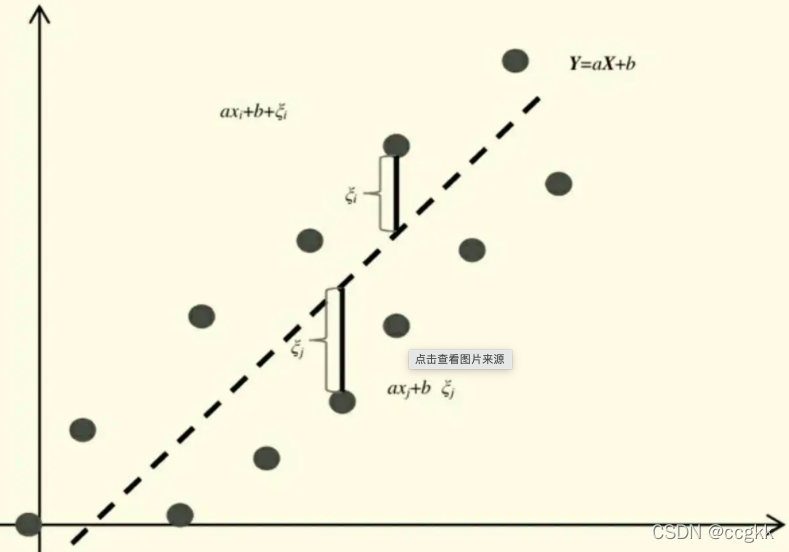

二十三、最小二乘法的思想⭐️

使得离差平方和最小,这时候脑子里一定要有那张图片!!!!

ps.最小二乘法除了由离差最小这一显著特点,注意,他还有一个鲜明的特点就是估计出来的各参数可以计算标准差

二十四、回归中针对误差项的3个基本假定⭐️

- 误差项是一个期望值为0的随机变量

- 对于自变量x1,x2…的所有值,误差项的方差都相同

- 误差项是一个服从正态分布的随机变量,且相互独立

二十五、线性回归的前提

- 因变量与自变量之间具有线性关系

- x的取值是固定的,即x的取值是非随机的

- 对误差项的3个基本假定

二十六、掷骰子二次,样本空间是怎样的?

- 先解释样本空间:包含所有可能发生的结果的集合

- 所以样本空间为正正、正反、反反

二十七、用概率知识谈一谈“多行不义必自毙”这句话?

- 总结性:小概率事件在大量重复试验中必然发生

- 解释

记小概率事件的概率为p(0 < p < 1),重复n次,那么这个事件一次也没发生的概率是(1-p)^n,发生至少一次的概率是 1-(1-p)^n 。可以看出,当n趋向于正无穷时,P趋向于1。也就是说,如果小概率事件重复无穷多次,那么必然发生至少一次。

二十八、伯努利试验的条件

- 相同条件下可重复试验

- 试验只有两种结果:成功或者不成功

二十九、抽样方法⭐️

- 简单随机抽样

- 分层抽样

- 整群抽样

- 系统抽样

推荐文章:整理总结:深入浅出统计学——统计抽样的运用

三十、因子旋转、因子分析、因子载荷矩阵

都是主成分分析当中的步骤,可以使用matlab进行以上操作

三十一、给出均匀分布U(0,a)中a的参数估计?

显然这里参数估计

三十二、统计学怎么理解?

是一门收集、处理、解释并从数据中得出结论的科学。

三十三、据估计是什么?

就是利用样本矩来估计总体参数。以均匀分布为例,假设(0,a),a是未知参数,此时总体均值是a/2,又因为大数定理,样本均值依概率收敛于总体均值,所以样本均值x就等于a/2,反解出a即可。同理若有n各未知数据,我们则需要构造多个中心矩。

三十四、解释一下变异系数?⭐️

- 变异系数=方差/均值

- 在比较两个或两个样本变异程度时,变异系数不受平均数与单位的限制。变异系数是以相对数形式表示的变异指标。

ps:解释拟合优度:是指回归直线对观测值的拟合程度。度量拟合优度的统计量是可决系数(亦称确定系数)R²。R²最大值为1。R²的值越接近1,说明回归直线对观测值的拟合程度越好;反之,R²的值越小,说明回归直线对观测值的拟合程度越差。

三十五、解释分位数的含义?

假如有1000个数字(正数),这些数字的5%, 30%, 50%, 70%, 99%分位数分别是 [3.0,5.0,6.0,9.0,12.0],这表明有5%的数字分布在0-3.0之间,有25%的数字分布在3.0-5.0之间,有20%的数字分布在5.0-6.0之间,有20%的数字分布在6.0-9.0之间,有29%的数字分布在9.0-12.0之间,有1%的数字大于12.0,这就是分位数的统计学理解

三十六、不同抽样方法的优缺点

三十八、方差分析和回归分析的几个预先假设

- 方差分析

可加性:各效应可加,即观测值是由各主效应,交互作用以及误差通过相加得到的。

随机性:各样本(观测值)是随机样本

正态性:各样本来自于正态分布的总体

独立性:各样本观测值互相独立

方差齐性:各样本来自的总体方差相同 - 回归分析

自变量与因变量之间是线性关系

在给定自变量x的情况下,随机误差项μ的均值为0,μ与x同方差,μ与x不序列相关。

随机误差项μ服从零均值、同方差的正态分布

各个自变量之间不存在严格线性相关性(无共线性)

三十九、随机变量

表示随机试验各种结果的实值单值函数

四十、功效函数

1-β(β是假设检验中犯第二类错误的概率)

四十一、箱线图

以一组数据来说明,先将一组数据排序,分别找出最小值、下四分位数,中位数、上四分位数、最大值。连接下四分位数和上四分位数画出箱子,中位数在箱子中间,连接箱子和最小值和最大值。(注意通过箱线图判断数据的偏态情况)

四十二、卡方分布

各随机变量Xi独立同分布,且Xi都服从标准正态分布,则n个Xi的平方服从自由度为n的卡方分布。

- 卡方分布的期望为n,方差为2n

- 卡方分布有可加性

- 当自由度足够大,卡方分布的概率密度曲线趋于对称

四十三、主成分成分分析中使用协方差矩阵和相关系数矩阵,为什么?

- 协方差矩阵:它是没有消除量纲的表示变量间相关性的矩阵.

- 相关系数矩阵:相当于消除量纲的表示变量间相关性的一个矩阵

四十四、主成分分析和因子分析的区别?

主成分分析和因子分析的关系是包含与扩展。当因子分析提取公因子的方法是主成分(矩阵线性组合)时,因子分析结论的前半部分内容就是主成分分析的内容,而因子旋转是因子分析的专属(扩展),主成分分析是因子分析(提取公因子方法为主成分)的中间步骤。

四十五、聚类分析和判别分析的区别?

聚类分析是无监督分类,就是只有自变量(指标)数据,没有(表示类别的)因变量数据;判别分析是有监督分类,就是既有自变量(指标)数据,又有(表示类别的)因变量数据

四十六、时间序列、白噪声序列

- 时间序列:是指将同一统计指标的数值按其发生的时间先后顺序排列而成的数列;(比如股票数据、某一月每天早上8点温度)

- 白噪声序列:均值和方差随着时间的变化都不变;

四十七、平稳检验方法

- 图形法

- 假设检验方法

DF检验

ADF检验

四十八、极大似然估计是否符合相合性?什么是相合性?

- 极大似然估计一定符合相合性

- 相合性:随着n的增大,估计值越来越接近被估计的总体参数

四十九、如何确定置信度?

置信度也称为置信水平(注意区别显著性水平),等于1-犯第一类错误的概率。

五十、正定矩阵的性质?⭐️

-

正定矩阵有以下性质:

1、正定矩阵的行列式恒为正;

2、实对称矩阵A正定当且仅当A与单位矩阵合同;

3、若A是正定矩阵,则A的逆矩阵也是正定矩阵;

4、两个正定矩阵的和是正定矩阵;

5、正实数与正定矩阵的乘积是正定矩阵。

-

判定的方法:

根据正定矩阵的定义及性质,判别对称矩阵A的正定性有两种方法:

1、求出A的所有特征值。若A的特征值均为正数,则A是正定的;若A的特征值均为负数,则A为负定的。

2、计算A的各阶主子式。若A的各阶主子式均大于零,则A是正定的;若A的各阶主子式中,奇数阶主子式为负,偶数阶为正,则A为负定的。

五十一、一个样本得到的置信区间是随机区间还是特定区间?

特定区间,样本确定下来,则置信区间不再是一个随机区间

ps.这个问题在初试中时常出现

五十二、给出一个具体问题如何建模?

这里注意一点,模型并不是自己建立的,一般参考他人或者在他人基础上进行修改。同时论文最好可以进行参考对比。

五十三、直方图的定义及直方图的作用的是什么?相关系数的含义?相关系数和协方差有什么关系?请谈谈你自己对相关系数的理解?

- 直方图的定义:数据分组,再根据每组频数所画出的纵向条纹即是直方图,与条形图有所不同,直方图横轴和纵抽均有意义

- 直方图的作用:探究数据的分布情况

- 相关系数的含义:反映两个数据之间的相关关系的统计量。

- 区别:相关性是协方差的标准化格式。协方差本身很难做比较。

- 理解:相关系数是用来证明两个参数是否为线性相关的一种统计方式,相关系数的绝对值越接近1则相关性越强,相关系数的绝对值越接近0,则相关性越弱

五十四、最小二乘法估计和最大释然估计是不是都是无偏的?

- 最小二乘法估计是无偏的

- 而极大释然估计并非都是无偏的

五十五、什么是EM算法?

用于缺失数据的估计

- 根据观测数据,估计(最大释然估计)出模型参数的值;

- 根据估计出的参数值估计缺失值

- 估计出的缺失值加上之前的观测数据重新对模型的参数值进行估计

- 反复迭代以上,直到收敛,迭代结束。

五十六、各种中心极限定理

- 棣莫弗-拉普拉斯(De Moivre-Laplace)定理

- 李雅普诺夫(Lyapunov)定理

五十七、均方误差

MSE的M代表平均mean,S代表平方square,E代表误差error;类似的, 代表A因素的均方差。一般而言,