点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

7月20日晚上7点半,本期我们邀请到清华大学黄高老师实验室的四位讲者,为大家解读2022CVPR的优秀论文!

哔哩哔哩直播通道

扫码关注AI TIME哔哩哔哩官方账号预约直播

7月20日 19:30-19:50

讲者简介

王语霖:

清华大学自动化系直博三年级,研究方向为机器学习与计算机视觉,主要关注动态深度神经网络的设计与高效训练,以第一作者在国际高水平期刊或会议 TPAMI / NeurIPS / ICLR / ICCV / CVPR / ECCV 上发表8篇学术论文,曾获CCF-CV学术新锐奖、百度奖学金、国家奖学金等。个人主页:https://www.rainforest-wang.cool/

分享内容

AdaFocus:利用空间冗余性实现高效视频识别

报告简介

现有高效视频识别算法往往关注于降低视频的时间冗余性(即将计算集中于视频的部分关键帧)。我们的工作则发现,降低视频的空间冗余性(即寻找和重点处理视频帧中最关键的图像区域),同样是一种效果显著、值得探索的方法;且后者与前者有效互补(即完全可以同时建模时空冗余性,例如关注于关键帧中的关键区域)。在方法上,提出了一个通用于大多数网络的AdaFocus框架,在同等精度的条件下,相较现有方法将计算开销降低了2-3.6倍,将TSM的GPU实测推理速度加快了1.6倍。

7月20日 19:50-20:10

讲者简介

蒋昊峻:

清华大学自动化系直博二年级,以一作或共一身份发表2篇 CVPR 论文,以合作者身份发表过1篇 CVPR, 1篇 ICCV, 1篇 TIP。

分享内容

面向 Visual Grounding 任务的无监督伪语句生成

报告简介

Visual Grounding是视觉语言理解的一个重要课题,该任务需要根据自然语言语句(query)定位图像中的对象。常见的算法通常需要昂贵的手动标记图像与语句对(image-query pair)或图像区域与语句对(image region-query pair)。为了消除对人工注释的严重依赖,我们提出了一种名为 Pseudo-Q 的新方法,可以自动生成用于监督训练的伪语句(pseudo-query)。我们的方法利用现成的对象检测器从未标记的图像中识别视觉对象,然后使用伪语句生成模块以无监督方式获得对这些对象的语言表述。广泛的实验证明我们的方法有两个显着的优势:(1)可以显着降低人工注释成本,例如,在 RefCOCO 上降低 31%的标注成本;(2)在5个通过数据集上均超越最先进的弱监督方法。

7月20日 20:10-20:30

讲者简介

潘旭冉:

清华大学自动化系直博四年级,研究方向为机器学习与计算机视觉,研究内容主要包括网络结构设计和3D计算机视觉,以第一作者(共同第一作者)在国际高水平会议 NeurIPS / CVPR / ECCV 上发表5篇论文。

分享内容

卷积与自注意力机制的高效结合

报告简介

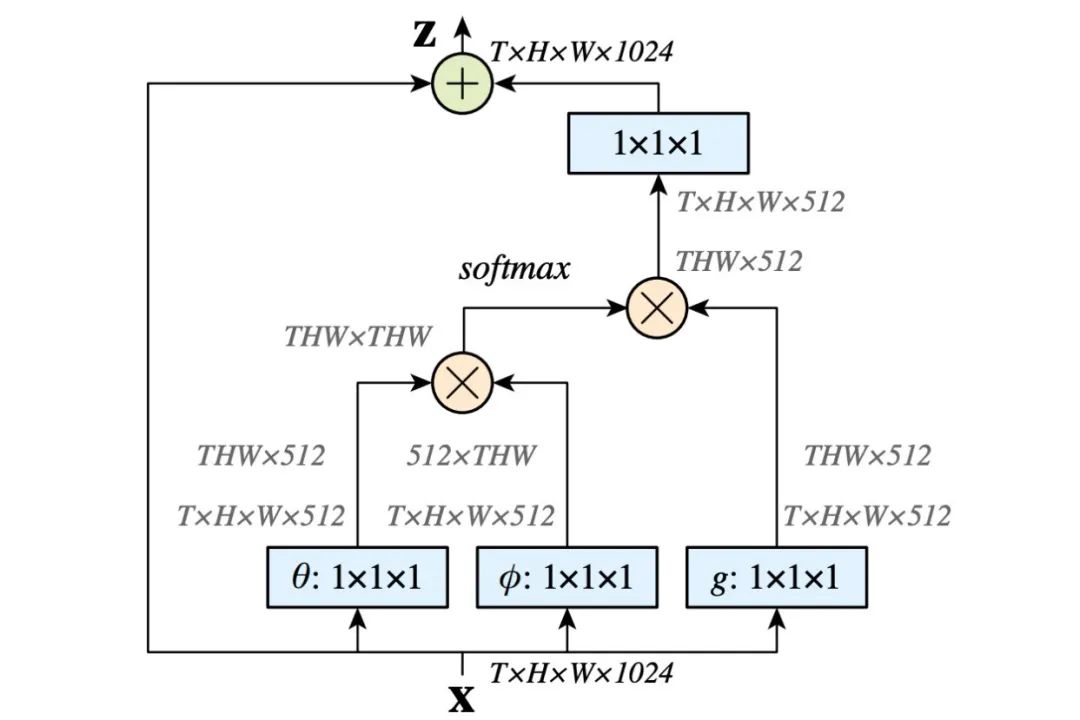

卷积(Convolution)和自注意力(Self-Attention)模块是面向计算机视觉任务的网络结构设计中极为重要的组成部分。考虑到这两种模块存在较为互补的特点,许多工作尝试将他们进行结合,以此提高网络模型在各类任务上的效果。然而,目前的工作多数通过简单的串并联方式将两种模块进行结合,而忽视了他们之间的内在联系。在本文中,我们对两种模块的计算范式进行分解,发现其中存在相同的计算瓶颈,即1x1卷积。通过共享这些计算瓶颈,我们以最小的计算代价实现了两种模块计算范式的结合(ACmix)。实验表明,ACmix可以应用于多种主流计算机视觉模型中,并在图像分类,语义分割,目标检测等任务中显著提升原有模型的效果。

7月20日 20:30-20:50

讲者简介

夏卓凡:

清华大学自动化系硕士二年级,以第一作者(共同第一作者)在CVPR上发表 2 篇论文

分享内容

可变形注意力的视觉Transformer

报告简介

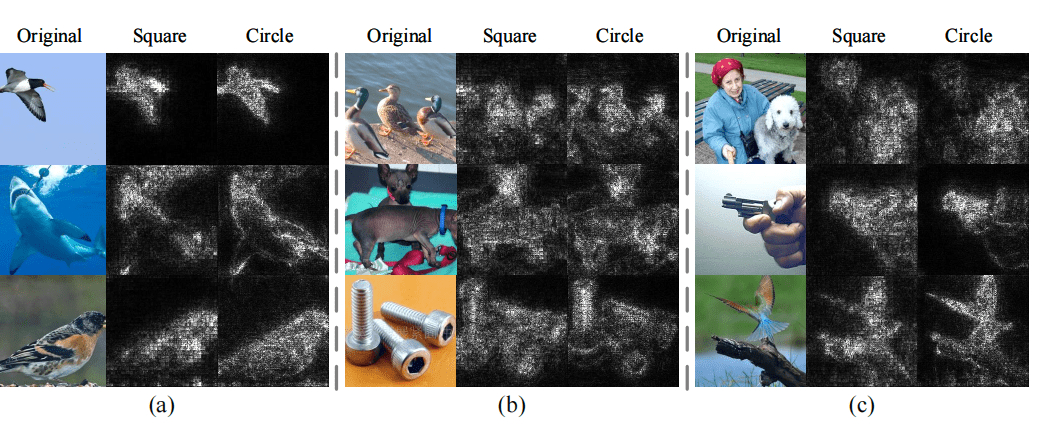

Vision Transformer (ViT) 模型在各类视觉任务上都展现出了强大的性能。因其具有较大甚至增大到全局的感受野,ViT相比卷积神经网络(CNN)能更好地建模长距离依赖关系,也拥有更强的表示学习能力。特别是在大量训练数据的情况下,ViT可以更好地scale up到更大的容量的模型,达得SOTA的实验结果。但是,attention机制也是一把双刃剑,大量的key/value增加了不少计算量,使模型难于收敛,也增加了过拟合的风险。现有的工作现有工作采取了很多的稀疏化attention的办法,如Swin Transformer和PVT,但他们它们手工设计的attention模式容易将与任务相关的key和value信息丢弃。本文受卷积网络中Deformable convolution的启发,提出Deformable Attention Transformer (DAT),将可变形机制引入Attention计算,自动关注输入图像中的重要部分。具体地,DAT让所有query都跟同一组key和value交互,而通过对每个输入图像学习一组偏移量,移动key和value到重要的位置实现可变形的attention机制。这样增强了sparse attention的表征能力,同时具有线性空间复杂度。实验表明,DAT在图像分类、目标检测、语义分割等任务中展现了强大的性能。

直播结束后大家可以在群内进行提问,请添加“AI TIME小助手(微信号:AITIME_HY)”,回复“CVPR”,将拉您进“AI TIME CVPR交流群”!

AI TIME微信小助手

主 办:AI TIME

合作媒体:AI 数据派、学术头条

合作伙伴:智谱·AI、中国工程院知领直播、学堂在线、蔻享学术、AMiner、 Ever链动、科研云

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了700多位海内外讲者,举办了逾300场活动,超260万人次观看。

我知道你

在看

哦

~

点击 阅读原文 预约直播!