我是半路从一个纯小白学过来的,学习途中也掉过许多坑,在这里建议新手要先把基础打扎实,然后再去学习自己需要的内容,不要想着全部学完再用,那样你是永远学不完的,用哪方面就学习哪方面的内容,不要贪多哟。

我当初想到学python是为了能在工作中提升工作效率(另一个也是兴趣),还有就是python入门快。相信大多数小伙伴也是这个原因才学python的。

python的关键词很少,入门很简单,但是想要深入还是要去用心去研究的。同时还要有耐心,因为有些资料在查询的时候,网上给的答案很杂,你需要自己去筛选有用的信息,没有耐心是不行的,有时候为了弄明白一个功能如何实现,我可能要查找几个小时的资料并自己测试可行性,这是很费时间的。当然,你学会了以后对自己的好处也是很大的,下次再有类似的应用就简单的多了,可以举一反三的去实现。

那么python入门之后呢?要用到实处才行,有的公司的工作需要到网上去查找资料做分析,有的是找别人的资料(比如百度等),有的是自己公司的内部资料(比如我😁)。因为工作需要,我需要爬取公司的案件数据,并把数据整合起来保存成表格。因为我有一点python的底子,熟悉工作流程之后就开始着手写自己需要的功能,去把一些固定的、重复的工作交给python来做。

第一步:先找到所需要的网址URL

打开网站,按F12,打开开发者模式,找到所需要的网址、请求方法和headers信息

找到网址和请求方法后,就可以知道去哪里,用什么方法去获取数据了。

网址是我公司的系统网址,没有用户和密码是登录不上去的,这里只是做个展示

有需要的酱友可以找其它的网站爬取内容。我用的requests来爬取(本来想实现模拟登录来保存cooking,目前还没有研究明白,就略过了。)。

第二步:分析网址的变化

找到这两个信息之后就可以开始了,先把网址URL和headers(headers的作用是用来模拟浏览器信息的,要不会被反爬)保存上

url = 'http://api.smart-insight-service.com:40423/case_medical?a=paginate&_=1658047475149'

headers = {'Accept':'application/json, text/javascript, */*; q=0.01','Accept-Encoding':'gzip, deflate','Accept-Language':'zh-CN,zh;q=0.9','Authorization':'','Connection':'keep-alive','Host':'api.smart-insight-service.com:40423','Origin':'http://saas.smart-insight-service.com:40423','Referer':'http://saas.smart-insight-service.com:40423/case/case_search/detail.html','User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36'}

Authorization为空是因为不能自动获取,需要手动粘贴过来,而且由于隐私原因我也不能粘贴过来。有这些信息其实就可以爬取网站的数据了,不过这个是默认的主页信息,还需要找到关键词来定位到自己需要的信息那里。比如我想找批次号为BJ-GGDE210421的批次信息,就要输入然后查询,对比一下两个URL的不同点(第一个是原网址,第二个是带有参数的网址)

url = 'http://api.smart-insight-service.com:40423/case_medical?a=paginate&_=1658047475149'

url = 'http://api.smart-insight-service.com:40423/case_medical?a=paginate&batch_no=BJ-GGDE210421&_=1658047475152'

看到区别了吗,就是a=XXX后面多了一个**&batch_no=BJ-GGDE210421**,这个是那个我要查找的批次。

第三步:开始获取数据

准备好之后就可以获取数据了,代码如下:

def 获取案件信息(url, headers):s = requests.Session()s.mount('http://', HTTPAdapter(max_retries=3))s.mount('https://', HTTPAdapter(max_retries=3))try:req = s.get(url=url, headers=headers, timeout=20)r = req.json()a = r.get('msg')if a == '请求成功':datas = r.get('data') # 案件列表要分离2次,案件详情分离1次。else:datas = aprint(a)except Exception as e:# 输出错误提示print(datetime.now())exstr = traceback.format_exc()print(f'exstr = {exstr}')print(f'e = {e}')datas = {}return datas

requests.Session() 这个功能不太清楚是做什么了🤣这就是不做注释的后果,各位新酱友要以我为戒,千万不要不写注释。(关于用中文,这是我个人的一个想法,对于英文不好的人,用中文来把一些有关联的地方替换掉,很容易就明白什么意思,有助于理解,不过不建议这么做,酱友们还是要按照大佬们的建议,规范的写代码,命名也规范命名。要是团队合作,规范是必须要遵守的。我这样只是单打独斗,自己用用还行,团队肯定不合适,我也需要去改。)

max_retries=3这个参数是重连次数,我的是重新连接3次,这个可以根据实际情况设置

timeout=20这个参数就是连接等待时长了,单位是秒,由于我们系统原因,我需要设置时间很长才行,要不会连接失败,这个也是视实际情况设置了。

获取到全部数据后,要用json() 这个函数转换成字典形式,这样利于提取数据。

第四步:定位数据字段

我现在需要这个批次下所有的案件号和案件数据,那我就要去知道在哪里去提取。同样F12打开,输入批次号查询,然后点击控制台。

左边的红框是我想要的信息内容,右边是要提取信息的地方,打开右边的红框

有以下几个字段:msg是请求状态,我上面的代码提取这个字段就是判断一下请求成功没有。status是状态码,200是请求成功。重点来了,data字段里才是我们需要的内容,打开看看

data里面有page字段,这个里面是页面信息(有需要页面信息了再从这里找),略过。

data里面还有个data字段,是个需要二次提取的地方,我上面的代码有注释,也是怕自己忘记

最后提取数据

再次点开data就出现了一个列表,里面就是我所需要的信息了,那么怎么提取出来呢?

def 获取案件信息(url, headers):s = requests.Session()s.mount('http://', HTTPAdapter(max_retries=3))s.mount('https://', HTTPAdapter(max_retries=3))try:req = s.get(url=url, headers=headers, timeout=20)r = req.json()a = r.get('msg')if a == '请求成功':datas = r.get('data') # 案件列表要分离2次,案件详情分离1次。else:datas = aprint(a)

这个函数里已经提取了一次,因为案件详情只要提取一次就行,所以这里只提取一次,如果需要提取两次的可以再提取一次,就像是获取字典的值一样方便dataset= r[‘data’][‘data’],这样就可以直接提取两次了

在这里说一下字典的 .get 这个用法,看过一些公众号,说这个好用,其实是看怎么用,我把我的字典获取值都改成 .get 了,然后就发现代码有点啰嗦了😂。如果你能确定获取的字典里必定会有这些内容的话,就直接a = dict[‘key’] 来提取值就行,除非是一些不确定的地方,用 .get 来提取会防止因为没有这个键导致程序出错而停止运行。

下面是把我需要的一些关键数据写成函数批量提取出来(提取成了字典,方便查找数据)

def 提取案件列表个案详情(x):if x:姓名 = x.get('name')批次号 = x.get('batch_no')案件号 = x.get('no')身份证号 = x.get('id_no')上传时间 = x.get('case_data').get('upload_time')回传时间 = x.get('case_data').get('send_time')案件状态 = x.get('case_status') # 案件的各种状态,可检查核查状态案件id = x.get('case_id')审核员 = x.get('user').get('nickname')理算状态 = x.get('adjuster_name')理算标识 = x.get('adjuster_status')身份证号 = x.get('id_no')核查状态 = x.get('check_name') # 和核查校验是一个核查校验 = x.get('is_check')data = {'姓名': 姓名,'批次号': 批次号,'案件号': 案件号,'身份证号': 身份证号,'上传时间': 上传时间,'回传时间': 回传时间,'案件状态': 案件状态,'案件id': 案件id,'审核员': 审核员,'核查状态': 核查状态,'理算状态': 理算状态,'理算标识': 理算标识,'身份证号': 身份证号,'核查校验': 核查校验}else:data = {}print('没有案件列表信息')return data

看看那么多 .get 有什么感想?我看着是有点别扭的,不过费了半天时间把所有函数都改了,就不动了,后面我重新写程序的时候就不这么写了

上面的代码就是把列表内所有的案件的信息都提取出来了,列表打开之后还是个字典的样式,直接找自己要的字段即可。

我框了几个字段,可以对照看看 这只是提取一条的数据,还要用for循环来获取列表里的全部内容,下面是个代码示例:

for x in datas:a = 提取案件列表个案详情(x)

这样我所需要的内容就全部提取出来存入字典里了,然后就是写入excel表格导出来了。

总结

看,其实爬虫就是这么简单,有时候直接获取后端数据即可。当然,我要学习的地方还很多。比如提取前端的数据,多协程获取数据等。

个人感悟:学习不是你学习了多少,而是你用上了多少,只有你用上的,才是有用的,所以学python不要想着我把这些都学完再写程序,那样是学习不好的,每天都会有大量的库更新,会有更好的库出现,你永远学不完,把自己能用上的学好就行,不是学的多就好。学以致用,就这样。

怎样快速掌握变现级爬虫?

很多人都表示,高阶的爬虫技术不好学,也找不到有价值的项目练手,每个人都在期待一套能快速进阶的速成方案。

想要快速学好爬虫,尤其是可以用于变现的高阶爬虫技术,在这里蛋糕特意给大家准备了一套python编程资料,能够帮你到你从零基础到python高阶爬虫的学习。

朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】。

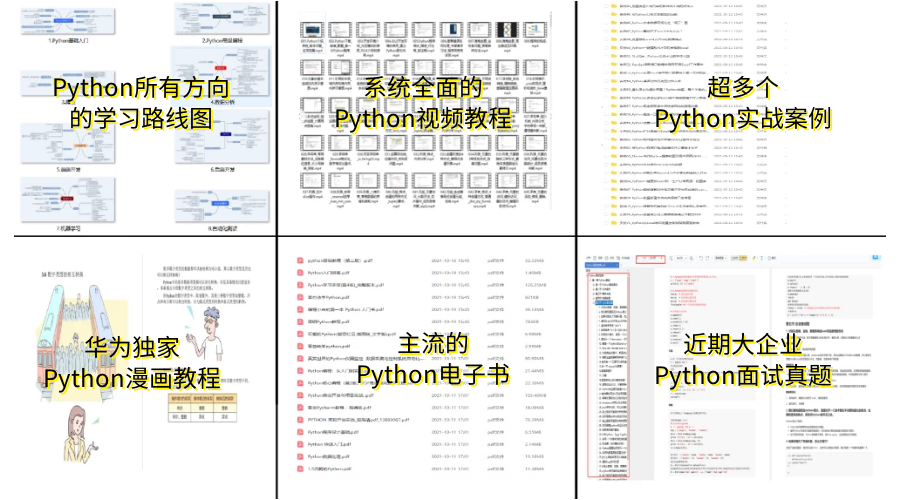

👉Python学习路线汇总👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。(全套教程文末领取哈)

👉Python必备开发工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉Python学习视频600合集👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉实战案例👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉100道Python练习题👈

检查学习结果。

👉面试刷题👈

资料领取

上述这份完整版的Python全套学习资料已经上传CSDN官方,朋友们如果需要可以微信扫描下方CSDN官方认证二维码输入“领取资料” 即可领取