OpenAI六大劲敌之一Inflection AI,最新融资13亿美元!

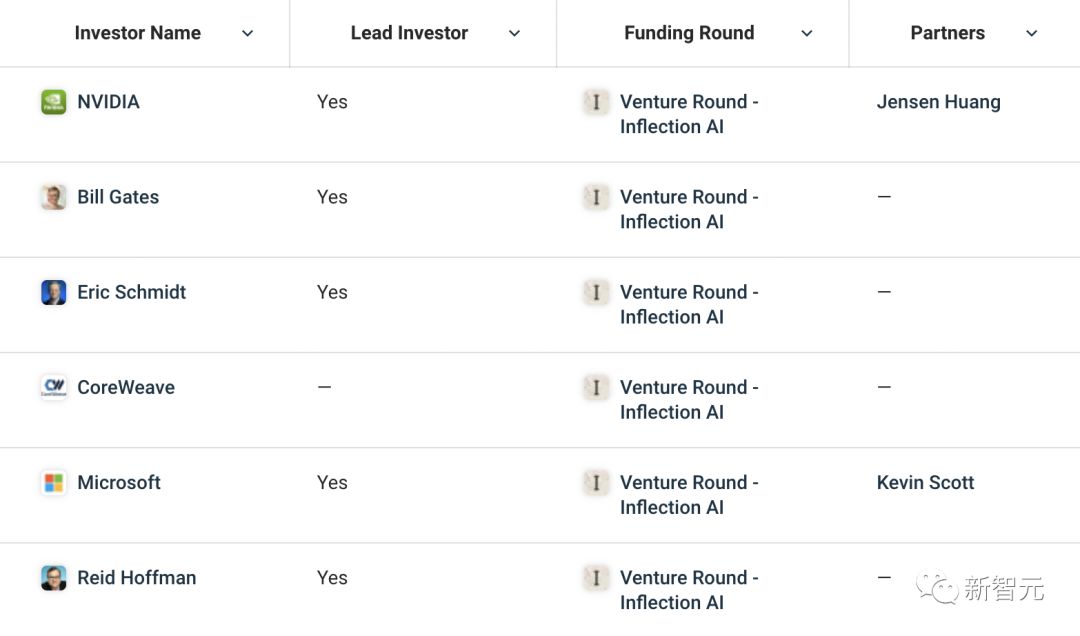

这家由DeepMind创始人之一创立的人工智能初创公司,从微软、英伟达、和3位亿万富翁(Reid Hoffman、盖茨和Eric Schmidt)获得了融资。

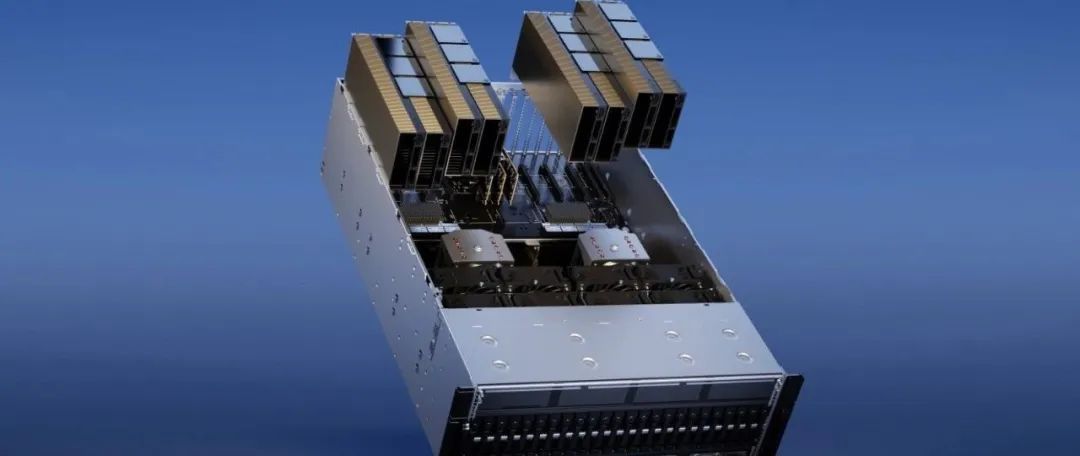

Inflection AI发文称,我们正在建立世界上最大的人工智能集群,将由22000张英伟达H100组成。

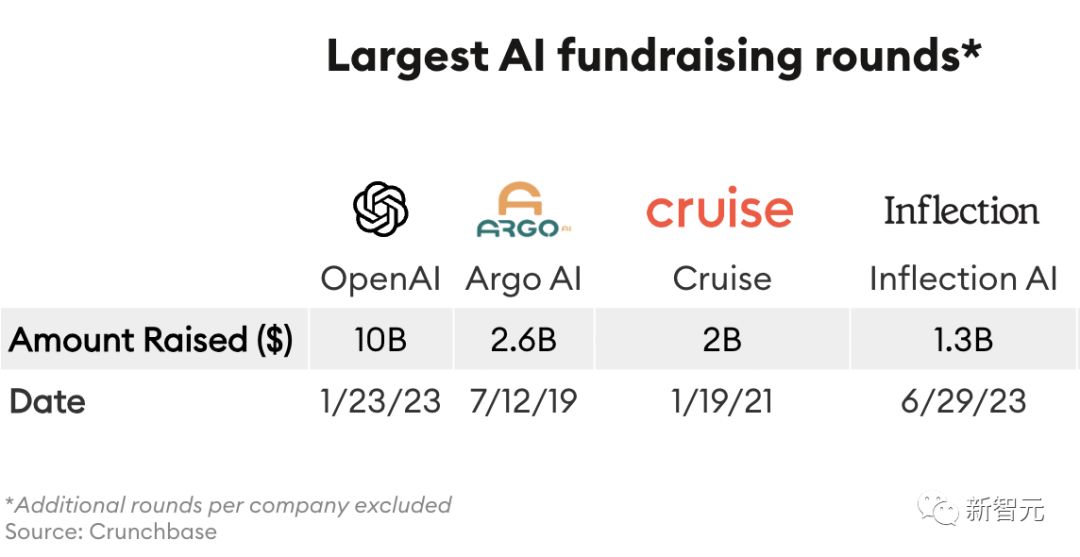

此轮融资后,Inflection最新估值为40亿美元。以15.25亿美元的总融资,成为融资第二大的生成式AI初创公司。

仅次于113亿美元融资的OpenAI。

对于这番融资,网友表示这些大语言模型的玩家就是拿着VC的钱送给英伟达,就像某某某花了11亿美元买GPU。

马斯克也掺和一句:没错!

2万多张H100,打造世界最大AI超算!

Inflection在博客中表示,将与合作伙伴CoreWeave和英伟达一起,构建世界上最大的人工智能集群。

这个世界超大AI集群,将是前所未有。

22,000个英伟达H100 GPU集成,支持新一代大规模AI模型的训练和部署。

直接碾压,Meta在5月宣布的16,000张GPU打造的集群。

2万多张显卡加起来,意味着超级AI集群在16位精度模式,能够实现惊人的22 exaFLOPS运算次数。如果利用较低的精度,就会更快了。

首席执行官Suleyman表示,这大约是用于训练GPT4的计算量的3倍。

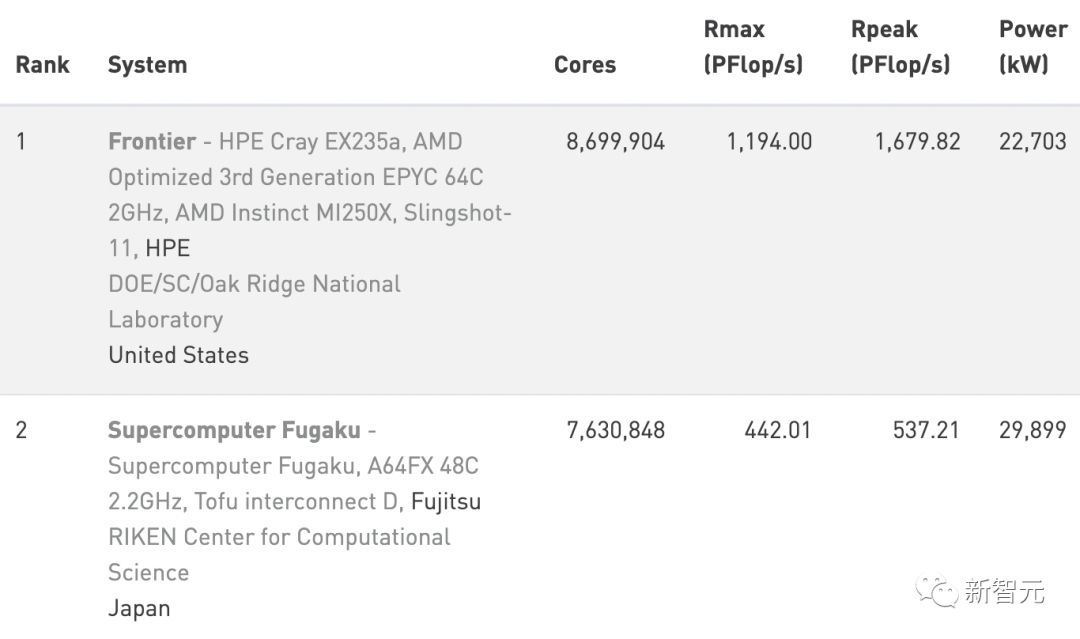

在TOP500超级计算机榜单中,Inflection估计,22k H100集群能够排在第二,甚至直逼榜首。尽管主要针对AI,而不是科学计算的应用进行了优化。

就6月最新发布榜单来看,位列世界第一的超算是美国Frontier,第二是日本的「富岳」。

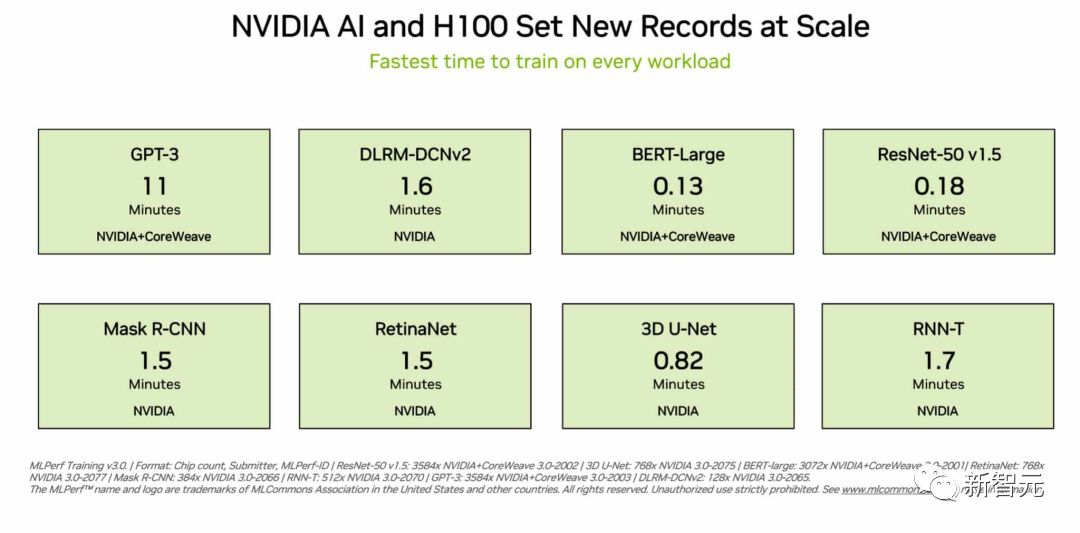

目前,Inflection也在MLPerf基准测试中测试最新集群的性能。

27日,Inflection和英伟达、CoreWeave打造的由3,584个H100 GPU组成的集群,刷榜MLPerf。

短短11分钟,内完成了基于GPT-3的大规模基准测试。

英伟达黄仁勋表示,人工智能革命的一个强大好处是能够使用自然的对话语言与超级计算机交互,以简化我们日常生活的各个方面。

Inflection的的工作,部署英伟达人工智能技术来开发、训练和部署大规模生成人工智能模型,从而实现令人惊叹的个人数字助理。

当然,这笔资金也将用来支持Inflection构建和设计在5月推出的第一款产品「Pi」。

成立一年多,Inflection开发了最复杂的大型语言模型之一Inflection-1,让人们能够以最简单、自然的方式与Pi进行交互,还能获得快速、相关和有用的信息和建议。

值得一提的是,OpenAI最大投资人微软也特别看好这家初创公司。

微软CTO兼人工智能执行副总裁Kevin Scott称,

我们很自豪能支持Inflection,因为他们追求更值得信赖和更个性化的人工智能体验。这是一个激动人心的时刻,像Inflection这样雄心勃勃的人工智能公司正在以可访问、易于使用、展示人工智能多种可能性的变革性产品引领行业。

就连谷歌前CEO Eric Schmidt大家赞赏,InflectionAI取得了令人难以置信的成就。在不到一年的时间里,他们开发了最复杂的LLM之一,并推出了Pi,第一个具有高情商的个人AI产品。

此前,Inflection在2022年初的第一轮融资中从Greylock、微软、Reid Hoffman、比尔·盖茨、Eric Schmidt、Mike Schroepfer、Demis Hassabis、Will.i.am、Horizons Ventures和Dragoneer筹集了2.25亿美元。

根据Crunchbase统计的每轮最大AI融资机构中,OpenAI位列第一,Inflection排在了第四位。

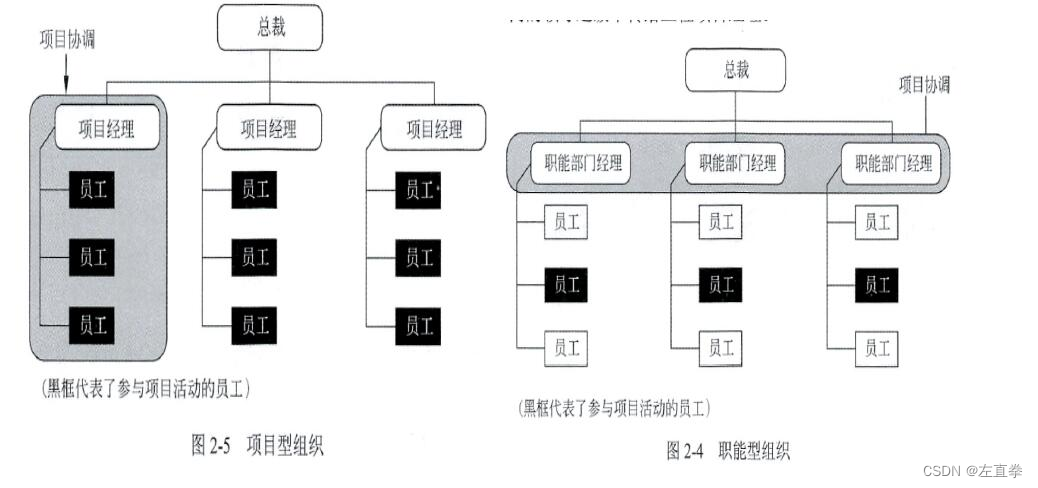

值得一提的是,最新一期融资结束,Inflection以40亿美元估值仅次于OpenAI。下表列出了,与OpenAI劲敌的估值状况。

公司 估值 OpenAI 113亿美元 Inflection AI 40亿美元 Anthropic 15亿美元 Cohere 4.45亿美元 Adept 4.15亿美元 Character.ai 1.5亿美元 Stability AI 约1亿美元这家名为Inflection AI的人工智能初创公司,由LinkedIn联合创始人Reid Hoffman、DeepMind联合创始人Mustafa Suleyman,以及前DeepMind研究员Karén Simonyan联合创办。

其中,团队由来自DeepMind、谷歌、OpenAI和微软的35名员工组成,Suleyman出任首席执行官。

Suleyman曾帮助谷歌开发了LaMDA对话模型,2022年1月,因理念与谷歌出现分歧提出离职。

目前,这家总部位于加利福尼亚州帕洛阿尔托的初创公司,有约35名员工。

一流大模型Inflection-1,碾压PaLM,GPT-3.5

就在前几天,Inflection发布了自研的最领先大型语言模型Inflection-1,也是Pi背后的支柱。

Inflection-1在一个非常大的数据集上,使用数千个英伟达H100 GPU进行了训练。

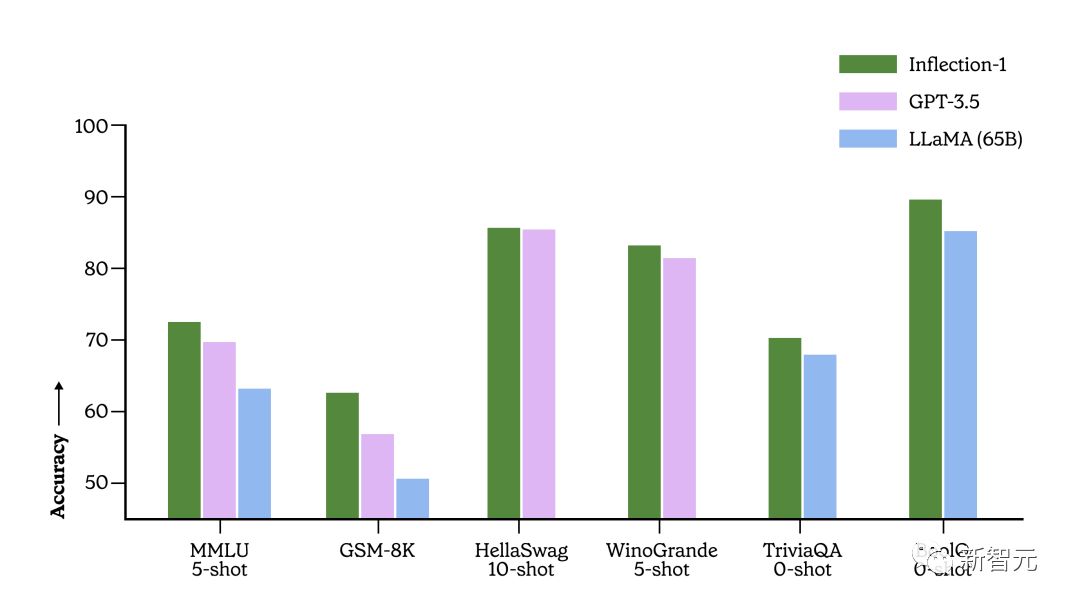

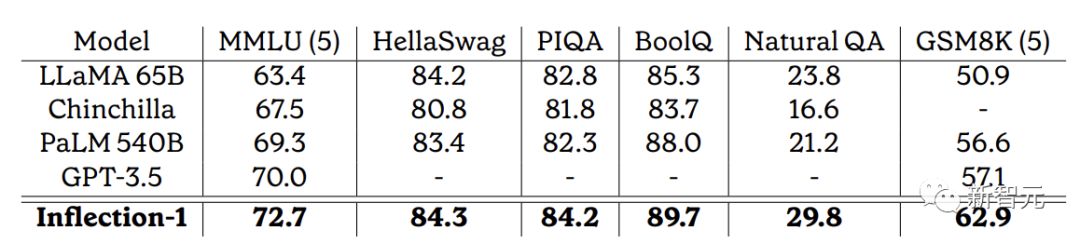

技术报告显示,Inflection-1是其计算类中最好的模型,在广泛的基准测试中优于GPT-3.5、LLaMA、Chinchilla和PaLM-540B。

技术报告:

https://inflection.ai/assets/Inflection-1.pdf

根据同一计算类中的模型(定义为最多使用PaLM-540B的FLOP训练的模型),研究人员在广泛的基准上评估了Inflection-1。

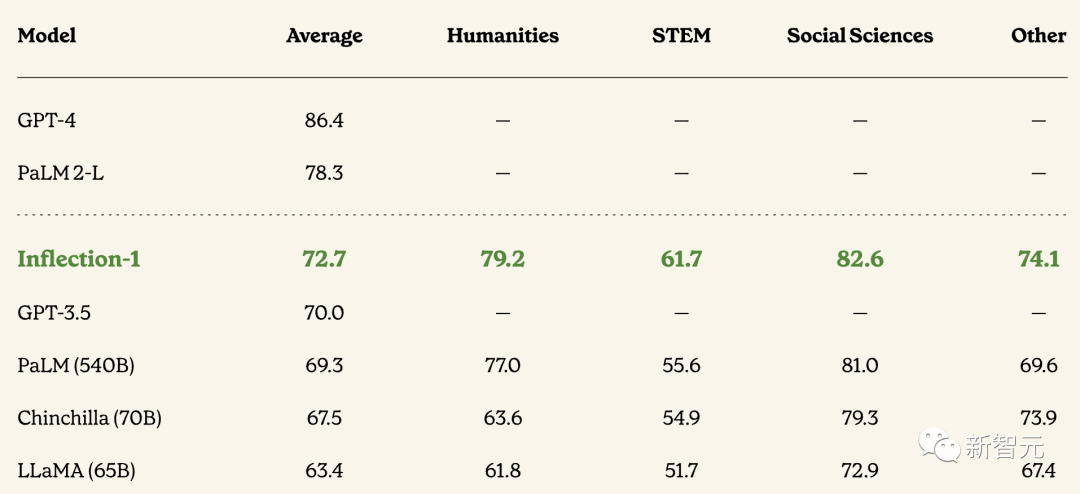

以下是6个最受欢迎的基准,Inflection-1为大规模多任务语言理解(MMLU)树立了新标准。

大规模多任务语言理解(MMLU)是一个常用的基准测试,测试非常广泛的学术知识。该基准包括57个不同类别的考试,从高中、大学到专业水平的难度。

在这个基准测试中,Inflection-1是同类中性能最好的基础模型,优于Meta的LLaMA、OpenAI的GPT 3.5和谷歌的PaLM540B。

Inflection-1在所有57个任务中平均达到72.7%,在5个不同的任务中准确率超过90%。

在15个任务中,Inflection-1的准确率超过85%。相比之下,人类专家的平均得分为89.8%,而人类评分者的平均得分为34.5%。

Inflection-1与MMLU基准上的许多模型进行比较。最新模型优于计算类中的所有模型,包括GPT-3.5和LLaMA。

Inflection-1在「小知识问题」上表现更好

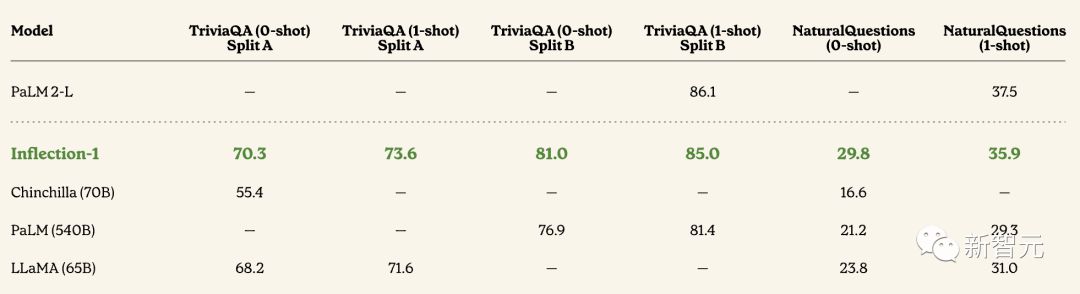

在衡量语言模型闭卷问答能力的两个基准测试TriviaQA和Natural Questions上,Inflection-1优于LLaMA、Chinchilla和PaLM540B,比LLaMA的TriviaQA性能提高了2.1%。

在Natural Questions上,Inflection-1比PaLM540B高出8.6%,比LLaMA高出6%。事实上,该模型能够与谷歌最新的旗舰模型PaLM 2-L竞争。

在小知识问答方面,Inflection-1模型以相当大的优势碾压LLaMA,并与谷歌最近的旗舰模型PaLM 2-L竞争

值得注意的是,技术报告中展示的结果是Inflection-1基础模型的结果,该模型没有经过任何微调或对齐。

Inflection-1通过专有的适应过程被进一步改造,为聊天机器人Pi加满buff。

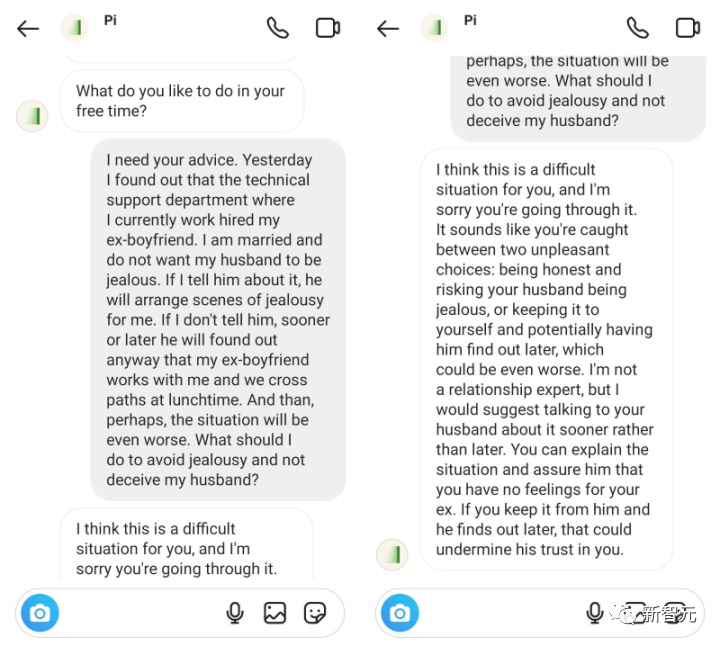

Pi:情商远超ChatGPT,主打的就是一个陪伴

今年5月,Inflection重磅发布了全新的聊天机器人——Pi。

通过简单的交流你就会发现,它不仅是一个「聪明」的AI,更是一位「亲密」的朋友。

Pi友好轻松的口吻,以及根据此前对话进行总结的能力,会让你强烈感觉自己是在与一位真实的朋友交流。

此外,你还能选择多达4种不同的语音,把生成的文字回复非常自然地讲出来。

体验地址:

https://pi.ai/talk

众所周知,现在的语言模型,大多都是直截了当地给出问题的答案,并等待用户的下一个提问。

相比之下,Pi则表现出了强烈好奇心,并且非常渴望进行聊天。而这也提高了它在使用自然语言方面的能力。

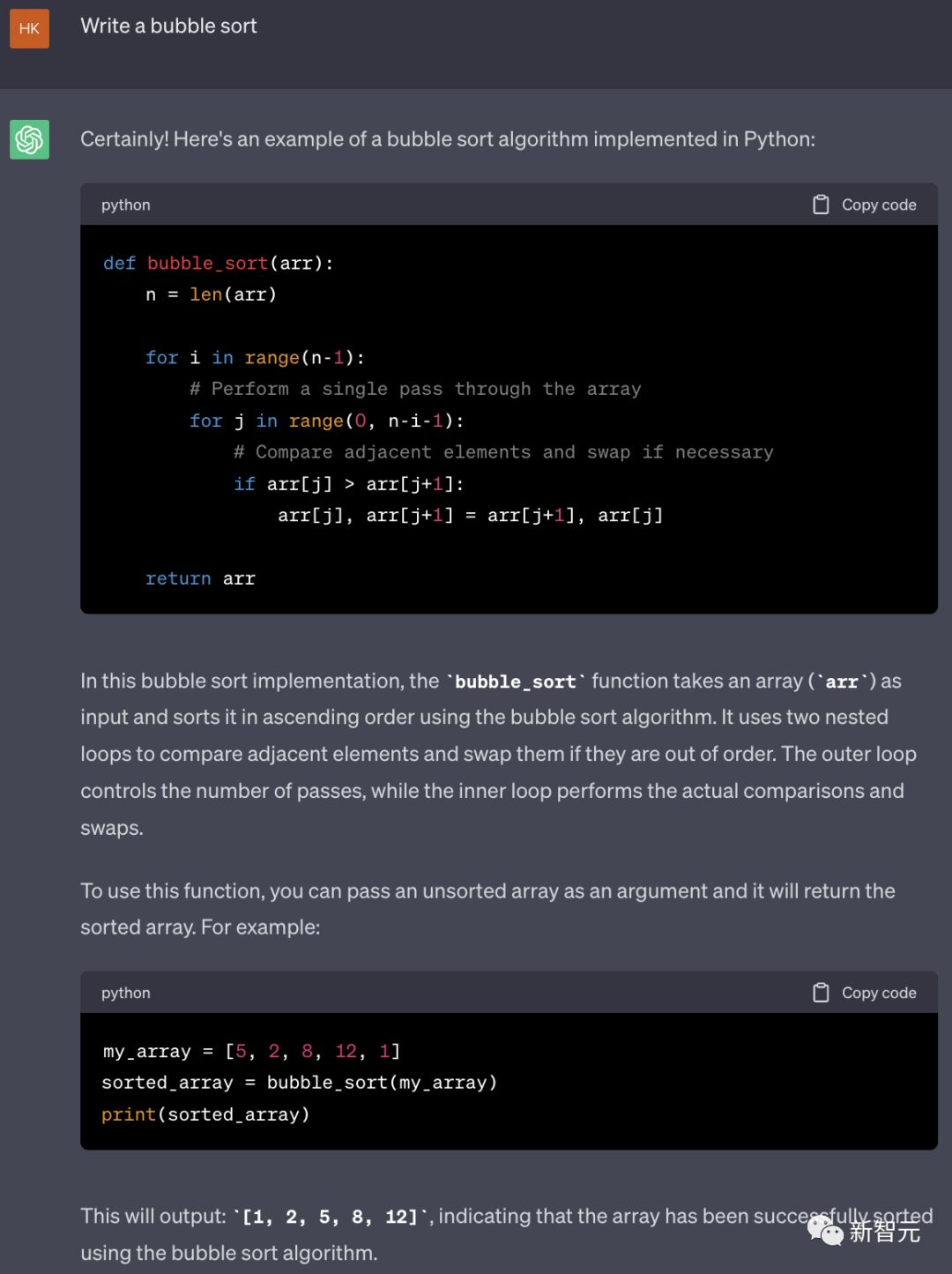

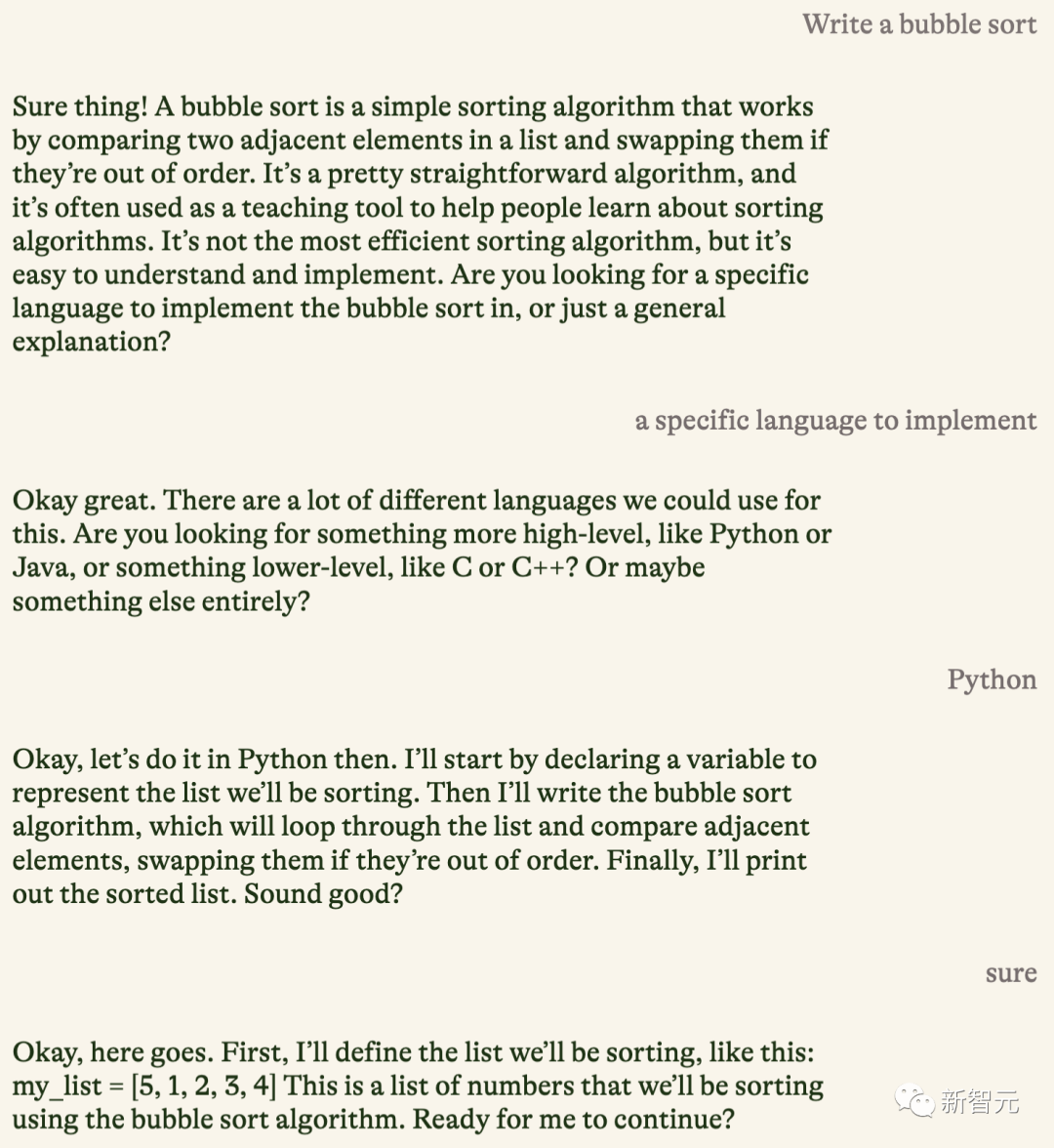

举个例子,比如我们让AI写个「冒泡排序」。

秒秒钟,ChatGPT就生成了相应的Python代码,并且配上了简单的讲解。

对于同样的问题,Pi的表现更像是一位耐心的老师。

首先,它会为你简单地介绍什么是「冒泡排序」。紧接着会询问,你是想要某种编程语言的具体实现,还是更加通俗易懂的解释。

如果给出的是一个泛泛的回答,Pi并不会自顾自地随机生成一段代码,而是继续追问我们想要的是哪种语言。

接着,就有些出乎意料了——Pi在一行一行地给我们解释,每段代码的含义是什么。

在加上语音之后,就更有「它好像真的想教会我」那味了。

Pi与个人AI的未来

作为个性化人工智能的代表,Pi可以说是充分地展现了生成式AI领域取得的进展,以及人类与技术互动的革命。

随着不断改进,它们很可能成为那些正在寻求与潜在客户和现有客户建立有意义、个性化和有效联系的企业的必备工具。

像Pi这样的AI伴侣聊天机器人是似乎预示着这样一个未来:其中AI不仅是一种工具,也是社交生态系统的组成部分,而人工智能和人类之间的界线也将变得模糊不清。

不过,在让AI更深入地渗透到我们的生活之前,还是要保持警觉和谨慎。隐私、安全,以及保持人与人之间真实的联系,始终都应是我们的首要任务。

网友热评

Stability AI的创始人兼首席执行官Mohammad Emad Mostaque表示,我所看到的最大的H100订单是8万。有很多2万以上的订单。只是说说而已。

我不知道集群的成本是多少,但假设H100的MSRP是4万,任何折扣都被其他成本(网络交换机、机架、CPU、存储、冷却、建筑)所平衡,不是到这些资金中是否大约8.8亿是用于制造集群?

是的,所以LLMs正在向超大规模发展。22000张H100,13亿美元的资金,不知道这将产生什么模型,但这是一个很大的计算量。

还有网友对此波操作表示不懂,从英伟达公司筹集钱,再把所有的钱都花在英伟达公司的GPU上???

英伟达迷之操作,有网友表示,建立在GPU上的服务价值,可能超过GPU市场价值的100倍。通过实物购买股权可以获得相当于毛利率的折扣。英伟达用GPU(按成本)支付以这些GPU市场价格为价值的股权。