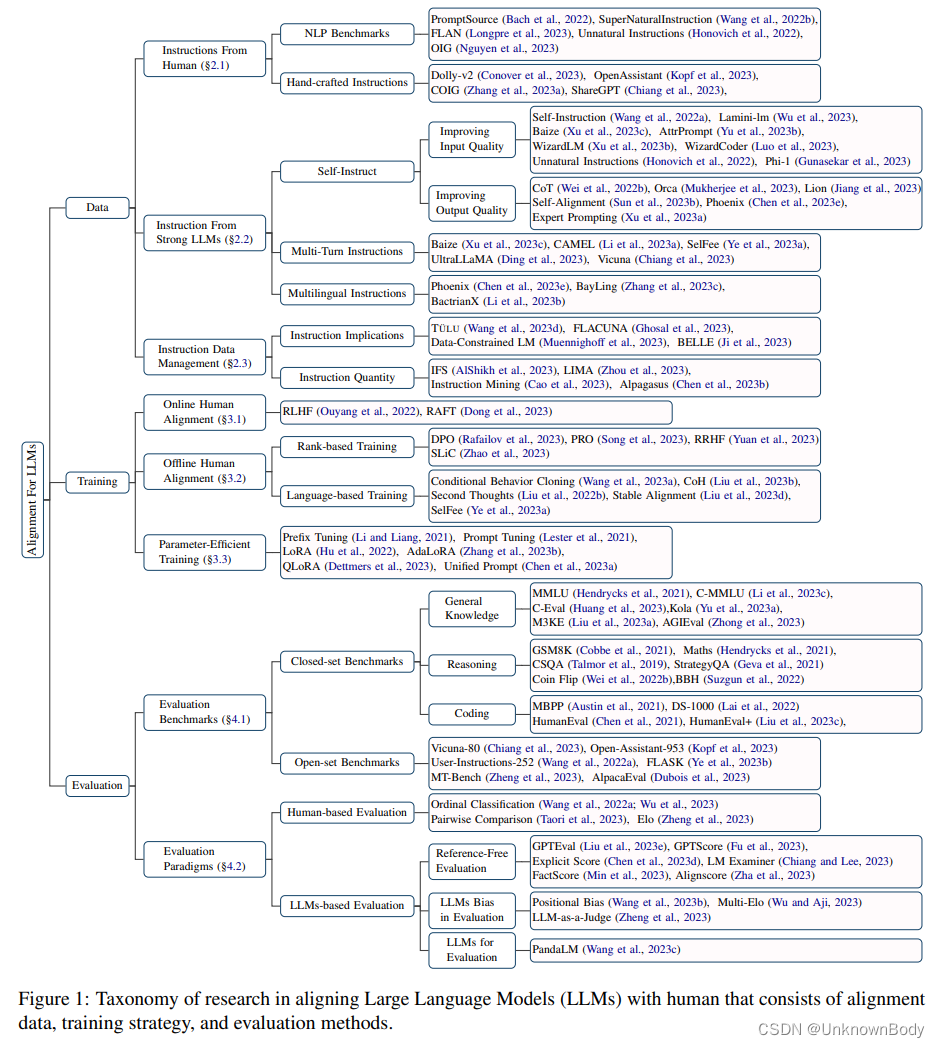

本文也是LLM相关的综述文章,针对《Aligning Large Language Models with Human: A Survey》的翻译。

对齐人类与大语言模型:综述

- 摘要

- 1 引言

- 2 对齐数据收集

- 2.1 来自人类的指令

- 2.1.1 NLP基准

- 2.1.2 人工构造指令

- 2.2 来自强大LLM的指令

- 2.2.1 自指令

- 2.2.2 多轮指令

- 2.2.3 多语言指令

- 2.3 指令数据管理

- 3 对齐训练

- 3.1 在线人类偏好训练

- 3.2 离线人类偏好训练

- 3.2.1 基于排序的方法

- 3.2.2 基于语言的方法

- 3.3 参数有效训练

- 4 对齐评估

- 4.1 评估基准

- 4.1.1 封闭式基准

- 4.1.2 开放式基准

- 4.2 评价范式

- 4.2.1 基于人类的评估

- 4.2.2 基于LLM的评估

- 5 挑战与未来方向

- 6 结论

摘要

在大量文本语料库上训练的大型语言模型(LLM)已成为一系列自然语言处理(NLP)任务的领先解决方案。尽管这些模型具有显著的性能,但它们容易受到某些限制,如误解人类指令、生成潜在的偏见内容或事实上不正确(产生幻觉)的信息。因此,将LLM与人类期望相结合已成为研究界关注的一个活跃领域。本调查全面概述了这些对齐技术,包括以下方面。(1) 数据收集:有效收集LLM对齐的高质量指令的方法,包括使用NLP基准、人工注释和利用强大的LLM。(2) 训练方法:详细审查LLM调整所采用的主流训练方法。我们的探索包括监督微调,在线和离线人类偏好训练,以及参数有效的训练机制。(3) 模型评估:评估这些与人类一致的LLM有效性的方法,为其评估提供了多方面的方法。最后,我们整理和提炼了我们的发现,为该领域未来的几个有前景的研究途径提供了线索。因此,对于任何致力于理解和推进LLM调整以更好地适应以人为本的任务和期望的人来说,这项调查都是一项宝贵的资源。收集最新论文的相关GitHub链接可在https://github.com/GaryYufei/AlignLLMHhumanSurvey。

1 引言

2 对齐数据收集

2.1 来自人类的指令

2.1.1 NLP基准

2.1.2 人工构造指令

2.2 来自强大LLM的指令

2.2.1 自指令

2.2.2 多轮指令

2.2.3 多语言指令

2.3 指令数据管理

3 对齐训练

3.1 在线人类偏好训练

3.2 离线人类偏好训练

3.2.1 基于排序的方法

3.2.2 基于语言的方法

3.3 参数有效训练

4 对齐评估

4.1 评估基准

4.1.1 封闭式基准

4.1.2 开放式基准

4.2 评价范式

4.2.1 基于人类的评估

4.2.2 基于LLM的评估

5 挑战与未来方向

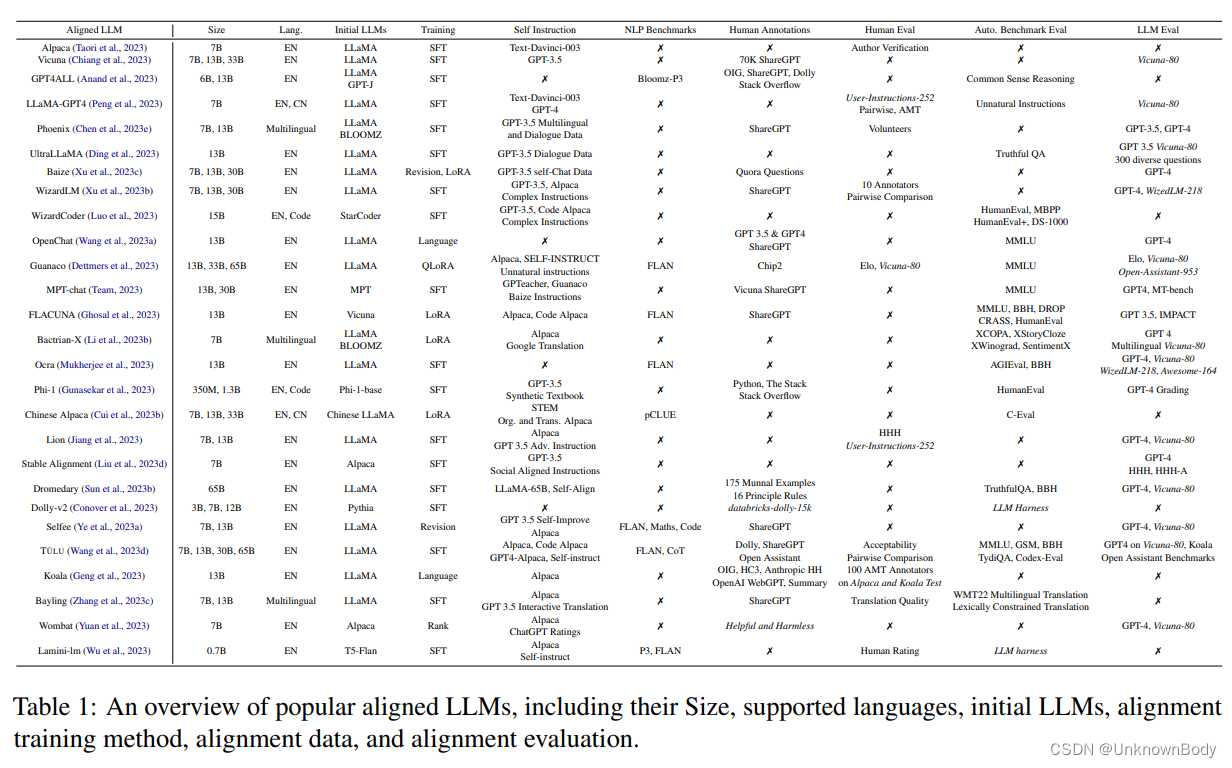

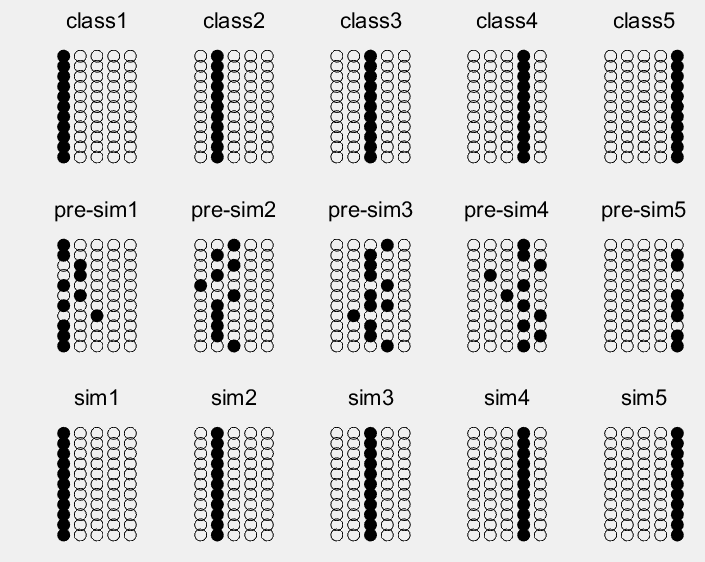

LLM对齐的发展仍处于初级阶段,因此还有很大的改进空间。在本节中,我们在表1中总结了将LLM与人类相结合的现有重要研究工作。下面,我们将讨论其中的一些挑战以及相应的未来研究方向。

6 结论

本次综述对LLM对齐技术的最新进展进行了最新综述。我们将这些研究工作总结为对齐指令收集、对齐训练和对齐评估。最后,我们指出了LLM对齐的几个有前景的未来方向。我们希望这项调查能够提供有见地的视角,并激励进一步研究如何改善LLM的一致性。

![智慧水利整体解决方案[43页PPT]](https://img-blog.csdnimg.cn/img_convert/fac9d85bb599af888c0454fe96fa7ff1.jpeg)