目录

项目介绍

项目概述

界面开发

界面分析

创建工程

主界面布局设计

窗口主框架设计

界面美化

主窗口设定

添加图片资源

head处理

播放控制区处理

自定义控件

BtForm

推荐页面

自定义CommonPage

自定义ListItemBox

自定义MusicSlider

自定义VolumeTool

音乐管理

音乐加载

MusicList类

Music类

音乐分类

更新Music信息到ComonPage界面

CommonPage显示不足处理

音乐收藏

音乐播放控制

QMediaPlayer类

QMediaPlaylist类

歌曲播放

lrc歌词同步

持久化支持

SQLite数据库介绍

QSqlDatabase类介绍

QQMusic中数据库支持

边角问题处理

更换主窗口图标

处理最大化、最小化按钮

歌词按钮的样式

CommonPage中滚动条格式

BtForm上动画问题

点击BtForm偶尔窗口乱移问题

点击添加按钮歌曲重复加载问题

添加系统托盘

保证程序只运行⼀次

禁止qDebug()输出

项目打包

项目总结

源码链接

项目介绍

项目概述

综合运用UI界面设计其主要功能如下:

窗口head部分:

- 点击窗口最小化按钮,窗口最小化

- 点击窗口最大化按钮,窗口无反应(即禁止窗口最大化)

- 点击关闭按钮,程序隐藏到任务栏中

- 点击换肤按钮,更好皮肤(该功能暂未支持,后期可继续拓展)

- 点击搜索框搜索功能(该功能暂未支持,后期可继续拓展)

窗口body左侧:

- 点击推荐按钮,窗口右侧显示:推荐Page(暂只有⻚⾯)

- 点击电台按钮,窗口右侧显示:电台Page(未⽀持)

- 点击⾳乐馆按钮,窗口右侧显示:⾳乐馆Page(未⽀持)

- 点击我喜欢按钮,窗口右侧显示:收藏的⾳乐Page

- 点击本地下载按钮,窗口右侧显示:本地⾳乐Page

- 点击最近播放按钮,窗口右侧显示:最近播放Page

注意:左侧按钮,当光标悬停在上面时有不同颜色突出显示,当点击时颜色会加深。

窗口右侧:

- 点击全部播放按钮,播放当前页面列表中所有音乐

- 双击列表中某⾳乐,播放当前选中音乐

- 点击爱心⽀持收藏

- 支持最近播放过的音乐

播放控制区:

- 支持seek功能,即拖拽到歌曲指定位置播放

- 支持随机、单曲循环、循环播放

- 支持播放上⼀曲

- 支持播放下一首

- 支持播放和暂停

- 支持音量调节和静音

- 支持歌词总时长显示+当前播放时间显示

- 支持LRC歌词同步显示

- 支持歌名、歌手、歌曲专辑图片显示

界面开发

界面分析

界面上控件比较多,归类之后建议分为三部分:head区、body区、play区

head区域:从左向右依次为图标Logo、搜索框、更换皮肤按钮、最小化&最大化&退出按钮

body区域:分为左侧类型选择区域和右侧Page展示区

body左侧区域有两部分组成:在线音乐和我的音乐,两部分内部的控件种类是相同的

- ①⑤区域划分,实际为QLabel

- ②自定义控件:图片+文本+动画

- ③④⑤⑥⑦⑧同②一样,自定义控件:图片+文本+动画

body右侧区域:Page区

Page区:歌曲信息界面,鼠标点击翻页按钮具有轮播图效果。

play区域:播放控制区、播放进度两部分构成

播放进度:当前歌曲播放进度说明,支持seek功能,与播放控制区时间、以及LRC歌词是同步的

播放控制区域:显示歌曲图片&歌名&歌手、播放模式选择&上一首&播放|暂停&下一首&音量条件和静音&添加本地歌曲、当前播放时间/歌曲总时长&弹出歌词窗口按钮

Page说明:

当点击body左侧不同的按钮时,Page页面会显示不同的页面

| 推荐按钮 |  |

| 电台 | 暂未支持 |

| 音乐馆 | 暂未支持 |

| 喜欢 |  |

| 本地和下载 |  |

| 最近播放 |  |

body右侧目前支持的4个页面结构,整体的布局是相同的,唯独Page区域显示的内容稍有区别

推荐页面具有类似轮播图的动态效果:

- 上⽅显示1行,内部有4个推荐元素;下方显示2行,每行有4个推荐元素

- 左右两侧⼀个按钮,点击后推荐内容会更换下⼀批,不停点击会循环推荐

- 当鼠标悬停在推荐元素上时,推荐元素会向上移动,当⿏标离开时,⼜回到原位置

- 当鼠标悬停在推荐元素上时,同时会出现小手图标,说明该推荐元素具有点击功能

喜欢、本地和下载、最近播放类似下图:

- ①QLabel:类型说明

- ②QLabel:图片显示

- ③QButton:播放全部按钮

- ④一组QLabel说明:歌名、歌手、歌曲专辑

- ⑤QListWidget:播放列表

可以通过自定义控件的方式,将①~⑤的控件集成到一起形成一个新的控件,方便复用,因此这三个Page属于同一个自定义类型的Page

这两个页面,将来由QStackedWidget控件组织管理起来,就可以实现点击不同按钮,显示不同页面的效果。

歌词界面:

解析当前正在播放音乐的歌词,同步显示在界面上

显示内容分为:歌词部分信息、左上角收起隐藏按钮

- 歌词部分展示当前正在播放词和在播放部分前三行和后三行歌词展示,当前播放歌词突出显示

- 点击收起按钮后,该页面会以动画滑动的方式收起

当歌曲有LRC歌词时,播放时歌词会随播放时间自动调整,歌词没有LRC歌词时,歌词部分显示空字符

创建工程

主界面布局设计

基于Widget局部

Qt系统提供四种布局管理器:

- QHBoxLayout:水平布局

- QVBoxLayout:垂直布局

- QGridLayout:栅格布局

- QFormLayout:表单布局

因此本项目基于Widget来进行布局

窗口主框架设计

主窗口的布局

选中该项目,在弹出的属性中找个geometry属性,将窗口高度宽度改为:1040*700

为了看到效果,选中backroound控件,然后右键单击,弹出菜单中选择改变样式表,内部添加:

background-color:gray;此处的颜⾊效果仅为⽅便看到界⾯效果,等界⾯框架设计完成后,将所有的颜⾊清除掉,界⾯添加特定颜⾊。

整个窗口由head、body、play上中下三部分组成。

直接拖三个Widget放到设计区,双击将名字修改为head、body、play;

head、body、play平分了整个background,并且它们三个之间的margin有间隔。再次选中background对象,右侧属性部分下滑找到Layout,将Margni和Space修改为0

但是head占区域过⼤,选中head对象,将head的minimumSize和maxmumSize属性的⾼度都调整为80,这样head的大小就固定了

head内部设计

head内部由两部分构成,headLeft区域显⽰图标Logo,headRight区域为搜索框和功能按钮区域。

拖两个widget到head中,选中head对象,点击⽔平布局。

继续选中head对象,下滑找到Layout属性,将Margin和Spacing全部设置为0

选中headLeft对象,将minimumSize和maximumSize的宽度修改为200,就能看到head的初步效果

headLeft

拖⼀个QLabel控件放置headLeft内,将QLabel的objectName修改为logo,text属性修改为空;然后选中headLeft,点击⽔平布局,此时QLabel就会填充满headLeft。同样需要选中headLeft,下滑找到Layout属性,将Margin和spacing全部设置为0

headRight

headRight内部也是由两部分构成:搜索框和按钮区域

拖拽两个widget到headRight,修改objectName为SearchBox和SettingBox,将SearchBox的minimumSize和maximumSize的宽度修改为300

选中headRight,然后点击⽔平布局,并将headRight的Margin和Spacing修改为0。

searchBox

拖⼀个QLineEdit进去,然后选中searchBox点击⽔平布局

settingBox

拖拽⼀个按钮到SettingBox,按钮的minimumSize和maximumSize的宽度和⾼度都修改为30,然后⿏标选中,按着ctrl键+⿏标拖拽,复制3个出来摆放好,依次将四个按钮的objectName从左往右修改为:skin、max、min、quit,并将按钮的text属性也修改为空,将来设置图⽚。在控件区域找到Spacers,找到Horizontal Spacer控件,拖拽到SettingBox区域

选中SettingBox,点击⽔平布局,并将SettingBox的Margin和Spacing修改为0

Body部分布局

整个body部分是由bodyLeft和bodyRight两部分组成。

- 拖两个Widget到Body中,将objectName修改为bodyLeft和bodyRight

- 选中body,点击⽔平布局,将bodyLeft的minimumSize和maxmumSize的宽度修改为200

- 选中Body,将body的Margin和Spacing修改为0

bodyLeft内部布局

- 拖拽⼀个Widget到bodyLeft,将objectName修改为leftBox,背景颜⾊修改为:backgroundcolor:pink;

- 拖拽Vertical Spacer到bodyLeft

- 选中leftBox,将minmumSize和maxmumSize的⾼度修改为420

- 选中bodyLeft,点击垂直布局,并将bodyLeft的Margin和Spacing修改为0

leftBox内部布局

leftBox内部包含:在线⾳乐和我的⾳乐两部分

- 拖拽两个Widget到leftBox中,将objectName依次修改为:onlineMusic和myMusic

- 选中leftBox,点击垂直布局,然后将Margin和Spacing设置为0

- onlineMusic和myMusic内部的元素都是相同的,由⼀个QLabel和三个Widget构成,后期Widget会替换为⾃定义按钮,此处先⽤Widget占位。因此分别向onlineMusic和myMusic内部拖拽一个QLabel和三个QWidget,并选中onlineMusic和myMusic点击垂直布局,然后将Margin和Spacing设置为0

bodyRight布局

bodyRight一个层叠窗口

- 拖拽层叠窗口控件StackedWidget,就在Widget控件上方到bodyRight中

- 选中bodyRight,点击垂直布局,然后将bodyRight的Margin和Spacing修改为0

stackedWidget内部增加页面

stackedWidget默认会提供两个⻚⾯,还需添加四个⻚⾯

在对象区域选中stackedWidget控件,然后右键单击弹出菜单中选择添加⻚

以类似的⽅式添加添加4个⻚⾯,并修改每个⻚⾯的objectName如下:

总共六个⻚⾯,每个⻚⾯都有⾃⼰的索引,所以是从0开始的,将来切换⻚⾯时就是通过索引来切换的。

选中stackedWidget,然后右键单击,弹出菜单中选择:改变页顺序,在弹出的窗⼝中就能看到每个页面的索引

六个⻚⾯中,recPage页面需要实现,musicPage、radioPage暂未⽀持

Play布局

进度滑竿、播放控制区两部分组成

- 拖拽Widget到Play,将objectName修改为processBar,将minimumSize和maximumSize的⾼度修改为75

- 选中Play,点击垂直布局,然后将bodyRight的Margin和Spacing修改为0

ControlBox内部布局

该区域内部由三部分组成:歌曲信息部分、播放控制部分、时间显示

- 拖拽三个Widget到ControlBox中,将ObjectName依次修改为play_1、play_2、play_3

- 选中ControlBox,点击⽔平布局,将ControlBox的Margin和Spacing修改为0

play1内部:

- 拖拽3个QLabel,放置歌曲图⽚、歌⼿名和歌曲名字,调整好位置,将QLabel的objectName修改为: musicCover、musicName、musicSinger

- 然后选中play1,点击栅格布局

拖入一个Widget:

- 左侧Widget放入Vertical Spacer和一个QLabel,QLabel的objectName修改为currentTime

- Widget的宽度修改为60,利用弹簧调整QLabel位置与progressBar进度条平行

- 选中Widget,点击⽔平布局,并将Margin和Spacing修改为0

play2内部:

- 添加两个Widget最上面从左到右依次摆放6个按钮,按钮的minimumSize和maxmumSize均修改为30*30,将objectName从左往右依次修改为:playMode、playUp、Play、playDown、volume、addLocal,最下面放一个进度条将objectName修改为:progressBar,进度条高度设置为20

- 然后选中play2,点击⽔平布局,并将play_2的Margin和Spacing修改为0

拖入一个Widget:

- 又侧Widget放入Vertical Spacer和一个QLabel,QLabel的objectName修改为totalTime

- Widget的宽度修改为60,利用弹簧调整QLabel位置与progressBar进度条平行

- 选中Widget,点击⽔平布局,并将Margin和Spacing修改为0

play3内部:

- 拖入一个QPushButton按钮,按钮的objectName修改为lrcWord

- 选中play3,点击⽔平布局,并将play3的Margin和Spacing修改为0

界面美化

主窗口设定

仔细观察发现主窗⼝是没有标题栏,因此在窗⼝创建前,就需要设置下窗⼝的格式

QWidget::setWindowFlag(...): 设置窗⼝格式,⽐如创建⽆边框的窗⼝由于窗口中控件比较多,这些控件将来都需要初始化,如果将所有代码放在QQMusic的构造函数中实现,将来会造成构造函数非常臃肿,因此在QQMusic类中添加initUI()方法来完成界面初始化⼯作

// QQMusic.h ⽂件中添加:

void initUI();

// 添加完成后,光标放在函数名字上按 alt + Enter 组合键完成⽅法定义// QQMusic.cpp 头⽂件中完成定义

void QQMusic::initUI()

{// 设置⽆边框窗⼝,即窗⼝将来⽆标题栏setWindowFlag(Qt::WindowType::FramelessWindowHint);

}添加完成后⼀定要在QQMusic的构造函数中调用initUI()函数,否则设置不会生效。运行后,发现有以下两个问题:

- 窗口无标题栏,找不到关闭按钮,导致窗口无法关闭

- 窗口无法拖拽

关闭窗口,可以先将光标放在任务栏中当前应用程序图标上,弹出的框中选择关闭,后序会实现关闭功能

主界面无法拖动,此时只需要处理下鼠标单击(mousePressEvent)和鼠标移动(mouseMoveEvent)事件即可

鼠标左键按下时,记录下窗口左上⻆和鼠标的相对位置

鼠标移动时,会产⽣新的位置,保持鼠标和窗口左上⻆相对位置不变,通过move修改窗口的左上⻆坐标即可

// QQMusic.h中添加

protected:// 重写QWidget类的⿏标单击和⿏标滚轮事件void mousePressEvent(QMouseEvent *event)override;void mouseMoveEvent(QMouseEvent* event)override;// 记录光标相对于窗⼝标题栏的相对距离QPoint dragPosition;// QQMusic.cpp中添加

void QQMusic::mousePressEvent(QMouseEvent *event)

{// 拦截⿏标左键单击事件if(event->button() == Qt::LeftButton){// event->globalPos():⿏标按下事件发⽣时,光标相对于屏幕左上⻆位置// frameGeometry().topLeft(): ⿏标按下事件发⽣时,窗⼝左上⻆位置// geometry(): 不包括边框及顶部标题区的范围// frameGeometry(): 包括边框及顶部标题区的范围// event->globalPos() - frameGeometry().topLeft() 即为:// ⿏标按下时,窗⼝左上⻆和光标之间的距离差// 想要窗⼝⿏标按下时窗⼝移动,只需要在mouseMoveEvent中,让光标和窗⼝左上⻆保持相同的位置差// 获取⿏标相对于屏幕左上⻆的全局坐标dragPosition = event->globalPos() - frameGeometry().topLeft();return;}QWidget::mousePressEvent(event);

}void QQMusic::mouseMoveEvent(QMouseEvent *event)

{if(event->buttons() == Qt::LeftButton){// 根据⿏标移动更新窗⼝位置move(event->globalPos() - dragPosition);return;}QWidget::mouseMoveEvent(event);

}再仔细观察,窗口周围是有阴影效果的,窗口四周黑色部分就是阴影

给窗⼝添加阴影需要用到QGraphicsDropShadowEffect类

- 创建QGraphicsDropShadowEffect类对象

- 设置阴影的属性。比如:设置阴影的偏移、颜色、圆角等

- 将阴影设置到具体对象上

在initUI()函数中添加如下代码:

// 设置窗⼝背景透明

this->setAttribute(Qt::WA_TranslucentBackground);// 给窗⼝设置阴影效果

QGraphicsDropShadowEffect* shadowEffect = new

QGraphicsDropShadowEffect(this);

shadowEffect->setOffset(0,0); // 设置阴影偏移

shadowEffect->setColor("#000000"); // 设置阴影颜⾊:⿊⾊

shadowEffect->setBlurRadius(10); // 设置阴影的模糊半径

this->setGraphicsEffect(shadowEffect);给窗口设置阴影效果时,需要将窗口标题栏⽆边框,背景设置为透明

添加图片资源

添加⼀个qrc⽂件,将图片资源拷贝到工程目录下,并添加到工程中

将之前布局时所有按钮的背景颜色全部清除掉,按照下面的风格重新设定

head处理

颜色查看器

| 控件 | QSS美化 |

| headLeft | |

| headRight | |

| Logo | |

| lineEdit | |

| settingBox | |

| skin | |

| max | |

| min | |

| quit | |

| bodyLeft | |

| bodyRight | |

| Play | |

播放控制区处理

祛除play1、play2、play3的页面布局时设置的临时背景色。将按钮上的文字全部去除,然后重新添加样式和图片

| 控件 | QSS美化 |

| play2 | |

| playMode | |

| playUp | |

| play | |

| playDown | |

| volume | |

| addLocal | |

| lrcWord | |

自定义控件

BtForm

BtForm界面设计

添加⼀个新设计界面,命名为BtForm

该控件实际由:图片、⽂字、动画三部分组成。图片和⽂字分别⽤QLabel展示,动画部分内部实际为4个QLabel

- 将BtForm的geometry的宽度和⾼度修改为200*35。

- 拖⼀个Widget到btForm中,objectName修改为btStyle,将btForm的margin和Spacing设置为0

- 拖2个QLable和1个Widget到btStyle中,并将objectName依次修改为btIcon、btText、lineBoxbtIcon的minimumSize和maximumSize的宽度设置为30(为了看到效果可将颜色设置为red)btText的minimumSize和maximumSize的宽度设置为90(为了看到效果可将颜色设置为green)lineBox的minimumSize和maximumSize的宽度设置为30然后选中btStyle,并将其margin和Spacing设置为0

- 然后往lineBox内部拖4个QLabel,objectName依次修改为line1、line2、line3、line4,minimumSize和maximumSize的宽度均设置为2

| 控件 | QSS美化 |

| btStyle | |

| lineBox | |

将bodyLeft内部onlineMusic和MyMusic中的QWidget全部提升为BtForm

选中要提升的控件,比如:Rec,在弹出的菜单中选择提升为,会出现⼀个新窗口(如下右侧图),在提升的类名称中输⼊要提升为的类型BtForm,然后点击添加,最后选中btform.h点击提升,便可以将Rec由QWidget提升为⾃定义的BtForm类型

BtForm类中实现

设置按钮上的图⽚和文字信息,以及该按钮关联的page页面

// btform.h 新增

// 按钮id:该按钮对应的page⻚

int id = 0;// 设置图标 ⽂字 id

void seticon(QString btIcon,QString content,int mid);// btform.cpp新增

void btFrom::seticon(QString btIcon,QString btText,int mid)

{// 设置⾃定义按钮的图⽚、⽂字、以及idui->btIcon->setPixmap(QPixmap(btIcon));ui->btText->setText(btText);this->id = mid;

}在QQMusic.cpp的initUI()函数中新增:

void Widget::initUi()

{// ...// 设置BodyLeft中6个btForm的信息ui->rec->seticon(":/images/rec.png", "推荐", 1);ui->music->seticon(":/images/music.png", "⾳乐馆", 2);ui->audio->seticon(":/images/radio.png", "电台", 3);ui->like->seticon(":/images/like.png", "我喜欢", 4);ui->local->seticon(":/images/local.png", "本地下载", 5);ui->recent->seticon(":/images/recent.png", "最近播放", 6);

}按钮响应

重写鼠标mousePressEvent,当按钮按下时:

- 按钮颜色发生变化

- 给QQMusic类发送click信号

/ btform.h 新增

protected:// ⿏标点击事件virtual void mousePressEvent(QMouseEvent *event);// btform.cpp新增

void btFrom::mousePressEvent(QMouseEvent *event)

{// 告诉编译器不要触发警告(void)event;// ⿏标点击之后,背景变为绿⾊,⽂字变为⽩⾊ui->btStyle->setStyleSheet("#btStyle{ background:rgb(30,206,154);}*{color:#F6F6F6;}");emit click(this->id); // 发送⿏标点击信号

}- QQMusic类处理该信号,内部:实现窗口切换,并清除上次按钮点击留下的样式,因此QQMuisc中需要新增:

// qqmusic.h 新增

// btForm点击槽函数void onBtFormClick(int id);

// qqmusic.cpp 新增

void QQMusic::connectSignalAndSlot()

{// ...// ⾃定义的btFrom按钮点击信号,当btForm点击后,设置对应的堆叠窗⼝connect(ui->rec, &btFrom::click, this, &QQMusic::onBtFormClick);connect(ui->musics, &btFrom::click, this, &QQMusic::onBtFormClick);connect(ui->audio, &btFrom::click, this, &QQMusic::onBtFormClick);connect(ui->like, &btFrom::click, this, &QQMusic::onBtFormClick);connect(ui->local, &btFrom::click, this, &QQMusic::onBtFormClick);connect(ui->recent, &btFrom::click, this, &QQMusic::onBtFormClick);}void Widget::onBtFormClick(int id)

{// 1.获取当前⻚⾯所有btFrom按钮类型的对象QList<BtForm*> buttonList = this->findChildren<BtForm*>();// 2.遍历所有对象, 如果不是当前id的按钮,则把之前设置的背景颜⾊清除掉foreach(BtForm* btitem, buttonList){if(id != btitem->getId()){btitem->clearBg();}}// 3.设置当前栈空间显⽰⻚⾯ui->stackedWidget->setCurrentIndex(id - 1);

}- BtForm类中新增:

// btform.h 新增

public:// 清除上⼀次按钮点击留下的样式void clearBg();// 获取idint getId();// btform.cpp 新增:

void BtForm::clearBg()

{// 清除上⼀个按钮点击的背景效果,恢复之前的样式ui->btStyle->setStyleSheet("#btStyle:hover{ background:#D8D8D8;} ");

}int BtForm::getId()

{return id;

}为了能看到Page切换的效果,可以在stackedWidget的每个page上放⼀个QLabel说明

BtFrom上的动画效果

Qt中QPropertyAnimation类可以提供简单的动画效果,允许对QObject获取派生类的可读写属性进行动画处理,创建平滑、连续的动画效果,比如控件的位置、大小、颜色等属性变化,使用时需包含<QPropertyAnimation>

关键函数说明:

/*

功能:实例化QPropertyAnimation类对象

参数:target: 给target设置动画效果propertyName:动画如何变化,⽐如:geometry,让target以矩形的⽅式滑动parent:该动画实⼒的⽗对象,即将该对象加到对象树中

*/QPropertyAnimation(QObject *target,const QByteArray &propertyName,QObject *parent = nullptr);/*

功能: 设置动画持续的时⻓

参数: 单位为毫秒

*/void setDuration(int msecs);

/*

功能:根据value创建关键帧

参数:

step:值再0~1之间,0表⽰开始,1表⽰停⽌

value:动画的⼀个关键帧,即动画现在的形态,假设是基于geometry,可以设置矩形的范围

*/void setKeyValueAt(qreal step, const QVariant &value);/*

功能:设置动画的循环次数

参数:

loopCount:默认值是1,表⽰动画执⾏1次,如果是-1,表⽰⽆限循环

*/void setLoopCount(int loopCount);/// 槽函数 ///

void pause(); // 暂停动画

void start(QAbstractAnimation::DeletionPolicy policy = KeepWhenStopped); // 开启动画

void stop(); // 停⽌动画// 设置动画的起始帧

void setStartValue(const QVariant &value)// 设置动画的结束帧

void setEndValue(const QVariant &value);/*

设置动画效果步骤:

1. 创建QPropertyAnimation 对象

2. 设置动画的持续时间

3. 设置动画的关键帧

4. 设置动画的循环次数【⾮必须】,如果未调⽤动画默认执⾏⼀次

5. 开启动画

6. 动画运⾏结束时,会发射finished信号,如果需要进⾏额外处理时,处理该信号即可

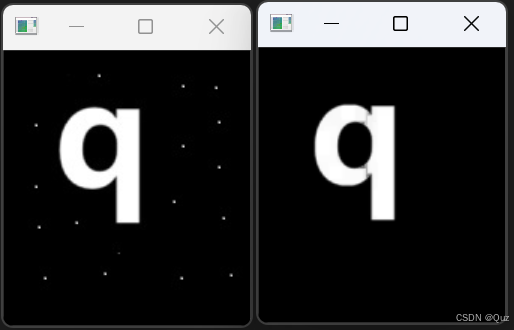

*/lineBox中的line1、line2、line3、line4添加动画效果,BtForm类中增加如下代码:

// btform.h 新增:// linebox动画起伏效果QPropertyAnimation *animationLine1;QPropertyAnimation *animationLine2;QPropertyAnimation *animationLine3;QPropertyAnimation *animationLine4;// btform.cpp的构造函数中新增:

BtForm::BtForm(QWidget *parent) :QWidget(parent),ui(new Ui::BtForm)

{ui->setupUi(this);// 设置line1的动画效果line1Animal = new QPropertyAnimation(ui->line1, "geometry", this);line1Animal->setDuration(1800);line1Animal->setKeyValueAt(0, QRect(0, 15, 2, 0));line1Animal->setKeyValueAt(0.5, QRect(0, 0, 2, 15));line1Animal->setKeyValueAt(1, QRect(0, 15, 2, 0));line1Animal->setLoopCount(-1);line1Animal->start();// 设置line2的动画效果line2Animal = new QPropertyAnimation(ui->line2, "geometry", this);line2Animal->setDuration(1700);line2Animal->setKeyValueAt(0, QRect(6, 15, 2, 0));line2Animal->setKeyValueAt(0.5, QRect(6, 0, 2, 15));line2Animal->setKeyValueAt(1, QRect(6, 15, 2, 0));line2Animal->setLoopCount(-1);line2Animal->start();// 设置line3的动画效果line3Animal = new QPropertyAnimation(ui->line3, "geometry", this);line3Animal->setDuration(1900);line3Animal->setKeyValueAt(0, QRect(12, 15, 2, 0));line3Animal->setKeyValueAt(0.5, QRect(12, 0, 2, 15));line3Animal->setKeyValueAt(1, QRect(12, 15, 2, 0));line3Animal->setLoopCount(-1);line3Animal->start();// 设置line4的动画效果line4Animal = new QPropertyAnimation(ui->line4, "geometry", this);line4Animal->setDuration(2000);line4Animal->setKeyValueAt(0, QRect(18, 15, 2, 0));line4Animal->setKeyValueAt(0.5, QRect(18, 0, 2, 15));line4Animal->setKeyValueAt(1, QRect(18, 15, 2, 0));line4Animal->setLoopCount(-1);line4Animal->start();

}关于动画显示

动画并不是所有页面都显示,只有当前选中的页面显示,所以默认情况下,动画隐藏。默认情况下设置addlocal显示

// btform.h 新增:

// 显⽰动画效果

void showAnimal();// btform.cpp的中新增:

void btFrom::showAnimal()

{// 显⽰linebox, 设置颜⾊为绿⾊ui->linebox->show();

}// QQMusic的initUI中设置默认选中

void QQMusic::initUi()

{// ...// 本地下载BtForm动画默认显⽰ui->local->showAnimal();ui->stackedWidget->setCurrentIndex(4);

}推荐页面

推荐页面分析

仔细观察推荐页面,对其进行拆解发现,推荐页面由五部分构成:

- ①"推荐"文本提⽰,即QLabel

- ②"今⽇为你推荐"⽂本提⽰,即QLabel

- ③具体推荐的歌曲内容,点击左右两侧翻页按钮,具有轮番图效果,将光标放到图上,有图片上移动

- ④"你的推荐歌单"文本提示,即QLabel

- ⑤具体显示音乐,和③实际是⼀样的,不同的是③中⾳乐只有⼀⾏,⑤中的音乐有两行

- 因为页面中元素较多,直接摆到⼀个⻚⾯太拥挤,从右侧的滚动条可以看出,整个页面中的元素都放置在QScrollArea中

仔细分析③发现,里面包含了:

- 左右各两个按钮,点击之后中间的图片会左右移动,Qt中未提供类似该种组合控件,因此③实际为⾃定义控件

- ③中按钮之间的元素,由图⽚和底下的文字组成,当光标放在图片上会有上移的动画,因此该元素实际也为自定义控件

推荐页布局

在stackedWidget中选中推荐页面,objectName为recPage的页⾯,删掉之前添加的QLabel推荐提示

- ①拖拽⼀个QScrollArea到recPage中,geometry的宽度和⾼度修改为822和527

- ②拖拽⼀个QLable,objectName修改为recText,显示内容修改为推荐,minimumSize和maximumSize的⾼度均修改为50,Font大小修改为24

- ③再拖拽⼀个QLable和Widget,QLable的objectName修改为recMusictext,内容修改为"今日为你推荐",minimumSize和maximumSize的⾼度均修改为30,Font大小修改为18;Widget得objectName修改为recMusicBox

- ④再拖拽⼀个QLabel和Widget,QLabel的objectName修改为supplyMusicText,内容修改为"你的推荐歌单",minimumSize和maximumSize的⾼度均修改为30,Font大小修改为18;Widget得objectName修改为supplyMusicBox。

- ⑤最后选中QScrollArea,点击垂直布局。

自定义recBox

RecBox界面布局

- 新添加设计师界⾯,命名为RecBox。geometry的宽⾼修改为:685*400。

- 添加三个Widget,objectName依次修改为leftPage、musicContent、rightPage;leftPage和rightPage的minimumSize和maximumSize修改宽为30,然后选中RecBox点击⽔平布局。将RecBox的margin和Spacing修改为0

- 在upPage和downPage中各拖⼀个按钮,upPage中按钮objectName修改为btUp,minimumSize的⾼度修改为220;downPage中按钮objectName修改为btDown,minimumSize的⾼度修改为220;然后选中upPage和downPage点击⽔平布局。将upPagedownPage和的margin和Spacing修改为0。

- 在musicContent中拖两个Widget,objectName依次修改为recListUp和recListDown,然后选中musicContent点击垂直布局,将musicContent的margin和Spacing修改为0。(为了看清楚效果可临时将recListUp背景⾊设置为:background-color:green;将recListDown背景⾊设置为:background-color:red;)

- 在recListUp和recListDown中分别拖两个⽔平布局器,依次命名为recListUpHLayout和recListDownHLayout,选中recListUp和recListDown点击⽔平布局,将margin和Spacing修改为0

按钮添加如下QSS美化:

| btUp | |

| btDown | |

将QQMusic主界⾯中recPage页面中的recMusicBox和supplyMusicBox提升为RecBox,就能看到如下效果

自定义recBoxItem

RecBoxItem界面布局

添加⼀个Designer界面,命名为RecBoxItem,geometry的宽和高设置为:150*200

拖拽⼀个Widget到RecBoxItem中,objectName修改为musicImageBox,minimumSize和maximumSize的⾼度均修改为150;

拖拽⼀个QLabel到Widget中,objectName修改为recBoxItemText,⽂本设置为"推荐-001",QLabel的alignment属性设置为⽔平、垂直居中。

拖拽⼀个QLabel到musicImageBox中,objectName修改为recMusicImage,geometry设置为:[(0,0),150*150]

拖拽⼀个QPushButton到musicImageBox中,objectName修改为recMusicBtn,删除掉⽂本内容。在属性中找到cursor,点击选择小手图标

#recMusicBt

{border:none;}

RecBoxItem类中添加动画效果

在RecBoxItem类中拦截鼠标进⼊和离开事件,在进⼊时让图片上移,在离开时让图片下移回到原位

// RecBoxItem.h 新增

bool eventFilter(QObject *watched, QEvent *event);// RecBoxItem.cpp 新增

#include <QPropertyAnimation>

#include <QDebug>bool RecBoxItem::eventFilter(QObject *watched, QEvent *event)

{// 注意:recItem上有⼀个按钮,当⿏标放在按钮上时在开启动画if(watched == ui->musicImageBox){int ImgWidget = ui->musicImageBox->width();int ImgHeight = ui->musicImageBox->height();// 拦截⿏标进⼊事件if(event->type() == QEvent::Enter){QPropertyAnimation* animation = new QPropertyAnimation(ui->musicImageBox, "geometry");animation->setDuration(100);animation->setStartValue(QRect(9,10,ImgWidget,ImgHeight));animation->setEndValue(QRect(9, 0, ImgWidget, ImgHeight));animation->start();// 注意:动画结束的时候会触发finished信号,拦截到该信号,销毁animationconnect(animation, &QPropertyAnimation::finished, this, [=](){delete animation;qDebug()<<"图⽚上移动画结束";});return true;}else if(event->type() == QEvent::Leave){// 拦截⿏标离开事件QPropertyAnimation* animation = new QPropertyAnimation(ui->musicImageBox, "geometry");animation->setDuration(150);animation->setStartValue(QRect(9,0,ImgWidget,ImgHeight));animation->setEndValue(QRect(9, 10, ImgWidget, ImgHeight));animation->start();// 注意:动画结束的时候会触发finished信号,拦截到该信号,销毁animationconnect(animation, &QPropertyAnimation::finished, this, [=](){delete animation;qDebug()<<"图⽚上移动画结束";});return true;}}return QObject::eventFilter(watched, event);

}// 注意:不要忘记事件拦截器安装,否则时间拦截不到,因此需要在构造函数中添加:

// 拦截事件处理器时,⼀定要安装事件拦截器

ui->musicImageBox->installEventFilter(this);该类中还需要添加设置推荐文本和图片的⽅法,将来需要在外部来设置每个RecBoxItem的文本和图片

// RecBoxItem.h 新增

void setText(const QString& text);

void setImage(const QString& Imagepath);// RecBoxItem.cpp 新增

void RecBoxItem::setText(const QString& text)

{ui->recBoxItemText->setText(text);

}void RecBoxItem::setImage(const QString& Imagepath)

{QString imgStyle = "border-image:url("+Imagepath+");";ui->recMusicImg->setStyleSheet(imgStyle);

}RecBox添加RecBoxItem

图片路径和推荐文本准备

每个RecBoxItem都有对应的图片和推荐文本,在往RecBox中添加RecBoxItem前需要先将图片路径和对应⽂本准备好。由于图片和文本具有对应关系,可以以键值对⽅式来进⾏组织,以下实现的时采用Qt内置的QJsonObject对象管理图片路径和文本内容

QJsonObject类:

头⽂件: <QJsonObject>

// 功能: 插⼊<key, value>键值对,如果key已经存在,则⽤value更新与key对应的value

// 返回值:返回指向新插⼊项的键值对

QJsonObject::iterator insert(const QString &key, const QJsonValue &value);// 功能:获取与key对应的value

// 返回值:返回的value⽤QJsonValue对象组织

QJsonValue QJsonObject::value(const QString &key) constQJsonArray类

作⽤:管理的是QJsonValue对象

头⽂件:<QJsonArray>

该类重载了[]运算符,可以通过下标⽅式获取管理的QJsonValue对象

QJsonValue operator[](int i) const

QJsonValueRef operator[](int i)// 往QJsonArray中插⼊⼀个QJsonValue对象

void append(const QJsonValue &value)QJsonValue类

// 单参构造⽅法,将QJsonObject对象转换为QJsonValue对象

QJsonValue(const QJsonObject &o)// 将内部管理的数据转化成QJsonObject返回

QJsonObject toObject() const// 将内部管理的数据转化成QString返回

QString toString() cons图⽚路径和对应⽂本的准备⼯作,应该在QQMusic类中处理好,RecBoxItem只负责设置,因此该准备工作需要在QQMusic类中进行,故QQMusic中需要添加如下代码:

// QQMusic.h 新增

// 参数num:RecBox中图⽚个数

QJsonArray RandomPicture();// QQMusic.cpp中新增

// 设置随机图⽚【歌曲的图⽚】

QJsonArray QQMusic::randomPiction()

{// 推荐⽂本 + 推荐图⽚路径QVector<QString> vecImageName;vecImageName<<"001.png"<<"003.png"<<"004.png"<<"005.png"<<"006.png"<<"007.png"<<"008.png"<<"009.png"<<"010.png"<<"011.png"<<"012.png"<<"013.png"<<"014.png"<<"015.png"<<"016.png"<<"017.png"<<"018.png"<<"019.png"<<"020.png"<<"021.png"<<"022.png"<<"023.png"<<"024.png"<<"025.png"<<"026.png"<<"027.png"<<"028.png"<<"029.png"<<"030.png"<<"031.png"<<"032.png"<<"033.png"<<"034.png"<<"035.png"<<"036.png"<<"037.png"<<"038.png"<<"039.png";std::random_shuffle(vecImageName.begin(), vecImageName.end());// 001.png// path: ":/images/rec/"+vecImageName[i];// text: "推荐-001"QJsonArray objArray;for(int i = 0; i < vecImageName.size(); i++){QJsonObject obj;obj.insert("path", ":/images/rec/"+vecImageName[i]);// arg(i, 3, 10, QCchar('0'))// i:要放⼊%1位置的数据// 3: 三位数// 10:表⽰⼗进制数// QChar('0'):数字不够三位,前⾯⽤字符'0'填充QString strText = QString("推荐-%1").arg(i + 1, 3, 10, QChar('0'));obj.insert("text", strText);objArray.append(obj);}return objArray;

}recBox中添加元素

由于recPage页面中有两个RecBox控件,上⾯的RecBox为⼀行四列,下⽅的RecBox为2行四列,因此在RecBox类中增加以下成员变量

// RecBox.h 新增

#include <QJsonArray>public:void initRecBoxUi(QJsonArray data, int row);

private:int row; // 记录当前RecBox实际总⾏数int col; // 记录当前RecBox实际每⾏有⼏个元素QJsonArray imageList; // 保存界⾯上的图⽚, ⾥⾯实际为key、value键值对RecBox的构造函数中,将row和col默认设置为1和4,count需要具体来计算

RecBox::RecBox(QWidget *parent) :QWidget(parent),ui(new Ui::RecBox),row(1),col(4)

{ui->setupUi(this);

}void RecBox::initRecBoxUi(QJsonArray data, int row)

{// 如果是两⾏,说明当前RecBox是主界⾯上的supplyMusicBoxif(2 == row){this->row = row;this->col = 8;}else{// 否则:只有⼀⾏,为主界⾯上recMusicBoxui->recBoxBottom->hide();}// 图⽚保存起来imageList = data;// 往RecBox中添加图⽚createRecItem();

}void RecBox::createRecBoxItem()

{// 创建RecBoxItem对象,往RecBox中添加// colfor(int i = 0; i < col; ++i){RecBoxItem* item = new RecBoxItem();// 设置⾳乐图⽚与对应⽂本QJsonObject obj = imageList[i].toObject();item->setRecText(obj.value("text").toString());item->setRecImage(obj.value("path").toString());// 将RecBoxItem对象添加到RecBox中ui->recListUpHLayout->addWidget(item);}

}运行程序可以看到:

上⾯RecBox正确,recListUpHLayout中添加了4个RecBoxItem元素并显示出来,recListDownHLayout被隐藏了,而下⾯的RecBox中内容不对,对于下⽅RecBox,期望recListUpHLayout中显示添加4个RecBoxItem,recListDownHLayout中显示添加4个RecBoxItem,而上述代码往RecBox中添加RecBoxItem时没有添加任何限制

createRecBoxItem()函数修改如下:

void RecBox::createRecBoxItem()

{// 添加之前先删除RecBox中的元素QList<RecBoxItem*> recUpList = ui->recListUp->findChildren<RecBoxItem*>();for(auto e : recUpList){ui->recListUpHLayout->removeWidget(e);delete e;}QList<RecBoxItem*> recDownList = ui->recListDown->findChildren<RecBoxItem*>();for(auto e : recDownList){ui->recListDownHLayout->removeWidget(e);delete e;}int index = 0;for(int i = currentIndex * col; i < col + currentIndex * col; i++){RecBoxItem* item = new RecBoxItem();// 设置背景图片以及对应的文本信息QJsonObject obj = imageList[i].toObject();item->setRecText(obj.value("text").toString());item->setRecImage(obj.value("path").toString());// recMusicBox:col为4,元素添加到ui->recListUpHLayout中// supplyMuscBox: col为8, ui->recListUpHLayout添加4个,ui->recListDownHLayout添加4个// 即supplyMuscBox上下两⾏都要添加// 如果是recMusicBox:row为1,只能执⾏else,所有4个RecBoxItem都添加到ui->recListUpHLayout中// 如果是supplyMuscBox:row为2,col为8,col/2结果为4,i为0 1 2 3时,元素添加到ui->recListDownHLayout中// i为4 5 6 7时,元素添加到ui->recListUpHLayout中if(row == 2 && index++ >= col / 2){ui->recListDownHLayout->addWidget(item);}else{ui->recListUpHLayout->addWidget(item);}}

}

RecBox中btUp和btDown按钮clicked处理

添加槽函数

选中recbox.ui⽂件,分别选中btUp和btDown,右键单击弹出菜单选择转到槽,选中clicked确定, btUp和btDown的槽函数就添加好了

void RecBox::on_btUp_clicked()

{// 点击btUp按钮,显⽰前4张图⽚,如果已经是第⼀张图⽚,循环从后往前显示

}void RecBox::on_btDown_clicked()

{// 点击btUp按钮,显⽰前8张图⽚,如果已经是第⼀张图⽚,循环从后往前显示

}imageList中图片分组

- 假设imageList中有24组图⽚路径和推荐⽂本信息,如果将信息分组:如果是recMusicBox,将元素按照col分组,即每4个元素为⼀组,可分为6组;如果是supplyMuscBox,将元素按照col分组,即每8个元素为⼀组,可分为3组。

- RecBox类中添加currentIndex和count整形成员变量,currentIndex记录当前显⽰组,count记录总的信息组数。当点击btUp时,currentIndex--,显⽰前⼀组,如果currentIndex小于0时,将其设置为count-1;当点击btDown按钮时,currentIndex++显⽰下⼀组,当currentIndex为count时,将count设置为0

// recbox.h 中新增

int currentIndex; // 标记当先显⽰第⼏组图⽚和推荐信息

int count; // 标记imageList中元素按照col分组总数// recbox.cpp 中新增

void RecBox::initRecBoxUi(QJsonArray data, int row)

{if(row == 2){this->row = row;col = 8;}else{ui->recListDown->hide(); // 隐藏第二行}imageList = data;currentIndex = 0;count = imageList.size() / col;// 在RecBox控件中添加RecBoxItemcreateRecBoxItem();

}void RecBox::on_btUp_clicked()

{// 点击btUp按钮,显⽰前⼀组图⽚,如果已经是第⼀组图⽚,显⽰最后⼀组currentIndex--;if(currentIndex < 0){currentIndex = count - 1;}createRecBoxItem();

}void RecBox::on_btDown_clicked()

{// 点击btDown按钮,显⽰下⼀组图⽚,如果已经是最后⼀组图⽚,显⽰第0组currentIndex++;if(currentIndex >= count){currentIndex = 0;}createRecBoxItem();

}程序启动时图片随机显示

仔细观察发现,每次程序启动时,显⽰的图⽚都是相同的,这是因为random_shuffle在随机打乱元素时,需要设置随机数种⼦,否则默认使⽤的种⼦是相同的,就导致每次打乱的结果都是相同的,所以每次程序启动时RecBox中显⽰的内容都是相同的,因此在randomPiction()调⽤之前需要设置随机数种⼦

// QQMusic类的initUi函数中新增

void QQMusic::initUi()

{// ...// 本地下载BtForm动画默认显⽰ui->local->showAnimal();ui->stackedWidget->setCurrentIndex(4);// 设置RecBox图⽚、⾏数srand(time(NULL));ui->recMusicBox->initRecBoxUi(randomPiction(), 1);ui->supplyMuscBox->initRecBoxUi(randomPiction(), 2);

}自定义CommonPage

CommonPage页面分析

我的⾳乐下的:喜欢、本地和下载、最近播放三个按钮表⾯上看对应三个Page⻚⾯,分析之后发现,这三个Page⻚⾯实际是雷同的,因此只需要定义⼀个⻚⾯CommonPage,将stackedWidget中这三个⻚⾯的类型提升为CommonPage即可

上图为本地⾳乐的Page⻚⾯,对⻚⾯拆解后,发现该⻚⾯可以分四部分:

- 页面说明,比如:本地⾳乐,该部分实际就是QLabel的提示说明;

- 正在播放音乐图⽚和播放全部按钮;

- ⾳乐列表中每个部分的文本提示,实际就是三个QLabel

- 本⻚⾯对应的⾳乐列表,即QListWidget

CommonPage页面布局

- 新增加⼀个设计界⾯,objectName修改为CommonPage,geometry的宽⾼修改为800*515

- 拖拽⼀个QLabel、两个Widget和⼀个ListView控件到CommonPage中,objectName从上往下依次修改为pageTittle、musicPlayBox、listLabelBox、pageMusicList,然后选中CommonPage点击垂直布局,将CommonPage的margin和Spacing修改为0。

- pageTittle的minimumSize和maximumSize的⾼度修改为30。musicPlayBox的minimumSize和maximumSize的⾼度修改为150。listLabelBox的minimumSize和maximumSize的⾼度修改为40。

- 将pageTittle的⽂本内容修改为"本地⾳乐"

- musicPlayBox中拖拽⼀个QLabel,objectName修改为musicImageLabel,minimumSize和maximumSize的宽度修改为150

- 拖拽⼀个Widget,objectName修改为playAll,minimumSize和maximumSize的宽度修改为120,在其内部拖拽⼀个PushButton和Vertical Space(即垂直弹簧),将按钮的objectName修改为playAllBtn,minimumSize和maximumSize的宽和⾼修改为100*30,⽂本内容修改为"播放全部",然后选中playAll点击垂直布局

- 拖拽⼀个HorizontalSpacer到CommonPage中,放在playAll之后,然后选中musicPlayBox,点击⽔平布局,将margin和spacing设置为0.

- listLabelBox中拖拽三个QLabel,内容依次修改为:歌曲名称、歌⼿名称、专辑名称,objectName从左往右依次修改为:musicNameLabel、musicSingerLabel、musicAlbumLabel,然后选中musicPlayBox,点击⽔平布局,将margin和spacing设置为0

- 选中List View,右键单击弹出菜单中选择"变形为",选择QListWidget

选中QQMusic⻚⾯,将stackedWidget中我喜欢、本地下载、最近播放对应的页面提升为CommonPage,页面就处理完成了。

#playAllBtn

{background-color:rgb(227,227,227);border-radius:14px;

}#playAllBtn:hover

{background-color:rgb(219,219,219);

}CommonPage界⾯设置和显示

CommonPage⻚⾯是喜欢、本地和下载、最近播放三个界⾯的共同类型,因此该类需要提供设置: pageTittle和musicImageLabel的公共⽅法,将来在程序启动时完成三个界⾯信息的设置,因此CommonPage类需要添加⼀个public的setCommonPageUI函数

// commonpage.h 中新增

public:void setCommonPageUI(const QString &title, const QString &image);// commonpage.cpp 中新增

void CommonPage::setCommonPageUI(const QString &title, const QString &image)

{// 设置标题ui->pageTittle->setText(title);// 设置封⾯栏ui->musicImageLabel->setPixmap(QPixmap(image));ui->musicImageLabel->setScaledContents(true);

}界⾯设置的函数需要在程序启动时就完成好配置,即需要在QQMusic的initUi()函数中调⽤完成设置:

void Widget::initUi()

{....// 设置我喜欢、本地⾳乐、最近播放⻚⾯ui->likePage->setCommonPageUI("我喜欢", ":/images/ilikebg.png");ui->localPage->setCommonPageUI("本地⾳乐", ":/images/localbg.png");ui->recentPage->setCommonPageUI("最近播放", ":/images/recentbg.png");

}自定义ListItemBox

ListItemBox⻚⾯分析

CommonPage⻚⾯创建好之后,等⾳乐加载到程序之后,就可以将⾳乐信息往CommonPage的pageMusicList中显⽰了

上图每⾏都是QListWidget中的⼀个元素,每个元素中包含多个控件:

- 收藏图标,即QLabel

- 歌曲名称,即QLabel

- VIP和SQ,VIP即收费会员专享,SQ为⽆损⾳乐,也是两个QLabel

- 歌⼿名称,即QLabel

- ⾳乐专辑名称,即QLabel

此处,需要将上述所有QLabel组合在⼀起,作为⼀个独⽴的控件,添加到QListWidget中,因此该控件也需要⾃定义。

ListItemBox⻚⾯布局

- 添加⼀个设计师界⾯,objectName为ListItemBox,geometry的宽度和⾼度修改为800*46

- 拖三个Widget到ListItemBox中,objectName从左往右依次修改为musicNameBox、musicSingerBox、musicAlbumBox,将musicNameBox的minimumSize和maximumSize的宽修改为380,将musicSingerBox的minimumSize和maximumSize的宽修改为200,然后选中ListItemBox,点击⽔平布局,将ListItemBox的margin和spacing修改为0

- musicNameBox:

- 拖拽⼀个QPushButton到musicNameBox中,objectName修改为likeBtn,minimumSize和maximumSize的宽⾼修改为25*25

- 拖⼀个QLabel到musicNameBox中,objectName修改为musicNameLabel,minimumSize和的宽修改为130

- 拖⼀个QLabel到musicNameBox中,objectName修改为VIPLabel,minimumSize和maximumSize的宽修改为30,maximumSize⾼度修改为15,⽂本内容修改为VIP。

- 拖⼀个QLabel到musicNameBox中,objectName修改为SQLabel,minimumSize和maximumSize的宽修改为25,maximumSize⾼度修改为15,⽂本内容修改为SQ

- 拖拽⼀个⽔平弹簧控件到musicNameBox中,将上述控件撑到musicNameBox的左侧

- 选中musicNameBox,点击⽔平布局,将musicNameBox的margin和spacing修改为0

- 拖拽⼀个QLabel到musicSingerBox中,objectName修改为musicSingerLabel,然后选中musicNameBox点击⽔平布局,将musicSingerBox的margin和spacing修改为0

- 拖拽⼀个QLabel到albumBox中,objectName修改为albumNameLabel,然后选中albumBox点击⽔平布局,将musicSingerBox的margin和spacing修改为0

| likeBtn | |

| VIPLabel | |

| SQLabel | |

ListItemBox显示测试

ListItemBox将来要添加到CommonPage⻚⾯中的QListWidget中,因此在CommonPage类的初始化⽅法中添加如下代码:

#include "listitembox.h"void CommonPage::setCommonPageUI(const QString &title, const QString &image)

{// 设置标题ui->pageTittle->setText(title);// 设置封⾯栏ui->musicImageLabel->setPixmap(QPixmap(image));ui->musicImageLabel->setScaledContents(true);// 测试ListItemBox* listItemBox = new ListItemBox(this);QListWidgetItem* listWidgetItem = new QListWidgetItem(ui->pageMusicList);listWidgetItem->setSizeHint(QSize(ui->pageMusicList->width(), 45));ui->pageMusicList->setItemWidget(listWidgetItem, listItemBox);}⽀持hover效果

ListItemBox添加到CommonPage中的QListWidget之后,⾃带hover效果,但是背景颜⾊和界⾯不太搭配,此处重新实现hover效果,此处重写enterEvent和leaveEvent来实现hover效果

// listitembox.h 新增

protected:void enterEvent(QEvent *event);void leaveEvent(QEvent *event);// listitembox.cpp 新增

void ListItemBox::enterEvent(QEvent *event)

{(void)event;setStyleSheet("background-color:#EFEFEF");

}void ListItemBox::leaveEvent(QEvent *event)

{(void)event;setStyleSheet("");

}自定义MusicSlider

由于QT内置的HorizontalSlider(⽔平滑竿)不是很好看,该控件也采⽤⾃定义。该控件⽐较简单,实际就是两个QFrame嵌套起来的

- 添加⼀个设计师界⾯,objectName修改为MusicSlider,geometry修改为800*20。

- 拖拽⼀个QFrame,objectName修改为inLine,geometry修改为[(0,8),800*4]。

- 拖拽⼀个QFrame,objectName修改为outLine,geometry修改为[(0,8),400*4]。

- 选中MusicSlider,点击⽔平布局。

inLine和outLine的样式设置如下:

| #inLine | |

| #outLine | |

打开QQMusic.ui,选中progressBar清除之前样式,将progressBar提升为MusicSlider,运⾏程序就能看到效果

自定义VolumeTool

VolumeTool控件分析

⾳量调节控件本来也可以使⽤Qt内置的垂直滑杆来代替,只是垂直滑杆不好看,因此也⾃定义

- 内部为类似MusicSlider控件+⼩圆球,圆球实际为⼀个QPushButton

- ⾳量⼤⼩⽂本显⽰,实际为QLabel

- QPushButton,点击之后在静⾳和取消静⾳切换

- ⼀个倒三⻆,Qt未提供三⻆控件,该控件需要⼿动绘制,⽤来提⽰是播放控制区那个按钮按下的

VolumeTool界面布局

- ⽣成⼀个QT设计师界⾯,objectName命名为VolumeTool,geometry的宽⾼修改为80*350

- 拖拽⼀个Widget到VolumeTool中,objectName修改为volumeWidget,geometry修改为:[(10,10),60*300]

- 拖拽⼀个QPushButton到volumeWidget,objectName修改为silenceBtn,mimimumSize和maximumSize的宽⾼修改为60*45

- 拖拽⼀个QLabel到volumeWidget,objectName修改为volumeRatio,mimimumSize和maximumSize的⾼修改为30,QLabel的alignment属性修改为⽔平和垂直居中

- 拖拽⼀个QWidget到volumeWidget,objectName修改为sliderBox。geometry修改为:[(0,0), 60*225]

sliderBox内部:

- 拖拽⼀个QFrame,objectName修改为inSlider,geometry修改为[(28,25),4*180]。

- 拖拽⼀个QFrame,objectName修改为outSlider,geometry修改为[(28,25),4*180]。

- 拖拽⼀个QPushButton,objectName修改为sliderBtn,geometry修改为[(23,18),14*14], mimimumSize和maximumSize的宽⾼14*14

| #volumeWidget | |

| #slienceBtn | |

| #inSlider | |

| #outSlider | |

| sliderBtn | |

静⾳底下的空缺⽤来绘制三⻆

界面设置

该控件属于弹出窗⼝,即点击了主界⾯的⾳量调节按钮后,才需要弹出该界⾯,点击其他位置该界⾯⾃动隐藏。因此在窗⼝创建时,需要设置窗⼝为⽆边框以及为弹出窗口

// VolumeTool.cpp 的构造函数中添加如下代码

#include <QGraphicsDropShadowEffect>VolumeTool::VolumeTool(QWidget *parent) :QWidget(parent),ui(new Ui::VolumeTool)

{ui->setupUi(this);// 弹出音量条件界面setWindowFlags(Qt::Popup | Qt::FramelessWindowHint | Qt::NoDropShadowWindowHint);// 将Widget多余边界隐藏setAttribute(Qt::WA_TranslucentBackground);// 窗口自定义阴影效果QGraphicsDropShadowEffect * shadowsEffect = new QGraphicsDropShadowEffect(this);shadowsEffect->setColor("#646464");shadowsEffect->setBlurRadius(14);shadowsEffect->setOffset(0, 0);this->setGraphicsEffect(shadowsEffect);// 设置音量静音按钮图标ui->silenceBtn->setIcon(QIcon(":/images/volume.png"));// 设置默认音量百分比ui->volumeRatio->setText("20%");// 中心坐标ui->outLine->setGeometry(rect.x(), 180 - 36 + 25, rect.width(), 36);// 定位按钮位置ui->silderBtn->move(ui->silderBtn->x(), ui->outLine->y() - ui->silderBtn->y() / 2);

}界⾯创建及弹出

⾳量调节属于主界⾯上元素,因此在QQMusic类中需要添加VolumeTool的对象,在initUi中new该类的对象

主界⾯中⾳量调节按钮添加clicked槽函数

// qqmusic.h中新增

#include "volumetool.h"VolumeTool* volumeTool;// qqmusic.cpp中新增

void QQMusic::initUi()

{// ...// 创建⾳量调节窗⼝对象并挂到对象树volumeTool = new VolumeTool(this);

}void QQMusic::on_volume_clicked()

{// 先要调整窗⼝的显⽰位置,否则该窗⼝在主窗⼝的左上⻆// 1. 获取该按钮左上⻆的图标QPoint point = ui->volume->mapToGlobal(QPoint(0,0));// 2. 计算volume窗⼝的左上⻆位置// 让该窗⼝显⽰在⿏标点击的正上⽅// ⿏标位置:减去窗⼝宽度的⼀半,以及⾼度恰巧就是窗⼝的左上⻆QPoint volumeLeftTop = point - QPoint(volumeTool->width()/2, volumeTool->height());// 微调窗⼝位置volumeLeftTop.setY(volumeLeftTop.y()+30);volumeLeftTop.setX(volumeLeftTop.x()+15);// 3. 移动窗⼝位置volumeTool->move(volumeLeftTop);// 4. 将窗⼝显⽰出来volumeTool->show();

}绘制三⻆

由于Qt中并未给出三⻆控件,因此三⻆需要⼿动绘制,故在VolumeTool类中重写paintEvent事件函数

// volumetool.h中新增

void paintEvent(QPaintEvent *event);// volumetool.cpp中新增

#include <QPainter>void VolumeTool::paintEvent(QPaintEvent *event)

{(void)event;// 绘制volumerTool界面下的倒三角QPainter painter(this);// 设置画笔painter.setPen(Qt::NoPen);// 设置画刷painter.setBrush(::QBrush(Qt::white));// 绘制三角形 定位坐标系QPolygon polygon;QPoint a(10, 300 + 5);QPoint b(10 + 60, 300 + 5);QPoint c(10 + 30, 300 + 20);polygon.append(a);polygon.append(b);polygon.append(c);painter.drawPolygon(polygon);}音乐管理

界面处理好之后,现在就需要将⾳乐⽂件加载到程序然后显示在界⾯上,待后续播放操作

音乐加载

QQMusic类中给addLocal添加槽函数

⾳乐⽂件在磁盘中,可以借助QFileDialog类完成⾳乐⽂件加载。QFileDialog类中函数介绍:

构造函数:

QFileDialog(QWidget *parent = nullptr, // 指定该对象的⽗对象const QString &caption = QString(), // 设置窗⼝标题const QString &directory = QString(), // 设置默认打开⽬录const QString &filter = QString()) // 设置过滤器,可以只打开指定后缀⽂件,默认创建的是打开对话框

⽂件过滤器:

/*筛选所需要格式的⽂件,格式:每组⽂件之间⽤两个分号隔开,同⼀组内不同后缀之间⽤空格隔开

⽐如:打开指定⽂件夹下所有.cpp .h 以及.png的⽂件

QString filter = "代码⽂件(.cpp *.h)";

过滤器可以在构造QFileDialog对象时传⼊,也可以通过setNameFilters函数设置*/void setNameFilters(const QStringList &filters);/*有些时候⽂件的后缀不⼀定能给全,⽐如图⽚格式:.pnp .bmp .jpg等,有些格式甚⾄没有接触过,

但也属于图⽚⽂件,该种情况下最好使⽤MIME类型过滤

MIME类型(Multipurpose Internet Mail Extensions)是⼀种互联⽹标准,⽤于表⽰⽂档、⽂件或

字节流的性质和格式*/

void setMimeTypeFilters(const QStringList &filters)

///

// 设置打开对话框的类型

QFileDialog::AcceptOpen:表⽰对话框为打开对话框

QFileDialog::AcceptSave:表⽰对话框为保存对话框

void setAcceptMode(QFileDialog::AcceptMode mode);

///

// 设置选择⽂件的数量和类型

void setFileMode(QFileDialog::FileMode mode);

QFileDialog::AnyFile ⽤⼾可以选择任何⽂件,甚⾄指定⼀个不存在的⽂件

QFileDialog::ExistingFile ⽤⼾只能选择单个存在的⽂件名称

QFileDialog::Directory ⽤⼾可以选择⼀个⽬录名称

QFileDialog::ExistingFiles ⽤⼾可以选择⼀个或者多个存在的⽂件名称// 设置⽂件对话框的当前⽬录

void setDirectory(const QString &directory);

// 获取当前⽬录

QDir::currentPath();

打开函数实现如下:

// qqmusic.cpp 中新增

#include <QDir>

#include <QFileDialog>void QQMusic::on_addLocal_clicked()

{// 1. 创建⼀个⽂件对话框QFileDialog fileDialog(this);fileDialog.setWindowTitle("添加本地⾳乐");// 2. 创建⼀个打开格式的⽂件对话框fileDialog.setAcceptMode(QFileDialog::AcceptOpen);// 3. 设置对话框模式// 只能选择⽂件,并且⼀次性可以选择多个存在的⽂件fileDialog.setFileMode(QFileDialog::ExistingFiles);// 4. 设置对话框的MIME过滤器QStringList mimeList;mimeList<<"application/octet-stream";fileDialog.setMimeTypeFilters(mimeList);// 5. 设置对话框默认的打开路径,设置⽬录为当前⼯程所在⽬录QDir dir(QDir::currentPath());dir.cdUp();QString musicPath = dir.path()+"/QQMusic/musics/";fileDialog.setDirectory(musicPath);// 6. 显⽰对话框,并接收返回值// 模态对话框, exec内部是死循环处理if(fileDialog.exec() == QFileDialog::Accepted){// 切换到本地⾳乐界⾯,因为加载完的⾳乐需要在本地⾳乐界⾯显⽰ui->stackedWidget->setCurrentIndex(4);// 获取对话框的返回值QList<QUrl> urls = fileDialog.selectedUrls();// 拿到歌曲⽂件后,将歌曲⽂件交由musicList进⾏管理}

}MusicList类

添加C++类MusicList

将来添加到播放器中的⾳乐⽐较多,可借助⼀个类对所有的⾳乐进⾏管理。添加新C++类与添加设计师界⾯类似:

歌曲对象存储

每⾸⾳乐⽂件,将来需要获取其内部的歌曲名称、歌⼿、⾳乐专辑、歌曲时⻓等信息,因此在MusicList类中,将所有的歌曲⽂件以Music对象方式管理起来。

QQMusic中,通过QFileDialog将⼀组⾳乐⽂件的url获取到之后,可以交给MusicList类来管理

但是QQMusic加载的⼆进制⽂件不⼀定全部都是⾳乐⽂件,因此MusicList类中需要对⽂件的MIME类型再次检测,以筛选出真正的⾳乐⽂件。

QMimeDatabase类是Qt中主要⽤于处理⽂件的MIME类型,经常⽤于:

- ⽂件类型识别

- ⽂件过滤

- 多媒体⽂件处理

- ⽂件导⼊导出

- ⽂件管理器

该类中的mimeTypeForFile函数可⽤于获取给定⽂件的MIME类型

// QMimeDatabase类的mimeTypeForFile⽅法

// 功能:获取fileName⽂件的MIME类型

// fileName:⽂件的名称

// mode: MatchMode为枚举类型,表明如何匹配⽂件的MIME类型

// MatchDefault: 通过⽂件名和⽂件内容来进⾏查询匹配,⽂件名优先于⽂件内容,如果⽂件扩展名

// 未知,或者匹配多个MIME类型,则使⽤⽂件内容匹配

// MatchExtension: 通过⽂件

// MatchContent:通过⽂件内容来查询匹配

QMimeType mimeTypeForFile(const QString &fileName,MatchMode mode = MatchDefault) const// QMimeType类中的name属性,保存了获取到的MIME类型,

// 可以通过该类的name()⽅法以字符串⽅式返回MIME类型

QString name();// audio/mpeg : 适⽤于mp3格式的⾳频⽂件

// audio/flac : 表⽰⽆损⾳频压缩格式

// audio/wav : 表⽰wav格式的歌曲⽂件

// 上述三种⾳乐格式⽂件,Qt的QMediaPlayer类都是⽀持的对于歌曲文件:

- audio/mpeg:适⽤于mp3格式的⾳乐⽂件

- audio/flac:⽆损压缩的⾳频⽂件,不会破坏任何原有的⾳频信息

- audio/wav:表⽰wav格式的歌曲⽂件

上述歌曲⽂件格式,Qt的QMediaPlayer类都是⽀持的

// musiclist.h 中新增

#include <QVector>QVector<Music> musicList; // Music类是⾃定义的C++类,描述歌曲相关信息// 将QQMusic⻚⾯中读取到的⾳乐⽂件,检测是⾳乐⽂件后添加到musicList中

void addMusicByUrl(const QList<QUrl>& urls);// musiclist.cpp中新增

void MusicList::addMusicByUrl(const QList<QUrl> &urls)

{for(auto musicUrl : urls){// 由于添加进来的⽂件不⼀定是歌曲⽂件,因此需要再次筛选出⾳乐⽂件QMimeDatabase db;QMimeType mime = db.mimeTypeForFile(musicUrl.toLocalFile());if(mime.name() != "audio/mpeg" && mime.name() != "audio/flac"){continue;}// 如果是⾳乐⽂件,加⼊歌曲列表musicList.push_back(musicUrl);}

}Music类

Music类介绍

该⽤来描述⼀个⾳乐⽂件,⽐如:⾳乐名称、歌⼿名称、专辑名称、⾳乐持续时⻓,当在界⾯上点击收藏之后,⾳乐会被标记为喜欢,播放之后需要标记为历史记录。因此该类中⾄少需要以下成员:

// music.h中新增

#include <QUrl>

#include <QString>class Music

{

public:Music();Music(const QUrl& url);void setIsLike(bool isLike);void setIsHistory(bool isHistory);void setMusicName(const QString& musicName);void setSingerName(const QString& singerName);void setAlbumName(const QString& albumName);void setDuration(const qint64 duration);void setMusicUrl(const QUrl& url);void setMusicId(const QString& musicId);bool getIsLike();bool getIsHistory();QString getMusicName();QString getSingerName();QString getAlbumName();qint64 getDuration();QUrl getMusicUrl();QString getMusicId();private:bool isLike; // 标记⾳乐是否为我喜欢bool isHistory; // 标记⾳乐是否播放过// ⾳乐的基本信息有:歌曲名称、歌⼿名称、专辑名称、总时⻓QString musicName;QString singerName;QString albumName;qint64 duration; // ⾳乐的持续时⻓,即播放总的时⻓// 为了标记歌曲的唯⼀性,给歌曲设置id// 磁盘上的歌曲⽂件经常删除或者修改位置,导致播放时找不到⽂件,或者重复添加// 此处⽤musicId来维护播放列表中⾳乐的唯⼀性QString musicId;QUrl musicUrl; // ⾳乐在磁盘中的位置

};Music::Music(): isLike(false), isHistory(false)

{}void Music::setIsLike(bool isLike)

{this->isLike = isLike;

}void Music::setIsHistory(bool isHistory)

{this->isHistory = isHistory;

}void Music::setMusicName(const QString &musicName)

{this->musicName = musicName;

}void Music::setSingerName(const QString &singerName)

{this->singerName = singerName;

}void Music::setAlbumName(const QString &albumName)

{this->albumName = albumName;

}void Music::setDuration(const qint64 duration)

{this->duration = duration;

}void Music::setMusicUrl(const QUrl &url)

{this->musicUrl = url;

}void Music::setMusicId(const QString &musicId)

{this->musicId = musicId;

}bool Music::getIsLike()

{return isLike;

}bool Music::getIsHistory()

{return isHistory;

}QString Music::getMusicName()

{return musicName;

}QString Music::getSingerName()

{return singerName;

}QString Music::getAlbumName()

{return albumName;

}qint64 Music::getDuration()

{return duration;

}QUrl Music::getMusicUrl()

{return musicUrl;

}QString Music::getMusicId()

{return musicId;

}另外,该类还需要添加⼀个带有歌曲⽂件路径的构造函数,当给定有效⾳乐⽂件后,Music类需要负责将该⾳乐⽂件的元数据解析出来。

为了保证Music对象的唯⼀性,给每个Music对象设置⼀个UUID。

UUID,即通⽤唯⼀识别码(Universally Unique Identifier),确保在分布式系统中每个元素都有唯⼀的标识

UUID由⼀组32位数的16进制数字组成,形式为8-4-4-4-12的32个字符,⽐如:"550e8400-e29b- 41d4-a716-446655440000"

在Music对象查找和更新时,可以已通过对⽐UUID,来保证Music对象的唯⼀性

Qt中QUuid类可⽣成UUID。

Music::Music(const QUrl &url): isLike(false), isHistory(false), musicUrl(url)

{musicId = QUuid::createUuid().toString();

}解析⾳乐⽂件元数据

对于每⾸歌曲,将来在界⾯上需要显⽰出:歌曲名称、歌⼿、专辑名称,在播放时还需要拿到歌曲总时⻓,因此在构造⾳乐对象时,就需要将上述信息解析出来

歌曲元数据解析,需要⽤到 QMediaPlayer ,该类也是⽤来进⾏歌曲播放的类,后续在播放⾳乐位置详细介绍

QMediaPlayer类中的setMedia()函数

// 功能:设置要播放的媒体源,媒体数据从中读取

// media: 要播放的媒体内容,⽐如⼀个视频或⾳频⽂件,该类提供了⼀个QUrl格式的单参构造

void setMedia(const QMediaContent &media, QIODevice *stream = nullptr)该函数执⾏后⽴即返回,不会等待媒体加载完成,也不检查错误,如果在媒体加载时发⽣错误,会触发mediaStatusChanged和error信号

由于加载媒体⽂件需要时间,可以通过QMediaObject类中的isMetaDataAvailable()⽅法检测媒体数据是否可用

// 检测媒体源是否有效,如果是有效的返回true,否则返回false

bool isMetaDataAvailable() const;媒体元数据加载成功之后,可以通过QMediaObject类的metaData函数获取指定的媒体数据:

// 返回要获取的媒体数据key的值

QVariant QMediaObject::metaData(const QString &key) const本⽂需要获取媒体的:标题、作者、专辑、持续时⻓

| valye | description | type |

| Title | 媒体的标题 | QString |

| Auther | 媒体的作者 | QStringLIst |

| AlbumTitle | 媒体所属专辑名称 | QString |

| Duration | 媒体的播放时长 | qint64 |

有些媒体中媒体数据可能不全,即有些媒体数据获取不到,比如盗版歌曲

使⽤QMediaPlayer媒体播放类时,需要在QQMusic.pro项目工程文件中添加媒体模块multimedia ,该模块主要⽤来播放各种⾳频视频⽂件等,该模块中提供了很多类

| 媒体模块中的主要类 | 功能 |

| QMediaplayer,QMediaPlayList | 播放压缩音频(MP3、AAC等) |

| QSoundEffer,QSound | 播放音效文件(WAV文件) |

| QAudioOutput | 播放低延迟的音频 |

| QAudioInput | 访问原始音频输入数据 |

| QAudioRecorder | 录制编码的音频数据 |

| QAudioDeviceInfo | 发现音频设备 |

| QMediaPlayer,QvideoWidget,QGraphics VideoItem | 视频播放 |

| QMediaPlayer,QvideoFrame,QAbstract VideoSurface | 视频处理 |

| QCamera,QVideoWidget,QGraphicsVideoItem | 摄像头取景框 |

| QCamera,QAbstractVideoSurface,QVideoFrame | 取景框预览处理 |

| QCamera,QCameralmage Capture | 摄像头拍照 |

| QCamera,QMediaRecorder | 摄像头录像 |

| ORadioTuner,ORadioData | 收听数字广播 |

QT += core gui multimedia添加完成之后,重新将项目构建⼀下,否则Qt create可能识别不过来

⾳乐⽂件的meta数据解析如下:

// music.h 中新增

private:

void parseMediaMetaData();// music.cpp 中新增

#include <QMediaPlayer>

#include <QCoreApplication>

#include <QUuid>void Music::parseMediaMetaData()

{// 解析时候需要读取歌曲数据,读取歌曲⽂件需要⽤到QMediaPlayer类QMediaPlayer player;player.setMedia(musicUrl);// 媒体元数据解析需要时间,只有等待解析完成之后,才能提取⾳乐信息,此处循环等待// 循环等待时:主界⾯消息循环就⽆法处理了,因此需要在等待解析期间,让消息循环继续处理while(!player.isMetaDataAvailable()){QCoreApplication::processEvents();}// 解析媒体元数据结束,提取元数据信息if(player.isMetaDataAvailable()){musicName = player.metaData("Title").toString();singerName = player.metaData("Author").toString();albumName = player.metaData("AlbumTitle").toString();duratioplayer. Durationtion();if(musicName.isEmpty()){musicName = "歌曲未知";}if(singerName.isEmpty()){singerName = "歌⼿未知";}if(albumName.isEmpty()){albumName = "专辑名未知";}qDebug()<<musicName<<" "<<singerName<<" "<<albumName<<" "<<duration;}

}// 该函数需要在Music的构造函数中调⽤,当创建⾳乐对象时,顺便完成歌曲⽂件的加载

Music::Music(const QUrl &url): isLike(false), isHistory(false), musicUrl(url)

{musicId = QUuid::createUuid().toString();parseMediaMetaData();

}Music数据保存

通过QFileDialog将音乐从本地磁盘加载到程序中后,拿到的是所有⾳乐⽂件的QUrl,而在程序中需要的是经过元数据解析之后的Music对象,并且Music对象需要管理起来,此时就可以采用MusicList类对解析之后的Music对象进⾏管理,QQMusic类中只需要保存MusicList的对象,就可以让qqMusic.ui界⾯中CommonPage对象完成Music信息往界⾯更新。

// qqmusic.h 新增

#include "musiclist.h"

MusicList musicList;// qqmusic.cpp

void QQMusic::on_addLocal_clicked()

{// ....// 6. 显⽰对话框,并接收返回值// 模态对话框, exec内部是死循环处理if(fileDialog.exec() == QFileDialog::Accepted){// 切换到本地⾳乐界⾯,因为加载完的⾳乐需要在本地⾳乐界⾯显⽰ui->stackedWidget->setCurrentIndex(4);// 获取对话框的返回值QList<QUrl> urls = fileDialog.selectedUrls();// 拿到歌曲⽂件后,将歌曲⽂件交由musicList进⾏管理musicList.addMusicByUrl(urls);// 更新到本地⾳乐列表ui->localPage->refresh(musicList);}

}由于添加的是本地音乐,因此⾳乐信息需要由ui->localPage更新到其内部的QListWidget中

音乐分类

QQMusic中,有三个显示歌曲信息的页面:

- likePage:管理和显示点击爱心后收藏的歌曲

- localPage:管理和显示本地加载的歌曲

- recentPage:管理和显示历史播放过的歌曲

这三个⻚⾯的类型都是CommonPage,每个页面应该维护自己页面中的歌曲。因此CommonPage类中需要新增:

// commonpage.h中新增

// 区分不同page⻚⾯enum PageType

{

LIKE_PAGE, // 我喜欢⻚⾯

LOCAL_PAGE, // 本地下载⻚⾯

HISTORY_PAGE // 最近播放⻚⾯

};class CommonForm : public QWidget

{

// 新增成员函数

public:void setMusicListType(PageType pageType);

// 新增成员变量

private:// 歌单列表QVector<QString> musicListOfPage; // 具体某个⻚⾯的⾳乐,将来只需要存储⾳乐的id即可PageType pageType; // 标记属于likePage、localPage、recentPage哪个⻚⾯

};// commonpage.cpp中新增:

void CommonPage::setMusicListType(PageType pageType)

{this->pageType = pageType;

}// qqmusic.cpp中新增:

void initUi()

{// ...// 设置CommonPage的信息ui->likePage->setMusicListType(PageType::LIKE_PAGE);ui->likePage->setCommonPageUI("我喜欢", ":/images/ilikebg.png");ui->localPage->setMusicListType(PageType::LOCAL_PAGE);ui->localPage->setCommonPageUI("本地⾳乐", ":/images/localbg.png");ui->recentPage->setMusicListType(PageType::HISTORY_PAGE);ui->recentPage->setCommonPageUI("最近播放", ":/images/recentbg.png");

}QQMusic中,点击addLocal(本地加载)按钮后,会通过其musicList成员变量,将music添加到musicList中管理,在添加过程中,每个歌曲会对应⼀个Music对象,Music对象在构造时,会完成歌曲文件的加载,顺便完成歌曲名称、作者、专辑名称等元数据的解析。⼀切准备就绪之后,每个CommonPage页面,通过QQMusic的musicList分离出自己页面的歌曲,保存在musicListOfPage中。

// commonpage.h中新增:

#include "musiclist.h"private:

void addMusicToMusicPage(MusicList &musicList);// commonpage.cpp 中新增:

void CommonPage::addMusicToMusicPage(MusicList &musicList)

{// 将旧内容清空musicListOfPage.clear();for(auto& music : musicList){switch(musicListType){case LOCAL_LIST:musicListOfPage.push_back(music.getMusicId());break;case LIKE_LIST:{if(music.getIsLike()){musicListOfPage.push_back(music.getMusicId());}break;}case HOSTORY_LIST:{if(music.getIsHistory()){musicListOfPage.push_back(music.getMusicId());break;}}default:break;}}

}由于musicList所属类,并不能直接⽀持范围for,因此需要在MusicList类中新增:

// musiclist.h中新增:

typedef typename QVector<Music>::iterator iterator;iterator begin();

iterator end();// musiclist.cpp中新增:

iterator MusicList::begin()

{return musicList.begin();

}iterator MusicList::end()

{return musicList.end();

}更新Music信息到ComonPage界面

歌曲分类完成之后,歌曲信息就可以更新到CommonPage页面了

更新步骤:

- 调⽤addMusicIdPageFromMusicList函数,从musicList中添加当前页面的歌曲

- 遍历musicListOfPage,拿到每⾸⾳乐后先检查其是否在,存在则添加

- 界⾯上需要更新每首歌曲的:歌曲名称、作者、专辑名称,而commonPage中只保存了歌曲的musicId,因此需要在MusicList中增加通过musicID查找Music对象的⽅法

// commonpage.h中新增

void reFresh(MusicList& musicList);// commonpage.cpp 中新增:

void CommonPage::reFresh(MusicList &musicList)

{// 添加前需要清空列表内已存在的元素ui->PageMusicList->clear();// 添加歌曲addMusicToMusicPage(musicList);for(auto musicId : musicOfPage){auto it = musicList.findMusicByMusicId(musicId);// 没有找到if(it == musicList.end())continue;// 将ListBoxItem对象放到pageMusicList中ListItemBox* listItemBox = new ListItemBox(this);// 歌曲名称,作者,专辑更新到界面listItemBox->setMusicName(it->getMusicName());listItemBox->setMusicSinger(it->getMusicSinger());listItemBox->setMusicAlbum(it->getMusicAlbumn());listItemBox->setLikeMusic(it->getIsLike());QListWidgetItem* item = new QListWidgetItem(ui->PageMusicList);item->setSizeHint(QSize(listItemBox->width(), listItemBox->height()));ui->PageMusicList->setItemWidget(item, listItemBox);// 拦截收藏时触发的信号connect(listItemBox, &ListItemBox::setIsLike, this, [=](bool isLike){// 更新歌曲库状态,通知qqmusic,让其中likePage,localPage,recentPage更新歌曲库中信息// 给qqmusic发送信号emit updataLikeMusic(isLike, it->getMusicId());});}// 窗口重绘paintEventrepaint(); // 立马响应

}// musiclist.h中新增

iterator findMusicById(const QString& musicId);// musiclist.cpp中新增

iterator MusicList::findMusicByMusicId(const QString &musicId)

{for(auto it = begin(); it != end(); ++it){if(it->getMusicId() == musicId){return it;}}return end();

}将歌曲名称、作者、专辑名称、喜欢图片等往ListBoxItem界⾯中更新时,需要ListBoxItem提供对应的set方法,因此需要在ListItemBox类中新增:

// listitembox.h中新增:

public:void setMusicName(const QString& name);void setSinger(const QString& singer);void setAlbumName(const QString& albumName);void setLikeIcon(bool like);

private:bool isLike;// listitembox.cpp中新增:

ListItemBox::ListItemBox(QWidget *parent) :QWidget(parent),ui(new Ui::ListItemBox),isLike(false)

{ui->setupUi(this);

}void ListItemBox::setMusicName(const QString &musicName)

{ui->musicNameLabel->setText(musicName);

}void ListItemBox::setMusicSinger(const QString &musicSinger)

{ui->musicSingerLabel->setText(musicSinger);

}void ListItemBox::setAlbumName(const QString& albumName)

{ui->musicAlbumLabel->setText(albumName);

}void ListItemBox::setLikeMusic(bool isLike)

{this->isLike = isLike;if(isLike){ui->likeBtn->setIcon(QIcon(":/images/like_2.png"));}else{ui->likeBtn->setIcon(QIcon(":images/like_3.png"));}

}更新音乐信息到界面的函数处理完成之后,需要在QQMusic的addLocal槽函数最后调用

// qqmusic.cpp中新增:

void QQMusic::onAddLocalClick()

{// ...// 6. 显⽰对话框,并接收返回值// 模态对话框, exec内部是死循环处理if(fileDialog.exec() == QFileDialog::Accepted){// 切换到本地⾳乐界⾯,因为加载完的⾳乐需要在本地⾳乐界⾯显⽰ui->stackedWidget->setCurrentIndex(4);// 获取对话框的返回值QList<QUrl> urls = fileDialog.selectedUrls();// 注意:后序需要将⾳乐信息添加到数据库,否则每次打开是都需要添加⾳乐太⿇烦了musicList.addMusicByUrl(urls);// 更新到本地⾳乐列表ui->localPage->refresh(musicList);}

}CommonPage显示不足处理

歌曲作者对齐处理

解析歌曲元数据时,有些歌曲文件中可能不存在歌曲名称、作者、歌曲专辑等,为了界面上显示出歌曲名称,从歌曲⽂件名中解析出歌曲名称和作者,这样解析出来的歌曲名称后面多⼀个空格,作者之前多⼀个空格,导致界面显示的时候歌手名称对不齐。因此在往界⾯设置之前,可以将名称前后的空格去除掉

QString类提供了⼀个 trimmed() 方法,专⻔⽤来去除字符串前后空白字符的

// music.cpp ⽂件修改

void Music::parseMediaMetaMusic()

{if(musicName.isEmpty()){if(index != -1){musicName = fileName.mid(0, index).trimmed();}else{musicName = fileName.mid(0, fileName.indexOf('.')).trimmed();}}// Singer为空if(musicSinger.isEmpty()){if(index != -1){musicSinger = fileName.mid(index + 1, fileName.indexOf('.') - index - 1).trimmed();}else{musicSinger = "未知歌手";}}if(musicAlbumn.isEmpty()){musicAlbumn = "未知专辑";}// ...

}显示延迟问题

在CommonPage的 reFresh() 函数中,将ListItemBox设置好之后,更新到界面,有时候不会立马显示出来,等鼠标放置ListWidget上或者界面刷新的时候,才会显示出来。这是因为往界面更新元素的操作,没有引起窗体的重绘,导致不能实时显示出来,因此添加完元素之后,需要触发重绘事件,将元素及时绘制出来

// 该⽅法负责将歌曲信息更新到界⾯

void CommonPage::reFresh(MusicList &musicList)

{// ...// 该函数最后添加上repaint()函数调⽤// repaint()会⽴即执⾏paintEvent(),不会等待事件队列的处理// update()将⼀个paintEvent事件添加到事件队列中,等待稍后执⾏,即不会⽴即执⾏paintEvent。repaint();

}移除掉QListWidget的⽔平滚动条

⼀般歌曲名称、作者、专辑名称不会将ListItemBox沾满,为了界⾯好看,可以让CommonPage中的QListWidget控件去除掉⽔平滚动条

CommonPage::CommonPage(QWidget *parent) :QWidget(parent),ui(new Ui::CommonPage)

{ui->setupUi(this);// 不要⽔平滚动条ui->pageMusicList->setHorizontalScrollBarPolicy(Qt::ScrollBarAlwaysOff);

}QListWidget选中后背景色设置

QListWidget中ListItemBox选中之后,背景颜⾊和界⾯不是很搭,⽤如下QSS代码设置ListItemBox选中后的背景颜色

#pageMusicList::item:selected /*::item表⽰⼦控件,即ListItemBox :selected:

表⽰选中*/

{background-color:#EFEFEF;

}QListWidget的垂直滚动条美化

#PageMusicList::item:selected

{background-color:rgb(230,230,230);

}QScrollBar:vertical

{border:none;width:10px;height:10px;background-color:rgb(250,250,250);margin: 0px 0px 0px 0px;

}QScrollBar::handle:vertical

{width:10px;background-color:rgb(225,225,225);border-radius:5px;min-heigth:20px;

}音乐收藏

喜欢图标处理

当CommonPage往界⾯更新Music信息时,也要根据Music的isLike属性更新对应的图标。因此ListItemBox需要根据

当点击喜欢按钮之后,要切换ListItemBox中的爱心图标。因此ListItemBox中添加设置bool类型isLike成员变量,以及setIsLike函数,在CommonPage添加Music信息到界⾯时,要能够设置爱心图标

// listItemBox.h 中新增

bool isLike;

void setLikeMusic(bool isLike);// listItemBox.cp 中新增

ListItemBox::ListItemBox(QWidget *parent) :QWidget(parent),ui(new Ui::ListItemBox),isLike(false)

{ui->setupUi(this);

}void ListItemBox::setLikeMusic(bool isLike)

{this->isLike = isLike;if(isLike){ui->likeBtn->setIcon(QIcon(":/images/like_2.png"));}else{ui->likeBtn->setIcon(QIcon(":images/like_3.png"));}

}点击喜欢按钮处理

当喜欢某首歌曲时,可以点击界⾯上爱心收藏该该歌曲。我喜欢按钮中应该有以下操作:

- 更新爱心图标

- 更新Music的喜欢属性,但ListItemBox并没有歌曲数据,所以只能发射信号,上其父元素CommonPage来处理

// listItemBox.h 中新增

public:void onLikeBtnClicked(); // 按钮点击槽函数

signals:void setIsLike(bool); // 通知更新歌曲数据信号// ListItemBox.cpp 中新增

ListItemBox::ListItemBox(QWidget *parent) :QWidget(parent),ui(new Ui::ListItemBox),isLike(false)

{ui->setupUi(this);// 关联槽函数 执行切换图片事件connect(ui->likeBtn, &QPushButton::clicked, this, &ListItemBox::onLikeClicked);

}void ListItemBox::onLikeClicked()

{isLike = !isLike;setLikeMusic(isLike);// 通过发射信号来通知修改Music对象中isLike熟悉emit setIsLike(isLike);

}- CommonPage在往QListWidget中添加元素时,会创建⼀个个ListItemBox对象,每个对象将来都可能会发射setLikeMusic信号,因此在将ListItemBox添加完之后,CommonPage应该关联先该信号,将需要更新的的Music信息以及是否喜欢,同步给QQMusic

// commonpage.h中新增

signals:void updateLikeMusic(bool isLike, QString musicId);// commonpage.cpp中新增

// 该⽅法负责将歌曲信息更新到界面

void CommonPage::reFresh(MusicList &musicList)

{// ...for(auto musicId : musicOfPage){// ...QListWidgetItem* item = new QListWidgetItem(ui->pageMusicList);item->setSizeHint(QSize(listItemBox->width(), listItemBox->height()));ui->pageMusicList->setItemWidget(item, listItemBox);// 接收ListItemBox发射的setLikeMusic信号connect(listItemBox, &ListItemBox::setIsLike, this, [=](bool isLike){emit updateLikeMusic(isLike, it->getMusicId());});}ui->pageMusicList->repaint();

}QQMusic收到CommonPage发射的updateLikePage信号后,通知其上的likePage、localPage、recentPage更新其界面的喜欢歌曲信息

// qqmusic.h 新增

void onUpdateLikeMusic(bool isLike, QString musicId); // 响应CommonPage发射updateLikeMusic信号// qqmusic.cpp新增

void QQMusic::connectSignalAndSlots()

{// ...// 关联CommonPage发射的updateLikeMusic信号connect(ui->likePage, &CommonPage::updateLikeMusic, this,&QQMusic::onUpdateLikeMusic);connect(ui->localPage, &CommonPage::updateLikeMusic, this,&QQMusic::onUpdateLikeMusic);connect(ui->recentPage, &CommonPage::updateLikeMusic, this,&QQMusic::onUpdateLikeMusic);

}void QQMusic::onUpdateLikeMusic(bool isLike, QString musicId)

{// 通过ID找到该音乐,修改状态auto it = musiclist.findMusicByMusicId(musicId);if(it != musiclist.end()){it->setIsLike(isLike);}// 更新页面歌曲列表ui->page_like->reFresh(musiclist);ui->page_local->reFresh(musiclist);ui->page_recent->refresh(musiclist);

}歌曲重复显示问题

当界⾯上歌曲数据更新之后,CommonPage往页面上更新其musicOfPage内容时,musicOfPage和界⾯中的QListWidget中已经有数据了,需要先将之前的内容清楚掉,否则就会重复。

// commonpage.cpp修改

void CommonPage::addMusicToMusicPage(MusicList &musicList)

{musicOfPage.clear();// ...

}void CommonPage::reFresh(MusicList &musicList)

{ui->pageMusicList->clear();// ...

}音乐播放控制

歌曲已经添加到程序并完成解析,解析的信息也更新到界面了,所有前置⼯作基本完成,接下来重点处理音乐播放,歌曲播放需要⽤到Qt提供的QMediaPlayer类和QMediaPlaylist类

QMediaPlayer类

QMediaPlayer类说明

MediaPlayer是Qt框架中⽤于⽀持各种⾳频和视频的播放,流媒体的播放,各种播放模式(单曲播放、列表播放、循环播放等),各种播放模式(播放、暂停、停⽌等),信号槽机制可以让用户在播放状态改变时进⾏所需控制。

使⽤时需要包含 #include <QMediaPlayer> 头⽂件,并且需要在.pro项目文件中添加媒体库,即: QT += multimedia ,将 multimedia 模块导⼊到⼯程中,就可以使用该模块中提供的媒体播放控制的相关类,比如:QMediaPlayer、QMediaPlayList等

属性和方法

枚举类型

QMediaPlayer::State枚举类型:

| 状态枚举名称 | 枚举值 | 说明 |

| QMdiaPlayer::StoppedState | 0 | 播放停止状态 |

| QMdiaPlayer::PlayingState | 1 | 播放状态 |

| QMdiaPlayer::PausedState | 2 | 播放暂停状态 |

QMediaPlayer::Flag

| 状态枚举名称 | 枚举值 | 说明 |

| QMdiaPlayer::LowLatency | 0 | 播放未压缩的音频⽂件,播放表现为低时延,主要播放蜂鸣、手机铃声 |

| QMdiaPlayer::StreamPlayback | 1 | 播放给予QIODevice构建的媒体文件,QMediaPlayer或自动选择支持的流进行播放 |

| QMdiaPlayer::VideoSurface | 2 | 渲染视频到QAbstractVideoSurface输出 |

QMediaPlayer::Error

| 状态枚举名称 | 枚举值 | 说明 |

| QMdiaPlayer::NoError | 0 | 没有错误 |

| QMdiaPlayer::ResourceError | 1 | 媒体源无法解析 |

| QMdiaPlayer::FormatError | 2 | 媒体源格式不支持,可能会播放,但是没有音频和视频组件 |

| QMdiaPlayer::NetworkError | 3 | 网络错误 |

| QMdiaPlayer::AccessDeniedError | 4 | 没有媒体源访问权限 |

| QMdiaPlayer::ServiceMissingError | 5 | 没有有效的播放服务,无法继续播放 |

QMediaPlayer::MediaStatus

| 状态枚举名称 | 枚举值 | 说明 |

| QMdiaPlayer::UnknownMediaStatus | 0 | 媒体的状态未被定义 |

| QMdiaPlayer::NoMedia | 1 | 没有媒体文件,player处于StoppedState |

| QMdiaPlayer::LoadingMedia | 2 | 媒体文件加载中,player可以处于任何状态 |

| QMdiaPlayer::LoadedMedia | 3 | 媒体文件已经加载,player处于StoppedState |

| QMdiaPlayer::StalledMedia | 4 | 媒体处于延迟或者暂时中断状态,player处于PlayingState或PauseState |

| QMdiaPlayer::BufferingMedia | 5 | 媒体正在缓冲数据,player处于PlayingState或PauseState |

| QMdiaPlayer::BufferedMedia | 6 | 媒体数据缓冲完成,player处于PlayingState或PauseState |

| QMdiaPlayer::EndOfMedia | 7 | 媒体结束,player处于StoppedState |

| QMdiaPlayer::InvalidMedia | 8 | 非法的媒体⽂件,player处于StoppedState |

常用属性

// 部分常⽤属性

const qint64 duration; // 保存媒体的总播放时间,单位为毫秒

const QMediaContent currentMedia; // 当前正在播放媒体的媒体内容

const QString error; // 最近⼀次错误信息

int volume; // 保存⾳量⼤⼩,范围在0~100之间

const bool audioAvailable; // ⾳频是否可⽤,audioAvailableChanged信号⽤于监听其状态

QMediaPlaylist* playtlist; // 播放列表常用函数

qint64 duration() const; // 获取当前媒体的总时间

qint64 position() const; // 获取当前媒体的播放位置

int volume() const; // 获取播放⾳量⼤⼩

bool isMuted() const; // 检测是否静⾳

State state() const; // 获取当前媒体的播放状态

QMediaContent currentMedia() const; // 获取当前正在播放的媒体内容

QString errorString() const // 获取最近的⼀次错误常用槽函数

void pause(); // 播放媒体

void play(); // 暂停媒体

void stop(); // 停⽌播放媒体

void setMuted(bool muted); // 设置是否静⾳,true为静⾳,false为⾮静⾳

void setVolume(int volume); // 设置播放⾳量,volume取值范围在0~100之间

void setPosition(qint64 position); // 设置播放位置,position为要播放的时间,单位毫秒// 设置播放列表,若播放多个媒体需要设置,默认为空

void setPlaylist(QMediaPlaylist *playlist);// 设置媒体源

void setMedia(const QMediaContent &media, QIODevice *stream = nullptr);常用信号

void stateChanged(QMediaPlayer::State state); // 播放状态改变时发射该信号

void durationChanged(qint64 duration); // 播放时⻓改变时发射该状态

void positionChanged(qint64 position); // 播放位置改变时发射该状态

void volumeChanged(int volume); // ⾳量改变时发射该信号

void metaDataAvailableChanged(bool available); // 源数据改变发出以上只列出了本次需要⽤到的属性、方法和槽函数,后续需要使用时请参考Qt帮助手册

QMediaPlaylist类

QMediaPlaylist类介绍

QMediaPlaylist 类提供了⼀种灵活而强⼤的方式管理媒体⽂件的播放列表。通过结合QMediaplayer,可以实现顺序播放、循环播放随机播放等多种播放模式,提升用户的媒体播放体验。该类提供了以下功能:

- 添加和删除媒体文件

- 播放模式设置(列表播放、随机播放、单曲循环)

- 控制播放列表(开始,停止,上⼀曲,下⼀曲)

- 获取和设置当前媒体文件 信号槽支持

若播放多个媒体文件,必须使用该类来管理媒体文件,将该列表设置到player上,就可实现更加灵活的播放支持

属性和方法

枚举类型

QMediaPlaylist::PlaybackMode

| 枚举状态名称 | 枚举值 | 说明 |

| QMediaPlaylist::CurrentItemOnce | 0 | 单词播放 |

| QMediaPlaylist::CurrentItemInLoop | 1 | 单曲循环 |

| QMediaPlaylist::Sequential | 2 | 从当前选中位置开始,顺序播放 |

| QMediaPlaylist::Loop | 3 | 列表中⽂件循环播放 |

| QMediaPlaylist::Random | 4 | 列表中⽂件随机播放 |

常见属性

int currentIndex; // 当前播放的媒体⽂件在媒体列表中的索引

const QMediaContent currentMedia; // 当前选中的媒体⽂件

QMediaPlaylist::PlaybackMode playbackMode; // 媒体列表中⽂件的播放模式常见方法

bool addMedia(const QMediaContent &content); // 向媒体列表中添加单个媒体⽂件

int mediaCount() const; // 获取播放列表中⽂件的个数

int currentIndex() const; // 获取当前播放的媒体的索引

bool clear(); // 清空媒体列表

QMediaPlaylist::PlaybackMode playbackMode() const; // 获取媒体列表的播放模式

QMediaContent currentMedia() const; // 获取当前播放的媒体⽂件

QString errorString() const; // 获取最近⼀次发⽣过的错误常见槽函数

void next(); // 下⼀曲

void previous(); // 上⼀曲

void setCurrentIndex(int playlistPosition); // 设置当前播放媒体的索引

void shuffle(); // 媒体顺序打乱,重建媒体索引常用信号

// 列表播放模式⽅法改变时发射

void playbackModeChanged(QMediaPlaylist::PlaybackMode mode);// 当前索引发⽣改变时发射

void currentIndexChanged(int position);// 当前媒体⽂件改变时发⽣

void currentMediaChanged(const QMediaContent &content);该类提供的方法非常丰富,此处暂介绍了需要⽤到的内容,后续开发时需要用到其他内容请参考Qt帮助手册

歌曲播放

播放媒体和播放列表初始化

在播放之前,需要先将QMediaPlayer和QMediaPlaylist初始化好。QQMusic类中需要添加QMediaPlayer和QMediaPlaylist的对象指针,在界⾯初始化时将这两个类的对象创建好

#include <QMediaPlayer>

#include <QMediaPlaylist>// qqmusic.h 新增

public:void initPlayer(); // 初始化媒体对象private://播放器相关QMediaPlayer* player;// 要多⾸歌曲播放,以及更复杂的播放设置,需要给播放器设置媒体列表QMediaPlaylist* playlist;// qqmusic.cpp 中添加

QQMusic::QQMusic(QWidget *parent): QWidget(parent), ui(new Ui::QQMusic)

{ui->setupUi(this);// 窗⼝控件的初始化⼯作initUI();// 初始化播放器initPlayer();// 关联所有信号和槽connectSignalAndSlot();

}void QQMusic::initPlayer()

{// 创建播放器player = new QMediaPlayer(this);// 创建播放列表playList = new QMediaPlaylist(this);// 设置播放模式:默认为循环播放playList->setPlaybackMode(QMediaPlaylist::Loop);// 将播放列表设置给播放器player->setPlaylist(playList);// 默认⾳量⼤⼩设置为20player->setVolume(20);

}播放列表设置

播放之前,先要将歌曲加⼊用于播放的媒体列表,由于每个CommonPage页面的歌曲不同,因此CommonPage中新增将其页面歌曲添加到模仿列表的方法。

// commonpage.h 中新增

#include <QMediaPlaylist>void addMusicToPlayer(MusicList &musicList, QMediaPlaylist *playList);// commonpage.cpp 中新增

void CommonPage::addMusicToPlayer(MusicList &musicList, QMediaPlaylist*playList)

{for(auto music : musicList){switch (pageType){case LIKE_PAGE:if(music.getIsLike()){musicOfPage.push_back(music.getMusicId());}break;case LOCAL_PAGE:musicOfPage.push_back(music.getMusicId());break;case HISTORY_PAGE:if(music.getIsHistory()){musicOfPage.push_back(music.getMusicId());}break;default:qDebug() << "暂未支持";}}

}播放和暂停

- 当点击播放和暂停按钮时,播放状态应该在播放和暂停之间切换。播放器的状态如下,刚开始为停止状态

- QMediaPlayer的播放状态有:PlayingState()、PausedState()、StoppedState()。

| 播放状态 | 对应槽函数 | 说明 |

| PlayingState | | 正在播放 |

| PausedState | | 暂停 |

| StoppedState | | 停止状态 |

// qqmusic.h 中新增

// 播放控制区域

void onPlayCliked(); // 播放按钮// qqmusic.cpp 中新增

void QQMusic::onPlayCliked()

{if(QMediaPlayer::PlayingState == player->state()){// 正在播放点击触发暂停事件player->pause();}else if(QMediaPlayer::PausedState == player->state()){// 暂停点击触发继续播放事件player->play();}else if(QMediaPlayer::StoppedState == player->state()){// 启动时点击触发开始播放事件player->play();}else{qDebug() << player->error();}

}void QQMusic::connectSignalAndSlots()

{// ...// 播放控制区的信号和槽函数关联connect(ui->play, &QPushButton::clicked, this, &QQMusic::onPlayMusic);

}播放时默认是从播放列表索引为0的歌曲开始播放的

另外播放状态改变的时候,需要修改播放按钮上图标,图⽚的修改可以在onPlayCliked函数中设置,也可以拦截

QMediaPlayer中的stateChanged信号,当播放状态改变的时候,QMediaPlayer会触发该信号,在stateChanged信号中修改播放按钮也可以,此处拦截stateChanged信号

// qqmusic.h 新增// QMediaPlayer信号处理

// 播放状态发⽣改变

void onPlayStateChanged();// qqmusic.cpp 新增

// QMediaPlayer信号关联槽函数void QQMusic::onPlayStateChanged()

{if(player->state() == QMediaPlayer::PlayingState){// 处于播放状态时ui->play->setIcon(QIcon(":/images/play_on.png"));}else{ui->play->setIcon(QIcon(":/images/play.png"));}

}void QQMusic::initPlayer()

{// ...// QMediaPlayer信号和槽函数关联// 播放状态改变时:暂停和播放之间切换connect(player, &QMediaPlayer::stateChanged, this,&QQMusic::onPlayStateChanged);

}播放和暂停切换的时候,按钮上的图标有重叠,是因为之前在界⾯设置的时候,为了能看到效果,给 按钮添加了背景图片,背景图片和图标是两种属性,都设置时就ui叠加,因此将按钮上个添加背景图片样式去除掉。

void QQMusic::initUi()

{// 按钮的背景图⽚样式去除掉之后,需要设置默认图标// 播放控制区按钮图标设定ui->play->setIcon(QIcon(":/images/play_2.png")); // 默认为暂停图标ui->playMode->setIcon(QIcon(":/images/shuffle_2.png")); // 默认为随机播放volumeTool = new VolumeTool(this);

}上⼀曲和下⼀曲

播放列表中,提供了previous()和next()函数,通过设置前⼀个或者下⼀个歌曲为当前播放源,player就会播放对应的歌曲

// qqmusic.h 新增

void onPlayUpCliked(); // 上⼀曲

void onPlayDownCliked(); // 下⼀曲// qqmusic.cpp 新增

void QQMusic::onPlayUpCliked()

{playList->previous();

}void QQMusic::onPlayDownCliked()

{playList->next();

}void QQMusic::connectSignalAndSlots()

{// ...// 播放控制区的信号和槽函数关联connect(ui->play, &QPushButton::clicked, this, &QQMusic::onPlayMusic);connect(ui->playUp, &QPushButton::clicked, this,&QQMusic::onPlayUpClicked);connect(ui->playDown, &QPushButton::clicked, this,&QQMusic::onPlayDownClicked);

}播放模式设置

媒体列表提供了以下播放模式:

| 枚举状态名称 | 枚举值 | 说明 |

| QMediaPlaylist::CurrentItemOnce | 0 | 单曲播放 |

| QMediaPlaylist::CurrentItemInLoop | 1 | 单曲循环 |

| QMediaPlaylist::Sequential | 2 | 从当前选中位置开始,顺序播放 |

| QMediaPlaylist::Loop | 3 | 列表中文件循环播放 |

| QMediaPlaylist::Random | 4 | 列表中文件随机播放 |

QMediaPlaylist提供了获取和设置播放模式的方法:

QMediaPlaylist::PlaybackMode playbackMode() const; // 获取播放模式

void setPlaybackMode(QMediaPlaylist::PlaybackMode mode); // 设置播放模式目前暂支持:循环播放、随机播放、单曲循环

// qqmusic.h 中新增

void onPlaybackModeCliked(); // 播放模式设置// qqmusic.cpp 中新增

void QQMusic::initPlayer()

{// ...// 设置播放模式connect(ui->playMode, &QPushButton::clicked, this,&QQMusic::onPlaybackModeCliked);

}void QQMusic::onPlaybackModeClicked()

{// 列表循环->随机播放->单曲循环if(playList->playbackMode() == QMediaPlaylist::Loop){// 列表循环->随机播放playList->setPlaybackMode(QMediaPlaylist::Random);ui->playMode->setToolTip("随机播放");}else if(playList->playbackMode() == QMediaPlaylist::Random){playList->setPlaybackMode(QMediaPlaylist::CurrentItemInLoop);ui->playMode->setToolTip("单曲循环");}else if(playList->playbackMode() == QMediaPlaylist::CurrentItemInLoop){playList->setPlaybackMode(QMediaPlaylist::Loop);ui->playMode->setToolTip("列表循环");}else{qDebug() << "暂未支持";}

}播放模式切换时会触发 playbackModeChanged 信号,在该信号对应槽函数中,完成图片切换

// qqmusic.h 中新增

// 播放模式切换槽函数

void onPlaybackModeChanged(QMediaPlaylist::PlaybackMode playbackMode);/ qqmusic.cpp 中新增

void QQMusic::onPlaybackModeChanged(QMediaPlaylist::PlaybackMode playbackMode)

{if(playbackMode == QMediaPlaylist::Loop){ui->playMode->setIcon(QIcon(":/images/playMode.png"));}else if(playbackMode == QMediaPlaylist::Random){ui->playMode->setIcon(QIcon(":/images/shuffle.png"));}else if(playbackMode == QMediaPlaylist::CurrentItemInLoop){ui->playMode->setIcon(QIcon(":/images/single_play.png"));}else{qDebug() << "暂未支持该模式";}

}void QQMusic::initPlayer()

{// ...// 播放列表的模式放⽣改变时的信号槽关联connect(playList, &QMediaPlaylist::playbackModeChanged,this,&QQMusic::onPlaybackModeChanged)

}播放所有

- 播放所有按钮属于CommonPage中的按钮,其对应的槽函数添加在CommonPage类中,但是CommonPage不具有音乐播放的功能,因此当点击播放所有按钮后之后,播放所有的槽函数应该发射出信号,让QQMusic类完成播放。

- 由于likePage、localPage、recentPage三个CommonPage页面都有playAllBtn,因此该信号需要带上PageType参数,需要让QQMusic在处理该信号时,知道播放哪个页面的歌曲。

// commonpage.h 中新增加

signals:// 该信号由QQMusic处理--在构函数中捕获void playAll(PageType pageType);// commonpage.cpp 中修改

CommonPage::CommonPage(QWidget *parent) :QWidget(parent),ui(new Ui::CommonPage)

{ui->setupUi(this);// playAllBtn按钮的信号槽处理// 当播放按钮点击时,发射playAll信号,播放当前⻚⾯的所有歌曲// playAll信号交由QQMusic中处理connect(ui->playAllBtn, &QPushButton::clicked, this, [=](){emit playAll(pageType);});// ...

}在QQMusic中,给playAll信号关联槽函数,并播放当前Page页面的所有音乐。playAll槽函数中,根据pageType将当前page页⾯记录下来,默认从该页⾯的第0首歌曲开始播放。注意不要忘记关联信号槽。

// qqmusic.h 中新增// 播放所有信号的槽函数

#include "commonpage.h"void onPlayAll(PageType pageType);

void playAllOfCommonPage(CommonPage* commonPage, int index);// qqmusic.cpp 中新增

void QQMusic::onPlayAll(PageType pageType)

{// 播放当前对应页面中的所有歌曲CommonPage* page = ui->page_local;switch(pageType){case PageType::LIKE_PAGE:page = ui->page_like;break;case PageType::LOCAL_PAGE:page = ui->page_local;break;case PageType::HISTORY_PAGE:page = ui->page_recent;break;default:qDebug() << "无该页面";}// 播放当前page页面playAllMusicOfCommonPage(page, 0);

}void QQMusic::playAllOfCommonPage(CommonPage *commonPage, int index)

{// 清空之前加载过的playlistplayList->clear();// 添加当前播放页面歌曲page->addMusicToPlaylist(musiclist, playList);// 从第一首开始播放playList->setCurrentIndex(index);// 开始播放player->play();

}void QQMusic::connectSignalAndSlots()

{// ...// 关联播放所有的信号和槽函数connect(ui->likePage, &CommonPage::playAll, this, &QQMusic::onPlayAll);connect(ui->localPage, &CommonPage::playAll, this, &QQMusic::onPlayAll);connect(ui->recentPage, &CommonPage::playAll, this, &QQMusic::onPlayAll);

}双击CommPage页⾯QListWidget项播放

// QListWidget中的项被双击时触发

// QModelIndex类中的row()函数会返回被点击的QListWidgetItem在QListWidget中索引

void doubleClicked(const QModelIndex &index);该信号在QListWidget的基类中定义,有⼀个index参数,表示被双击的QListWidgetItem在QListWidget中的索引,该索引刚好与QMediaPlaylist中歌曲的所以⼀致,被双击时直接播放该首歌曲即可。

// CommonPage.h 中新增

signals:void playMusicByIndex(CommonPage*, int);// commonpage.cpp 中新增

CommonPage::CommonPage(QWidget *parent) :QWidget(parent),ui(new Ui::CommonPage)

{

// ...connect(ui->pageMusicList, &QListWidget::doubleClicked, this, [=](constQModelIndex &index){// ⿏标双击后,发射信号告诉QQMusic,博能放this⻚⾯中共被双击的歌曲emit playMusicByIndex(this, index.row());});

}// qqmusic.h 中新增

// CommonPage中playMusicByIndex信号对应槽函数

void playMusicByIndex(CommonPage* page, int index);// qqmusic.cpp 中新增

void QQMusic::playMusicByIndex(CommonPage *page, int index)

{playAllMusicOfCommonPage(page, index);

}void QQMusic::connectSignalAndSlots()

{// ...// 处理likePage、localPage、recentPage中ListItemBox双击connect(ui->likePage, &CommonPage::playMusicByIndex, this,&QQMusic::playMusicByIndex);connect(ui->localPage, &CommonPage::playMusicByIndex, this,&QQMusic::playMusicByIndex);connect(ui->recentPage, &CommonPage::playMusicByIndex, this,&QQMusic::playMusicByIndex);

}最近播放同步

- 当播放歌曲改变时,即播放的媒体源发⽣了变化,QMediaPlayer会触发metaDataAvailableChanged 信号,QMediaPlaylist也会触发currentIndexChanged信号,该信号会带index参数,表⽰现在是媒体播放列表中的index歌曲被播放,通过index可以获取到recentPage页⾯中具体播放的歌曲,将该歌曲对应Music对象的isHistoty属性修改为true,然后更新下rencentPage的歌曲列表,播放过的歌曲就添加到历史播放页面中了。

- 获取likePage、localPage、recentPage哪个CommonPage页⾯中的歌曲呢?

- QQMusic类中维护CommonPage*变量currentPage,记录当前正在播放的CommonPage页面,初始时设置为localPage,当播放的页面发生改变时,修改currentPage为当前正在播放页面,其中点击播放所有按钮以及双击QListWidget中项的时候都回引起currentPage的改变。

// qqmusic.h 中新增

CommonPage* curPage;// qqmusic.cpp 中修改

void QQMusic::initUi()

{// ...// 将localPage设置为当前⻚⾯ui->stackedWidget->setCurrentIndex(4);currentPage = ui->localPage;// ...

}void QQMusic::playAllOfCommonPage(CommonPage* commonPage, int index)

{currentPage = commonPage;// 播放page所在⻚⾯的⾳乐// 将播放列表先清空,否则⽆法播放当前CommonPage⻚⾯的歌曲// 另外:该⻚⾯⾳乐不⼀定就在播放列表中,因此需要先将该⻚⾯⾳乐添加到播放列表playList->clear();// ...

}准备工作完成之后,同步最近播放歌曲的逻辑实现如下:

// qqmusic.h 中新增

// ⽀持播放历史记录

void onCurrentIndexChanged(int index);// qqmusic.cpp 中新增

void QQMusic::initPlayer(int index)

{// ...// 播放列表项发⽣改变,此时将播放⾳乐收藏到历史记录中connect(playList, &QMediaPlaylist::currentIndexChanged, this,&QQMusic::onCurrentIndexChanged);

}void QQMusic::onCurrentIndexChanged(int index)

{// ⾳乐的id都在commonPage中的musicListOfPage中存储着const QString& musicId = currentPage->getMusicIdByIndex(index);// 有了MusicId就可以再musicList中找到该⾳乐auto it = musicList.findMusicByMusicId(musicId);if(it != musicList.end()){// 将该⾳乐设置为历史播放记录it->setIsHistory(true);}ui->recentPage->reFresh(musicList);

}// commmonpage.h 中新增

const QString& getMusicIdByIndex(int index) const;// commonpage.cpp 中新增

QString CommonPage::getMusicIdByIndex(int index)

{if(index >= musicOfPage.size()){qDebug()<<"⽆此歌曲";return "";}return musicOfPage[index];

}音量设置

功能分析

- 当点击静音按钮时,⾳量应该在静音和非静音之间进行切换,并且按钮上图标需要同步切换

- 鼠标在滑竿上点击或拖动滑竿时,应该跟进滑竿的高低比率,设置音量大小,同时修改界面音量比率

QMediaPlayer提供支持

QMediaPlayer中音量相关操作如下:

int volume; // 标记⾳量⼤⼩,值在0~100之间

int volume()const; // 获取⾳量⼤⼩

void setVolume(int); // 槽函数:设置⾳量⼤⼩bool muted; // 是否静⾳,true为静⾳,false为⾮静⾳

bool isMuted()const; // 获取静⾳状态

bool setMuted(bool muted); // 槽函数:设置静⾳或⾮静⾳静音和非静音切换

- VolumeTool类中需要添加两个成员变量,并在构造函数中完成默认值的设置

- 给静音按钮参加槽函数onSilenceBtnClicked,并在构造函数中connect按钮的clicked信号,当按钮点击时候,调用setMuted(bool nuted)函数,完成静音和非静音的设置

- 由于VolumeTool不具备媒体播放控制,因此当静音状态发生改变时,发射设置静音信号,让QQMusic来处理

// volumetool.h 中新增

signals:void setSilence(bool); // 设置静⾳信号void onSilenceBtnClicked(); // 静⾳按钮槽函数bool isMuted; // 记录静⾳或⾮静⾳,当点击静⾳按钮时,在true和false之间切换int volumeRatio; // 标记⾳量⼤⼩// volumetool.cpp 中新增

VolumeTool::VolumeTool(QWidget *parent) :QWidget(parent),ui(new Ui::VolumeTool),isMuted(false), // 默认静⾳volumeRatio(20) // 默认⾳量为20%

{//...// 关联静⾳按钮的信号槽connect(ui->silenceBtn, &QPushButton::clicked, this,&VolumeTool::onSilenceBtnClicked);

}void VolumeTool::onSilenceBtnClicked()

{isMuted = !isMuted;if(isMuted){ui->silenceBtn->setIcon(QIcon(":/images/silent.png"));}else{ui->silenceBtn->setIcon(QIcon(":/images/volumn.png"));}emit setSilence(isMuted);

}// qqMusic.h 中新增

void setMusicSilence(bool isMuted);// qqmusic.cpp 中新增

void QQMusic::setMusicSilence(bool isMuted)

{player->setMuted(isMuted);

}void QQMusic::connectSignalAndSlots()

{// ...// 设置静⾳connect(volumeTool, &VolumeTool::setSilence, this,&QQMusic::setMusicSilence);

}鼠标按下、滚动以及释放事件处理

当鼠标在滑竿上按下时,需要设置sliderBtn和outLine的位置,当鼠标在滑竿上移动或者鼠标抬起时,需要设置SliderBtnoutLine结束的位置,即改变VolumeTool中滑竿的显示。具体修改播放媒体音量大小操作应该由于QQMusic负责处理,因此当鼠标移动或释放时,需要发射信号让QQMusic知道需要修改播放媒体的音量大小了。

// volumetool.h 中新增

// 发射修改⾳量⼤⼩槽函数

void setMusicVolume(int);// 事件过滤器

bool eventFilter(QObject* object, QEvent* event);// volumetool.cpp 中新增

bool VolumeTool::eventFilter(QObject *object, QEvent *event)

{// 过滤volumeBox上的事件if(object == ui->volumeBox){if(event->type() == QEvent::MouseButtonPress){// 如果是⿏标按下事件,修改sliderBtn和outLine的位置,并计算volumeRationsetVolume();}else if(event->type() == QEvent::MouseMove){// 如果是⿏标滚动事件,修改sliderBtn和outLine的位置,并计算volumeRation,setVolume();// 并发射setMusicVolume信号emit setMusicVolume(volumeRatio);}else if(event->type() == QEvent::MouseButtonRelease){// 如果是⿏标释放事件,直接发射setMusicVolume信号emit setMusicVolume(volumeRatio);}return true;}return QObject::eventFilter(object, event);

}VolumeTool::VolumeTool(QWidget *parent) :QWidget(parent),ui(new Ui::VolumeTool),isMuted(false),volumeRatio(20)

{// ...// 安装事件过滤器ui->volumeBox->installEventFilter(this);

}outLine和SliderBtn以及volumeRation更新

- outLine坐标:[(28,25),4*180]。

- 当outLine最低时,即高度为0时候,outLine左上⻆坐标为:(28,205)

- 当outLine最高时,即高度为180时候,outLine左上⻆坐标为:(28,25)

- 当刷吧在滑竿上滚动时,鼠标坐标转化为volumeBox上相对坐标时,鼠标y坐标必须在[25~205]范围内。

- 据鼠标在滑竿上的相对高度更新:SliderBtn、outLine以及volumeRation的值

// volumetool.h 中新增

// 根据⿏标在滑竿上滑动更新滑动界⾯,并按照⽐例计算⾳量⼤⼩

void setVolume();// volumetool.cpp 中新增

void VolumeTool::setVolume()

{// 获取鼠标点击时Y的坐标int height = ui->volumeBox->mapFromGlobal(QCursor().pos()).y();// height坐标合法性height = height < 25 ? 25 : height;height = height > 205 ? 205 : height;// 更新outLine动画ui->outLine->setGeometry(ui->outLine->x(), height, ui->outLine->width(), 205 - height);// 更新sliderBtn按钮位置ui->silderBtn->move(ui->silderBtn->x(), ui->outLine->y() - ui->silderBtn->height() / 2);// 计算音量大小volumeRatio = (int)(ui->outLine->height() / (float)180 * 100);// 更新百分比ui->volumeRatio->setText(QString::number(volumeRatio) + "%");

}QQMusic类拦截VolumeTool发射的setMusicVolume信号,将音量大小设置为指定值。

// qqmusic.h 中新增

void setPlayerVolume(int vomume); // 设置音量大小// qqmusic.cpp 中新增

void QQMusic::setPlayerVolume(int volume)

{player->setVolume(volume);

}void QQMusic::connectSignalAndSlots()

{// ...// 设置⾳量⼤⼩connect(volumeTool, &VolumeTool::setMusicVolume, this,&QQMusic::setPlayerVolume);

}

当前播放时间和总时间更新

- 界面歌曲总时间更新

- 歌曲总时间在Music对象中可以获取,也可以让player调⽤⾃⼰的duration()⽅法获取。但是这两种 获取歌曲总时间的调用时机不太好确定。我们期望的是当歌曲发生切换时,获取到正在播放歌曲的总时长。

- 当播放源的持续时长发生改变时,QMediaPlayer会触发durationChanged信号,该信号中提供了将要播放媒体的总时长。

// duration为将要播放媒体的总时⻓

void QMediaPlayer::durationChanged(qint64 duration);因此在QQMusic类中给该信号关联槽函数,在槽函数中将duration更新到界⾯总时间即可。

// qqmusic.h 中新增

// 歌曲持续时⻓改变时[歌曲切换]

void onDurationChanged(qint64 duration);// qqmusic.cpp 中新增

void QQMusic::onDurationChanged(qint64 duration)

{ui->totalTime->setText(QString("%1:%2").arg(duration/1000/60, 2, 10,QChar('0')).arg(duration/1000%60,2,10,QChar('0')));

}void QQMusic::initPlayer()

{// ...// 媒体持续时⻓更新,即:⾳乐切换,时⻓更新,界⾯上时间也要更新connect(player, &QMediaPlayer::durationChanged, this,&QQMusic::onDurationChanged);

}界面歌曲当前播放时间更新

媒体在持续播放过程中,QMediaPlayer会发射positionChanged,该信号带有⼀个qint64类型参数,表示媒体当前持续播放的时间。

// position: 媒体持续播放时间

void positionChanged(qint64 position);因此,在QQMusic中捕获该信号,便可获取到正在播放媒体的持续时间。

/ qqmusic.h 中新增

// 播放位置改变,即持续播放时间改变

void onPositionChanged(qint64 duration);// qqmusic.cpp 中新增

void QQMusic::onPositionChanged(qint64 duration)

{ui->currentTime->setText(QString("%1:%2").arg(duration/1000/60, 2, 10,QChar('0')).arg(duration/1000%60,2,10,QChar('0')));// 界⾯上的进度条也需要同步修改

}void QQMusic::initPlayer()

{// ...// 播放位置发⽣改变,即已经播放时间更新connect(player, &QMediaPlayer::positionChanged, this,&QQMusic::onPositionChanged);

}在持续播放时间改变的同时,界面上的进度条应该也要前进

进度条处理[seek功能]

seek功能介绍

播放器的seek功能指,通过时间或位置快速定位到视频或音频流的特定位置,允许用户在播放过程中随时跳转到特定时间点,从而快速找到感兴趣的内容或重新开始播放。