文章目录

- 4.图像梯度计算

- (1)Sobel算子

- (2)梯度计算方法

- (3)Scharr与Laplacian算子

4.图像梯度计算

(1)Sobel算子

图像梯度-Sobel算子

Sobel算子是一种经典的图像边缘检测算子,广泛应用于图像处理和计算机视觉领域。以下是关于Sobel算子的详细介绍:

基本原理

Sobel算子是一种基于一阶导数的边缘检测算子,通过计算图像中每个像素点的梯度来检测边缘。它结合了图像的平滑处理和微分计算,旨在强调图像中强度变化显著的区域。

对于图像中的每个像素点,Sobel算子通过将卷积核与像素点及其邻域像素进行卷积运算,分别计算出水平方向和垂直方向的梯度。

水平方向梯度(Gx):使用Gx卷积核与图像进行卷积,得到水平梯度图像。

垂直方向梯度(Gy):使用Gy卷积核与图像进行卷积,得到垂直梯度图像。

优点

计算简单:Sobel算子的卷积核简单,计算速度快。

对噪声有一定鲁棒性:由于结合了平滑处理,对噪声有一定的抑制作用。

缺点

对斜边缘检测效果不佳:Sobel算子对水平和垂直边缘的检测效果较好,但对斜边缘的检测效果相对较弱。

对高频噪声敏感:尽管比单纯的差分算子要好一些,但仍然对高频噪声较敏感。

应用

Sobel算子在图像处理和计算机视觉领域有广泛应用,包括:

- 边缘检测:用于提取图像中的边缘信息。

- 特征提取:作为图像分析和物体识别的预处理步骤。

- 图像分割:帮助确定图像中不同区域的边界。

import cv2

import matplotlib.pyplot as plt

img = cv2.imread('pie.png',cv2.IMREAD_GRAYSCALE)

cv2.imshow('img',img)

cv2.waitKey()

cv2.destroyAllWindows()img_rgb = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)# 使用Matplotlib显示图像

plt.imshow(img_rgb)

plt.show()

dst = cv2.Sobel(src, ddepth, dx, dy, ksize)

- ddepth:图像的深度

- dx和dy分别表示水平和竖直方向

- ksize和Sobel算子的大小

import numpy as np

def cv_show(img,name):cv2.imshow(name,img)cv2.waitKey()cv2.destroyAllWindows()#计算x方向的梯度,dx=1

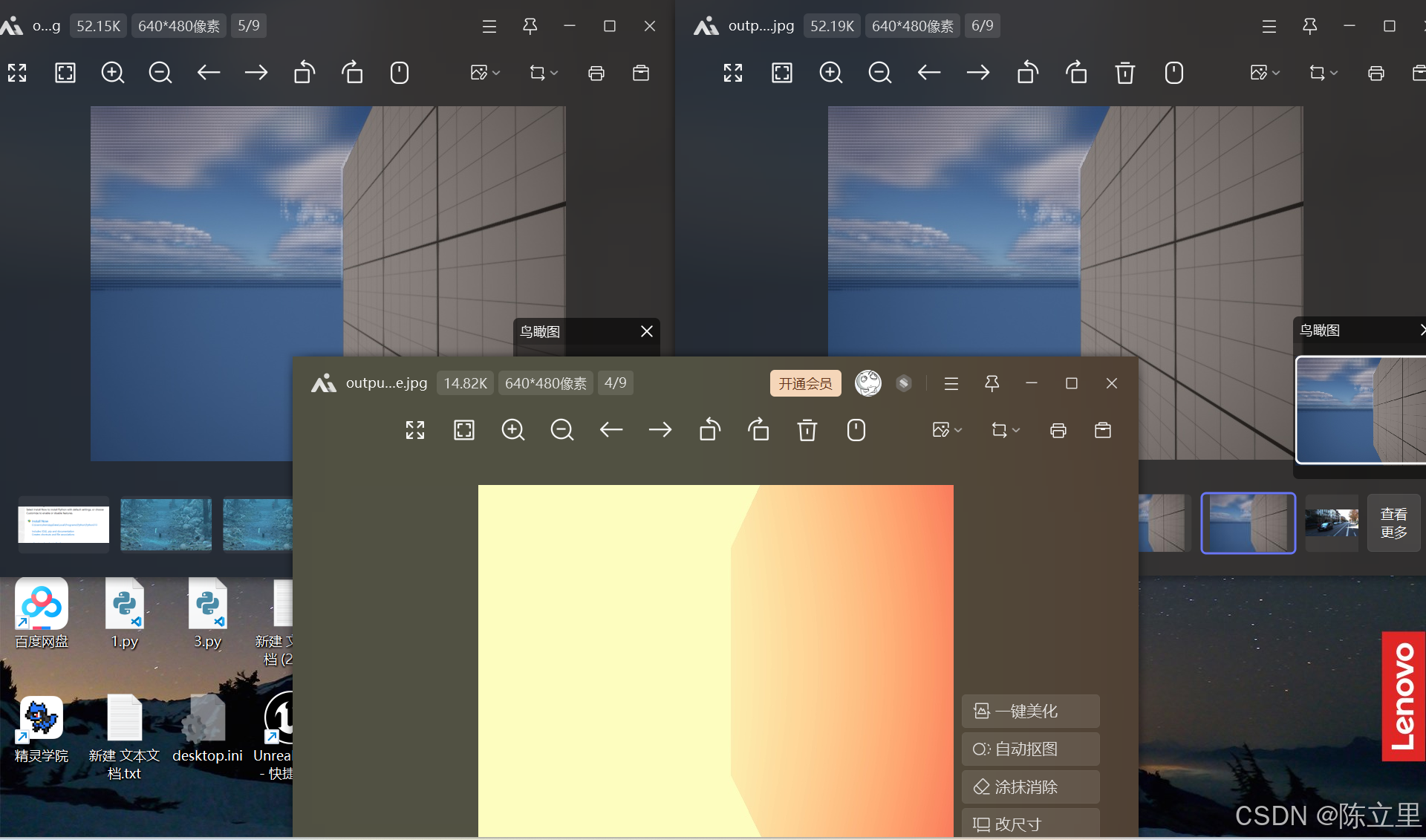

sobelx = cv2.Sobel(img,cv2.CV_64F,1,0,ksize=3)

cv_show(sobelx,'sobelx'

![[Collection与数据结构] B树与B+树](https://i-blog.csdnimg.cn/direct/b96afb008a104ddca272db3e6e105ace.png)