一,环境准备

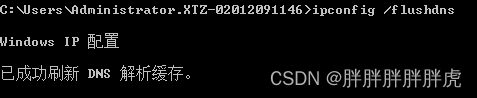

把两台虚拟机的ip地址设置成静态的IP地址,否则ip地址会变

虚拟机配置静态IP(NAT模式)_nat子网的准入_阿祖,收手吧的博客-CSDN博客

| 节点 | IP | 软件 |

| 云节点 | 192.168.133.139 | kubernetes+cloudcore |

| 边结点 | 192.168.133.136 | kubeedge(edgecore) |

| 边结点 | 192.168.133.137 | kubeedge(edgecore) |

映射好ssh端口(问题)

二,主节点master的配置

1,初始准备

node节点和主节点一样,要执行到kubeadm init之前

- 1、hostname配置

(配置本机主机名,我们需要设置hostname为 “k8s-master” ,与hosts 相匹配)

# 设置当前机器1的hostname

hostnamectl set-hostname k8s-master

# 查看当前机器hostname

hostname

- 2、hosts配置

vim /etc/hosts192.168.133.139 k8s-master

192.168.133.136 kubeedge1

192.168.133.137 kubeedge2如果不配置hostname 默认会配置为localhost.localdomain,k8s 运行时会报错Error getting node" err="node \"localhost.localdomain\" not found

- 3、基础依赖包安装

# 系统时钟同步

# 向阿里云服务器同步时间

ntpdate time1.aliyun.com

# 删除本地时间并设置时区为上海

rm -rf /etc/localtime

ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

# 查看时间

date -R || date

- 4、关闭防火墙、selinux

systemctl stop firewalldsystemctl disable firewalldsed -i 's/enforcing/disabled/' /etc/selinux/configsetenforce 0- 5、关闭swap

# 临时关闭Swap

swapoff -a

# 修改 /etc/fstab 删除或者注释掉swap的挂载,可永久关闭swap

sed -i '/swap/s/^/#/' /etc/fstab

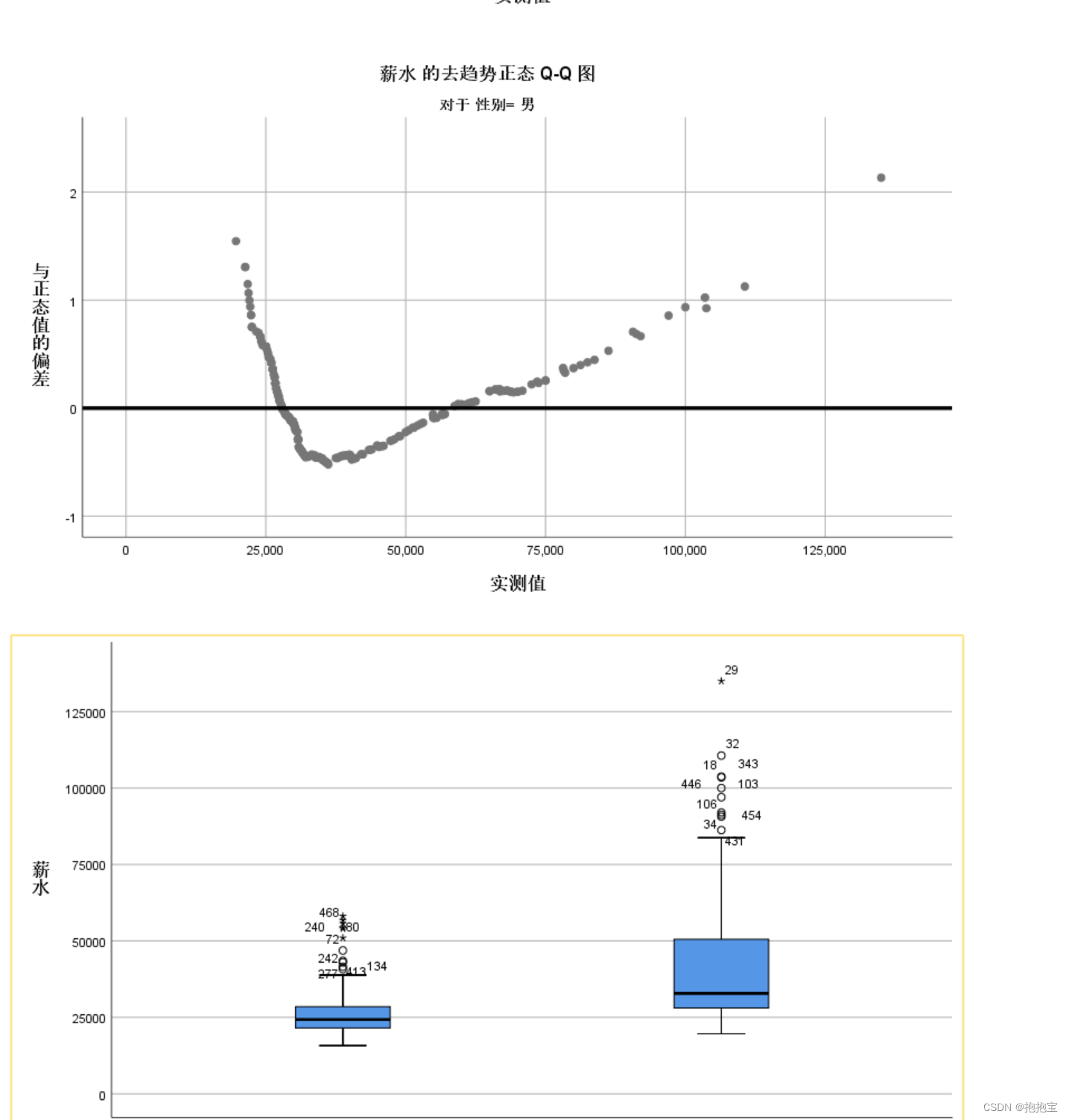

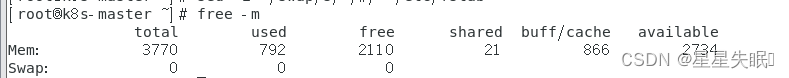

# 修改完后我们检测以下,看最后一行swap 都是0 就成功了

free -m

- 6、网桥过滤

# 网桥过滤

vim /etc/sysctl.confnet.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-arptables = 1

net.ipv4.ip_forward=1

net.ipv4.ip_forward_use_pmtu = 0# 生效命令

sysctl --system

# 查看效果

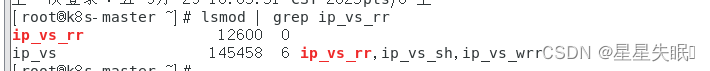

sysctl -a|grep "ip_forward"- 7、开启ipvs

kubernetes1.8版本开始,新增了kube-proxy对ipvs的支持,性能和追踪问题比iptable强)------ 此步骤为选填项,如果不执行那么默认使用iptables

# 安装IPVS

yum -y install ipset ipvsdm

# 编译ipvs.modules文件

vi /etc/sysconfig/modules/ipvs.modules

# 文件内容如下

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

# 赋予权限并执行

chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules &&lsmod | grep -e ip_vs -e nf_conntrack_ipv4

# 重启电脑,检查是否生效

reboot

lsmod | grep ip_vs_rr2,Docker安装

- docker 换源安装

-

# 安装yum utils yum install -y yum-utils # yum docker-ce config 换源 yum-config-manager \--add-repo \https://download.docker.com/linux/centos/docker-ce.repo # 安装docker yum -y install docker-ce docker-ce-cli containerd.io # 启动docker, enable 为必须,k8s会检测docker.service systemctl enable docker && systemctl start docker

- docker配置镜像加速

exec-opts参数配置为native.cgroupdriver=systemd,这一步很重要,下面的镜像地址参考阿里云。

# 创建docker目录

mkdir -p /etc/docker

# 设置镜像源, exec-opts必须指定否则k8s启动报错(cgroup、systemd)

tee /etc/docker/daemon.json <<-'EOF'

{"exec-opts": ["native.cgroupdriver=systemd"],"registry-mirrors": ["https://g6t55xi7.mirror.aliyuncs.com"]

}

EOF

# 重启docke并生效镜像加速

systemctl daemon-reload && systemctl restart docker3, Kubernetes安装

- 配置kubernetes源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF注意:阿里源并未与官网同步gpg(由于官网未开放同步方式, 可能会有索引gpg检查失败的情况,这时请用如下命令安装)

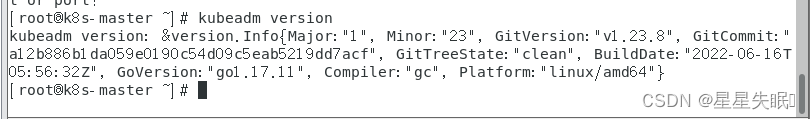

- 安装完成后我们检查一下

# 检查kubectl version

kubectl version# 检查kubeadm版本

kubeadm version

- 启动k8s服务

# 启动k8s服务

systemctl enable kubelet && systemctl start kubelet

# 查看服务状态

systemctl status kubelet

现在kubelet服务起不来是正常的,应该init之后就会起来

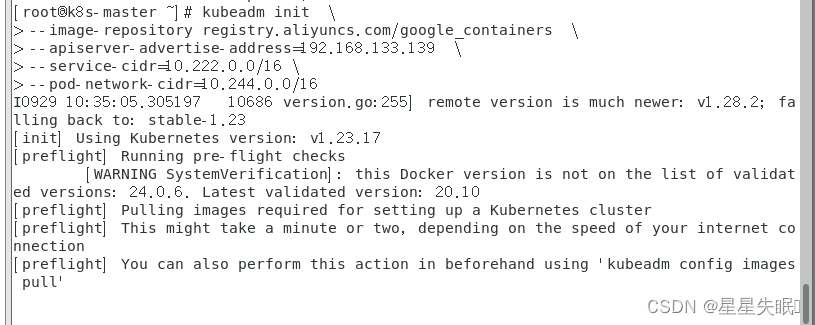

k8s master 主节点初始化(仅master节点执行– 这里考虑的是单master,多slave)

注意:这里一定要改成自己master的IP地址,并且这句话需要在master节点上执行

如果你没有改ip地址执行了一次,即使再改成正确的ip地址也会出现错误

注意:这句话只在master节点执行,node节点不要执行!!!!!否则想把node节点join到master节点时join不进去!!!!需要重新在做一遍,很麻烦

# 初始化

kubeadm init \

--image-repository registry.aliyuncs.com/google_containers \

--apiserver-advertise-address=192.168.133.139 \

--service-cidr=10.222.0.0/16 \

--pod-network-cidr=10.244.0.0/16# 初始化过程比较长,需要下载一些资源#这里补充以下参数说明

--apiserver-advertise-address=192.168.133.139 这个参数就是master主机的IP地址,例如我的Master主机的IP是:192.168.133.139--image-repository=registry.aliyuncs.com/google_containers 这个是镜像地址,由于国外地址无法访问,故使用的阿里云仓库地址:registry.aliyuncs.com/google_containers--service-cidr=10.222.0.0/16 这个参数后的IP地址直接就套用10.222.0.0/16 ,以后安装时也套用即可,不要更改--pod-network-cidr=10.244.0.0/16 k8s内部的pod节点之间网络可以使用的IP段,不能和service-cidr写一样,如果不知道怎么配,就先用这个10.244.0.0/16

还可以指定k8s版本,用以下参数即可

--kubernetes-version=v1.23.8 这个参数是下载的k8s软件版本号总之,只修改master主机IP,k8s软件版本)

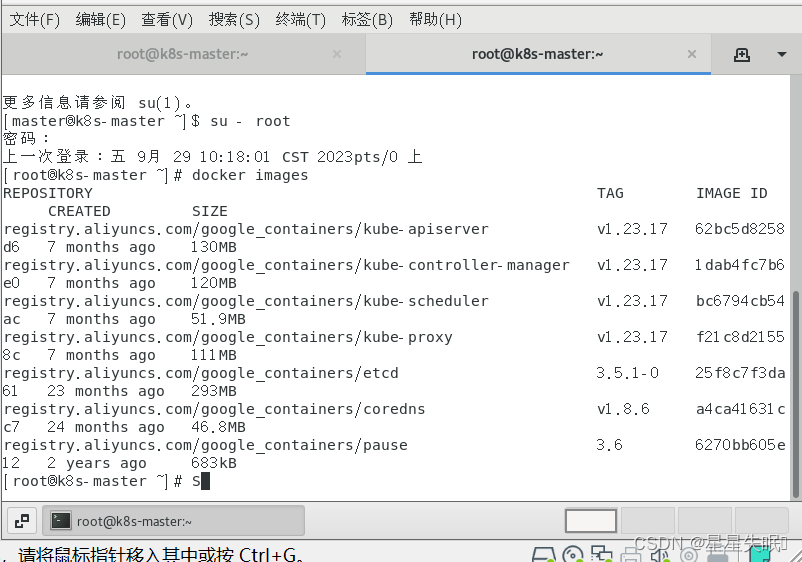

这时候你可以另起一个标签页去查看pull下来了什么以及情况

这些都是k8s的一些重要组件

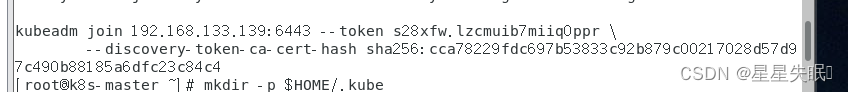

刚才init的结果会提示你接下来需要做的步骤,还需要进行一些收尾工作,根据kubeadm init log 提示,执行以下命令

mkdir -p $HOME/.kube

cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

chown $(id -u):$(id -g) $HOME/.kube/config

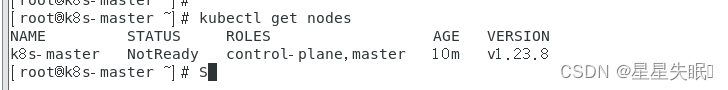

然后,我们就可以进行k8s的节点查询

# 查询节点

kubectl get nodes

此时, STATUS 是 NotReady状态,因为网络组件还未安装,Pod之间还不能通讯

这时你可以查看刚才systemctl status kubelet这个命令查看kubelet的状态,服务起来了

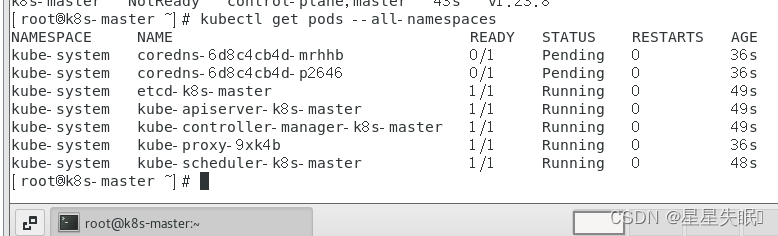

查看各命名空间下的Pod信息

kubectl get pods --all-namespaces

可以看到NDS解析服务coredns的pod还处于Pending状态未运行,也是因为网络组件还没安装。

三、网络插件的安装

下面我们进行网络组件的安装

这里只简单说明下,推荐使用calico

flannel 和 calico 是常用的网络插件。

calico 的性能更好,使用场景更广一些。

flannel 没有网络策略,不能控制pod的访问。

这里我们用calico插件。

curl https://docs.projectcalico.org/v3.18/manifests/calico.yaml -O

kubectl apply -f calico.yaml

kubectl get nodes

安装完成, 如果有条件的话,现在就可以做一个快照了,因为后面的操作很可能会频繁出错,这里多做一些备份是好的习惯。

下面介绍一些其他常用信息。

# 查看k8s 运行日志命令, 这个比较有用,在k8s 启动、kubeadm init、kubeadm join 阶段可以辅助分析问题。

journalctl -xefu kubelet

# 查看k8s驱动

systemctl show --property=Environment kubelet |cat

# 重启k8s

systemctl restart kubelet

# 启动k8s

systemctl start kubelet

# 停止k8s

systemctl stop kubelet

# 开机自启k8s

systemctl enable kubelet# dashboard 获取token

kubectl describe secret admin-user -n kubernetes-dashboard# kubeadm 重置, 有些时候我们在使用kubeadm init 命令时会报错,我们根据错误提示修复问题后需要重新进行 init 操作,因此需要进行reset重置

kubeadm resetRelease KubeEdge v1.12.1 release · kubeedge/kubeedge · GitHub

四、安装KubeEdge

还是在k8s-master节点!!!

- 安装版本:v1.12.1

如下图所示为kubernetes和Kubeedge版本对应关系,这里安装Kubeedge v1.12.1

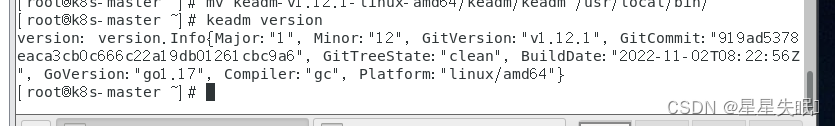

1 安装keadm

如果网络不好,也可采用离线安装。将以下文件下载下来,下载地址:https://github.com/kubeedge/kubeedge/releases/tag/v1.12.1

版本一定要对应,这里别整错了,都是v1.12.1

uname -a

# 下载Keadm

wget https://github.com/kubeedge/kubeedge/releases/download/v1.12.1/keadm-v1.12.1-linux-amd64.tar.gz#解压

tar zxvf keadm-v1.12.1-linux-amd64.tar.gz

#添加执行权限

chmod +x keadm-v1.12.1-linux-amd64/keadm/keadm

#移动目录

mv keadm-v1.12.1-linux-amd64/keadm/keadm /usr/local/bin/

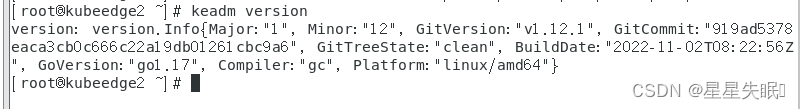

# 查看keadm是否安装

keadm version#输出版本信息

version: version.Info{Major:"1", Minor:"12", GitVersion:"v1.12.1", GitCommit:"919ad5378eaca3cb0c666c22a19db01261cbc9a6", GitTreeState:"clean", BuildDate:"2022-11-02T08:22:56Z", GoVersion:"go1.17", Compiler:"gc", Platform:"linux/amd64"}2 启动Cloudcore

运行以下命令启动cloudecode,修改下面地址为k8s-master主机地址

keadm init --advertise-address=172.23.70.235 --kubeedge-version=1.12.1 # 查询cloudcore进程,如果查到cloudcore,表明启动成功

ps -ef | grep cloudcore 这个是启动成功的返回结果

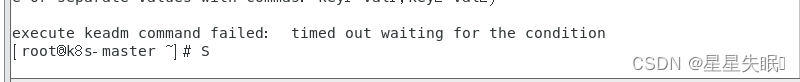

出现问题:execute keadm command failed: timed out waiting for the condition

这是因为cloudcore没有污点容忍,默认master节点是不部署应用的,可以用下面的命令查看污点:

kubectl describe nodes k8s-master | grep Taints

把master的污点删掉

kubectl taint node k8s-master node-role.kubernetes.io/master-# 然后重置

keadm reset

#再重新启动

我reset的时候遇到了这个问题解决了

解决:Unable to connect to the server: x509: certificate signed by unknown authority (possibly because-CSDN博客

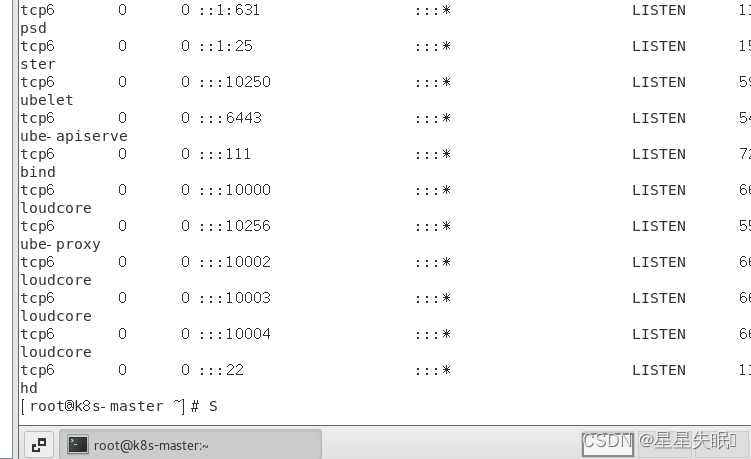

查看端口

出现10000,和10002,这两个端口算正常。

如果安装失败,可以通过以下命令重置,然后重新安装

keadm reset

执行完这个,系统会有提示,你需要重新重新init和join等操作

生成证书,后面会用到

# 使用以下命令生成证书keadm gettoken# 输出

1d3c0fc18c82264606283dcdf0eac02e53ada4fa297b45590cca105bb7311463.eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJleHAiOjE2OTYwNDkwODZ9.kfQOWuqK5rnpkY36hEQ2o1eRhvu00GiTZpKc8A1CZzo至此,如果不出问题的话云端节点暂时安装完成,可以再打个快照,下面安装边缘节点。

五,边缘节点安装

除了kubeadm init操作外其他的都执行

下面我们简单说下 子节点服务器的操作流程:

# 基础依赖包安装

yum -y install wget vim net-tools ntpdate bash-completion

# 修改当前机器名

hostnamectl set-hostname k8s-slave02

# 或 hostnamectl set-hostname k8s-slave03# 修改hosts文件

vim /etc/hosts192.168.56.105 k8s-master01

192.168.56.106 k8s-slave02

192.168.56.107 k8s-slave03# 系统时钟同步与时区配置

ntpdate time1.aliyun.com

rm -rf /etc/localtime

ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

date -R || date# 关闭防火墙、selinux

systemctl stop firewalld

systemctl disable firewalld

sed -i 's/enforcing/disabled/' /etc/selinux/config

setenforce 0# 关闭swap

swapoff -a

sed -i '/swap/s/^/#/' /etc/fstab

free -m# 网桥过滤

vim /etc/sysctl.confnet.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-arptables = 1

net.ipv4.ip_forward=1

net.ipv4.ip_forward_use_pmtu = 0# 生效命令 与 查看

sysctl --system

sysctl -a|grep "ip_forward"# docker安装

yum install -y yum-utils

yum-config-manager \

--add-repo \

https://download.docker.com/linux/centos/docker-ce.repo

yum -y install docker-ce docker-ce-cli containerd.io

systemctl enable docker && systemctl start docker# docker 镜像加速 与 cgroup配置

mkdir -p /etc/dockertee /etc/docker/daemon.json <<-'EOF'

{

"exec-opts": ["native.cgroupdriver=systemd"],

"registry-mirrors": ["https://fl791z1h.mirror.aliyuncs.com"]

}

EOFsystemctl daemon-reload && systemctl restart docker# k8s安装

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOFyum -y install --nogpgcheck kubelet-1.23.8 kubeadm-1.23.8 kubectl-1.23.8# 启动k8s服务

systemctl enable kubelet && systemctl start kubelet

在边缘节点安装keadm

同理,先下载安装keadm,这个步骤跟云端一样,如下:

# 下载Keadm

wget https://github.com/kubeedge/kubeedge/releases/download/v1.12.1/keadm-v1.12.1-linux-amd64.tar.gz#解压

tar zxvf keadm-v1.12.1-linux-amd64.tar.gz

#添加执行权限

chmod +x keadm-v1.12.1-linux-amd64/keadm/keadm

#移动目录

mv keadm-v1.12.1-linux-amd64/keadm/keadm /usr/local/bin/

# 查看keadm是否安装

keadm version#输出版本信息

version: version.Info{Major:"1", Minor:"12", GitVersion:"v1.12.1", GitCommit:"919ad5378eaca3cb0c666c22a19db01261cbc9a6", GitTreeState:"clean", BuildDate:"2022-11-02T08:22:56Z", GoVersion:"go1.17", Compiler:"gc", Platform:"linux/amd64"}

两个node节点都安装了keadm

加入云节点管理

使用命令

#注意这里是要加入master的IP地址,token是master上四.2.1的步骤获取的

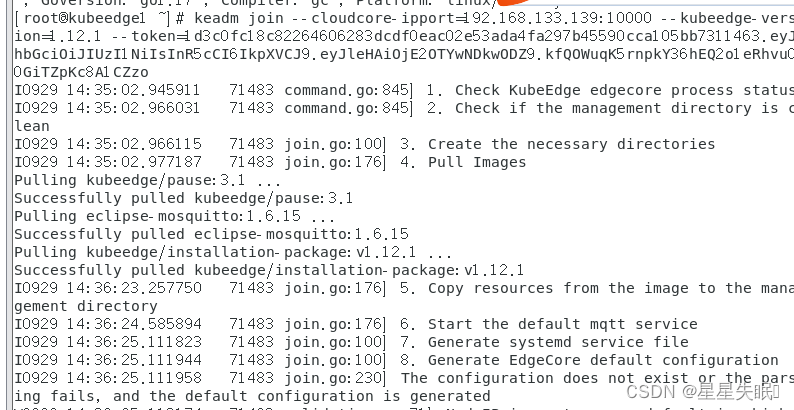

keadm join --cloudcore-ipport=192.168.133.139:10000 --kubeedge-version=1.12.1 --token=1d3c0fc18c82264606283dcdf0eac02e53ada4fa297b45590cca105bb7311463.eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJleHAiOjE2OTYwNDkwODZ9.kfQOWuqK5rnpkY36hEQ2o1eRhvu00GiTZpKc8A1CZzo

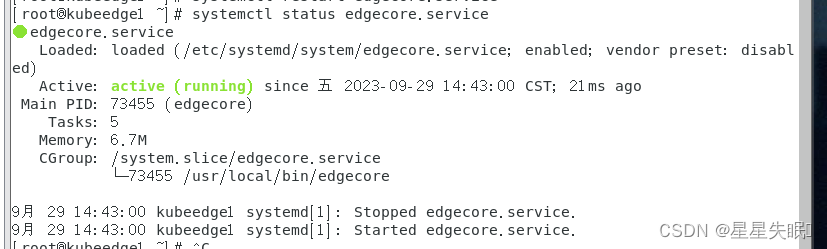

#启动edgecore

systemctl start edgecore #设置开机自启

systemctl enable edgecore.service #查看edgecore开机启动状态 enabled:开启, disabled:关闭

systemctl is-enabled edgecore#查看状态

systemctl status edgecore #查看日志

journalctl -u edgecore.service -b检查是否安装成功

出现问题

http://t.csdnimg.cn/bTYUh