C# 上位机--变量

在 C# 上位机开发领域,变量是构建程序逻辑的基础元素之一。它就像是一个容器,用于存储各种类型的数据,从简单的数值到复杂的对象。正确理解和使用变量,对于开发出高效、稳定且易于维护的上位机程序至关重要。本文将深入探讨 C# 上位机开发中变量的相关知识,并通过丰富的示例和图文说明,帮助读者更好地掌握这一关键概念。

一、变量的基本概念与声明

变量在 C# 中是用于存储数据值的标识符。在使用变量之前,需要先声明它,指定其数据类型。C# 支持多种数据类型,如整数类型(int)、浮点数类型(float、double)、字符类型(char)、布尔类型(bool)以及字符串类型(string)等。

例如,声明一个整数类型的变量 count 并初始化为 10:

int count = 10; 声明一个字符串类型的变量 message 并赋值为 "Hello, World!":

string message = "Hello, World!";在 Visual Studio 中,我们可以通过创建一个新的 C# 控制台应用程序来实践这些变量声明。以下是一个简单的示例代码:

using System;

class Program

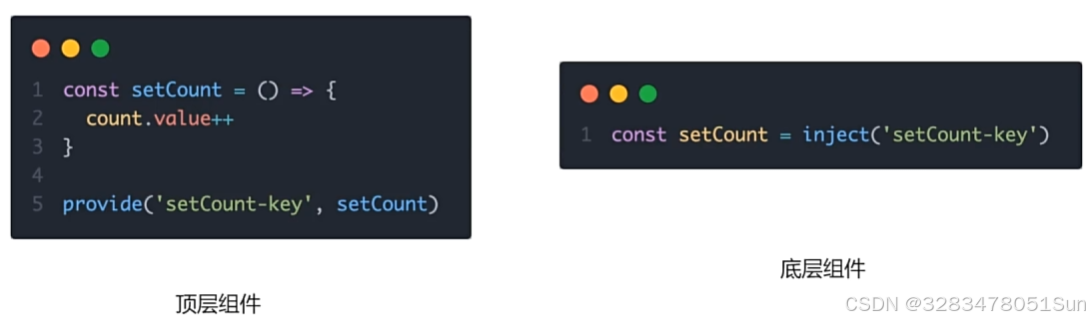

{static void Main(){int num = 5;double pi = 3.14159;string name = "Alice";bool isTrue = true;Console.WriteLine($"整数变量 num 的值为: {num}");Console.WriteLine($"浮点数变量 pi 的值为: {pi}");Console.WriteLine($"字符串变量 name 的值为: {name}");Console.WriteLine($"布尔变量 isTrue 的值为: {isTrue}");Console.ReadLine();}

}运行上述代码,在控制台中会输出各个变量的值,如下图所示:

二、变量的作用域

变量的作用域是指变量在程序中可以被访问的范围。在 C# 中,变量的作用域通常由其声明的位置决定。

- 局部变量:在方法内部声明的变量称为局部变量,其作用域仅限于该方法内部。例如:

using System;

class Program

{static void Main(){{int localVar = 20;Console.WriteLine($"局部变量 localVar 的值为: {localVar}");}// 尝试访问 localVar 会导致编译错误,因为它超出了作用域// Console.WriteLine(localVar); }

}在上述代码中,localVar 是在 Main 方法内部的一个代码块中声明的局部变量,当超出该代码块的范围后,就无法再访问它。

2.成员变量:在类中声明但在方法外部的变量称为成员变量,其作用域为整个类。成员变量又可以分为实例变量和静态变量。

using System;

class MyClass

{// 实例变量int instanceVar = 10;// 静态变量static int staticVar = 20;public void InstanceMethod(){Console.WriteLine($"实例变量 instanceVar 的值为: {instanceVar}");}public static void StaticMethod(){Console.WriteLine($"静态变量 staticVar 的值为: {staticVar}");}

}

class Program

{static void Main(){MyClass myObj = new MyClass();myObj.InstanceMethod();MyClass.StaticMethod();Console.ReadLine();}

}

在这个示例中,instanceVar 是实例变量,需要通过类的实例来访问;staticVar 是静态变量,可以通过类名直接访问。

三、变量的类型转换

在 C# 上位机开发中,经常需要对不同类型的变量进行转换。类型转换可以分为隐式转换和显式转换。

- 隐式转换:当源类型可以安全地转换为目标类型时,会发生隐式转换。例如,将

int类型转换为double类型:

int num = 10;

double result = num; // 隐式转换 2.显式转换:当源类型不能安全地转换为目标类型时,需要进行显式转换,也称为强制类型转换。例如,将 double 类型转换为 int 类型:

double num = 10.5;

int result = (int)num; // 显式转换,结果为 10在实际的上位机开发中,比如处理传感器数据时,可能会从设备接收到 double 类型的数据,但需要将其转换为 int 类型进行进一步的计算或显示。

四、变量在 C# 上位机开发中的应用实例

假设我们正在开发一个监控设备温度的上位机程序,设备通过串口发送温度数据(以字符串形式),我们需要将其解析并存储在变量中进行处理。

using System;

using System.IO.Ports;

class TemperatureMonitor

{private SerialPort serialPort;public TemperatureMonitor(){serialPort = new SerialPort("COM1", 9600);serialPort.DataReceived += SerialPort_DataReceived;serialPort.Open();}private void SerialPort_DataReceived(object sender, SerialDataReceivedEventArgs e){string receivedData = serialPort.ReadLine();double temperature;if (double.TryParse(receivedData, out temperature)){Console.WriteLine($"接收到的温度值为: {temperature} 摄氏度");// 可以在这里对温度值进行进一步处理,比如与阈值比较等}else{Console.WriteLine("无法解析接收到的数据");}}public void Close(){serialPort.Close();}

}

class Program

{static void Main(){TemperatureMonitor monitor = new TemperatureMonitor();Console.WriteLine("温度监控程序已启动,按任意键退出...");Console.ReadKey();monitor.Close();}

}

在上述代码中,receivedData 是一个字符串类型的变量,用于存储从串口接收到的数据。temperature 是一个 double 类型的变量,用于存储解析后的温度值。通过 double.TryParse 方法,我们尝试将接收到的字符串数据转换为 double 类型,并进行相应的处理。

五、总结

变量作为 C# 上位机开发的基础元素,贯穿于整个程序的逻辑之中。从基本的变量声明、作用域的理解,到类型转换的应用,再到实际项目中的使用,都需要开发者熟练掌握。合理地使用变量,可以使程序更加高效、稳定,并且易于维护和扩展。希望本文的内容能够帮助读者更好地理解和应用 C# 上位机开发中的变量,在实际的项目开发中取得更好的成果。

以上就是关于 C# 上位机变量的详细介绍,如有任何疑问或建议,欢迎在评论区留言交流,333。

请大家一健3连,必回关!

![[学习笔记] Kotlin Compose-Multiplatform](https://img-home.csdnimg.cn/images/20230724024159.png?origin_url=compose.assets%2Ftooltips.gif&pos_id=img-JR8Vi11g-1738845957167)