文章目录

- 一、简介

- 二、安装

- 1、简介

- 2、本地部署(Local模式)

- 2.1 安装

- 2.2 官方WordCount实例

- 3、Standlong模式

- 3.1 简介

- 2.2 安装集群

- 2.3 官方测试案例

- 4、Yarn模式

- 3.1 安装

- 3.2 配置历史服务器

- 3.3 配置查看历史日志

- 5、Mesos模式

- 6、几种模式对比

- 7、常用端口

- 三、Yarn模式详解

- 1、简介

- 2、Client模式

- 3、Cluster模式

一、简介

1)官网地址:http://spark.apache.org/

2)文档查看地址:https://spark.apache.org/docs/3.1.3/

3)下载地址:https://spark.apache.org/downloads.html

https://archive.apache.org/dist/spark/

二、安装

1、简介

部署Spark集群大体上分为两种模式:单机模式与集群模式

大多数分布式框架都支持单机模式,方便开发者调试框架的运行环境。但是在生产环境中,并不会使用单机模式。因此,后续直接按照集群模式部署Spark集群。

下面详细列举了Spark目前支持的部署模式。

- Local模式:在本地部署单个Spark服务

- Standalone模式:Spark自带的任务调度模式。(国内常用)

- YARN模式:Spark使用Hadoop的YARN组件进行资源与任务调度。(国内最常用)

- Mesos模式:Spark使用Mesos平台进行资源与任务的调度。(国内很少用)

2、本地部署(Local模式)

2.1 安装

Local模式就是运行在一台计算机上的模式,通常就是用于在本机上练手和测试。

wget https://gitcode.net/weixin_44624117/software/-/raw/master/software/Linux/Spark/spark-3.4.1-bin-hadoop3.tgz

创建文件夹

mkdir /opt/module

解压文件

tar -zxvf spark-3.4.1-bin-hadoop3.tgz -C /opt/module/

更改文件名

mv /opt/module/spark-3.4.1-bin-hadoop3/ /opt/module/spark-local

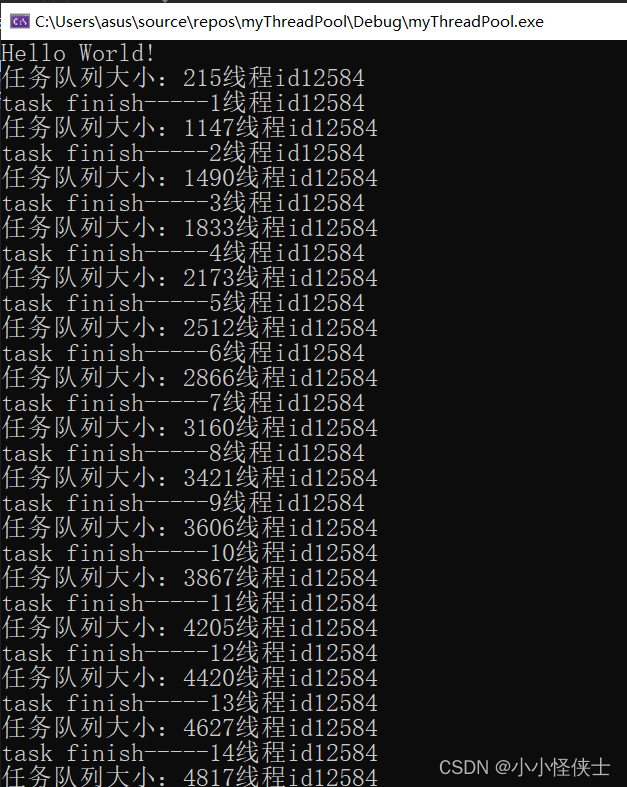

官方求PI案例

cd /opt/module/spark-localbin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master local[2] \

./examples/jars/spark-examples_2.12-3.4.1.jar \

10

参数解析:

--class:表示要执行程序的主类;--master local[2]:

(1)local: 没有指定线程数,则所有计算都运行在一个线程当中,没有任何并行计算

(2)local[K]:指定使用K个Core来运行计算,比如local[2]就是运行2个Core来执行。

(3)local[*]:默认模式。自动帮你按照CPU最多核来设置线程数。比如CPU有8核,Spark帮你自动设置8个线程计算。

spark-examples_2.12-3.1.3.jar:要运行的程序;10:要运行程序的输入参数(计算圆周率π的次数,计算次数越多,准确率越高);

该算法是利用蒙特·卡罗算法求PI

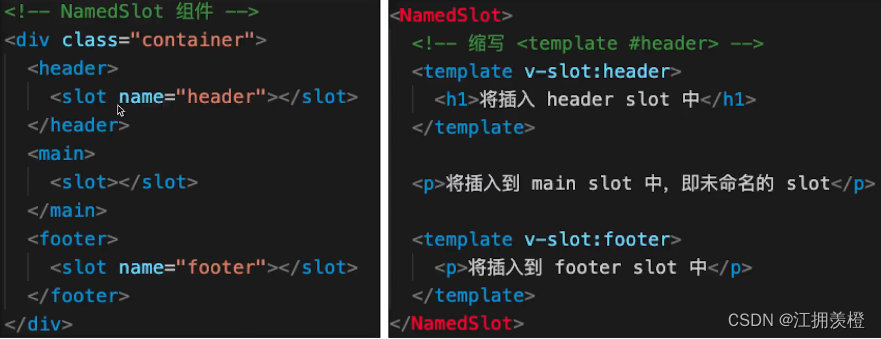

2.2 官方WordCount实例

准备数据

mkdir input

输入以下内容

hello atguigu

hello spark

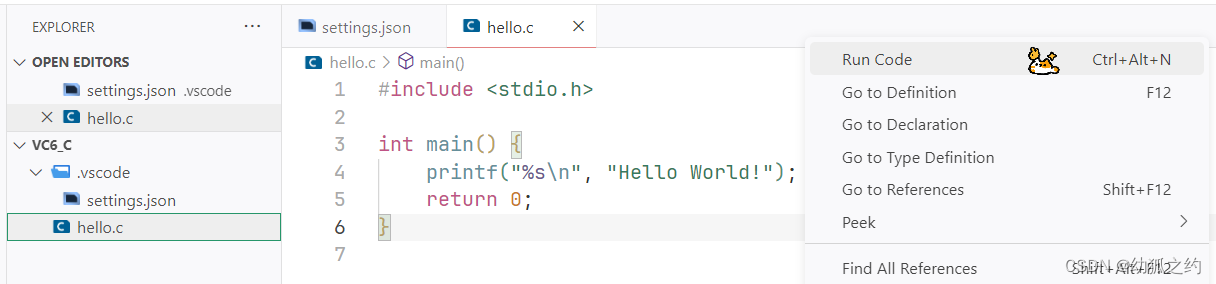

启动Spark-shell

bin/spark-shell

执行任务

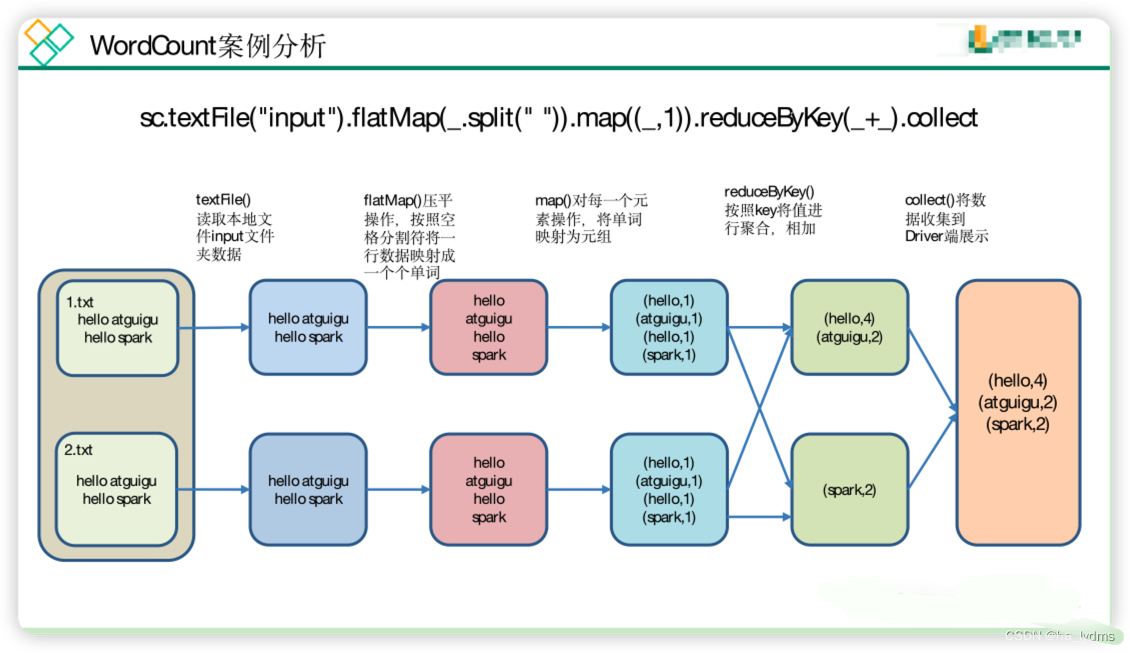

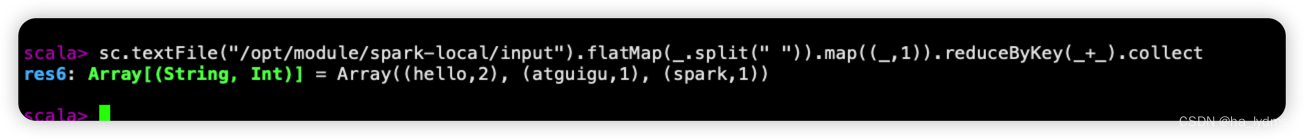

scala> sc.textFile("/opt/module/spark-local/input").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect

res6: Array[(String, Int)] = Array((hello,2), (atguigu,1), (spark,1))

查看执行结果:

连接窗口,发现了一个SparkSubmit进程

spark-shell窗口关闭掉,则hadoop102:4040页面关闭。

3、Standlong模式

3.1 简介

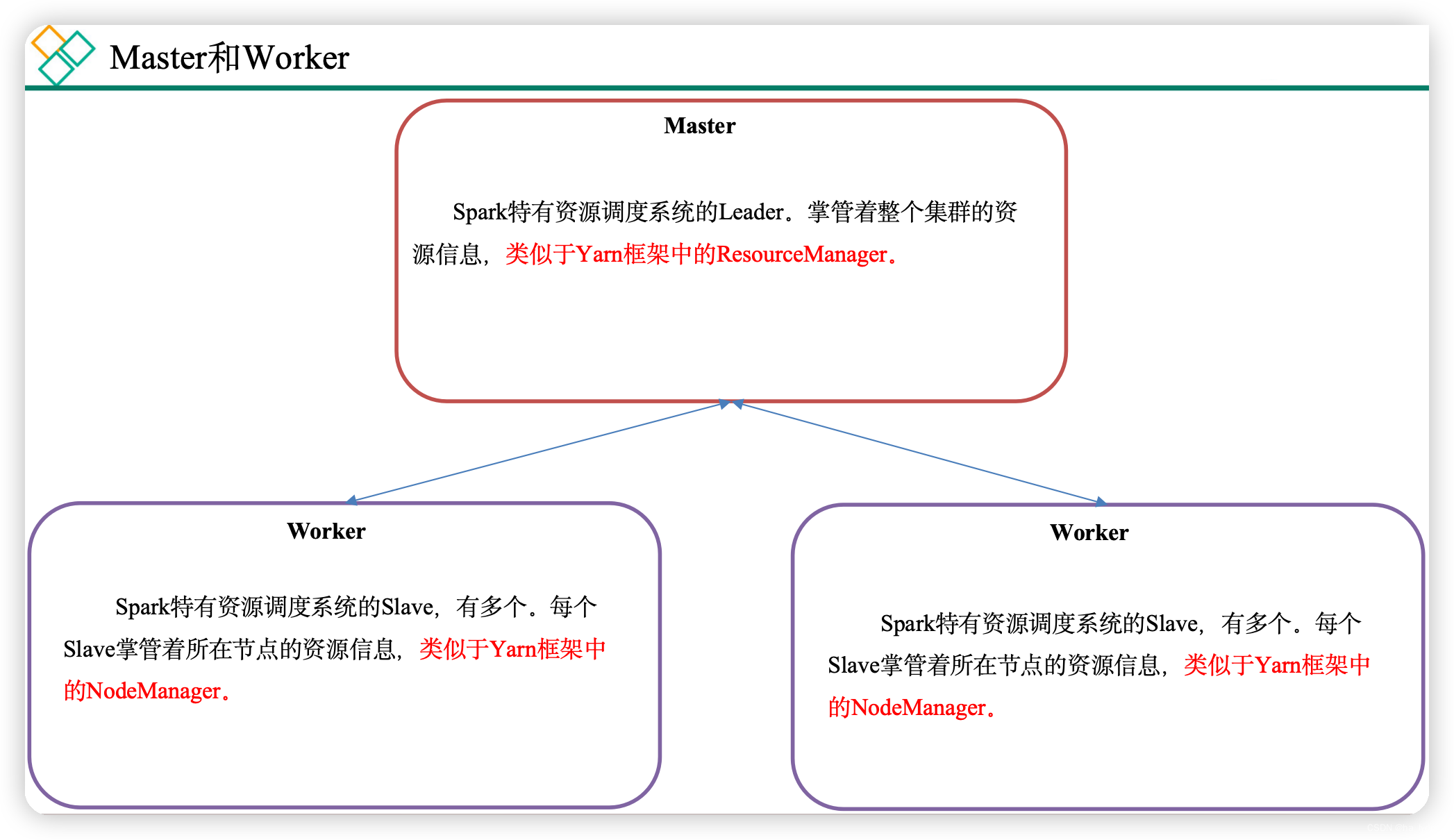

Standalone模式是Spark自带的资源调度引擎,构建一个由Master + Worker构成的Spark集群,Spark运行在集群中。

这个要和Hadoop中的Standalone区别开来。这里的Standalone是指只用Spark来搭建一个集群,不需要借助Hadoop的Yarn和Mesos等其他框架。

Master和Worker是Spark的守护进程、集群资源管理者,即Spark在特定模式(Standalone)下正常运行必须要有的后台常驻进程。

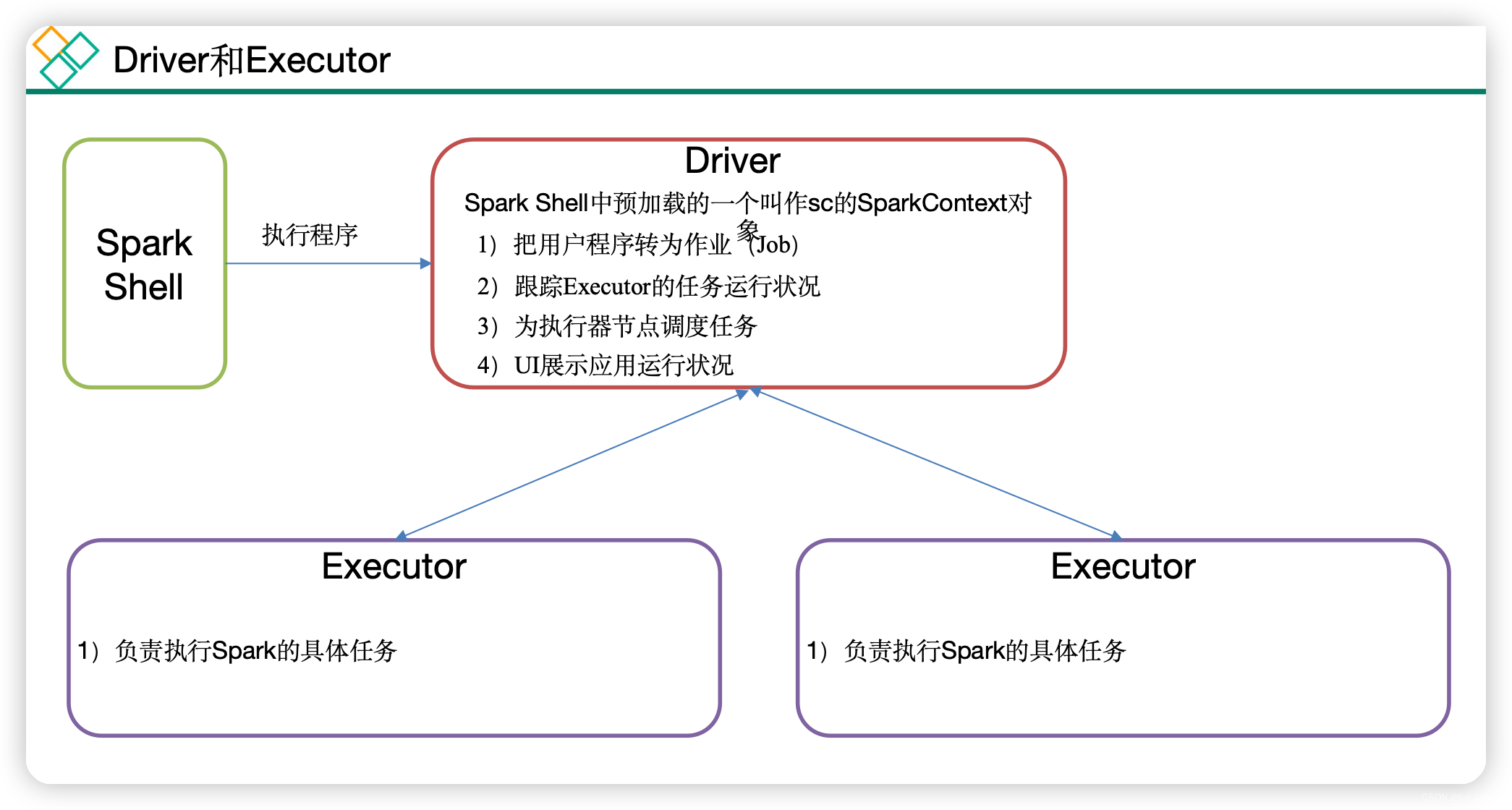

- Driver和Executor是临时程序,当有具体任务提交到Spark集群才会开启的程序。Standalone模式是Spark自带的资源调度引擎,构建一个由Master + Worker构成的Spark集群,Spark运行在集群中。

- 这个要和Hadoop中的Standalone区别开来。这里的Standalone是指只用Spark来搭建一个集群,不需要借助Hadoop的Yarn和Mesos等其他框架。

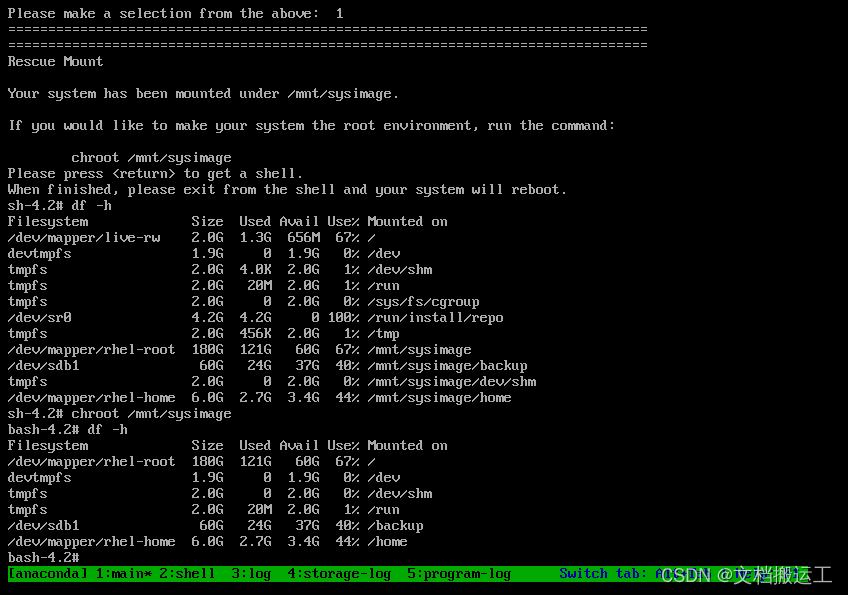

2.2 安装集群

| Hadoop101 | Hadoop102 | Hadoop103 | |

|---|---|---|---|

| Spark | MasterWorker | Worker | Worker |

解压文件

tar -zxvf spark-3.4.1-bin-hadoop3.tgz -C /opt/module/

重命名文件夹

mv /opt/module/spark-3.4.1-bin-hadoop3 /opt/module/spark-standalone

添加Worker节点

cd /opt/module/spark-standalone/conf/

vim slaves

hadoop101

hadoop102

hadoop103

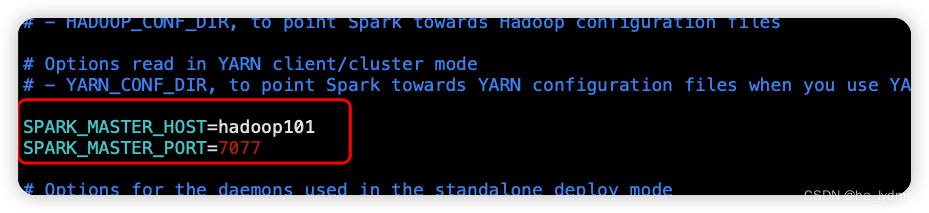

添加Master节点

mv spark-env.sh.template spark-env.sh

vim spark-env.sh

SPARK_MASTER_HOST=hadoop101

SPARK_MASTER_PORT=7077

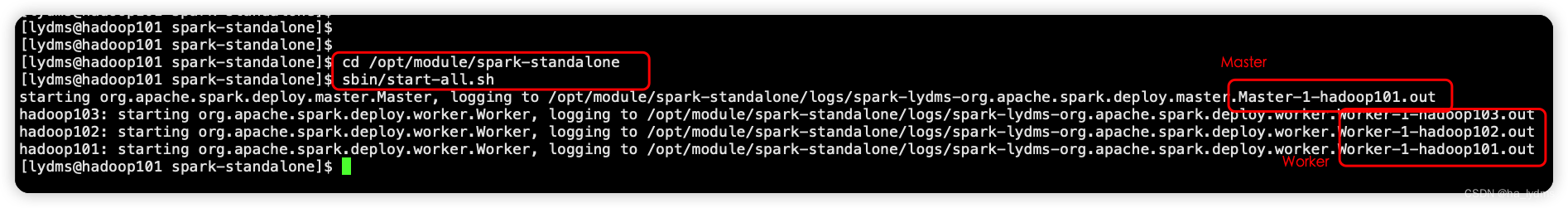

cd /opt/module/spark-standalone

sbin/start-all.sh

查看页面:http://hadoop101:8080

-

8080:master的webUI

-

4040:application的webUI的端口号

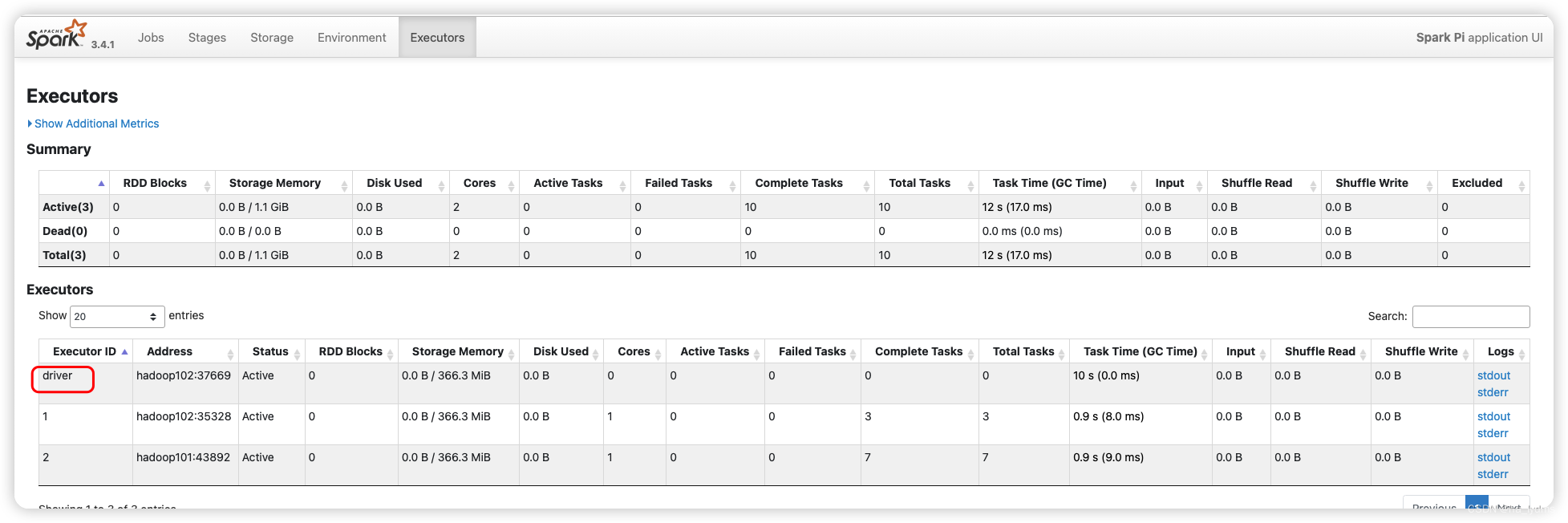

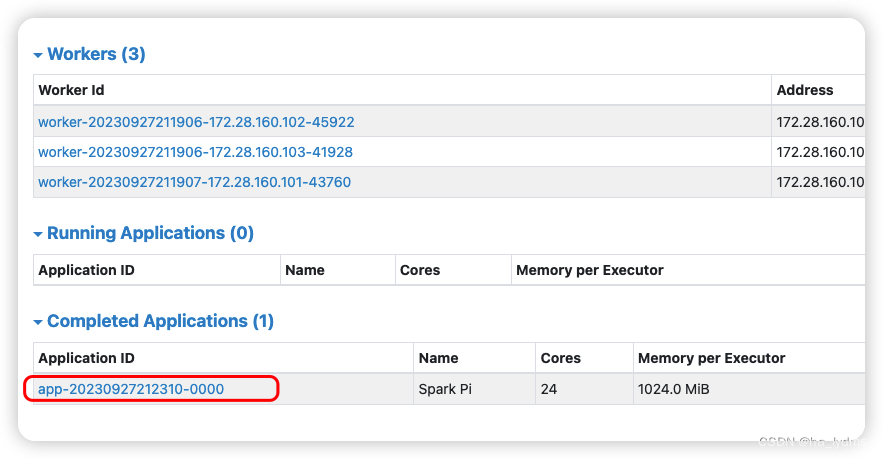

2.3 官方测试案例

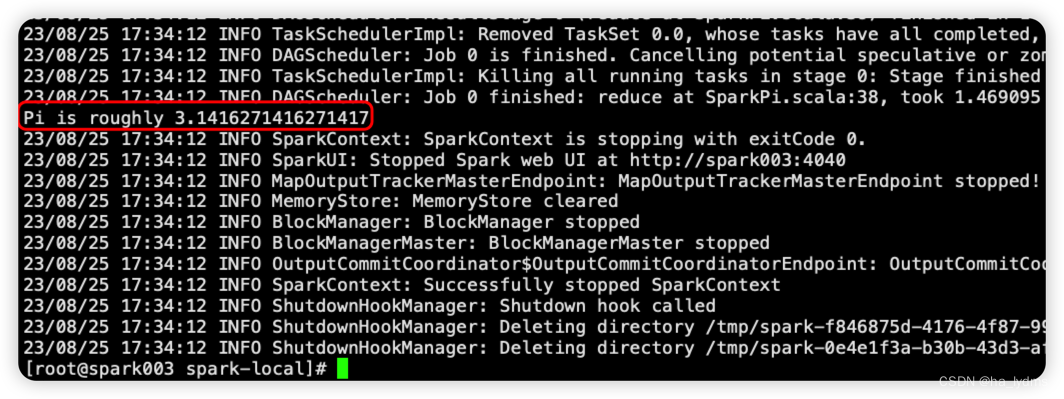

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://hadoop101:7077 \

./examples/jars/spark-examples_2.12-3.4.1.jar \

10

执行结果:

8080:master的webUI

4040:application的webUI的端口号

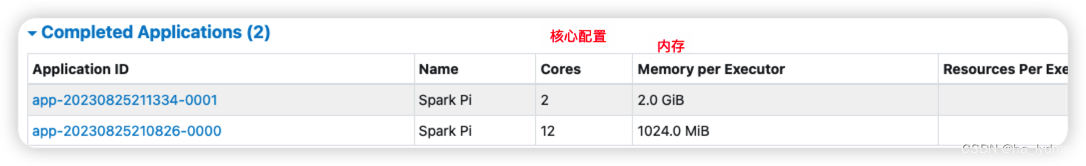

执行参数

./bin/spark-submit \--class org.apache.spark.examples.SparkPi \--master spark://hadoop102:7077 \--executor-memory 2G \--total-executor-cores 2 \./examples/jars/spark-examples_2.12-3.4.1.jar \

10

参数解析

--executor-memory:可用内存为2G。--total-executor-cores:使用CPU核数为2个。

| 参数 | 解释 | 可选值举例 |

|---|---|---|

| –class | Spark程序中包含主函数的类 | |

| –master | Spark程序运行的模式 | 本地模式:local[*]、spark://hadoop102:7077、Yarn |

| –executor-memory 1G | 指定每个executor可用内存为1G | 符合集群内存配置即可,具体情况具体分析。 |

| –total-executor-cores 2 | 指定所有executor使用的cpu核数为2个 | |

| application-jar | 打包好的应用jar,包含依赖。这个URL在集群中全局可见。 比如hdfs:// 共享存储系统,如果是file:// path,那么所有的节点的path都包含同样的jar | |

| application-arguments | 传给main()方法的参数 |

4、Yarn模式

- Spark客户端直接连接Yarn,不需要额外构建Spark集群。

- 一台能提交Yarn的服务器即可

3.1 安装

获取文件

wget https://gitcode.net/weixin_44624117/software/-/raw/master/software/Linux/Spark/spark-3.4.1-bin-hadoop3.tgz

加压安装包

tar -zxvf spark-3.4.1-bin-hadoop3.tgz -C /opt/module/

修改目录名称

mv /opt/module/spark-3.4.1-bin-hadoop3 /opt/module/spark-yarn

修改启动文件

mv /opt/module/spark-yarn/conf/spark-env.sh.template /opt/module/spark-yarn/conf/spark-env.sh

添加配置文件

vim /opt/module/spark-yarn/conf/spark-env.sh

# 增加配置内容(Yarn配置文件地址)

YARN_CONF_DIR=/opt/module/hadoop-3.1.3/etc/hadoop

提交任务

参数:--master yarn:表示Yarn方式运行;–deploy-mode表示客户端方式运行程序

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

./examples/jars/spark-examples_2.12-3.4.1.jar \

10

3.2 配置历史服务器

移动配置文件

mv /opt/module/spark-yarn/conf/spark-defaults.conf.template /opt/module/spark-yarn/conf/spark-defaults.conf

修改配置文件

cd /opt/module/spark-yarn/conf

vim spark-defaults.conf

spark.eventLog.enabled true

spark.eventLog.dir hdfs://hadoop101:8020/directory

修改配置文件spark-env.sh

vim spark-env.sh

export SPARK_HISTORY_OPTS="

-Dspark.history.ui.port=18080

-Dspark.history.fs.logDirectory=hdfs://hadoop101:8020/directory

-Dspark.history.retainedApplications=30"

配置文件解析:

Dspark.history.ui.port=18080:WEBUI访问的端口号为18080-Dspark.history.fs.logDirectory:指定历史服务器日志存储路径(读)-Dspark.history.retainedApplications:指定保存Application历史记录的个数,如果超过这个值,旧的应用程序信息将被删除,这个是内存中的应用数,而不是页面上显示的应用数。

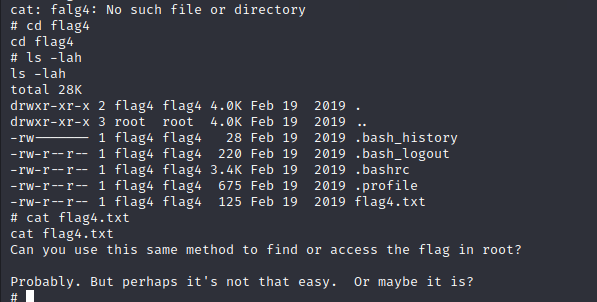

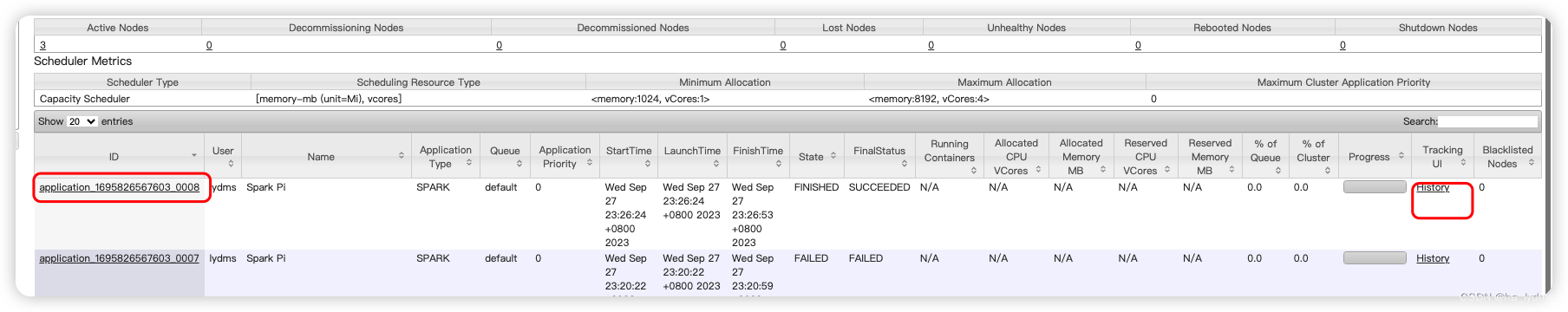

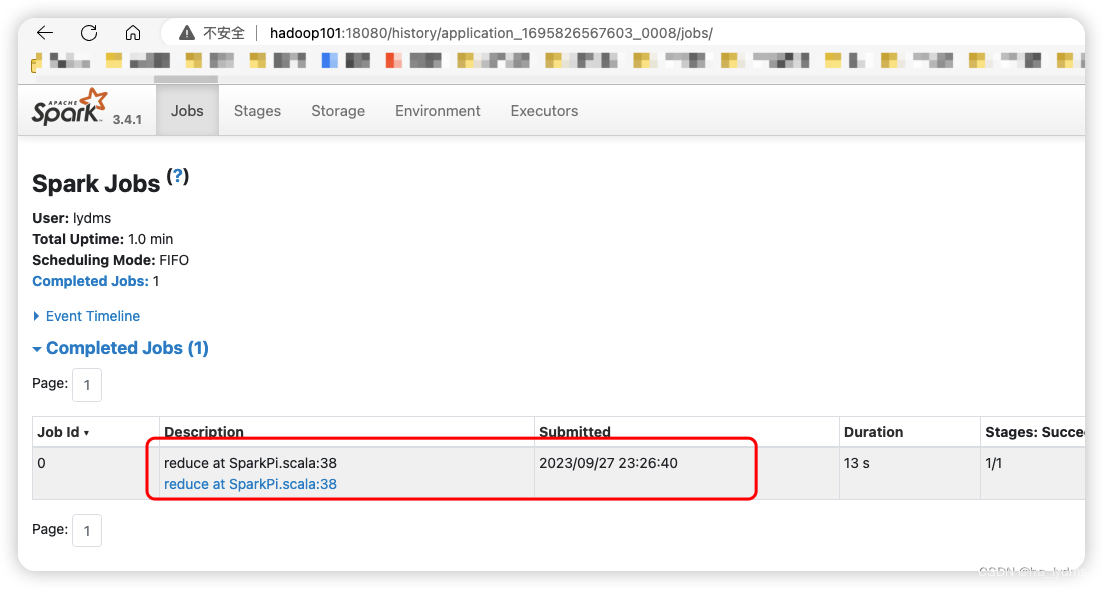

3.3 配置查看历史日志

为了能从Yarn上关联到Spark历史服务器,需要配置spark历史服务器关联路径。

目的:点击yarn(8088)上spark任务的history按钮,进入的是spark历史服务器(18080),而不再是yarn历史服务器(19888)。

修改配置文件/opt/module/spark-yarn/conf/spark-defaults.conf

vim /opt/module/spark-yarn/conf/spark-defaults.conf

spark.yarn.historyServer.address=hadoop101:18080

spark.history.ui.port=18080

启动历史服务器

cd /opt/module/spark-yarn

sbin/start-history-server.sh

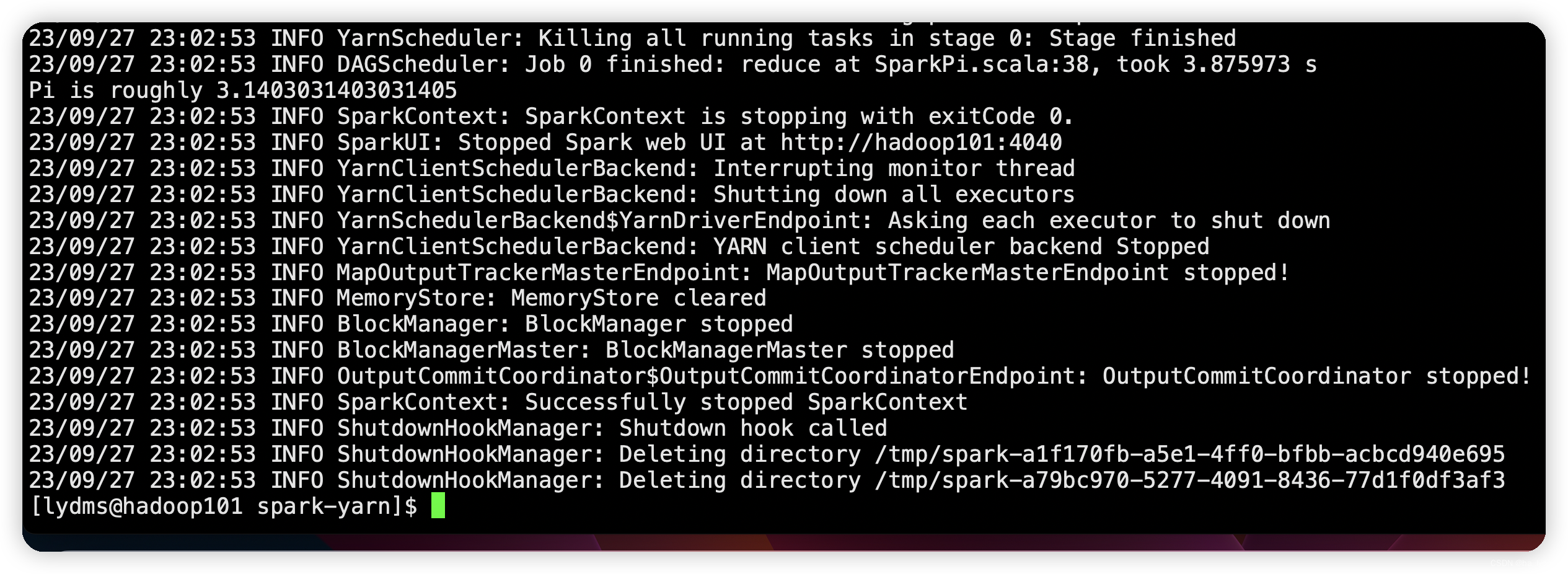

再次提交任务

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

./examples/jars/spark-examples_2.12-3.4.1.jar \

10

页面查看历史任务:http://hadoop102:8088/cluster

5、Mesos模式

Spark客户端直接连接Mesos;不需要额外构建Spark集群。国内应用比较少,更多的是运用Yarn调度。

6、几种模式对比

| 模式 | Spark安装机器数 | 需启动的进程 | 所属者 |

|---|---|---|---|

| Local | 1 | 无 | Spark |

| Standalone | 3 | Master及Worker | Spark |

| Yarn | 1 | Yarn及HDFS | Hadoop |

7、常用端口

4040:Spark查看当前Spark-shell运行任务情况端口号:40407077:Spark Master内部通信服务端口号:7077 (类比于yarn的8032(RM和NM的内部通信)端口)8080:Spark Standalone模式Master Web端口号:8080(类比于Hadoop YARN任务运行情况查看端口号:8088) (yarn模式) 898918080:Spark历史服务器端口号:18080 (类比于Hadoop历史服务器端口号:19888)

三、Yarn模式详解

1、简介

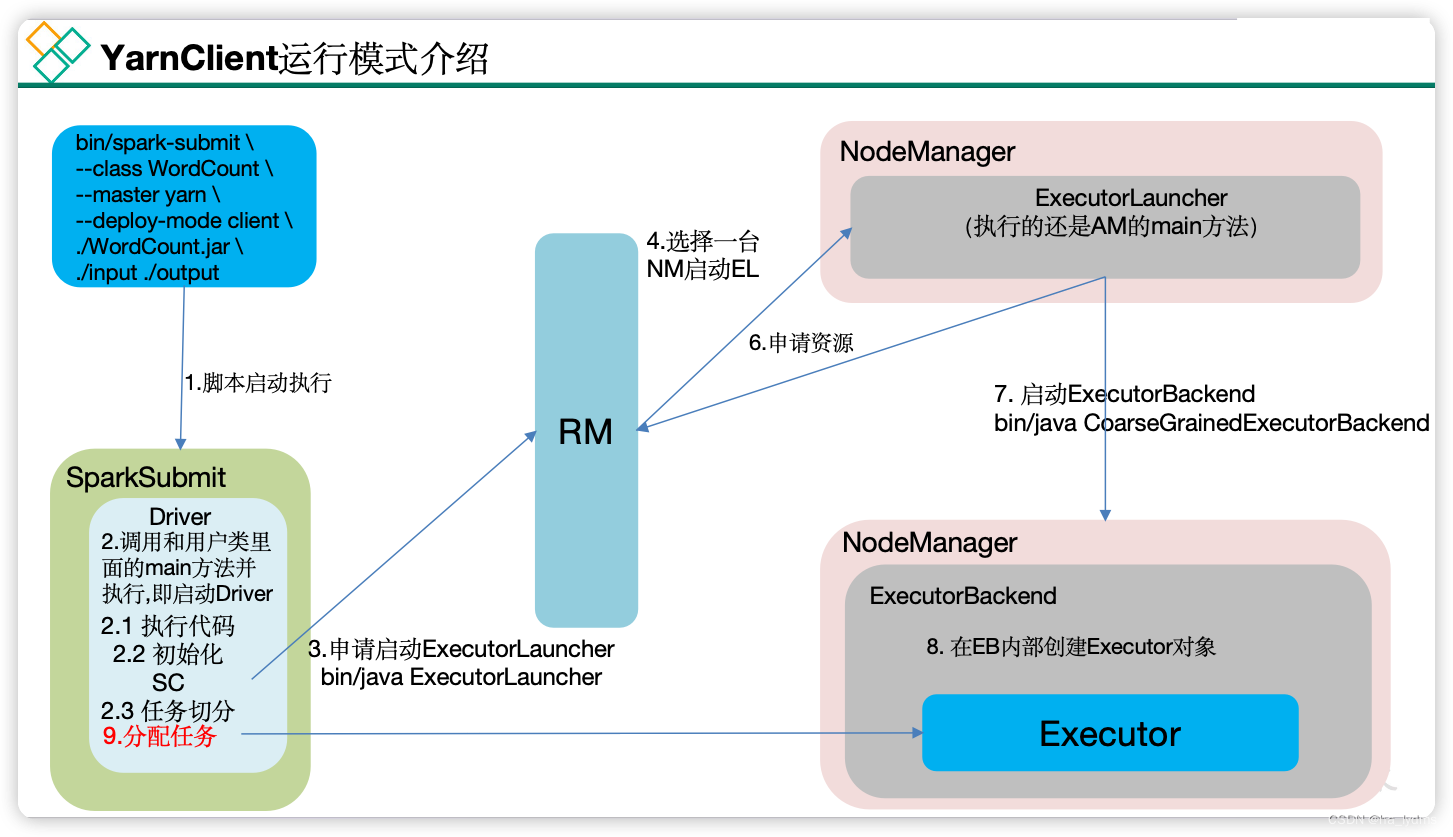

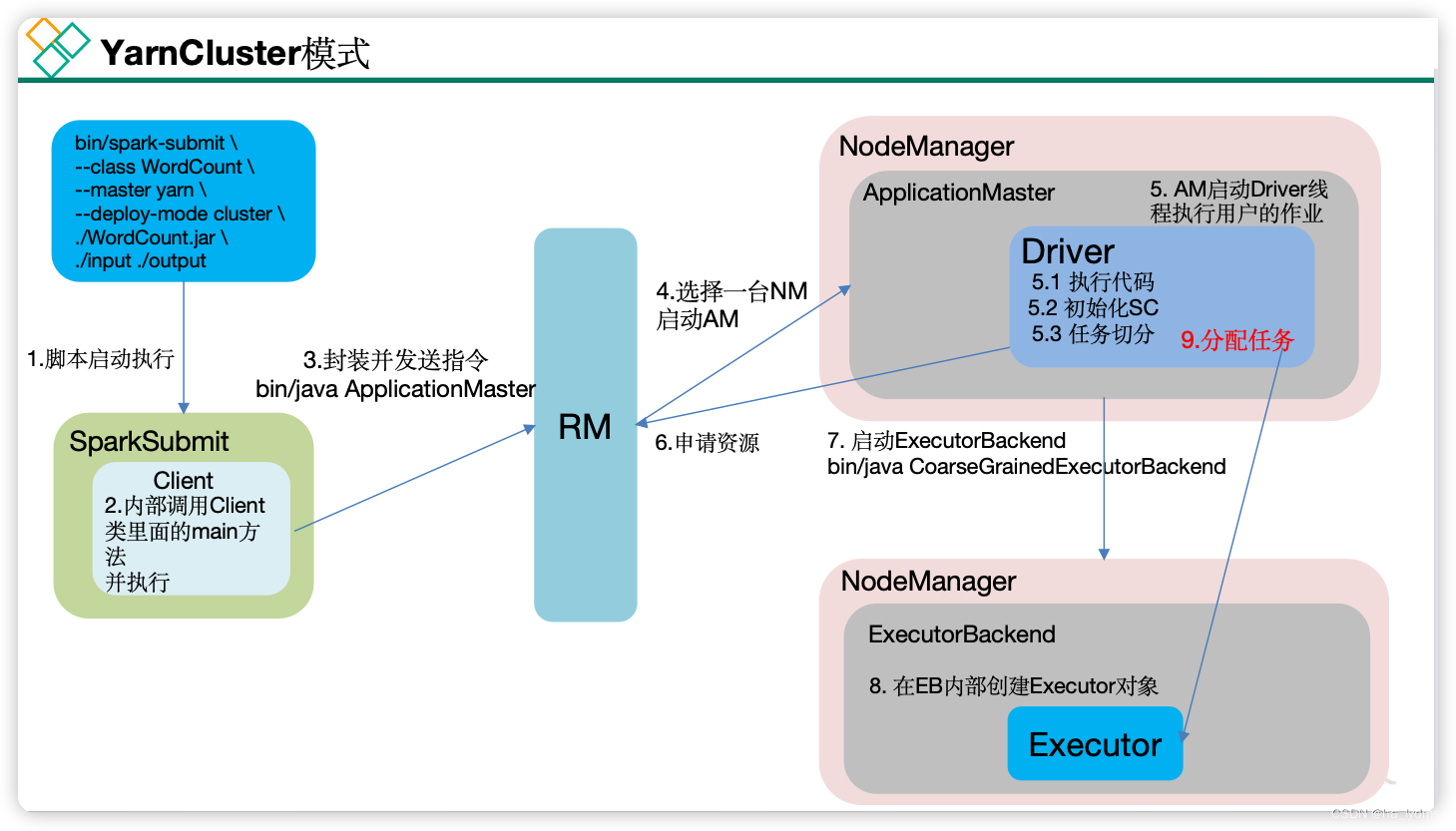

Spark有yarn-client和yarn-cluster两种模式,主要区别在于:Driver程序的运行节点。

yarn-client:Driver程序运行在客户端,适用于交互、调试,希望立即看到app的输出。

yarn-cluster:Driver程序运行在由ResourceManager启动的APPMaster,适用于生产环境。

2、Client模式

client模式启动

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode client \

./examples/jars/spark-examples_2.12-3.4.1.jar \

10

3、Cluster模式

cluster模式启动

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode cluster \

./examples/jars/spark-examples_2.12-3.4.1.jar \

10