来源:机器之心

统计了近三年引用量最高的 100 篇论文,我们发现……

谁在发表最具影响力的 AI 研究?在如今「百花齐放」的时代,这个问题极具挖掘空间。

你可能会猜到一些结论:比如谷歌、微软、OpenAI、DeepMind 这些顶级机构,类似这样的结论只猜对了一半,还有另外一些信息,向我们揭露了原本不为人知的结论。

随着 AI 创新的飞速发展,尽快获取一些「情报」是至关重要的。毕竟几乎没人有时间去阅读所有的东西,但可以肯定的是,本文整理的这些论文具备改变人工智能技术发展方向的潜力。

对研发团队影响力的真正考验当然是技术如何落地在产品中,OpenAI 在 2022 年 11 月底发布了 ChatGPT,震撼了整个领域,这是继他们 2022 年 3 月的论文「利用人类反馈训练遵循指令的语言模型」(Training language models to follow instructions with human feedback)之后的又一次突破。

如此迅速的产品落地是罕见的。所以,为了洞察到更多信息,近日,Zeta Alpha 的统计采用了一个经典的学术指标:引用次数。

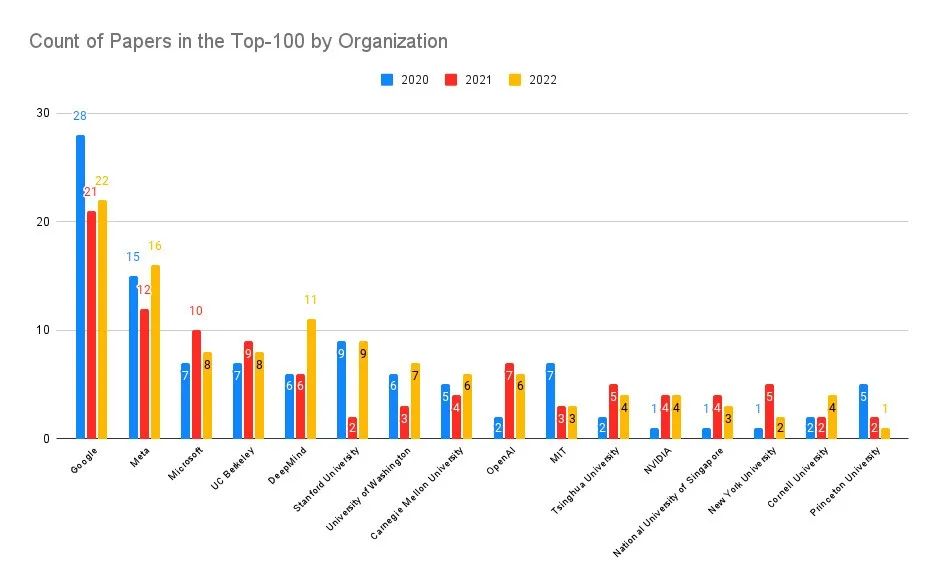

对 2022 年、2021 年和 2020 年每年被引用次数最多的 100 篇论文的详细分析,可以深入了解目前发表最具影响力的 AI 研究的机构和国家 / 地区。一些初步结论是:美国和谷歌仍然占主导地位,DeepMind 在这一年也取得了辉煌的成就,但考虑到产出量,OpenAI 在产品影响和研究方面确实处于前列,并能快速和广泛地被引用。

资料来源:Zeta Alpha。

如上图所示,另外一个重要结论是:中国在研究引用量上的影响力排行第二,但与美国相比仍存在差距,并不像很多报道中描述的那样「追平甚至超越」。

利用来自 Zeta Alpha 平台的数据,然后结合人工策划,本文收集了 2022 年、2021 年和 2020 年人工智能领域被引用次数最多的论文,并分析了作者的所属机构和国家 / 地区。这使得能够按照研发影响而不是纯粹的出版数据对这些论文进行排名。

为了创建分析结果,本文首先在 Zeta Alpha 平台上收集了每年被引用次数最多的论文,然后手动检查首次发表日期(通常是 arXiv 预印本),以便将论文放在正确的年份中。然后通过在 Semantic Scholar 上挖掘高引用率的人工智能论文来补充这个名单,因为 Semantic Scholar 的覆盖面更广,而且能够按引用次数排序。这主要是发现了来自高影响力的出版商(如 Nature、Elsevier、Springer 和其他期刊)之外的论文。然后,将每篇论文在谷歌学术上的引用次数作为代表指标,并按这个数字对论文进行排序,得出一年中的前 100 名。对于这些论文,本文使用了 GPT-3 来提取作者、隶属机构和国家 / 地区,并手动检查这些结果(如果国家 / 地区在出版物中不明显,就采用该组织总部所在的国家 / 地区)。如果一篇论文有来自多个机构的作者,每个机构算一次。

看了这份排行榜之后,大佬 Yann LeCun 表示很欣慰:「在 Meta AI,我们倾向于出版质量而不是数量。这就是为什么在 2022 年被引用最多的 100 篇人工智能论文中,Meta AI 撰写(或共同撰写)了 16 篇,仅次于谷歌的 22 篇,排名第二。我们的研究正在对社会产生巨大的影响。(此外,纽约大学的排名也很赞)。」

所以,刚才谈论的这些 Top 论文有哪些?

在深入了解这些数字之前,让我们先了解一下过去三年的热门论文。相信你会认出其中的几篇。

2022 年热门论文

1、AlphaFold Protein Structure Database: massively expanding the structural coverage of protein-sequence space with high-accuracy models

论文链接:https://academic.oup.com/nar/article/50/D1/D439/6430488

机构:DeepMind

引用次数:1372

主题:Using AlphaFold to augment protein structure database coverage.

2、ColabFold: making protein folding accessible to all

论文链接:https://www.nature.com/articles/s41592-022-01488-1

引用次数:1162

主题:An open-source and efficient protein folding model.

3、Hierarchical Text-Conditional Image Generation with CLIP Latents

论文链接:https://arxiv.org/abs/2204.06125

机构:OpenAI

引用次数:718

主题:DALL・E 2, complex prompted image generation that left most in awe

4、A ConvNet for the 2020s

论文链接:https://arxiv.org/abs/2201.03545

机构:Meta,UC 伯克利

引用次数:690

主题:A successful modernization of CNNs at a time of boom for Transformers in Computer Vision

5、PaLM: Scaling Language Modeling with Pathways

论文链接:https://arxiv.org/abs/2204.02311

机构:谷歌

引用次数:452

主题:Google's mammoth 540B Large Language Model, a new MLOps infrastructure, and how it performs

2021 年热门论文

1、《Highly accurate protein structure prediction with AlphaFold》

论文链接:https://www.nature.com/articles/s41586-021-03819-2

机构:DeepMind

引用次数:8965

主题:AlphaFold, a breakthrough in protein structure prediction using Deep Learning

2、《Swin Transformer: Hierarchical Vision Transformer using Shifted Windows》

论文链接:https://arxiv.org/abs/2103.14030

机构:微软

引用次数:4810

主题:A robust variant of Transformers for Vision

3、《Learning Transferable Visual Models From Natural Language Supervision》

论文链接:https://arxiv.org/abs/2103.00020

机构:OpenAI

引用次数:3204

主题:CLIP, image-text pairs at scale to learn joint image-text representations in a self supervised fashion

4、《On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?》

论文链接:https://dl.acm.org/doi/10.1145/3442188.3445922

机构:U. Washington, Black in AI, The Aether

引用次数:1266

主题:Famous position paper very critical of the trend of ever-growing language models, highlighting their limitations and dangers

5、《Emerging Properties in Self-Supervised Vision Transformers》

论文链接:https://arxiv.org/pdf/2104.14294.pdf

机构:Meta

引用次数:1219

主题:DINO, showing how self-supervision on images led to the emergence of some sort of proto-object segmentation in Transformers

2020 年热门论文

1、《An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale》

论文链接:https://arxiv.org/abs/2010.11929

机构:谷歌

引用次数:11914

主题:The first work showing how a plain Transformer could do great in Computer Vision

2、《Language Models are Few-Shot Learners》

论文链接:https://arxiv.org/abs/2005.14165

机构:OpenAI

引用次数:8070

主题:This paper does not need further explanation at this stage

3、《YOLOv4: Optimal Speed and Accuracy of Object Detection》

论文链接:https://arxiv.org/abs/2004.10934

机构:Academia Sinica, Taiwan

引用次数:8014

主题:Robust and fast object detection sells like hotcakes

4、《Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer》

论文链接:https://arxiv.org/abs/1910.10683

机构:谷歌

引用次数:5906

主题:A rigorous study of transfer learning with Transformers, resulting in the famous T5

5、《Bootstrap your own latent: A new approach to self-supervised Learning》

论文链接:https://arxiv.org/abs/2006.07733

机构:DeepMind,Imperial College

引用次数:2873

主题:Showing that negatives are not even necessary for representation learning

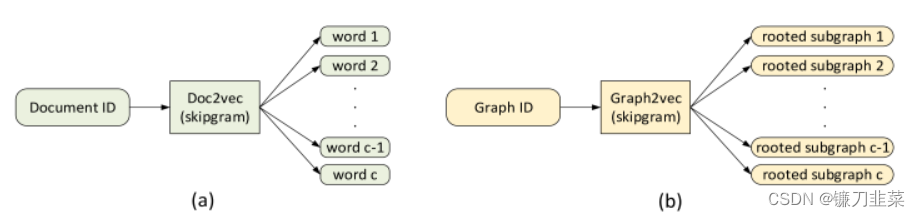

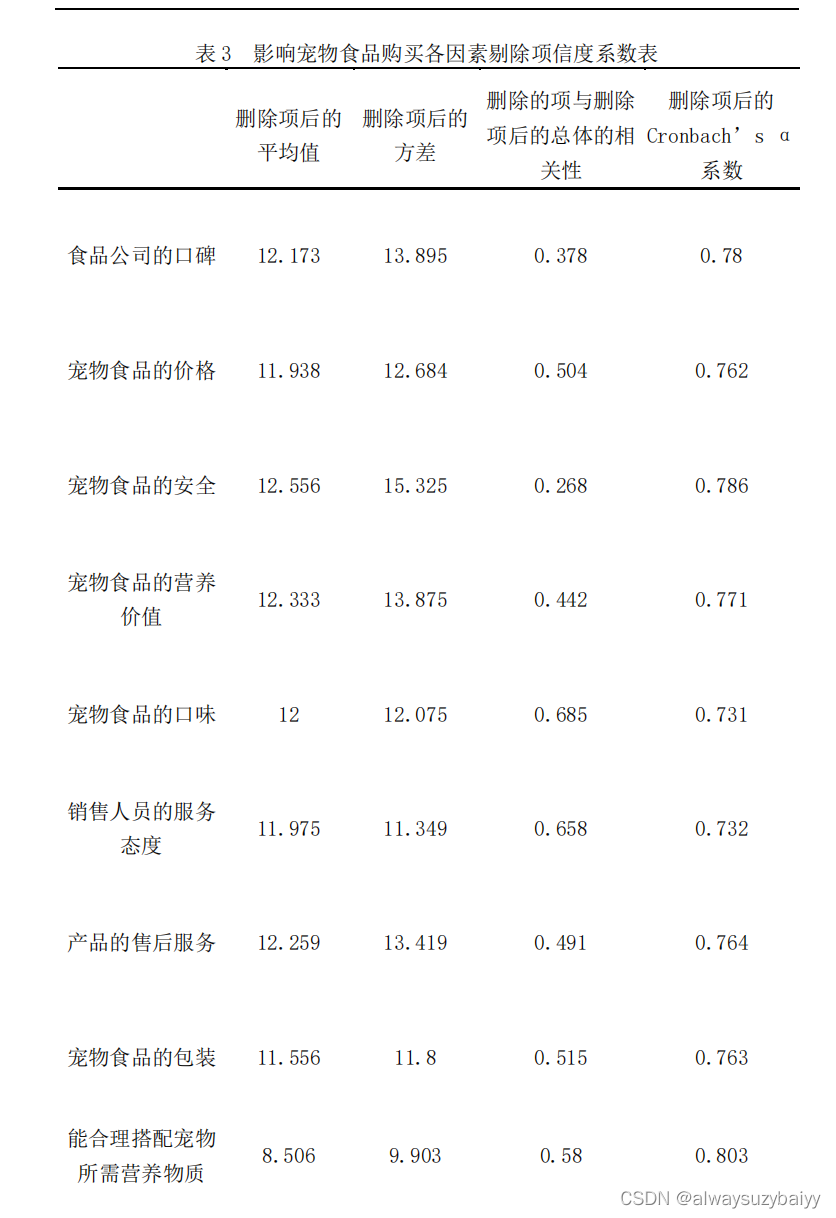

领先机构排行

让我们来看看一些领先的机构在前 100 名的论文数量上是如何排行的:

谷歌一直是最强大的参与者,其次是 Meta、微软、加州大学伯克利分校、DeepMind 和斯坦福。虽然如今的工业界在人工智能研究中「呼风唤雨」,单一的学术机构不会产生那么大的影响,但这些机构的尾巴要长得多,所以当我们按组织类型进行汇总时,就会达到平衡。

在研究总量方面,过去三年谷歌居首位,清华大学、卡耐基梅隆大学、麻省理工学院、斯坦福大学等高校排名靠前,而微软位居第三位。整体来看,学术机构的研究数量是要多于业界科技企业的,而谷歌、微软这两大科技巨头近三年发表的研究数也是居于高位。

实际上,谷歌的科研实力一直很强。2017 年,谷歌发表论文《Attention Is All You Need》,标志着 transformer 的问世。直到今天,transformer 依然是包括 ChatGPT 在内的大部分 NLP 和 CV 模型的架构基础。

上个月,在 Bard 发布之际,谷歌 CEO Sundar Pichai 也在一份公开信中表示:「Google AI 和 DeepMind 推动了最先进技术的发展。我们的 Transformer 研究项目和我们 2017 年的领域论文,以及我们在扩散模型方面的重要进展,是当前许多生成式 AI 应用程序的基础。」

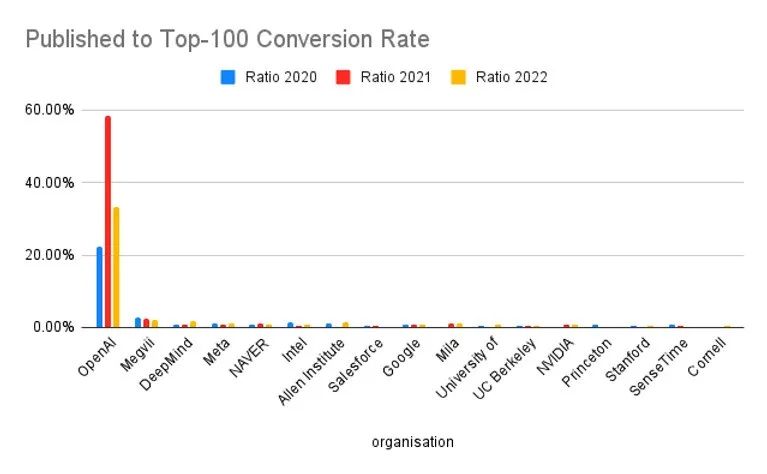

当然,作为新晋顶流 ChatGPT 背后的公司,OpenAI 近三年的研究成果转化率(Conversion Rate)是具有绝对优势的。最近几年,OpenAI 的大多数研究成果都引起了极大的关注,特别是在大规模语言模型方面。

2020 年,OpenAI 发布了 GPT-3,这个 1750 亿参数的大规模语言模型在一定程度上颠覆了语言模型领域的游戏规则,因为它解决了许多大规模语言模型中的难题。GPT-3 掀起了一场大规模语言模型的狂潮。几年来,语言模型的参数规模不断被打破,人们一直在探索大规模语言模型的更多潜力。

2022 年底,ChatGPT 横空出世,它引起了人们对文本生成和 AI 对话系统的高度关注。特别地,ChatGPT 在生成知识型内容和生成代码方面已经表现出非常高的能力。在谷歌、微软陆续宣布将类似 ChatGPT 的功能集成到下一代搜索引擎后,ChatGPT 被认为将引领一场 AIGC 和智能工具的新变革。

最后,我们来看一下 2022 年被引用次数最多的 100 篇论文具体有哪些:

此处还增加了推特提及次数,这有时被视为早期影响指标。但到目前为止,相关性似乎很弱。还需要进一步的工作。

原文链接:https://www.zeta-alpha.com/post/must-read-the-100-most-cited-ai-papers-in-2022

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”