一、环境配置

- 为了成功实现基于CNN-RNN的动态手势识别系统,你需要确保你的开发环境已经安装了以下必要的库和工具:

- Python:推荐使用Python 3.x版本,作为主要的编程语言。

- TensorFlow:深度学习框架,用于构建和训练神经网络模型。

- Keras:TensorFlow的高级API,简化了神经网络的构建过程。

- NumPy:用于数值计算的库。

- OpenCV:用于图像处理和视频捕获的库。

目录

一、环境配置

你可以使用pip命令来安装这些库:

二、数据预处理

在进行模型训练之前,需要对手势数据进行预处理。

三、模型搭建

四、模型训练与评估

五、代码实现

数据加载与预处理

模型搭建

模型训练与评估

六、模型测试与手势识别

模型测试

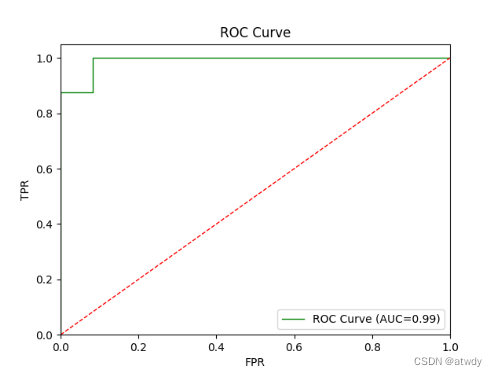

我们可以使用测试集对模型进行测试,并计算识别准确率、混淆矩阵等指标来评估模型的性能。

-

你可以使用pip命令来安装这些库:

pip install tensorflow keras numpy opencv-python二、数据预处理

-

在进行模型训练之前,需要对手势数据进行预处理。

三、模型搭建

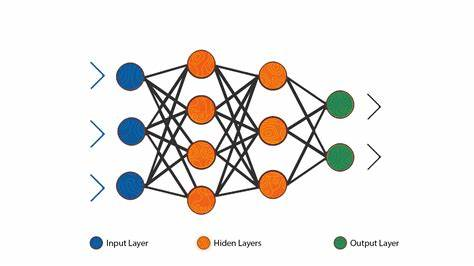

- CNN部分:用于提取手势图像的空间特征。你可以选择使用预训练的CNN模型(如VGG、ResNet等)进行特征提取,也可以自定义一个简单的CNN结构。

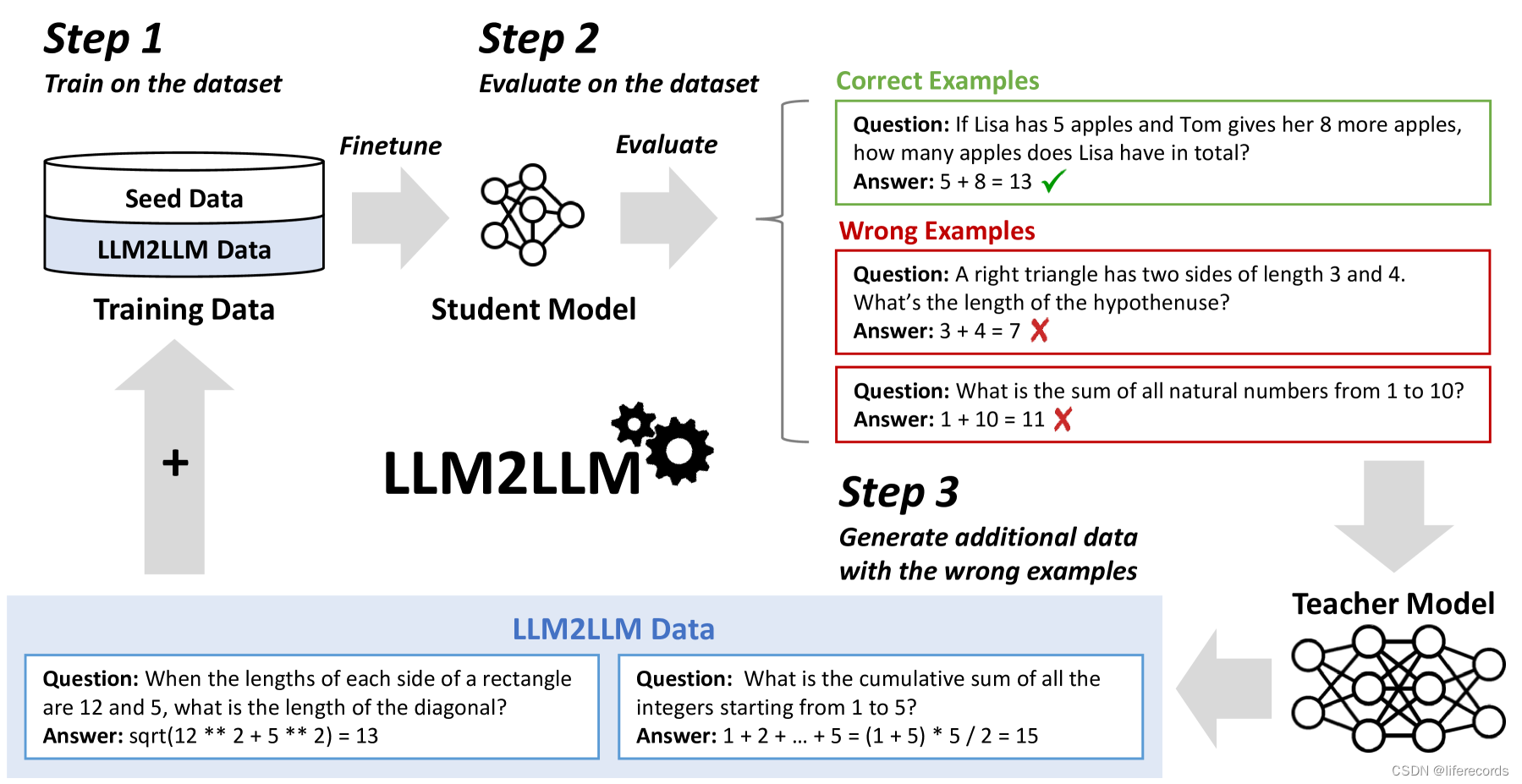

- RNN部分:用于捕捉手势序列的时间依赖关系。你可以选择使用LSTM或GRU等循环神经网络结构。

- 连接CNN和RNN:将CNN提取的特征输入到RNN中,通过RNN对特征序列进行建模。

四、模型训练与评估

- 使用标注好的手势数据进行模型训练,并通过验证集对模型进行评估。你可以使用交叉熵损失函数和Adam优化器来训练模型。在训练过程中,你可以通过调整学习率、批次大小等超参数来优化模型的性能。

五、代码实现

-

数据加载与预处理

# 加载手势数据

gesture_data = load_gesture_data() # 数据预处理

processed_data = preprocess_data(gesture_data)-

模型搭建

# 定义CNN结构

def build_cnn(): # ... return cnn_model # 定义RNN结构

def build_rnn(): # ... return rnn_model # 连接CNN和RNN

input_shape = (timesteps, image_height, image_width, channels)

cnn_model = build_cnn()

rnn_model = build_rnn(input_shape, cnn_model.output_shape[-1]) model = Model(inputs=cnn_model.input, outputs=rnn_model.output)-

模型训练与评估

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # 训练模型

model.fit(x_train, y_train, epochs=num_epochs, batch_size=batch_size, validation_data=(x_val, y_val)) # 评估模型

loss, accuracy = model.evaluate(x_test, y_test)

print(f'Test loss: {loss}, Test accuracy: {accuracy}')六、模型测试与手势识别

在模型训练完成后,我们需要对模型进行测试,以验证其在实际手势识别任务中的性能。此外,我们还需要编写代码来捕获实时手势视频,并利用训练好的模型进行手势识别。

-

模型测试

-

我们可以使用测试集对模型进行测试,并计算识别准确率、混淆矩阵等指标来评估模型的性能。

# 加载测试集数据

x_test, y_test = load_test_data() # 进行模型测试

predictions = model.predict(x_test)

predicted_labels = np.argmax(predictions, axis=1)

test_labels = np.argmax(y_test, axis=1) # 计算准确率

accuracy = np.mean(predicted_labels == test_labels)

print(f'Test Accuracy: {accuracy * 100:.2f}%') # 计算混淆矩阵

from sklearn.metrics import confusion_matrix

cm = confusion_matrix(test_labels, predicted_labels)

print('Confusion Matrix:')

print(cm)2. 实时手势识别

为了实现实时手势识别,我们需要使用OpenCV来捕获视频流,并逐帧处理视频中的手势图像。然后,我们可以将处理后的手势图像序列输入到训练好的模型中,以获取手势识别的结果。

import cv2 # 加载训练好的模型

model = load_trained_model() # 打开视频流

cap = cv2.VideoCapture(0) while True: # 读取视频帧 ret, frame = cap.read() if not ret: break # 对视频帧进行预处理,如裁剪、缩放、归一化等 processed_frame = preprocess_frame(frame) # 将处理后的帧转换为模型输入格式 input_data = np.expand_dims(processed_frame, axis=0) # 进行手势识别 prediction = model.predict(input_data) predicted_label = np.argmax(prediction, axis=1)[0] # 显示识别结果和手势图像 cv2.putText(frame, gesture_labels[predicted_label], (50, 50), cv2.FONT_HERSHEY_SIMPLEX, 1, (255, 0, 0), 2) cv2.imshow('Gesture Recognition', frame) # 按下'q'键退出循环 if cv2.waitKey(1) & 0xFF == ord('q'): break # 释放视频流并关闭窗口

cap.release()

cv2.destroyAllWindows() 在上述代码中,load_trained_model()函数用于加载训练好的模型,preprocess_frame()函数用于对视频帧进行预处理,gesture_labels是一个包含手势标签的列表。实时手势识别的结果将显示在视频帧上,并可以通过按下'q'键退出识别过程。

以上只是基于CNN-RNN的动态手势识别系统的部分实现和代码示例。在实际应用中,你可能还需要考虑更多的细节和优化措施,如数据增强、模型正则化、超参数调优等。希望本文能为你提供一个良好的起点,帮助你更好地理解和实现基于CNN-RNN的动态手势识别系统。

![Linux repo基本用法: 搭建自己的repo仓库[服务端]](https://img-blog.csdnimg.cn/direct/4ff0eb8bf537489dbb519f8e33bb06bb.png#pic_center)